LLM Meta AI

FlowHunt tukee kymmeniä tekstintuottomalleja, mukaan lukien Metan Llama-mallit. Opi, kuinka voit integroida Llaman omiin tekoälytyökaluihisi ja chatteihisi, muk...

LLM Mistral FlowHuntissa mahdollistaa kehittyneiden Mistral-tekoälymallien joustavan integroinnin saumattomaan tekstin tuottamiseen chatboteissa ja tekoälytyökaluissa.

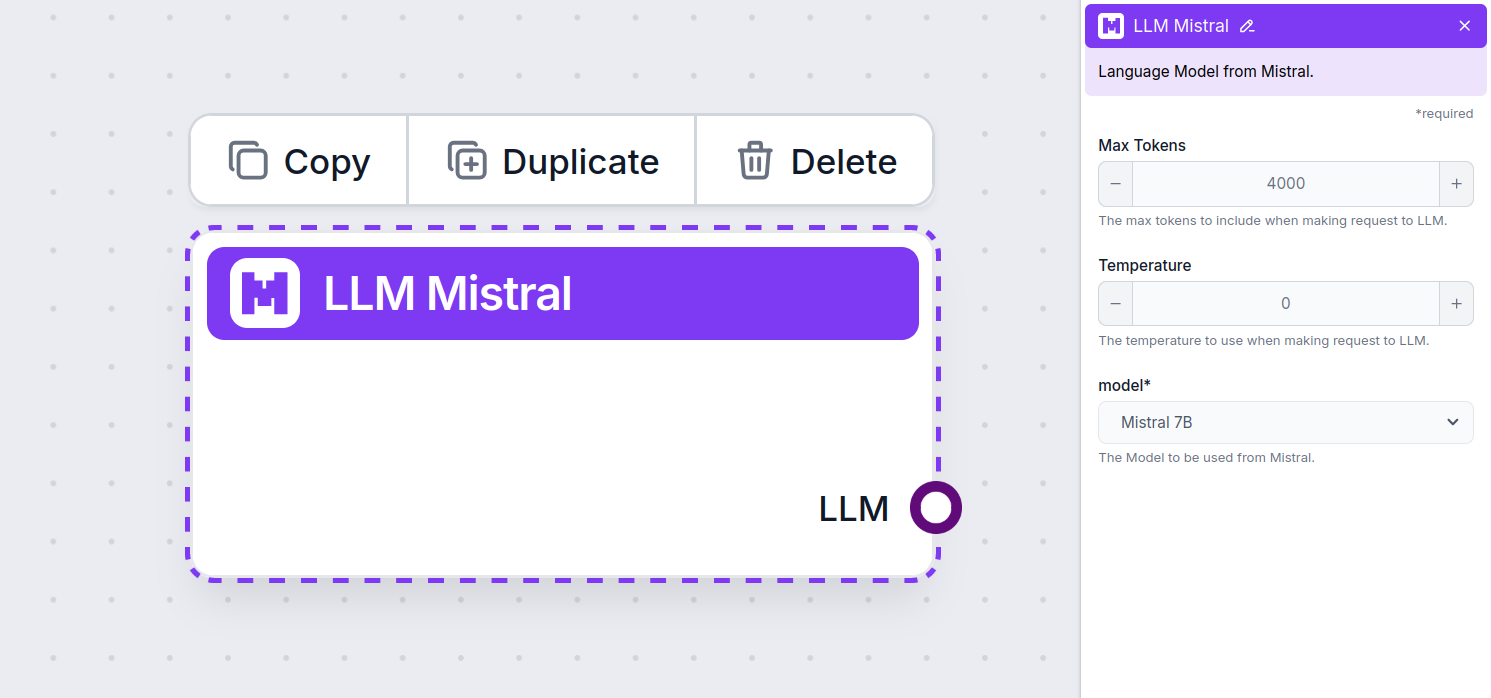

Komponentin kuvaus

LLM Mistral -komponentti yhdistää Mistral-mallit flow’husi. Vaikka varsinaiset Generaattorit ja Agentit tekevät varsinaisen taian, LLM-komponenttien avulla voit hallita käytettävää mallia. Kaikissa komponenteissa on oletuksena ChatGPT-4. Voit liittää tämän komponentin, jos haluat vaihtaa mallia tai saada siihen enemmän hallintaa.

Muista, että LLM-komponentin liittäminen on vapaaehtoista. Kaikissa komponenteissa, jotka käyttävät LLM:ää, on oletuksena ChatGPT-4o. LLM-komponenttien avulla voit vaihtaa mallia ja säätää mallin asetuksia.

Tokenit ovat yksittäisiä tekstin osia, joita malli käsittelee ja tuottaa. Tokenien käyttö vaihtelee mallista riippuen, ja yksi token voi olla sana, osasana tai yksittäinen merkki. Mallien hinnoittelu perustuu usein miljooniin tokeneihin.

Max tokens -asetus rajoittaa kerralla prosessoitavien tokenien kokonaismäärää, mikä varmistaa, että vastaukset pysyvät kohtuullisen kokoisina. Oletusraja on 4 000 tokenia, mikä on optimaalinen määrä esimerkiksi dokumenttien ja useiden lähteiden tiivistämiseen vastauksen muodostamiseksi.

Temperature eli lämpötila säätelee vastausten vaihtelevuutta, arvovälillä 0–1.

0,1:n lämpötila tekee vastauksista hyvin ytimekkäitä, mutta ne voivat olla toisteisia ja vajavaisia.

Korkea lämpötila, 1, mahdollistaa maksimaalisen luovuuden vastauksissa, mutta lisää epäolennaisten tai jopa harhaisten vastausten riskiä.

Asiakaspalvelubotille suositeltu lämpötila on välillä 0,2–0,5. Tällöin vastaukset pysyvät olennaisina ja käsikirjoituksen mukaisina, mutta mahdollistavat luonnollisen vaihtelun.

Tämä on mallinvalitsin. Täältä löydät kaikki tuetut Mistral-mallit. Tuemme tällä hetkellä seuraavia malleja:

Näin lisäät LLM Mistralin flow’husi

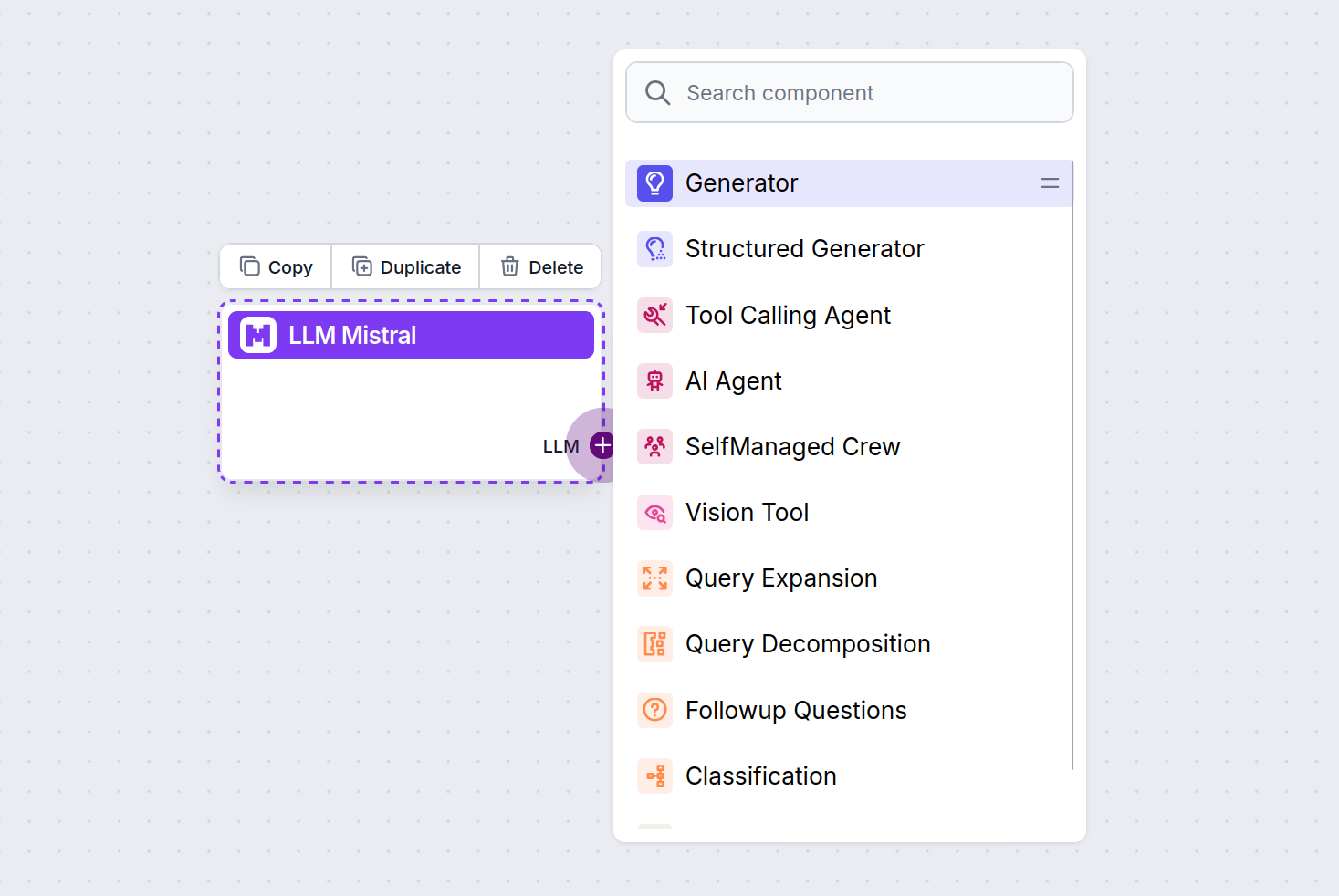

Huomaat, että kaikissa LLM-komponenteissa on vain lähtevä liitäntä. Syöte ei kulje komponentin läpi, sillä se edustaa vain mallia, kun taas varsinainen generointi tapahtuu AI-agenteissa ja generaattoreissa.

LLM-liitäntä on aina violetti. LLM-tuloliitäntä löytyy kaikista komponenteista, jotka käyttävät tekoälyä tekstin tuottamiseen tai datan käsittelyyn. Näet vaihtoehdot klikkaamalla liitäntää:

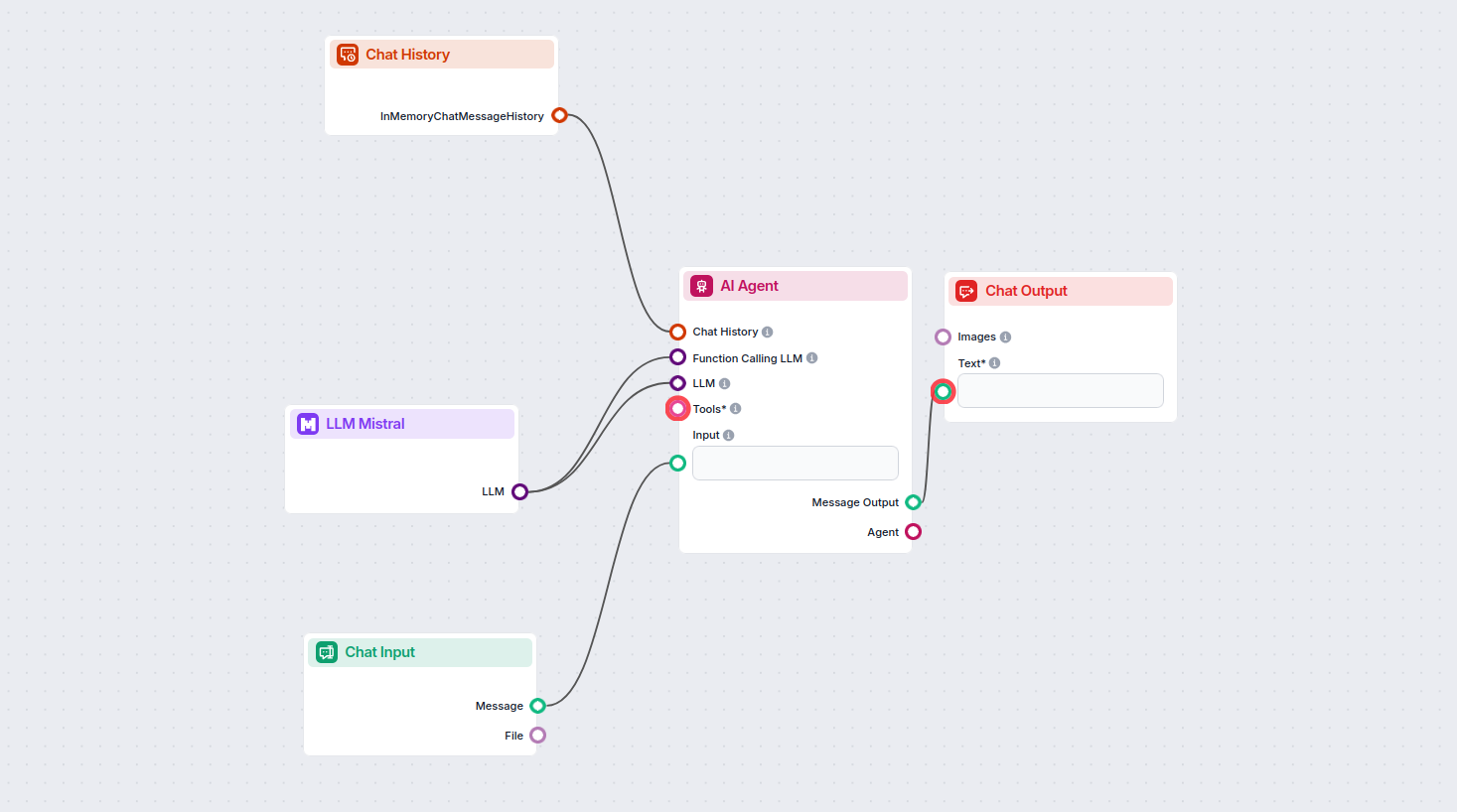

Tämän avulla voit rakentaa erilaisia työkaluja. Katsotaanpa komponenttia käytännössä. Tässä on yksinkertainen AI Agent -chatbot-flow, joka käyttää Mistral 7B -mallia vastausten tuottamiseen. Voit ajatella sitä perus-Mistral-chatbottina.

Tämä yksinkertainen chatbot-flow sisältää:

LLM Mistral -komponentin avulla voit yhdistää Mistral AI -malleja FlowHunt-projekteihisi, mahdollistaen kehittyneen tekstin generoinnin chatboteille ja tekoälyagenteille. Voit vaihtaa mallia, säätää asetuksia ja integroida esimerkiksi Mistral 7B, Mixtral (8x7B) ja Mistral Large -malleja.

FlowHunt tukee Mistral 7B-, Mixtral (8x7B)- ja Mistral Large -malleja, jotka tarjoavat erilaisia suorituskyky- ja parametrimääriä erilaisiin tekstin generointitarpeisiin.

Voit säätää esimerkiksi token-määrän ja lämpötilan arvoja sekä valita tuetuista Mistral-malleista, jolloin voit hallita vastausten pituutta, luovuutta ja mallin käyttäytymistä flow'ssasi.

Ei, LLM-komponentin liittäminen on vapaaehtoista. Oletuksena FlowHunt-komponentit käyttävät ChatGPT-4o:ta. Käytä LLM Mistral -komponenttia, kun haluat enemmän hallintaa tai käyttää tiettyä Mistral-mallia.

Aloita älykkäämpien tekoäly-chatbottien ja työkalujen rakentaminen integroimalla Mistralin tehokkaat kielimallit FlowHuntin no-code-alustalla.

FlowHunt tukee kymmeniä tekstintuottomalleja, mukaan lukien Metan Llama-mallit. Opi, kuinka voit integroida Llaman omiin tekoälytyökaluihisi ja chatteihisi, muk...

FlowHunt tukee kymmeniä tekstinluontimalleja, mukaan lukien xAI:n mallit. Näin voit käyttää xAI-malleja AI-työkaluissasi ja chatboteissasi.

FlowHunt tukee kymmeniä tekoälymalleja, mukaan lukien mullistavat DeepSeek-mallit. Näin käytät DeepSeekia AI-työkaluissasi ja chatbotissasi.