LLM Meta AI

FlowHunt tukee kymmeniä tekstintuottomalleja, mukaan lukien Metan Llama-mallit. Opi, kuinka voit integroida Llaman omiin tekoälytyökaluihisi ja chatteihisi, muk...

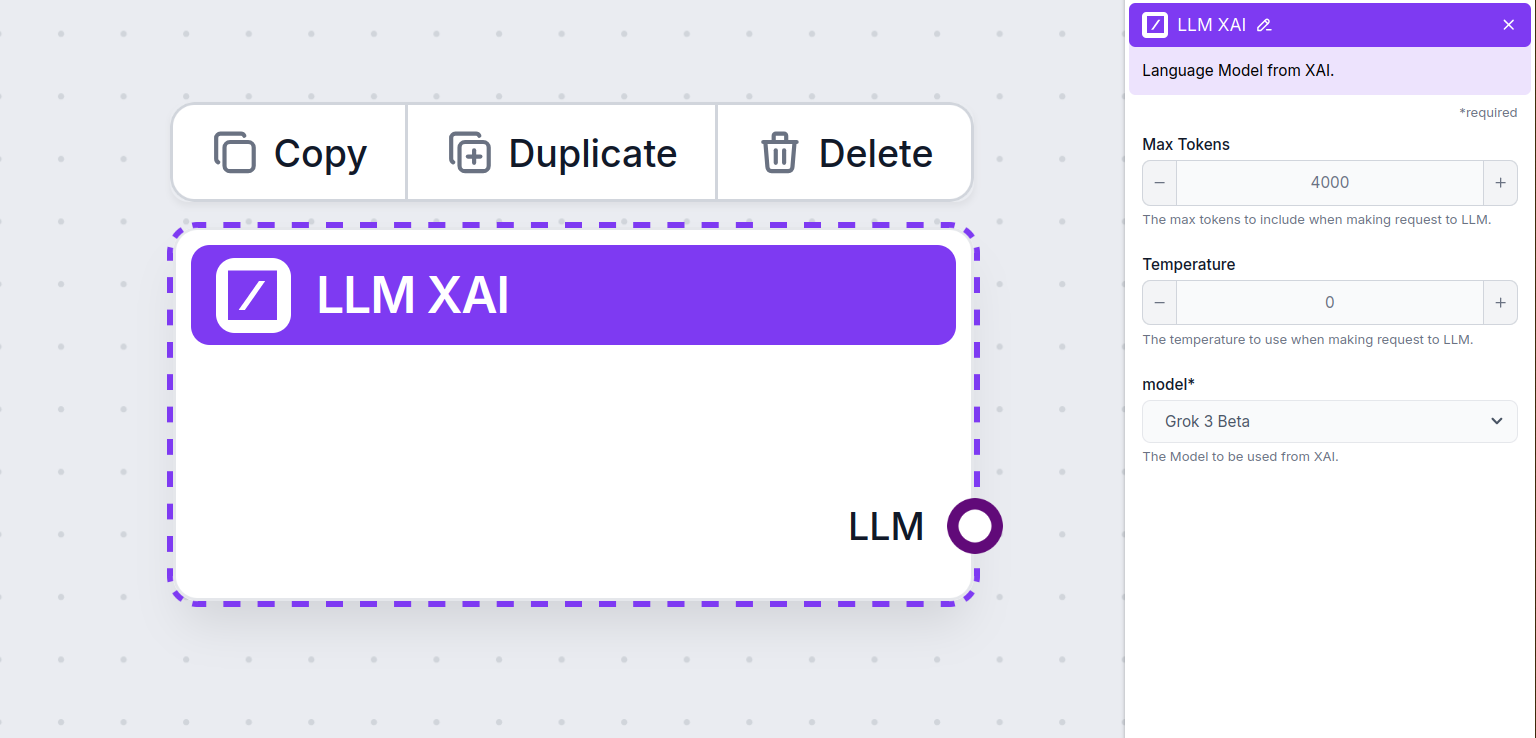

LLM xAI FlowHuntilta mahdollistaa xAI:n tekstinluontimallien, kuten Grok-betan, yhdistämisen chatboteihin ja AI-työkaluihin joustavilla asetuksilla, kuten token-määrä, temperature ja mallin valinta.

Komponentin kuvaus

LLM xAI -komponentti yhdistää Grok-mallin flow’husi. Vaikka varsinainen taika tapahtuu Generaattoreissa ja Agenteissa, LLM-komponenttien avulla voit hallita käytettävää mallia. Kaikissa komponenteissa on oletuksena ChatGPT-4. Voit liittää tämän komponentin, jos haluat vaihtaa mallia tai saada siihen enemmän hallintaa.

Muista, että LLM-komponentin liittäminen on vapaaehtoista. Kaikissa LLM:ää käyttävissä komponenteissa on oletuksena ChatGPT-4o. LLM-komponenttien avulla voit vaihtaa mallia ja säätää mallin asetuksia.

Tokenit ovat tekstin yksiköitä, joita malli prosessoi ja tuottaa. Tokenien käyttö vaihtelee mallien mukaan, ja yksi token voi olla sana, sanan osa tai yksittäinen merkki. Mallien hinnoittelu perustuu yleensä miljooniin tokeneihin.

Maksimitokenien asetus rajoittaa kerralla prosessoitavien tokenien määrän, jolloin vastaukset pysyvät kohtuullisen kokoisina. Oletusraja on 4 000 tokenia, mikä on optimaalinen esimerkiksi dokumenttien ja useiden lähteiden tiivistämiseen.

Temperature säätelee vastausten monipuolisuutta, välillä 0–1.

Temperature-arvo 0,1 tekee vastauksista hyvin täsmällisiä, mutta mahdollisesti toistavia ja niukkoja.

Korkea temperature-arvo 1 mahdollistaa luovimmat vastaukset, mutta kasvattaa epäolennaisten tai jopa “hallusinoitujen” vastausten riskiä.

Esimerkiksi asiakaspalvelubotille suositeltu temperature-arvo on 0,2–0,5. Tällä tasolla vastaukset pysyvät olennaisina ja skriptin mukaisina, mutta luonnollinen vaihtelu säilyy.

Tämä on mallin valitsin. Täältä löydät kaikki xAI-tarjoajan tukemat mallit. xAI:n lippulaivatekstimalli on Grok. Tällä hetkellä tuemme vain grok-beta-mallia, sillä se on ainoa, joka on julkaistu julkiseen API-käyttöön.

Haluatko tietää lisää Grok-betasta ja nähdä, miten se vertautuu muihin malleihin? Katso tämä artikkeli.

Huomaat, että kaikissa LLM-komponenteissa on vain ulostulokahva. Syöte ei kulje komponentin läpi, sillä komponentti edustaa ainoastaan mallia; varsinainen generointi tapahtuu AI-agenteissa ja Generaattoreissa.

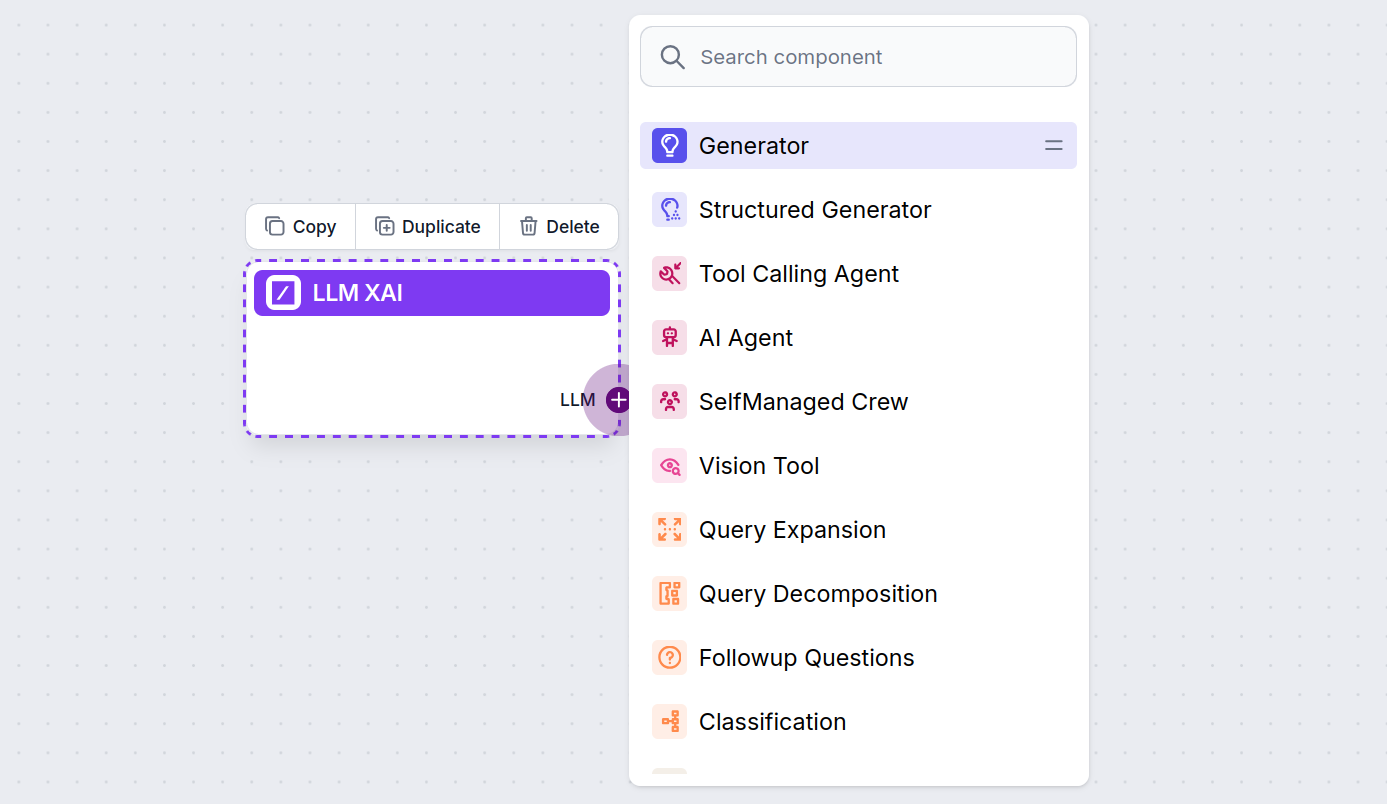

LLM-kahva on aina violetti. LLM-syötekahva löytyy kaikista komponenteista, joissa AI generoi tekstiä tai käsittelee dataa. Vaihtoehdot näet klikkaamalla kahvaa:

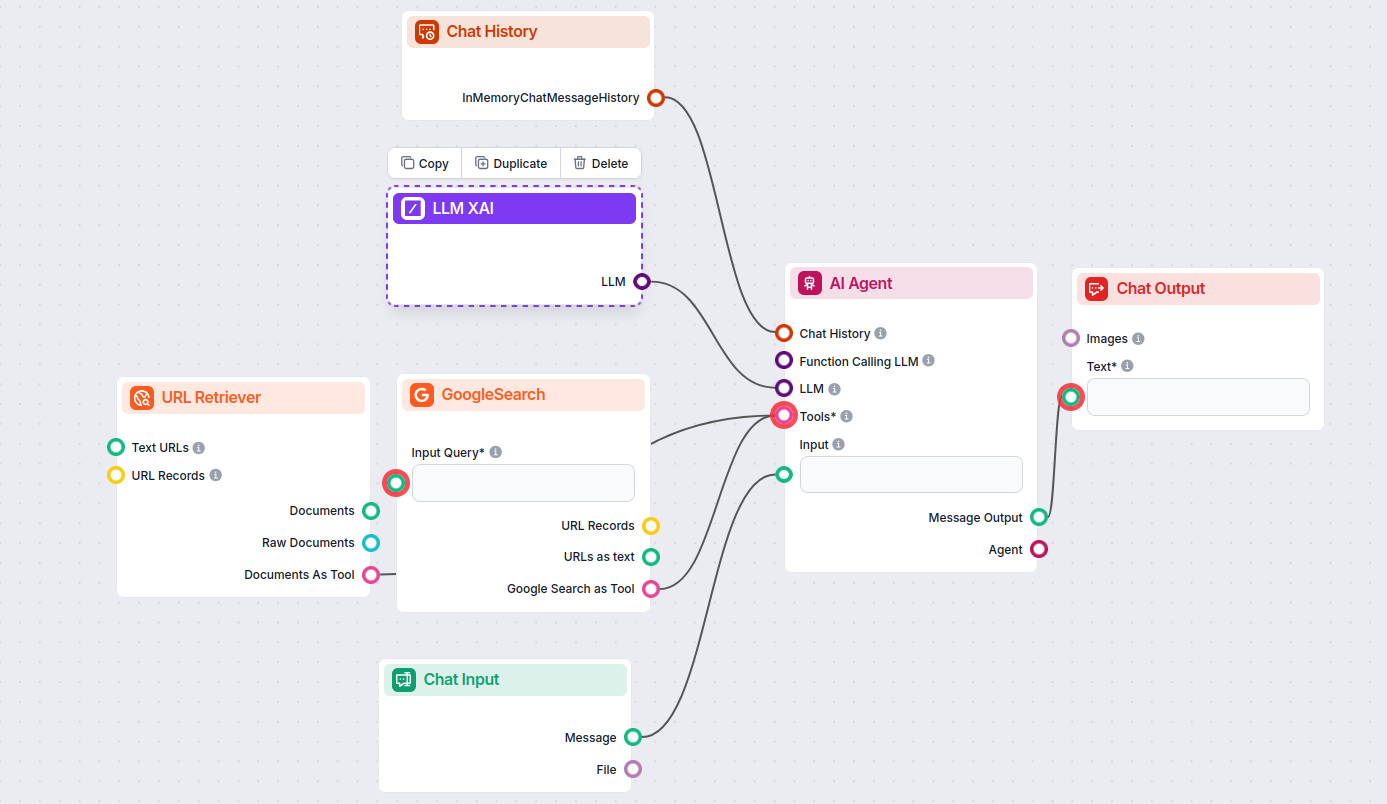

Tämän avulla voit luoda monenlaisia työkaluja. Katsotaanpa komponentti käytännössä. Tässä on yksinkertainen AI Agent -chatbotti Flow, joka käyttää xAI:n grok-beta-mallia vastausten tuottamiseen. Voit ajatella tätä perus xAI-chatbottina.

Tämä yksinkertainen Chatbot Flow sisältää:

LLM xAI on FlowHunt-komponentti, jonka avulla voit yhdistää ja ohjata xAI-tarjoajien tekstinluontimalleja, kuten Grok-beta, omissa AI-floweissasi ja chatboteissasi.

Tällä hetkellä FlowHunt tukee xAI:n grok-beta-mallia, ja lisää malleja lisätään sitä mukaa kun ne tulevat julkisen API:n kautta saataville.

Voit säätää maksimimäärää tokeneille, temperature-arvoa (vastausten monipuolisuus) ja valita käytettävissä olevista xAI-malleista, jotta saat chatbotistasi tai AI-työkalustasi haluamasi kaltaisen.

Ei, se on valinnainen. Oletuksena komponenteissa käytetään ChatGPT-4o:ta, mutta voit liittää LLM xAI:n vaihtaaksesi xAI-malleihin tai saadaksesi enemmän hallintaa.

Lisää vain LLM-komponentti flow'hun; se toimii mallinvalitsijana. Varsinainen tekstin generointi tapahtuu siihen liitetyissä AI-agenteissa ja Generaattoreissa.

Aloita älykkäämpien AI-chatbottien ja työkalujen rakentaminen FlowHuntilla. Yhdistä huipputason xAI-malleihin, kuten Grok-betaan, joustavassa, koodittomassa hallintapaneelissa.

FlowHunt tukee kymmeniä tekstintuottomalleja, mukaan lukien Metan Llama-mallit. Opi, kuinka voit integroida Llaman omiin tekoälytyökaluihisi ja chatteihisi, muk...

FlowHunt tukee kymmeniä tekoälytekstimalleja, mukaan lukien Mistralin mallit. Näin voit käyttää Mistralia tekoälytyökaluissasi ja chatboteissasi.

FlowHunt tukee kymmeniä tekoälymalleja, mukaan lukien mullistavat DeepSeek-mallit. Näin käytät DeepSeekia AI-työkaluissasi ja chatbotissasi.