Neuroverkot

Neuroverkko, eli keinotekoinen neuroverkko (ANN), on laskennallinen malli, joka on saanut inspiraationsa ihmisaivoista. Se on olennainen tekoälyssä ja koneoppim...

Aktivointifunktiot tuovat epälineaarisuuden neuroverkkoihin, mahdollistaen monimutkaisten kuvioiden oppimisen, mikä on oleellista tekoälyn ja syväoppimisen sovelluksissa.

Aktivointifunktiot ovat keskeinen osa tekoälyverkkojen (ANN) arkkitehtuuria ja vaikuttavat merkittävästi verkon kykyyn oppia ja suorittaa monimutkaisia tehtäviä. Tämä sanastoartikkeli perehtyy aktivointifunktioiden yksityiskohtiin tarkastellen niiden tarkoitusta, tyyppejä ja käyttökohteita etenkin tekoälyn, syväoppimisen ja neuroverkkojen yhteydessä.

Aktivointifunktio neuroverkossa on matemaattinen operaatio, joka kohdistetaan neuronin ulostuloon. Se määrittää, aktivoituuko neuroni vai ei, ja tuo verkkoon epälineaarisuuden, minkä ansiosta verkko pystyy oppimaan monimutkaisia kuvioita. Ilman näitä funktioita neuroverkko toimisi käytännössä lineaarisena regressiomallina riippumatta sen syvyydestä tai kerrosten määrästä.

Sigmoid-funktio

Tanh-funktio

ReLU (Rectified Linear Unit)

Leaky ReLU

Softmax-funktio

Swish-funktio

Aktivointifunktiot ovat olennaisia monissa tekoälysovelluksissa, kuten:

Aktivointifunktio on matemaattinen operaatio, joka kohdistetaan neuronin ulostuloon. Se tuo mukanaan epälineaarisuuden ja mahdollistaa neuroverkoille monimutkaisten kuvioiden oppimisen yksinkertaisten lineaaristen suhteiden sijaan.

Aktivointifunktiot mahdollistavat neuroverkoille monimutkaisten, epälineaaristen ongelmien ratkaisun mahdollistamalla yksityiskohtaisten kuvioiden oppimisen, mikä on välttämätöntä esimerkiksi kuvien luokittelussa, kielenkäsittelyssä ja automaatiossa.

Yleisiä tyyppejä ovat Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax ja Swish, joilla kaikilla on omat erityispiirteensä ja käyttökohteensa eri neuroverkkokerroksissa.

Yleisiä haasteita ovat esimerkiksi katoavat gradientit (erityisesti Sigmoidin ja Tanhin kanssa), kuolevat ReLU:t sekä laskennallisesti raskaat funktiot, kuten Softmax, erityisesti reaaliaikasovelluksissa.

Älykkäät chatbotit ja tekoälytyökalut yhdessä paikassa. Yhdistä intuitiivisia lohkoja ja muuta ideasi automatisoiduiksi Floweiksi.

Neuroverkko, eli keinotekoinen neuroverkko (ANN), on laskennallinen malli, joka on saanut inspiraationsa ihmisaivoista. Se on olennainen tekoälyssä ja koneoppim...

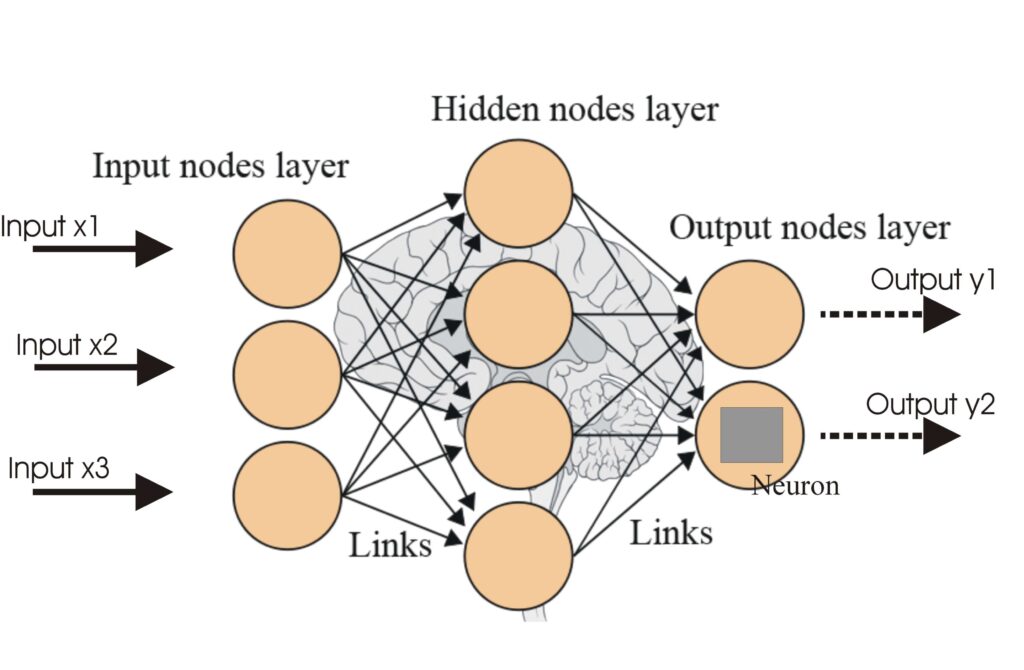

Tekoälyverkot (Artificial Neural Networks, ANN:t) ovat joukko koneoppimisalgoritmeja, jotka on mallinnettu ihmisaivojen mukaan. Nämä laskennalliset mallit koost...

Syvä uskomusverkko (DBN) on edistynyt generatiivinen malli, joka hyödyntää syviä arkkitehtuureja ja rajoitettuja Boltzmannin koneita (RBM) oppiakseen hierarkkis...