Sanaupotukset

Sanaupotukset ovat kehittyneitä sanojen esityksiä jatkuvassa vektoriavaruudessa, jotka tallentavat semanttisia ja syntaktisia suhteita edistyneisiin NLP-tehtävi...

Upotusvektori kuvaa dataa numeerisesti moniulotteisessa avaruudessa, mahdollistaen tekoälyjärjestelmille semanttisten suhteiden hyödyntämisen esimerkiksi luokittelussa, klusteroinnissa ja suosituksissa.

Upotusvektori on tiheä numeerinen esitys, jossa kukin datapiste kuvataan pisteenä moniulotteisessa avaruudessa. Tämä mallinnus on suunniteltu tallentamaan semanttista tietoa ja kontekstuaalisia suhteita eri datapisteiden välillä. Samanlaiset datapisteet sijoittuvat tässä avaruudessa lähemmäs toisiaan, mikä helpottaa esimerkiksi luokittelua, klusterointia ja suosituksia.

Upotusvektorit ovat käytännössä numerosarjoja, jotka tiivistävät edustamansa datan ominaisuudet ja suhteet. Muuntamalla monimutkaiset datatyypit näihin vektoreihin tekoälyjärjestelmät voivat käsitellä tietoa tehokkaammin.

Upotusvektorit ovat perustavanlaatuisia monissa tekoälyn ja koneoppimisen sovelluksissa. Ne yksinkertaistavat moniulotteisen datan esittämistä, jolloin analysointi ja tulkinta helpottuvat.

Upotusvektorien luominen sisältää useita vaiheita:

Huggingfacen Transformers-kirjasto tarjoaa huipputason transformer-malleja, kuten BERT, RoBERTa ja GPT-3. Nämä mallit ovat esikoulutettuja valtavilla aineistoilla ja tuottavat korkealaatuisia upotuksia, joita voi hienosäätää tiettyihin tehtäviin – näin saat vahvoja NLP-sovelluksia.

Varmista ensin, että transformers-kirjasto on asennettu Python-ympäristöösi. Voit asentaa sen näin:

pip install transformers

Lataa seuraavaksi esikoulutettu malli Huggingfacen mallikirjastosta. Tässä esimerkissä käytetään BERT-mallia.

from transformers import BertModel, BertTokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertModel.from_pretrained(model_name)

Tokenisoi syöttöteksti valmistelemaan se mallille.

inputs = tokenizer("Hello, Huggingface!", return_tensors='pt')

Syötä tokenisoitu teksti malliin saadaksesi upotusvektorit.

outputs = model(**inputs)

embedding_vectors = outputs.last_hidden_state

Tässä kokonainen esimerkki edellä mainituista vaiheista:

from transformers import BertModel, BertTokenizer

# Lataa esikoulutettu BERT-malli ja tokenisoija

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertModel.from_pretrained(model_name)

# Tokenisoi syöttöteksti

text = "Hello, Huggingface!"

inputs = tokenizer(text, return_tensors='pt')

# Luo upotusvektorit

outputs = model(**inputs)

embedding_vectors = outputs.last_hidden_state

print(embedding_vectors)

SNE on varhainen ulottuvuuksien vähennysmenetelmä, jonka kehittivät Geoffrey Hinton ja Sam Roweis. Se laskee parittaiset samankaltaisuudet korkeassa ulottuvuudessa ja pyrkii säilyttämään nämä matalammassa ulottuvuudessa.

t-SNE on parannettu versio SNE:stä ja laajasti käytetty korkean ulottuvuuden datan visualisointiin. Se minimoi kahden jakauman eron: alkuperäisen avaruuden ja pienemmän ulottuvuuden samankaltaisuuksien välillä käyttäen Student-t-jakaumaa.

UMAP on uudempi tekniikka, joka on nopeampi ja säilyttää globaalin rakenteen t-SNE:tä paremmin. Menetelmä rakentaa korkean ulottuvuuden graafin ja optimoi matalan ulottuvuuden graafin mahdollisimman rakenteellisesti samankaltaiseksi.

Useita työkaluja ja kirjastoja on saatavilla upotusvektorien visualisointiin:

Upotusvektori on tiheä numeerinen esitys datasta, jossa kukin datapiste kuvataan sijaintina moniulotteisessa avaruudessa semanttisten ja kontekstuaalisten suhteiden tallentamiseksi.

Upotusvektorit ovat perustavia tekoälyssä, sillä ne yksinkertaistavat monimutkaista dataa ja mahdollistavat tehtäviä kuten tekstiluokittelu, kuvantunnistus ja personoidut suositukset.

Upotusvektoreita voi luoda esikoulutetuilla malleilla, kuten BERT Huggingface Transformers -kirjastosta. Tokenisoimalla datasi ja syöttämällä sen tällaisiin malleihin saat korkealaatuiset upotukset jatkoanalyysiä varten.

Ulottuvuuksien vähennysmenetelmät, kuten t-SNE ja UMAP, ovat yleisesti käytettyjä korkeiden ulottuvuuksien upotusvektoreiden visualisointiin, mikä helpottaa datakuvioden tulkintaa ja analysointia.

Aloita omien tekoälytyökalujen ja chatbotien rakentaminen FlowHuntin koodittomalla alustalla. Muunna ideasi automaattisiksi Floweiksi helposti.

Sanaupotukset ovat kehittyneitä sanojen esityksiä jatkuvassa vektoriavaruudessa, jotka tallentavat semanttisia ja syntaktisia suhteita edistyneisiin NLP-tehtävi...

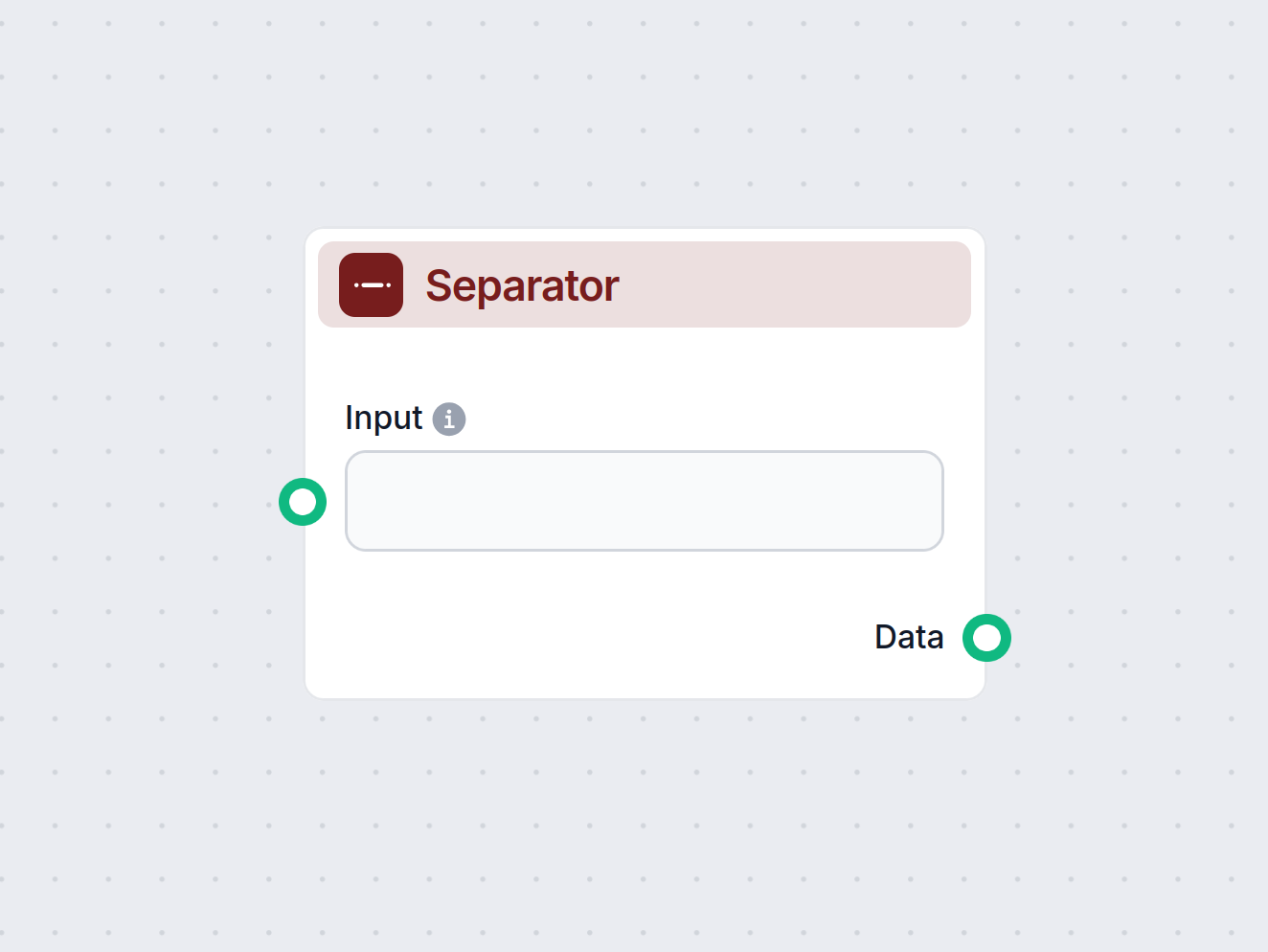

Separator-komponentti jakaa tavallisen tekstin luetteloksi tekstejä määritetyn erotinmerkin avulla. Se on olennainen työnkuluissa, joissa tarvitaan syötteiden j...

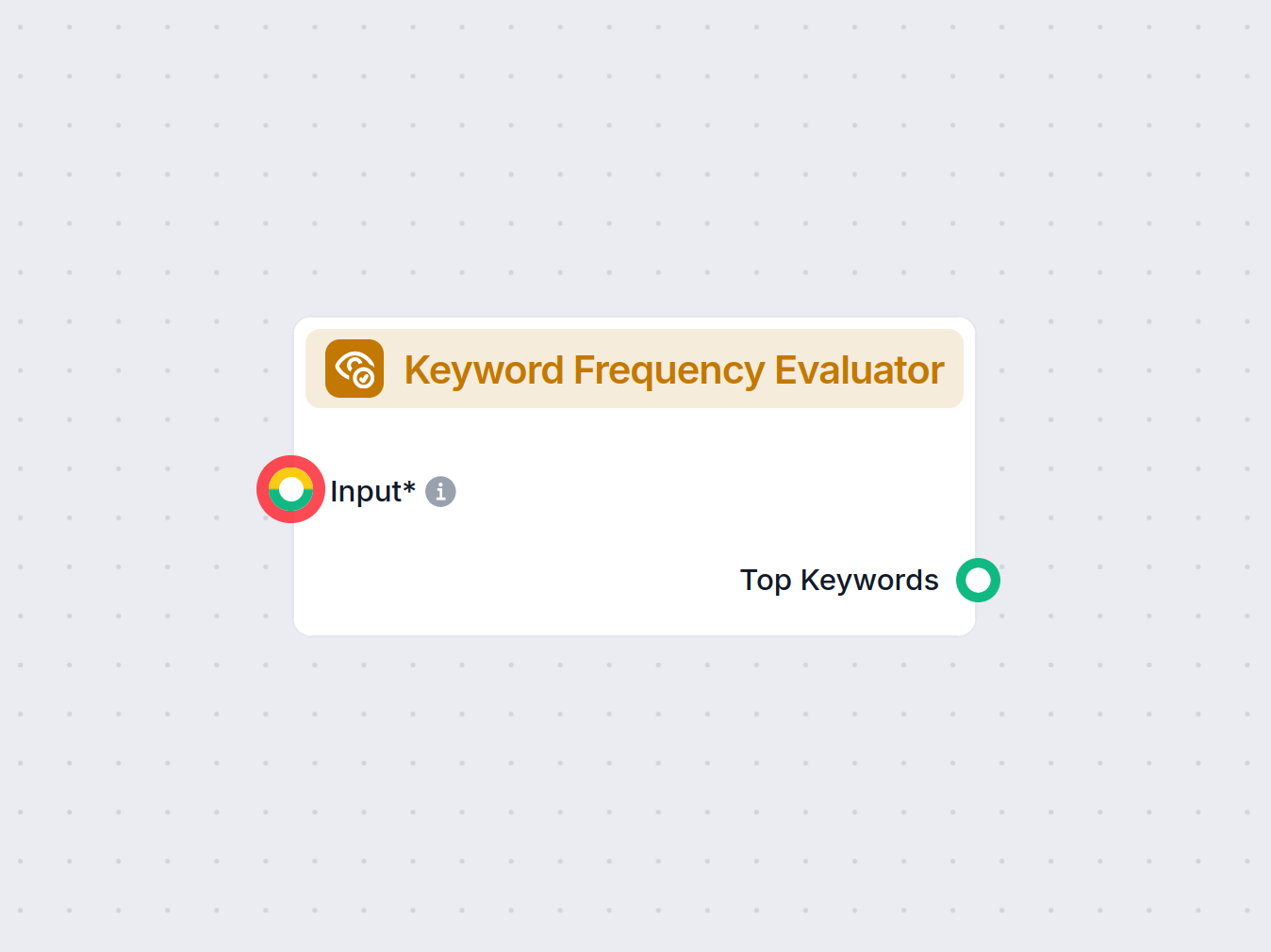

Analysoi tekstisi ja löydä yleisimmät ja merkittävimmät avainsanat Keyword Frequency Evaluator -komponentilla FlowHuntissa. Poimi automaattisesti tärkeimmät ava...