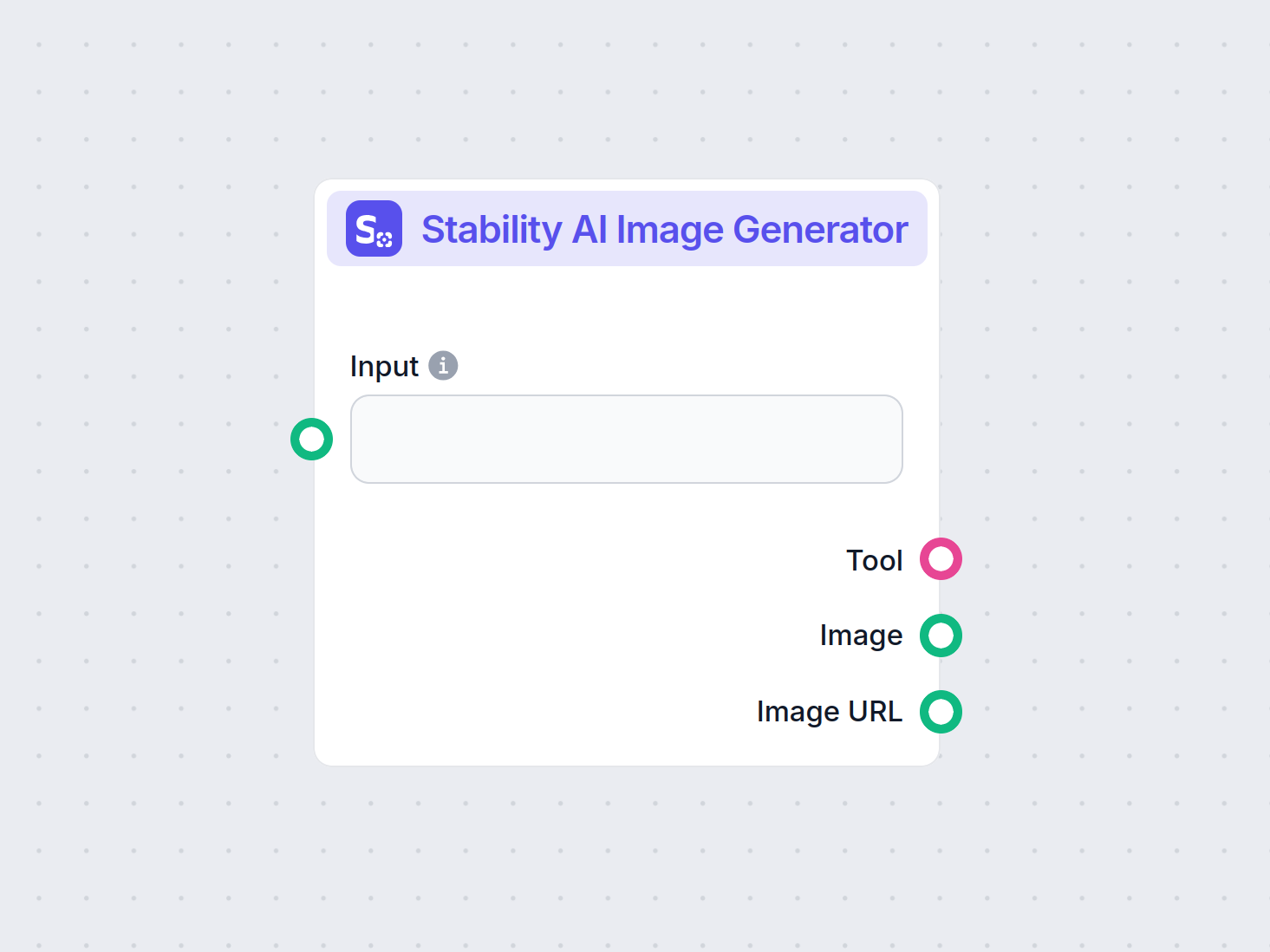

Stability AI Kuvageneraattori

Luo korkealaatuisia kuvia tekstikehotteista Stability AI Kuvageneraattori -komponentilla. Stable Diffusion -mallien voimin toimiva työkalu tarjoaa muokattavia a...

Stable Diffusion on johtava tekstistä kuvaan -tekoälymalli, jonka avulla käyttäjät voivat luoda valokuvamaisia visuaaleja syöttämällä ohjeita ja hyödyntämällä edistyneitä latent diffusion- ja syväoppimistekniikoita.

Stable Diffusion on tekstistä kuvaan -tekoälymalli, joka luo korkealaatuisia kuvia kuvauksista syväoppimisen avulla. Se hyödyntää tekniikoita kuten negatiiviset ohjeet ja viitekuvat parempien tulosten saavuttamiseksi, erityisesti haastavissa elementeissä kuten käsissä.

Stable Diffusion on edistynyt tekstistä kuvaan -generointimalli, joka hyödyntää syväoppimistekniikoita tuottaakseen korkealaatuisia, valokuvamaisia kuvia tekstikuvauksista. Latent diffusion -mallina se edustaa merkittävää läpimurtoa generatiivisen tekoälyn saralla, yhdistäen diffusion-mallien ja koneoppimisen periaatteet kuvien luomiseksi, jotka vastaavat tarkasti annettuja tekstiohjeita.

Stable Diffusion käyttää syväoppimista ja diffuusiomalleja luodakseen kuvia jalostamalla satunnaista kohinaa yhtenäisiksi visuaaleiksi. Vaikka sitä on koulutettu miljoonilla kuvilla, se kohtaa yhä haasteita monimutkaisten elementtien, kuten käsien, kanssa. Ajan myötä, kun malleja koulutetaan yhä suuremmilla aineistoilla, nämä ongelmat vähenevät ja kuvien laatu muuttuu yhä realistisemmaksi.

Yksi tehokas tapa ratkaista käsiongelmia on käyttää negatiivisia ohjeita. Lisäämällä ohjeeseesi esimerkiksi (-bad anatomy) tai (-bad hands -unnatural hands) voit ohjeistaa tekoälyä välttämään vääristyneiden piirteiden tuottamista. Varo kuitenkin liiallista negatiivisten ohjeiden käyttöä, sillä se saattaa rajoittaa mallin luovuutta.

Toinen tekniikka on käyttää viitekuvia tekoälyn ohjaamiseen. Sisällyttämällä ohjeeseen {image}-tunnisteen ja linkin viitekuvaan annat tekoälylle visuaalisen mallin tarkkaa käsien piirtämistä varten. Tämä on erityisen hyödyllistä oikeiden mittasuhteiden ja asentojen säilyttämisessä.

Parhaiden tulosten saavuttamiseksi yhdistä sekä negatiiviset ohjeet että viitekuvat. Tämä kaksinkertainen lähestymistapa varmistaa, että tekoäly välttää yleisimmät virheet ja noudattaa laadukkaita esimerkkejä.

(-bent fingers) tai (realistic perspectives), parantaaksesi käsien laatua entisestään.Kun hallitset nämä tekniikat, voit merkittävästi parantaa käsien piirtämistä Stable Diffusion -teoksissasi ja saavuttaa taidetta, jossa on kokeneen taiteilijan viimeistelyä. Kerää viitekuvat, laadi tarkat ohjeet ja seuraa, kuinka tekoälytaiteesi kehittyy!

Stable Diffusionin ydin perustuu tekstiohjeiden muuttamiseen visuaalisiksi esityksiksi erilaisten laskennallisten prosessien avulla. Toiminnan ymmärtäminen vaatii perehtymistä diffuusiomalleihin, latenttitiloihin ja neuroverkkoihin.

Diffuusiomallit ovat koneoppimisen generatiivisten mallien luokka, joka oppii luomaan dataa kääntämällä diffuusioprosessin. Diffuusioprosessissa dataan – kuten kuviin – lisätään vähitellen kohinaa, kunnes niitä ei voi erottaa satunnaisesta kohinasta. Malli oppii tämän jälkeen kääntämään prosessin, poistamalla kohinaa askel askeleelta palauttaen alkuperäisen datan. Tämä käänteinen diffuusio on avain uuden, yhtenäisen datan luomiseen satunnaisesta kohinasta.

Stable Diffusion käyttää nimenomaan latent diffusion -mallia. Toisin kuin perinteiset diffuusiomallit, jotka toimivat suoraan kuvien korkeissa pikseliulottuvuuksissa, latent diffusion -mallit työskentelevät pakatussa latenttitilassa. Tämä latenttitila on matalamman ulottuvuuden esitys datasta, joka säilyttää olennaiset piirteet ja vähentää laskennallista monimutkaisuutta. Toimimalla latenttitilassa Stable Diffusion voi tuottaa korkearesoluutioisia kuvia tehokkaammin.

Stable Diffusionin keskeinen mekanismi on käänteinen diffuusioprosessi latenttitilassa. Lähtökohtana on satunnainen kohinavektori latenttitilassa, jota malli jalostaa vaiheittain ennustamalla ja poistamalla kohinaa jokaisessa vaiheessa. Tätä jalostusta ohjaa käyttäjän antama tekstikuvaus. Prosessi jatkuu, kunnes latenttivektori lähestyy tilaa, joka dekoodattuna tuottaa tekstiohjeen mukaisen kuvan.

Stable Diffusionin arkkitehtuuri yhdistää useita keskeisiä komponentteja, jotka yhdessä muuttavat tekstiohjeet kuviksi.

VAE toimii kooderin-dekooderin järjestelmänä, joka pakkaa kuvat latenttitilaan ja palauttaa ne takaisin kuvamuotoon. Kooderi muuntaa kuvan latenttiesitykseksi, joka tiivistää olennaiset piirteet suppeampaan muotoon. Dekooderi muuntaa tämän latenttiesityksen yksityiskohtaiseksi kuvaksi.

Tämä prosessi on olennainen, koska se mahdollistaa mallin työskentelyn matalamman ulottuvuuden datan kanssa, mikä vähentää huomattavasti laskentatehoa verrattuna suoraan pikselitilassa toimimiseen.

U-Net on erikoistunut neuroverkkoarkkitehtuuri, jota käytetään Stable Diffusionissa kuvankäsittelytehtäviin. Se koostuu koodaavasta ja dekoodaavasta polusta, joiden välillä on poikittaisia yhteyksiä. Stable Diffusionissa U-Net toimii kohinan ennustajana käänteisessä diffuusioprosessissa.

Jokaisessa diffuusioprosessin aikaleimassa U-Net ennustaa, kuinka paljon kohinaa on latenttiesityksessä. Tätä ennustetta käytetään latenttivektorin jalostamiseen vähentämällä arvioitu kohina, jolloin latenttitilaa puhdistetaan vaiheittain kohti tekstiohjeen mukaista kuvaa.

Tekstitiedon sisällyttämiseksi Stable Diffusion hyödyntää tekstitunnistinta, joka perustuu CLIP-malliin (Contrastive Language-Image Pretraining). CLIP on suunniteltu ymmärtämään ja yhdistämään teksti- ja kuvainformaatiota sijoittamalla ne samaan latenttitilaan.

Kun käyttäjä antaa tekstiohjeen, tekstikooderi muuntaa sen upotuksiksi – numeerisiksi esityksiksi tekstidatasta. Nämä upotukset ohjaavat U-Netiä käänteisessä diffuusioprosessissa, ohjaten kuvagenerointia tekstiohjeen sisältöä vastaavaksi.

Stable Diffusion tarjoaa monipuolisuutta kuvien luomiseen ja sitä voi hyödyntää monin eri tavoin käyttäjän tarpeiden mukaan.

Stable Diffusionin ensisijainen käyttötapa on kuvien luominen tekstiohjeista. Käyttäjä syöttää kuvailevan tekstin, ja malli tuottaa sitä vastaavan kuvan. Esimerkiksi ohje “Rauhallinen ranta auringonlaskussa palmujen kera” tuottaa kuvan kyseisestä maisemasta.

Tämä ominaisuus on erityisen hyödyllinen luovilla aloilla, sisällöntuotannossa ja suunnittelussa, joissa ideoiden nopea visualisointi on tärkeää.

Pelkkien uusien kuvien luomisen lisäksi Stable Diffusion voi muokata olemassa olevia kuvia tekstiohjeiden perusteella. Antamalla alkuperäiskuvan ja tekstiohjeen malli voi tuottaa uuden kuvan, johon on tehty ohjeiden mukaisia muutoksia.

Esimerkiksi käyttäjä voi syöttää päiväaikaisen kaupunkimaiseman kuvan ja ohjeen “muuta yöksi neonvaloilla”, jolloin saadaan vastaava muokattu kuva.

Paikkaus tarkoittaa puuttuvien tai vioittuneiden kuvan osien täyttämistä. Stable Diffusion on tässä erityisen hyvä, sillä se voi käyttää tekstiohjeita ohjaamaan tiettyjen alueiden uudelleenrakennusta. Käyttäjä voi rajata kuvan osan ja antaa kuvauksen, mitä kohtaan halutaan lisätä.

Tämä ominaisuus soveltuu esimerkiksi valokuvien entisöintiin, ei-toivottujen objektien poistoon tai tiettyjen elementtien muuttamiseen säilyttäen kuvan kokonaisuuden.

Luomalla sarjoja kuvia pienin muutoksin Stable Diffusionia voidaan laajentaa tuottamaan animaatioita tai videota. Deforum-työkalun kaltaiset ratkaisut laajentavat Stable Diffusionin kykyjä tuottaa dynaamista visuaalista sisältöä tekstiohjeiden ohjaamana ajan yli.

Tämä avaa mahdollisuuksia animaatioon, visuaalisiin efekteihin ja dynaamiseen sisällöntuotantoon ilman perinteistä ruutu ruudulta -animaatiota.

Stable Diffusionin kyky luoda kuvia tekstikuvauksista tekee siitä tehokkaan työkalun tekoälyautomaation ja chatbotien kehitykseen.

Stable Diffusionin integroiminen chatteihin mahdollistaa visuaalisen sisällön tuottamisen käyttäjän kysymyksiin vastaamiseksi. Esimerkiksi asiakaspalvelutilanteessa chatbot voi tarjota visuaalisia ohjeita tai kuvituksia, jotka syntyvät lennossa.

Tekstiohjeet muunnetaan upotuksiksi CLIP-tekstikooderin avulla. Nämä upotukset ovat olennaisia kuvagenerointiprosessin ohjaamiseksi, jotta lopputulos vastaa käyttäjän tekstikuvausta.

Käänteinen diffuusioprosessi tarkoittaa latenttiesityksen jalostamista vaiheittain poistamalla ennustettua kohinaa. Jokaisessa vaiheessa malli huomioi tekstin upotukset ja latenttivektorin nykytilan arvioidakseen kohinakomponentin tarkasti.

Mallin taitavuus kohinaisten kuvien käsittelyssä perustuu laajoihin koulutusaineistoihin, joissa se oppii tunnistamaan ja puhdistamaan kuvia tehokkaasti. Tämä mahdollistaa selkeiden kuvien tuottamisen myös satunnaisesta kohinasta.

Työskentely latenttitilassa tarjoaa laskennallista tehokkuutta. Koska latenttitilassa ulottuvuuksia on vähemmän kuin pikselitilassa, operaatioihin kuluu vähemmän resursseja. Tämä mahdollistaa korkearesoluutioisten kuvien luonnin ilman liiallista laskentatehon tarvetta.

Taiteilijat ja suunnittelijat voivat käyttää Stable Diffusionia ideoiden nopeaan visualisointiin, mikä auttaa luovassa prosessissa ja lyhentää aikaa ideasta toteutukseen.

Markkinointitiimit voivat tuottaa räätälöityä kuvitusta kampanjoihin, sosiaaliseen mediaan ja mainoksiin ilman laajoja graafisen suunnittelun resursseja.

Pelikehittäjät voivat luoda assetteja, ympäristöjä ja konseptitaidetta antamalla kuvailevia ohjeita, mikä nopeuttaa tuotantoputkea.

Kauppiaat voivat tuottaa kuvia tuotteista erilaisissa ympäristöissä tai kokoonpanoissa, mikä parantaa tuotevisualisointia ja asiakaskokemusta.

Opettajat ja sisällöntuottajat voivat luoda kuvituksia ja kaavioita monimutkaisten asioiden havainnollistamiseen, tehden oppimateriaalista kiinnostavampaa.

Tekoälyn ja tietokonenäön tutkijat voivat hyödyntää Stable Diffusionia diffuusiomallien ja latenttitilojen mahdollisuuksien tutkimiseen.

Stable Diffusionin tehokkaaseen käyttöön on hyvä huomioida tietyt tekniset seikat.

Pääset alkuun Stable Diffusionin kanssa seuraavasti:

Kehittäjille, jotka rakentavat tekoälyautomaation järjestelmiä ja chatteja, Stable Diffusion voidaan integroida toiminnallisuuden laajentamiseksi.

Stable Diffusionia käytettäessä tulee huomioida eettiset kysymykset.

Stable diffusion on merkittävä tutkimusaihe generatiivisten mallien kentällä, erityisesti datan laajentamisessa ja kuvansynteesissä. Viimeaikaiset tutkimukset ovat käsitelleet erilaisia stable diffusionin osa-alueita, korostaen sen sovelluksia ja tehokkuutta.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments – Fuxi Wen (2013):

Esittelee diffusion least mean p-power (LMP) -algoritmin hajautettuun estimointiin alfa-stabiilissa kohinaympäristössä. Tutkimuksessa verrataan diffusion LMP -menetelmää diffusion least mean squares (LMS) -algoritmiin ja osoitetaan LMP:n parempi suorituskyky alfa-stabiilissa kohinassa. Tutkimus on tärkeä kehitettäessä kestäviä estimointitekniikoita meluisissa ympäristöissä. Lue lisää

Stable Diffusion for Data Augmentation in COCO and Weed Datasets – Boyang Deng (2024):

Tutkii stable diffusion -mallien käyttöä korkearesoluutioisten synteettisten kuvien tuottamiseen pienten aineistojen parantamiseksi. Hyödyntämällä tekniikoita kuten kuva-kuva -muunnos, Dreambooth ja ControlNet, tutkimus arvioi stable diffusionin tehokkuutta luokittelu- ja tunnistustehtävissä. Tulokset viittaavat lupaaviin sovelluksiin eri aloilla. Lue lisää

Diffusion and Relaxation Controlled by Tempered α-stable Processes – Aleksander Stanislavsky, Karina Weron, ja Aleksander Weron (2011):

Johdetaan anomalisen diffuusion ja epäeksponentiaalisen relaksaation ominaisuuksia käyttämällä tempered α-stable -prosesseja. Työssä ratkaistaan α-stabiilien satunnaisten aikojen ääretön momenttiongelma ja tarjotaan malli, joka sisältää alipisteleviä prosesseja erikoistapauksena. Lue lisää

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion – Andreas Stöckl (2022):

Arvioi Stable Diffusion -mallilla tuotettuja synteettisiä kuvia Wordnet-luokituksen avulla. Tutkimuksessa tarkastellaan mallin kykyä tuottaa oikeita kuvia eri käsitteistä ja tuo esiin eroja kuvausten tarkkuudessa. Arviot ovat tärkeitä stable diffusionin roolin ymmärtämisessä datan laajennuksessa. Lue lisää

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion – Sanchayan Vivekananthan (2024):

Käsittelee kolmea generatiivista kehystä: VAE:t, GAN:t ja Stable Diffusion -mallit. Tutkimus tuo esiin kunkin mallin vahvuudet ja rajoitukset, huomioiden että vaikka VAE- ja GAN-malleilla on omat etunsa, stable diffusion on ylivoimainen tietyissä kuvansynteesitehtävissä. Lue lisää

Katsotaan, miten Stable Diffusion -malli voidaan toteuttaa Pythonilla Hugging Face Diffusers -kirjaston avulla.

Asenna tarvittavat kirjastot:

pip install torch transformers diffusers accelerate

pip install xformers # Valinnainen

Diffusers-kirjasto tarjoaa helpon tavan ladata esikoulutetut mallit:

from diffusers import StableDiffusionPipeline

import torch

# Lataa Stable Diffusion -malli

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Siirrä malli GPU:lle nopeampaa suorittamista varten

Kuvien luominen onnistuu syöttämällä tekstiohje:

prompt = "A serene landscape with mountains and a lake, photorealistic, 8K resolution"

image = pipe(prompt).images[0]

# Tallenna tai näytä kuva

image.save("generated_image.png")

model_id.torch.float16 vähentää muistin käyttöä.Voit mukauttaa eri parametreja:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Number of denoising steps

guidance

Stable Diffusion on edistynyt tekoälymalli, joka on suunniteltu luomaan korkealaatuisia, valokuvamaisia kuvia tekstiohjeista. Se hyödyntää latent diffusion -menetelmää ja syväoppimista muuntaakseen tekstikuvaukset visuaaleiksi.

Stable Diffusion muuntaa tekstiohjeet kuvien upotuksiksi käyttämällä CLIP-tekstikooderia, jonka jälkeen se vaiheittain poistaa kohinaa latentista esityksestä ohjeen mukaisesti, tuottaen yhtenäisen kuvaulostulon.

Stable Diffusionia käytetään luovan sisällön tuottamiseen, markkinointimateriaaleihin, pelien assettien luontiin, verkkokaupan tuotevisualisointeihin, opetuksellisiin kuvituksiin sekä tekoälypohjaisiin chatteihin.

Kyllä, Stable Diffusion tukee kuva-kuvalta -käännöksiä ja paikkausta (inpainting), jolloin käyttäjät voivat muokata olemassa olevia kuvia tai täydentää puuttuvia osia tekstiohjeiden perusteella.

Tehokas kuvagenerointi Stable Diffusionilla edellyttää tietokonetta, jossa on nykyaikainen näytönohjain (GPU). Malli vaatii myös Pythonin sekä kirjastoja, kuten PyTorch ja Diffusers.

Kyllä, Stable Diffusion on julkaistu sallivalla avoimen lähdekoodin lisenssillä, mikä kannustaa yhteisön osallistumista, räätälöintiä ja laajaa saavutettavuutta.

Vapauta luovuutesi Stable Diffusionilla ja näe, miten tekoäly voi muuttaa ideasi upeiksi visuaaleiksi.

Luo korkealaatuisia kuvia tekstikehotteista Stability AI Kuvageneraattori -komponentilla. Stable Diffusion -mallien voimin toimiva työkalu tarjoaa muokattavia a...

Tutustu perusteelliseen arvosteluumme Stability AI SD3 Largesta. Analysoimme sen vahvuuksia, heikkouksia ja luovia tuloksia erilaisilla tekstistä kuvaksi -pyynn...

Black Forest Labsin Flux AI -malli on edistynyt tekstistä-kuvaksi -järjestelmä, joka muuntaa luonnollisen kielen kehotteet erittäin yksityiskohtaisiksi, valokuv...