Tokeni

Tokeni suurten kielimallien (LLM) yhteydessä on merkkijono, jonka malli muuntaa numeerisiksi esityksiksi tehokasta käsittelyä varten. Tokenit ovat tekstin perus...

Ikkunointi tekoälyssä jakaa datan hallittaviin osiin, parantaen kontekstin käsittelyä ja tehokkuutta NLP:ssä, keskusteluboteissa, käännöksissä ja aikasarja-analyyseissä.

Ikkunointi tekoälyssä tarkoittaa menetelmää, jossa dataa käsitellään osissa eli “ikkunoissa” järjestyksellisen tiedon analysoimiseksi ja oivallusten tuottamiseksi. Luonnollisen kielen käsittelyn (NLP) alalla ikkunointi on erityisen merkittävää, sillä sen ansiosta mallit voivat tarkastella vain osaa datasta kerrallaan, mikä helpottaa tekstin ymmärtämistä ja tuottamista kontekstuaalisten vihjeiden perusteella. Jakamalla dataa osiin tekoälyjärjestelmät pystyvät hallitsemaan laskentaresursseja tehokkaasti säilyttäen kyvyn tunnistaa olennaisia kuvioita datassa.

NLP:n ja suurten kielimallien (LLM) yhteydessä ikkunointi liittyy usein konteksti-ikkunoihin. Nämä ovat kiinteitä token-määriä, jotka malli pystyy käsittelemään samanaikaisesti. Tokenit ovat tekstin osia, kuten sanoja tai osasanoja, ja mallin kerralla hallitsema token-määrä määrittää konteksti-ikkunan koon. Tämän ansiosta tekoälymallit voivat keskittyä tekstin tiettyihin osiin ja tuottaa vastauksia relevantin kontekstin pohjalta.

Ikkunointia käytetään tekoälyssä järjestyksellisen datan tehokkaaseen hallintaan ja käsittelyyn. NLP:ssä se mahdollistaa pitkien tekstien pilkkomisen hallittaviin osiin. Jokainen ikkuna sisältää tietyn määrän tokeneita, jotka tarjoavat kontekstin mallin analyysille ja vastausten tuottamiselle. Tämä menetelmä on välttämätön tehtävissä, jotka vaativat ihmiskielen ymmärtämistä ja tuottamista, sillä mallit voivat huomioida tarvittavan kontekstin ilman, että koko datasekvenssi kuormittaa niitä liikaa.

Käytännössä ikkunointi auttaa malleja keskittymään tekstin olennaisiin osiin jättäen epäolennaisen tiedon huomiotta. Tämä on erityisen hyödyllistä sovelluksissa kuten konekäännös, tunteiden analyysi ja keskusteleva tekoäly, joissa välittömän kontekstin ymmärtäminen on olennaista täsmällisten ja johdonmukaisten vastausten tuottamiseksi. Ikkunoinnin ansiosta tekoälyjärjestelmät pystyvät säilyttämään suorituskykynsä ja tehokkuutensa myös käsitellessään pitkiä tai monimutkaisia aineistoja.

Luonnollisen kielen käsittelyssä ikkunointia käytetään tekstidatan jäsentämiseen ja ymmärtämiseen. Esimerkiksi tunteiden analyysissä malli voi käyttää ikkunointia tarkastellakseen tiettyä määrää sanoja kohdeilmauksen ympärillä selvittääkseen, millainen tunne tekstissä ilmaistaan. Keskittymällä tiettyyn tekstin ikkunaan malli pystyy tunnistamaan kontekstiin vaikuttavia tekijöitä, kuten kieltosanoja tai voimistavia ilmauksia.

Konekäännösjärjestelmät hyödyntävät ikkunointia kääntäessään tekstiä kielestä toiseen. Malli käsittelee lähdetekstin osia konteksti-ikkunan sisällä, jolloin käännös ottaa huomioon olennaisen kielellisen kontekstin. Tämä auttaa säilyttämään käännöksen merkityksen ja kieliopin, erityisesti silloin kun kielet eroavat lauserakenteiltaan.

Keskustelubotit hyödyntävät ikkunointia keskustelun hallinnassa. Keskittymällä konteksti-ikkunan sisällä oleviin viimeisimpiin vuorovaikutuksiin botti pystyy tuottamaan relevantteja ja johdonmukaisia vastauksia. Tämä on tärkeää luonnollisen ja mukaansatempaavan vuoropuhelun ylläpitämiseksi. Esimerkiksi asiakaspalvelubotti voi hyödyntää ikkunointia muistamaan aiemmat asiakaskysymykset ja tarjoamaan tarkkaa apua käynnissä olevan keskustelun perusteella.

Aikasarja-analyysissä ikkunointia käytetään aikajanan varrella kerättyjen datapisteiden käsittelyyn analysoimalla osia liikkuvan ikkunan sisällä. Tämän tekniikan avulla tekoälymallit voivat tunnistaa trendejä, kuvioita tai poikkeamia tietyissä aikajaksoissa. Esimerkiksi talousennusteessa tekoälyjärjestelmä voi käyttää ikkunointia analysoidakseen osakkeen hintoja rullaavassa aikaikkunassa ennustaakseen tulevaa markkinakehitystä.

Ikkunointi mahdollistaa tekoälyjärjestelmille keskittymisen tekstin olennaisiin osiin, mikä on välttämätöntä tehtävissä, joissa vaaditaan kontekstin ymmärtämistä. Käsittelemällä dataa konteksti-ikkunan sisällä mallit pystyvät havaitsemaan kielen vivahteet ja riippuvuudet, joita tarvitaan tarkkaan tulkintaan ja sisällön tuottamiseen.

Lisäksi ikkunointi auttaa laskentaresurssien hallinnassa rajoittamalla kerralla käsiteltävän datan määrää. Tämä on tärkeää, jotta NLP-mallit voivat skaalautua suuriin aineistoihin tai toimia reaaliaikaisissa sovelluksissa. Ikkunointi varmistaa, että mallit pysyvät tehokkaina ja responsiivisina myös laajoja tai monimutkaisia kielidatoja käsitellessään.

Suurissa kielimalleissa konteksti-ikkuna tarkoittaa tokeneiden jonoa, jonka malli ottaa huomioon syötettä käsitellessään. Konteksti-ikkunan koko määrittää, kuinka paljon tekstiä malli pystyy analysoimaan kerralla. Suuremmat konteksti-ikkunat mahdollistavat laajempien tekstikokonaisuuksien huomioimisen, mikä auttaa havaitsemaan pitkän aikavälin riippuvuuksia ja parantaa tuotettujen vastausten johdonmukaisuutta.

Konteksti-ikkunan koko vaikuttaa suoraan suurten kielimallien suorituskykyyn. Suuremmalla konteksti-ikkunalla mallit pystyvät käsittelemään pidempiä syötteitä ja tuottamaan kontekstuaalisesti osuvampia vastauksia. Tämä on erityisen tärkeää esimerkiksi tekstin tiivistämisessä tai pitkän sisällön tuottamisessa, joissa laajemman kontekstin ymmärtäminen on olennaista.

Kuitenkin konteksti-ikkunan koon kasvattaminen tuo mukanaan haasteita. Suuremmat ikkunat vaativat enemmän laskentaresursseja, ja suorituskyvyn parantuminen voi olla rajallista. Konteksti-ikkunan koon ja tehokkuuden tasapainottaminen on keskeinen huomio mallien suunnittelussa ja käyttöönotossa.

Eri LLM-malleilla on erilaisia konteksti-ikkunoiden kokoja. Esimerkiksi:

Tokenisointi on prosessi, jossa teksti jaetaan pienempiin yksiköihin eli tokeneihin. NLP:ssä tämä on perusvaihe, joka mahdollistaa tekstidatan käsittelyn ja analysoinnin tekoälymalleilla. Tokenit voivat olla sanoja, osasanoja tai jopa yksittäisiä merkkejä, riippuen kielestä ja käytetystä tokenisointialgoritmista.

Esimerkiksi lause “The quick brown fox jumps over the lazy dog” voidaan tokenisoida yksittäisiksi sanoiksi tai osasanoiksi, jolloin malli voi käsitellä kutakin elementtiä järjestyksessä. Tokenisointi auttaa syötteen standardoinnissa ja tekee siitä laskennallisesti hallittavaa.

Positionaalinen koodaus on tekniikka, jota käytetään transformer-pohjaisissa malleissa tiedon lisäämiseksi tokenien sijainnista sekvenssissä. Koska transformerit käsittelevät tokeneita rinnakkain eivätkä järjestyksessä, positionaalinen koodaus varmistaa, että malli tietää tokenien järjestyksen, mikä on ratkaisevaa tekstin syntaksin ja merkityksen ymmärtämiseksi.

Python-koodina positionaalinen koodaus voidaan toteuttaa esimerkiksi näin:

import torch

import math

def positional_encoding(position, d_model):

pe = torch.zeros(position, d_model)

for pos in range(position):

for i in range(0, d_model, 2):

pe[pos, i] = math.sin(pos / (10000 ** ((2 * i)/d_model)))

pe[pos, i + 1] = math.cos(pos / (10000 ** ((2 * (i + 1))/d_model)))

return pe

Tämä koodi tuottaa positionaalisen koodausmatriisin, joka voidaan lisätä token-upotuksiin, tuoden mallille tiedon jokaisen tokenin sijainnista.

Ikkunoinnin yhteydessä tokenisointi ja positionaalinen koodaus toimivat yhdessä mahdollistaen mallin käsitellä tokeneiden jonoja konteksti-ikkunan sisällä. Tokenisointi pilkkoo tekstin yksiköihin, jotka malli pystyy ymmärtämään, ja positionaalinen koodaus säilyttää näiden tokenien järjestyksen. Tämä yhdistelmä antaa tekoälyjärjestelmälle mahdollisuuden analysoida tekstiä tarkasti kussakin ikkunassa säilyttäen tarvittavan johdonmukaisuuden ja kontekstin merkityksellisten vastausten tuottamiseksi.

Yksi ikkunoinnin suurimmista haasteista tekoälyssä on laskennallinen monimutkaisuus suurilla konteksti-ikkunoilla. Ikkunan koon kasvaessa myös käsittelyn vaatimat resurssit kasvavat, usein eksponentiaalisesti. Tämä voi johtaa kasvaviin kustannuksiin ja hitaampiin käsittelyaikoihin, mikä ei aina ole käytännöllistä reaaliaikasovelluksissa tai resurssirajoitetuilla laitteilla.

Vaikka ikkunointi auttaa datan tehokkaassa hallinnassa, se voi myös johtaa tiedon menetykseen. Kun keskitytään vain konteksti-ikkunan sisällä olevaan dataan, malli voi jättää huomiotta tärkeitä tietoja, jotka sijaitsevat sen ulkopuolella. Tämä voi vaikuttaa ennusteiden tarkkuuteen tai tuotettujen vastausten relevanssiin erityisesti tehtävissä, joissa laajempi ymmärrys datasta on tarpeen.

Optimaalisen tasapainon löytäminen konteksti-ikkunan koon ja laskentatehokkuuden välillä on merkittävä haaste. Liian pieni ikkuna ei tarjoa riittävästi kontekstia mallin tehokkaaseen suoritukseen, kun taas liian suuri ikkuna voi olla raskas ja hidas. Tämä edellyttää huolellista harkintaa ja optimointia mallin suunnittelussa ja käyttöönotossa.

Ikkunointi voi vaikeuttaa mallien kykyä tunnistaa pitkäaikaisia riippuvuuksia järjestyksellisessä datassa. Kielenkäsittelyssä kaukana toisistaan olevien sanojen tai ilmauksien välisten suhteiden ymmärtäminen on tärkeää esimerkiksi diskurssianalyysissä tai narratiivin hahmottamisessa. Ikkunointi rajoittaa mallin näkymän kiinteään osaan, mikä voi vaikeuttaa näiden pitkän aikavälin suhteiden tunnistamista.

Ikkunointi tekoälyssä on prosessi, jossa data jaetaan osiin eli ikkunoihin järjestyksellisen tiedon tehokasta analyysia varten. Se auttaa malleja hallitsemaan kontekstia ja laskentatehoa, erityisesti NLP:ssä ja suurissa kielimalleissa.

Ikkunointi mahdollistaa NLP- ja LLM-malleille tekstin käsittelyn hallittavissa osissa, optimoiden resurssien käytön ja mahdollistaen kontekstuaalisen analyysin. Tämä on kriittistä esimerkiksi käännöksissä, tunteiden analyysissä ja keskustelullisessa tekoälyssä.

Ikkunointia käytetään NLP:ssä tekstin analyysiin, konekäännöksiin, keskusteluboteissa keskustelujen hallintaan sekä aikasarja-analyysissä tunnistamaan trendejä ja ilmiöitä tietyissä aikajaksoissa.

Haasteita ovat muun muassa laskennallinen monimutkaisuus suurilla ikkunoilla, tiedon menetyksen riski ikkunan ulkopuolella, tasapainottelu ikkunan koon ja tehokkuuden välillä sekä pitkäaikaisten riippuvuuksien hahmottamisen vaikeus järjestyksellisessä datassa.

Älykkäät keskustelubotit ja tekoälytyökalut yhdessä paikassa. Yhdistä intuitiivisia lohkoja ja muuta ideasi automatisoiduiksi Floweiksi.

Tokeni suurten kielimallien (LLM) yhteydessä on merkkijono, jonka malli muuntaa numeerisiksi esityksiksi tehokasta käsittelyä varten. Tokenit ovat tekstin perus...

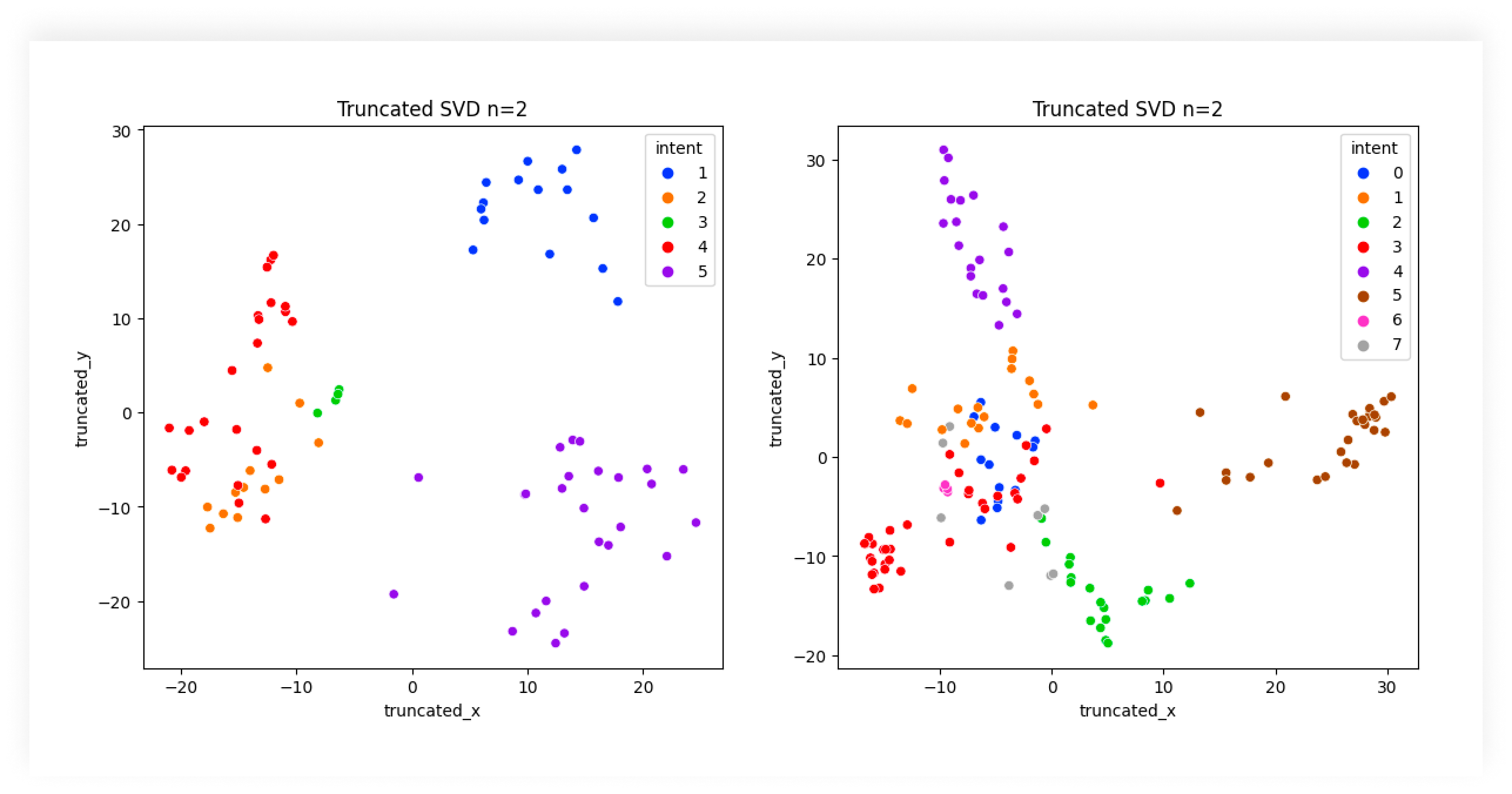

Tekstin luokittelu, tunnetaan myös nimillä tekstin kategorisointi tai tekstin tunnisteiden lisääminen, on keskeinen NLP-tehtävä, jossa tekstidokumenteille annet...

Tutustu tekoälyn intenttiluokituksen olennaiseen rooliin käyttäjävuorovaikutuksen parantamisessa teknologian kanssa, asiakastuen kehittämisessä ja liiketoiminta...