Human-in-the-Loop – Guide pour les dirigeants d'entreprise sur une IA responsable

Un guide pratique destiné aux dirigeants d'entreprise pour la mise en œuvre de cadres Human-in-the-Loop (HITL) afin d'assurer une gouvernance responsable de l’I...

Le Guide des Risques et Contrôles de l’IA de KPMG offre aux organisations une approche structurée et éthique pour gérer les risques liés à l’IA, favorisant un déploiement responsable et conforme aux normes mondiales.

Cette statistique date peut-être de l’an dernier, mais elle n’a jamais été aussi pertinente. Selon le KPMG’s 2024 U.S. CEO Outlook, pas moins de 68 % des PDG considèrent l’IA comme une priorité d’investissement majeure. Ils comptent sur elle pour accroître l’efficacité, perfectionner les compétences de leur personnel et stimuler l’innovation dans leurs organisations.

C’est un vote de confiance massif envers l’IA — mais cela soulève aussi une question essentielle : avec autant d’enjeux, comment les organisations s’assurent-elles de l’utilisation responsable et éthique de l’IA ?

C’est là que le Guide des Risques et Contrôles de l’IA de KPMG intervient. Il propose un cadre clair et concret pour aider les entreprises à exploiter le potentiel de l’IA tout en gérant les risques réels qu’elle implique. Dans le contexte actuel, bâtir une IA digne de confiance n’est plus seulement une bonne pratique — c’est devenu une nécessité stratégique.

L’intelligence artificielle (IA) révolutionne les secteurs, ouvrant la voie à une efficacité, une innovation et une compétitivité inédites. Mais cette transformation s’accompagne de risques et de défis éthiques particuliers que les organisations doivent gérer avec rigueur pour maintenir la confiance et garantir un usage responsable. Le Guide des Risques et Contrôles de l’IA de KPMG est conçu pour accompagner les organisations dans cette complexité, en proposant une approche pratique, structurée et fondée sur les valeurs pour la gouvernance de l’IA.

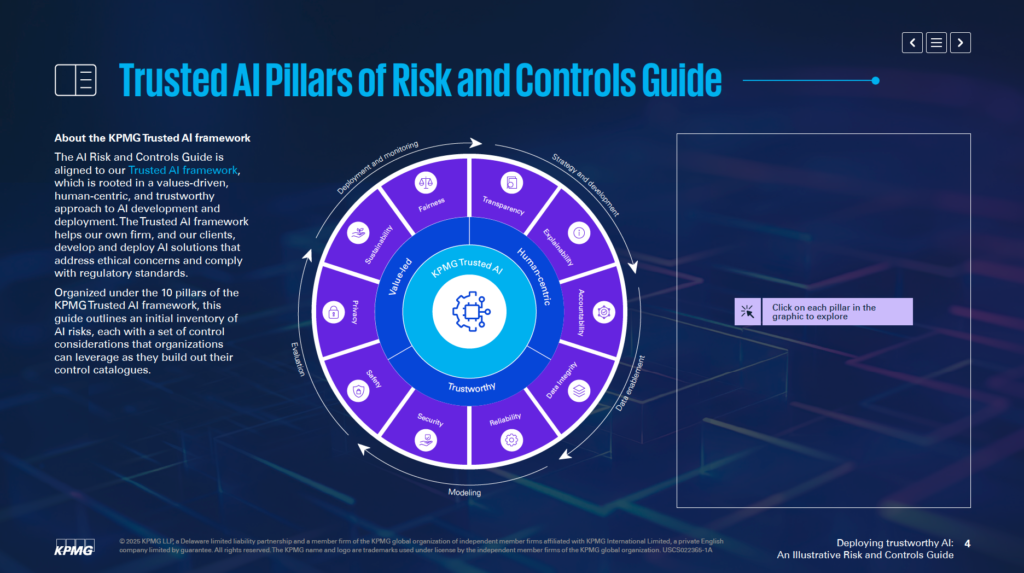

Aligné sur le Cadre IA de confiance de KPMG, ce guide aide les entreprises à développer et déployer des solutions d’IA éthiques, centrées sur l’humain et conformes aux normes réglementaires mondiales. Il s’articule autour de 10 piliers fondamentaux, chacun répondant à un aspect clé de la gestion des risques liés à l’IA :

En s’appuyant sur ces piliers, les organisations peuvent intégrer les principes éthiques à chaque étape du cycle de vie de l’IA — de la stratégie au développement, jusqu’au déploiement et au suivi. Ce guide améliore la résilience face aux risques tout en favorisant une innovation durable, digne de confiance et en phase avec les attentes sociétales.

Que vous soyez professionnel des risques, dirigeant, data scientist ou conseiller juridique, ce guide vous offre des outils et des perspectives essentiels pour exploiter la puissance de l’IA de manière responsable.

Le Guide des Risques et Contrôles de l’IA de KPMG est une ressource spécialisée pour aider les organisations à gérer les risques spécifiques liés à l’intelligence artificielle (IA). Il reconnaît que, si l’IA offre un potentiel considérable, ses complexités et enjeux éthiques exigent une approche de gestion des risques dédiée. Le guide fournit une structure pour relever ces défis de façon responsable et efficace.

Ce guide ne vise pas à remplacer les systèmes actuels, mais à compléter les processus existants de gestion des risques. Son objectif principal est d’intégrer les considérations propres à l’IA dans la gouvernance de l’organisation, assurant une cohérence avec les pratiques opérationnelles en place. Cette approche permet de renforcer les capacités de gestion des risques sans avoir à repenser entièrement les cadres existants.

Le guide s’appuie sur le Cadre IA de confiance de KPMG, qui privilégie une démarche fondée sur les valeurs et centrée sur l’humain. Il intègre les principes de normes reconnues comme l’ISO 42001, le cadre de gestion des risques IA du NIST et l’AI Act européen. Ainsi, le guide reste à la fois pratique et conforme aux meilleures pratiques et aux exigences réglementaires internationales en matière de gouvernance de l’IA.

Le guide propose des recommandations concrètes et des exemples pratiques pour gérer les risques liés à l’IA. Il encourage les organisations à adapter ces exemples à leurs contextes, en tenant compte de variables telles que le développement interne ou par des fournisseurs, ainsi que des types de données et de techniques exploitées. Cette flexibilité garantit la pertinence du guide pour différents secteurs et cas d’usage de l’IA.

Le guide vise à permettre aux organisations de déployer l’IA de façon sûre, éthique et transparente. En abordant les aspects techniques, opérationnels et éthiques des risques IA, il aide à instaurer la confiance auprès des parties prenantes tout en tirant parti du potentiel de transformation de l’IA.

Le guide constitue une ressource pour garantir l’alignement des systèmes d’IA avec les objectifs d’entreprise, tout en atténuant les risques potentiels. Il soutient l’innovation en mettant l’accent sur la responsabilité.

Le Guide de Gouvernance IA de KPMG s’adresse à tous les professionnels impliqués dans le pilotage de l’IA et veillant à son déploiement sécurisé, éthique et efficace. Il concerne les équipes de divers domaines au sein des organisations, notamment :

Les membres du comité de direction, comme les PDG, DSI ou CTO, trouveront dans ce guide un appui pour faire de l’IA une priorité stratégique. Selon l’étude KPMG 2024 US CEO Outlook, 68 % des PDG considèrent l’IA comme un axe d’investissement clé. Ce guide permet d’aligner la stratégie IA sur les objectifs de l’organisation tout en gérant les risques associés.

Les ingénieurs logiciels, data scientists et autres acteurs impliqués dans la création et le déploiement de solutions IA peuvent intégrer les principes éthiques et les contrôles directement dans leurs systèmes grâce au guide. Il met l’accent sur l’adaptation des pratiques de gestion des risques à l’architecture spécifique et aux flux de données des modèles IA.

Le guide s’adapte aussi bien aux entreprises développant des IA en interne, qu’à celles les achetant à des fournisseurs ou utilisant des jeux de données propriétaires. Il est particulièrement pertinent pour des secteurs comme la finance, la santé ou la tech, où l’IA avancée et les données sensibles sont au cœur de l’activité.

Déployer l’IA sans un cadre de gouvernance clair peut entraîner des risques financiers, réglementaires et réputationnels. Le guide KPMG s’intègre aux processus existants pour proposer une approche structurée et éthique de la gestion des risques IA. Il promeut la responsabilité, la transparence et les bonnes pratiques, aidant les organisations à exploiter l’IA de façon responsable tout en libérant son potentiel.

Les organisations doivent commencer par relier les risques spécifiques à l’IA à leur taxonomie des risques actuelle. Une taxonomie des risques est une structure permettant d’identifier, organiser et traiter les vulnérabilités potentielles. L’IA introduisant de nouveaux enjeux, les taxonomies traditionnelles doivent s’élargir à ces facteurs, tels que la qualité des flux de données, la logique des algorithmes ou la fiabilité des sources. Ainsi, les risques IA sont intégrés à la gestion globale des risques, et non traités à part.

Le guide recommande d’évaluer le cycle de vie complet des systèmes IA. Il s’agit notamment d’identifier l’origine des données, leurs parcours, et la logique des modèles IA sous-jacents. Cette vision globale permet de repérer où peuvent survenir des vulnérabilités lors du développement ou de l’exploitation de l’IA.

Les systèmes IA diffèrent selon leur finalité, leurs méthodes de développement et la nature des données utilisées. Qu’un modèle soit développé en interne ou acheté à un tiers influence fortement les risques. De même, le type de données (propriétaires, publiques ou sensibles) et les techniques d’IA requièrent des stratégies de gestion des risques sur mesure.

Le guide recommande d’ajuster les mesures de contrôle en fonction des besoins spécifiques de vos systèmes IA. Par exemple, si vous exploitez des données propriétaires, il faudra renforcer les contrôles d’accès. À l’inverse, l’utilisation d’une IA d’un fournisseur externe nécessitera une évaluation approfondie des risques tiers. Cette adaptation permet de mieux répondre aux défis propres à chaque système IA.

Le guide préconise d’intégrer les pratiques de gestion des risques à chaque phase du cycle de vie de l’IA. Cela inclut la prise en compte des risques dès la conception, la mise en place de systèmes de surveillance robustes au moment du déploiement, et l’actualisation régulière des évaluations à mesure que le système évolue. En traitant les risques à chaque étape, vous renforcez la fiabilité et l’éthique de vos systèmes IA.

Aligner les risques IA sur la taxonomie existante et adapter les contrôles à vos besoins constitue une base solide pour une IA de confiance. Ces efforts permettent d’identifier, d’évaluer et de gérer les risques de façon systématique, établissant un cadre robuste de gouvernance IA.

Le Cadre IA de confiance de KPMG repose sur dix piliers essentiels qui couvrent les défis éthiques, techniques et opérationnels de l’intelligence artificielle. Ces piliers guident la conception, le développement et le déploiement responsables des systèmes IA, garantissant la confiance et la responsabilité à chaque étape du cycle de vie.

La supervision humaine et la responsabilité doivent être présentes tout au long du cycle de vie de l’IA. Cela implique de désigner clairement qui gère les risques IA, de garantir la conformité aux lois et réglementations, et de garder la possibilité d’intervenir, de bloquer ou d’annuler des décisions prises par l’IA si nécessaire.

Les systèmes IA doivent viser à réduire ou éliminer les biais susceptibles de nuire à des individus, communautés ou groupes. Cela suppose une analyse rigoureuse des données pour qu’elles représentent la diversité, l’application de mesures d’équité au développement et une surveillance continue des résultats pour promouvoir un traitement équitable.

La transparence suppose d’expliquer ouvertement le fonctionnement des systèmes IA et leurs décisions. Cela inclut la documentation des limites, des résultats de performance et des méthodes de test. Les utilisateurs doivent être informés lors de la collecte de leurs données, les contenus générés par IA doivent être clairement identifiés, et les applications sensibles comme la catégorisation biométrique doivent prévoir des notifications explicites.

Les systèmes IA doivent fournir des raisons compréhensibles à leurs décisions. Pour cela, il convient de documenter en détail les jeux de données, les algorithmes et les métriques de performance, permettant ainsi aux parties prenantes d’analyser et de reproduire les résultats.

La qualité et la fiabilité des données à chaque étape — collecte, étiquetage, stockage, analyse — sont cruciales. Des contrôles doivent être mis en place pour limiter la corruption ou les biais. Des vérifications régulières et des tests de régression lors des mises à jour systèmes garantissent la précision et la fiabilité de l’IA.

Les solutions IA doivent respecter les lois sur la vie privée et la protection des données. Les organisations doivent gérer correctement les demandes des personnes concernées, réaliser des analyses d’impact sur la vie privée, et recourir à des techniques avancées comme la confidentialité différentielle pour concilier exploitation des données et protection des individus.

Les systèmes IA doivent fournir des performances constantes, conformes à leur objectif et à la précision requise. Cela passe par des tests approfondis, des mécanismes de détection d’anomalies et des boucles de rétroaction continues pour valider les résultats.

Des mesures de sûreté protègent contre les dommages à des personnes, entreprises ou biens. Cela comprend la conception de dispositifs de secours, la surveillance des attaques (empoisonnement des données, injection de prompts…), et l’alignement des systèmes aux standards éthiques et opérationnels.

Des pratiques de sécurité strictes sont requises pour protéger l’IA des menaces et actes malveillants. Les organisations doivent réaliser des audits réguliers, des évaluations de vulnérabilité et utiliser le chiffrement pour les données sensibles.

Les systèmes IA doivent être conçus pour limiter la consommation d’énergie et contribuer aux objectifs environnementaux. Les considérations de durabilité doivent être intégrées dès la conception, avec un suivi continu de la consommation énergétique, de l’efficacité et des émissions tout au long du cycle IA.

En appliquant ces dix piliers, les organisations conçoivent des systèmes IA éthiques, dignes de confiance et alignés sur les attentes sociétales. Ce cadre offre une structure claire pour relever les défis IA tout en favorisant une innovation responsable.

L’intégrité des données est essentielle pour garantir l’exactitude, l’équité et la fiabilité des systèmes IA. Une mauvaise gestion des données peut entraîner des biais, des résultats inexacts ou peu fiables. Ces problèmes nuisent à la confiance dans l’IA et peuvent causer des conséquences opérationnelles et réputationnelles majeures. Le cadre IA de confiance de KPMG souligne la nécessité de maintenir une qualité de données élevée tout au long du cycle de vie pour garantir le bon fonctionnement des systèmes IA et le respect des normes éthiques.

Sans gouvernance forte, les systèmes IA peuvent produire des résultats erronés. Des données incomplètes, inexactes ou inadaptées génèrent des biais ou des sorties peu fiables, augmentant les risques dans toutes les applications IA.

Les données circulent souvent entre systèmes pour l’entraînement, les tests ou l’exploitation. Si ces transferts ne sont pas correctement gérés, les données peuvent être corrompues, perdues ou altérées, ce qui impacte les performances des systèmes IA.

Pour renforcer la gouvernance des données, il convient de :

Pour limiter les risques lors des transferts, les organisations doivent :

La mise en place de systèmes de surveillance continue permet de préserver l’intégrité des données tout au long du cycle IA. Ces systèmes détectent les changements inattendus dans la qualité des jeux de données ou les incohérences de traitement, permettant des corrections rapides.

Préserver l’intégrité des données est indispensable pour déployer des systèmes IA de confiance. Les organisations peuvent réduire les risques en instaurant une gouvernance solide, en sécurisant les échanges de données et en maintenant des processus de validation continue. Ces actions renforcent la fiabilité des résultats IA tout en garantissant le respect des standards éthiques et opérationnels, et contribuent à instaurer la confiance dans les technologies d’IA.

La gestion des demandes d’accès des personnes concernées est un enjeu majeur de la vie privée en IA. Les organisations doivent permettre aux individus d’exercer leurs droits d’accès, de rectification ou de suppression de leurs données personnelles, conformément à des lois comme le RGPD ou le CCPA. Un traitement inadéquat de ces demandes peut entraîner des violations réglementaires, une perte de confiance et nuire à la réputation de l’organisation.

Pour limiter ce risque, il est recommandé de mettre en place des programmes de sensibilisation aux droits des personnes lors des interactions avec l’IA. Les systèmes doivent être capables de traiter rapidement et de manière transparente ces demandes. Les organisations doivent également documenter précisément la gestion de ces requêtes pour démontrer leur conformité en cas d’audit.

Les systèmes IA traitent fréquemment des informations personnelles sensibles, ce qui en fait des cibles pour la cybercriminalité. En cas de fuite, les conséquences sont lourdes : amendes réglementaires, atteinte à la réputation et perte de confiance client.

Pour s’en prémunir, le cadre IA de confiance de KPMG recommande des revues éthiques des systèmes traitant des données personnelles pour s’assurer du respect des réglementations. Des audits réguliers et des analyses d’impact sur la vie privée (AIPD) sont nécessaires, surtout lors de l’utilisation de données sensibles pour l’entraînement des modèles. Des techniques comme la confidentialité différentielle, qui ajoute du bruit statistique, permettent aussi d’anonymiser les données tout en préservant la possibilité d’analyse.

Les systèmes IA qui n’intègrent pas la confidentialité dès la conception présentent des risques majeurs. Sans appliquer le principe de privacy by design, les organisations s’exposent à des fuites de données sensibles ou à des manquements réglementaires.

Il est essentiel d’intégrer la confidentialité dès la phase de développement des systèmes IA. Cela passe par le respect des lois sur la vie privée et des bonnes pratiques de gestion des données. Une documentation claire des modalités de collecte, d’utilisation et de stockage des données est indispensable. Les organisations doivent également recueillir le consentement explicite des utilisateurs pour la collecte et le traitement des données, en particulier pour les données sensibles comme la biométrie.

Lorsque les systèmes IA n’expliquent pas clairement comment les données utilisateurs sont traitées, cela peut entraîner une défiance et une exposition juridique. Les utilisateurs doivent être informés lors de la collecte de leurs données et comprendre comment elles sont utilisées

Le Guide des Risques et Contrôles de l’IA de KPMG est un cadre pratique conçu pour aider les organisations à gérer les risques spécifiques à l’IA, en assurant un déploiement responsable, éthique et conforme de l’IA dans tous les secteurs.

Le guide repose sur dix piliers clés : Responsabilité, Équité, Transparence, Explicabilité, Intégrité des données, Fiabilité, Sécurité, Sûreté, Confidentialité et Durabilité — chacun abordant un aspect crucial de la gestion des risques liés à l’IA.

Le guide s’adresse aux professionnels des risques, équipes de conformité, spécialistes de la cybersécurité, conseillers juridiques, dirigeants, développeurs d’IA, ingénieurs et toutes les organisations cherchant à gérer l’IA de manière responsable.

Il est aligné sur des normes mondiales telles que l’ISO 42001, le Cadre de gestion des risques IA du NIST et l’AI Act européen, aidant les organisations à intégrer des contrôles spécifiques à l’IA dans les processus de gouvernance existants et à répondre aux exigences réglementaires.

Il préconise des mesures telles qu’une gouvernance rigoureuse des données, la confidentialité dès la conception, le suivi continu, la transparence des décisions de l’IA, la détection d’anomalies, les boucles de rétroaction et des objectifs de durabilité pour réduire les risques liés à l’IA.

Découvrez comment le Guide des Risques et Contrôles de l’IA de KPMG peut aider votre organisation à adopter l’innovation IA tout en garantissant un déploiement éthique, sécurisé et conforme.

Un guide pratique destiné aux dirigeants d'entreprise pour la mise en œuvre de cadres Human-in-the-Loop (HITL) afin d'assurer une gouvernance responsable de l’I...

Découvrez pourquoi le leadership en IA est essentiel à la réussite organisationnelle, comment des leaders solides impulsent la transformation IA, et comment l’a...

Les taux d'adoption de l'IA indiquent le pourcentage d'organisations ayant intégré l'intelligence artificielle dans leurs opérations. Ces taux varient selon les...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.