LLM Anthropic AI

Connectez les modèles Claude d’Anthropic à votre tableau de bord FlowHunt pour une génération de texte IA flexible et des solutions de chatbot, avec contrôle des jetons, de la température et du choix du modèle.

Description du composant

Comment fonctionne le composant LLM Anthropic AI

Different tasks call for different models, and FlowHunt is committed to giving you the best of AI without the need to sign up for countless subscriptions. Instead, you get dozens of text and image generator models in a single dashboard. The LLM type of components houses text generation and their diverse applications in AI, content creation, and automation.") models grouped by provider, allowing you to swap AI models on the fly.

What is the LLM Anthropic AI component?

The LLM Anthropic AI component connects the Claude family of models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

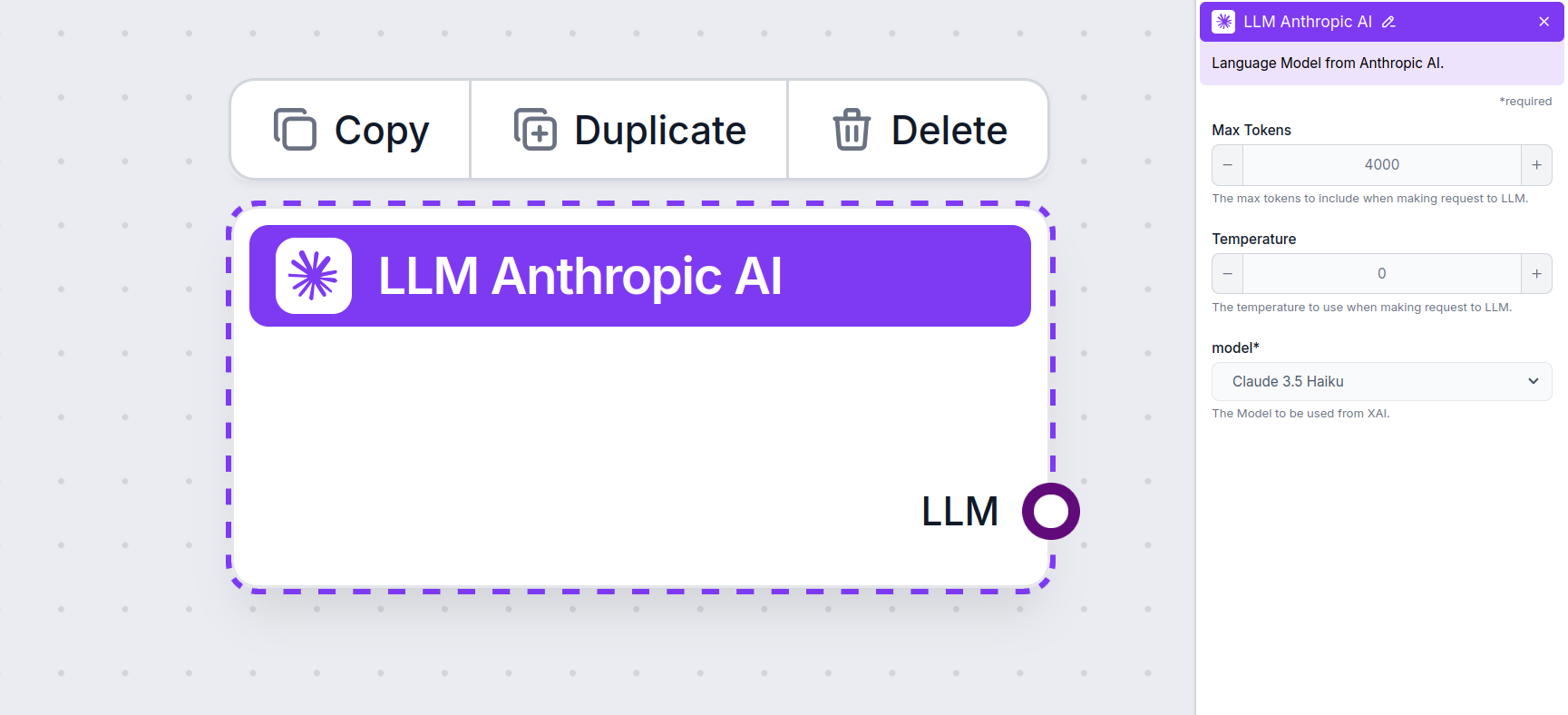

LLM Anthropic AI Component Settings

Max Tokens

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature

Temperature controls the variability of answers, ranging from 0 to 1.

- A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

- A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

Model

This is the model picker. Here, you’ll find all the supported models from Anthropic. We currently support all the latest models from the Claude family:

- Claude 3.5 Sonnet – The newest version of Claude’s mid-range model. This model combines speed and quality, making it great for most tasks. Learn more here.

- Claude 3 Sonnet – An older version of the popular mid-range model. Check out our article to see how well it compares.

- Claude 3 Haiku – Light and fast model, ideal for doing simple tasks in bulk. Despite being the least powerful, it still fares well when faced with more complex tasks. See our full test of the model.

- Claude 2 – A strong-performing legacy model. Learn more about how it thinks here.

How To Add The LLM Anthropic AI To Your Flow

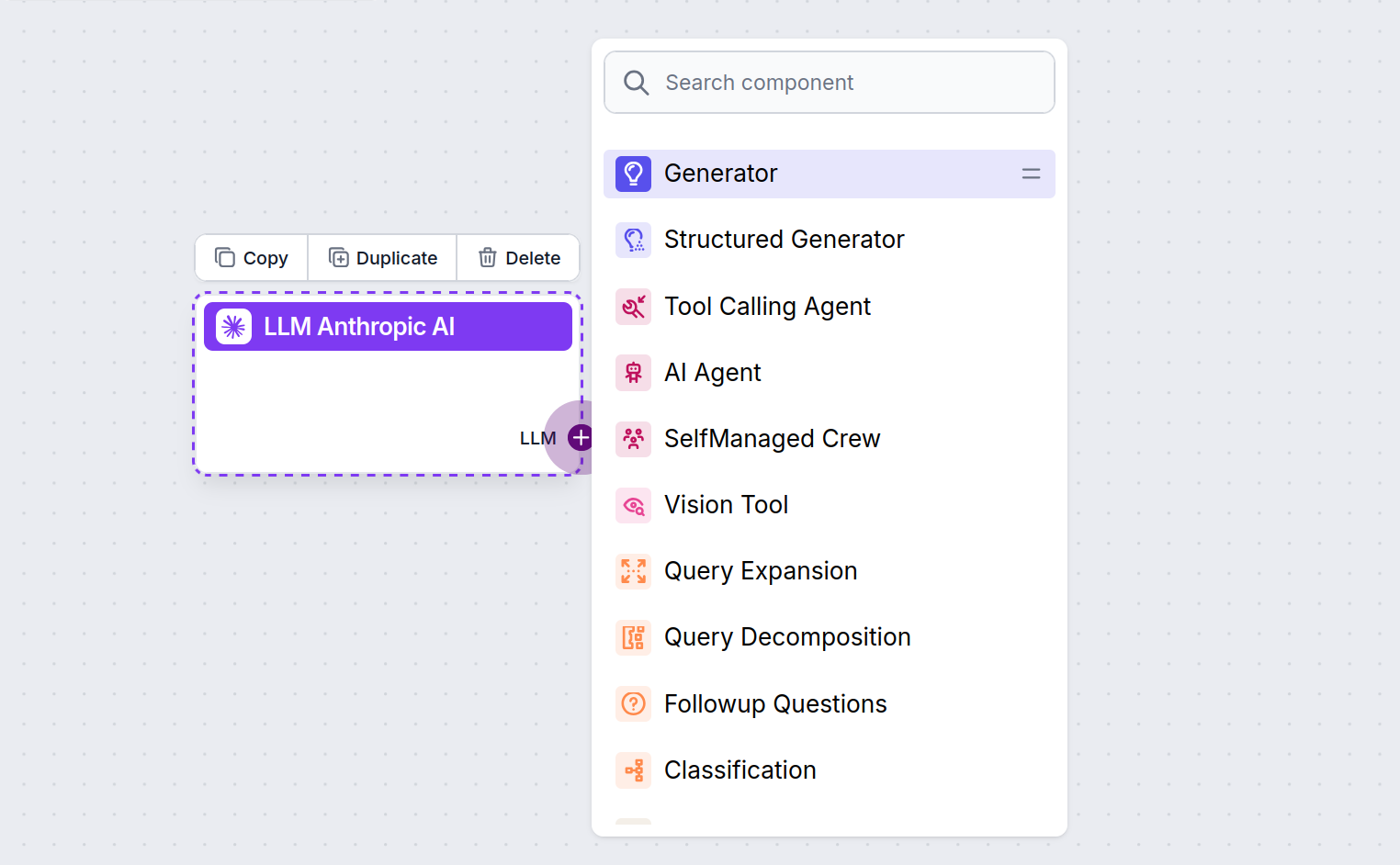

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

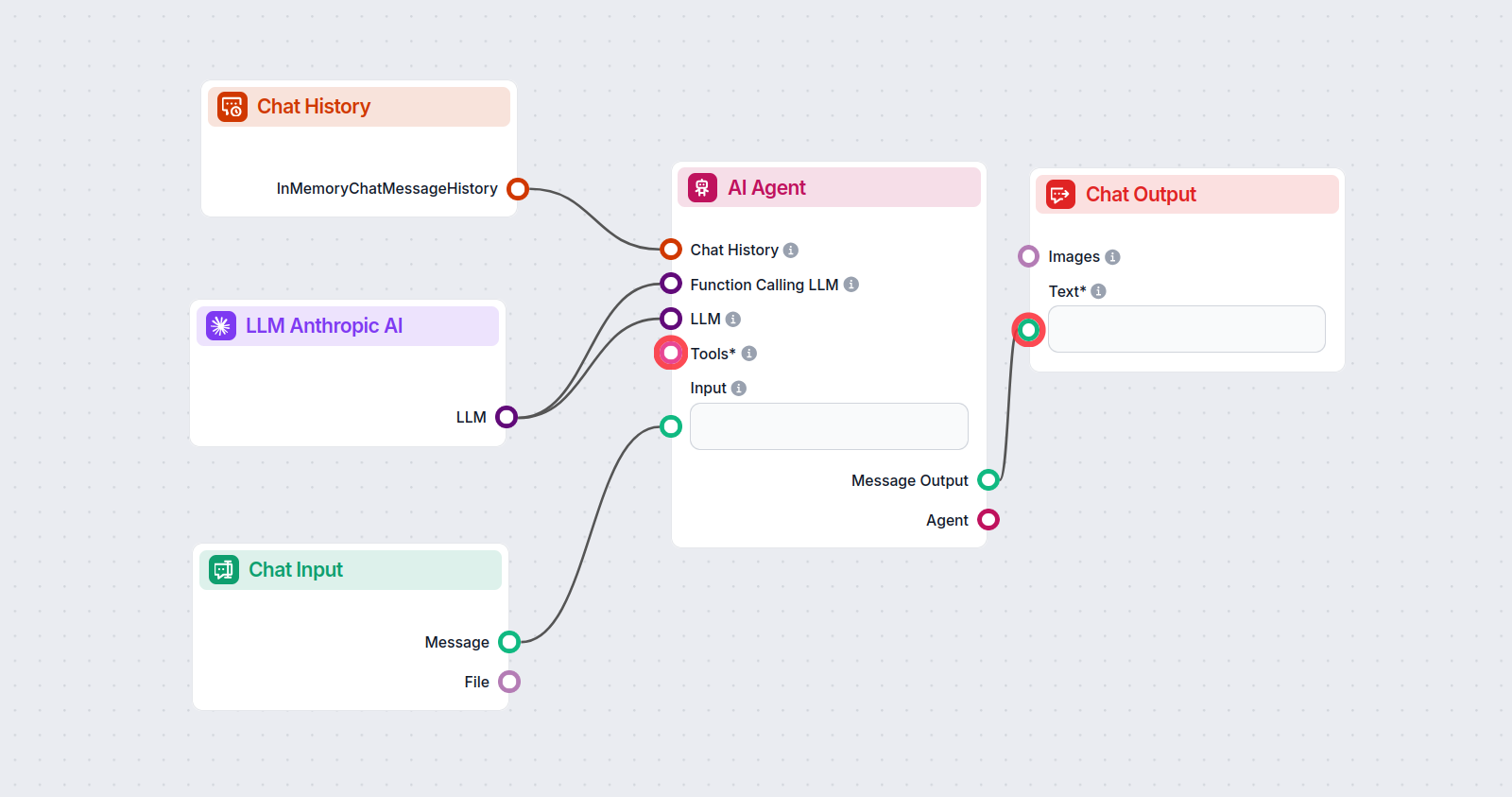

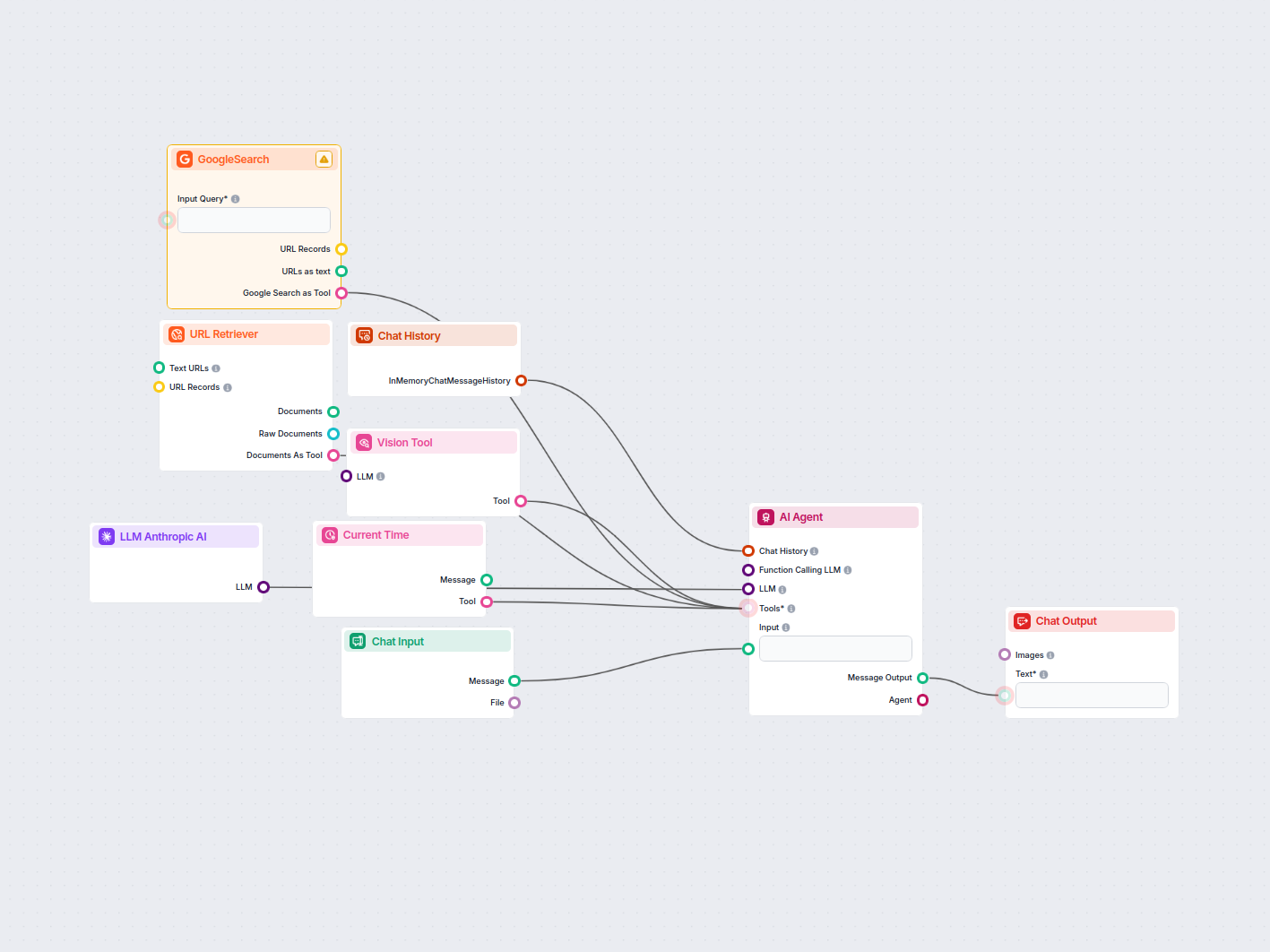

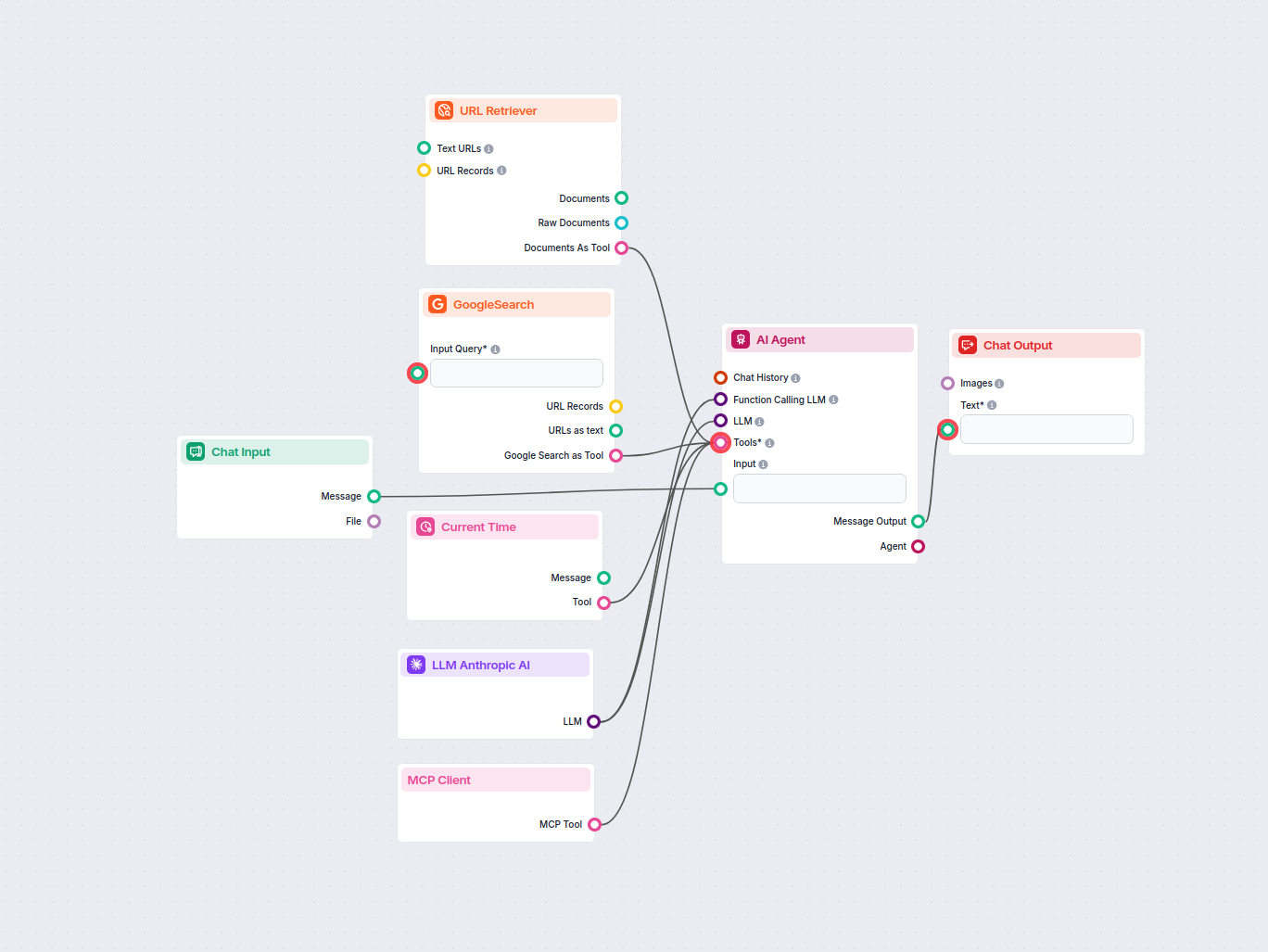

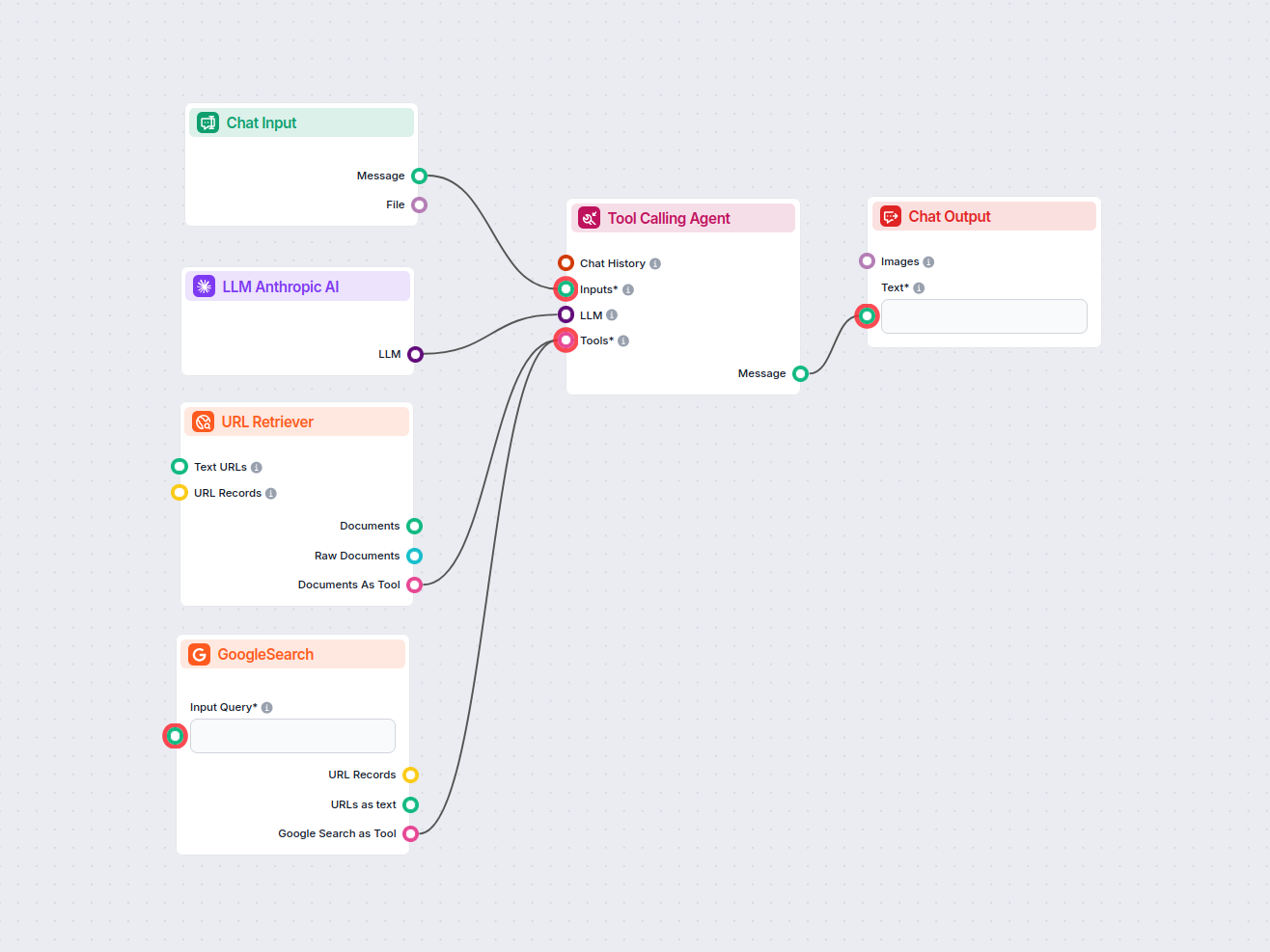

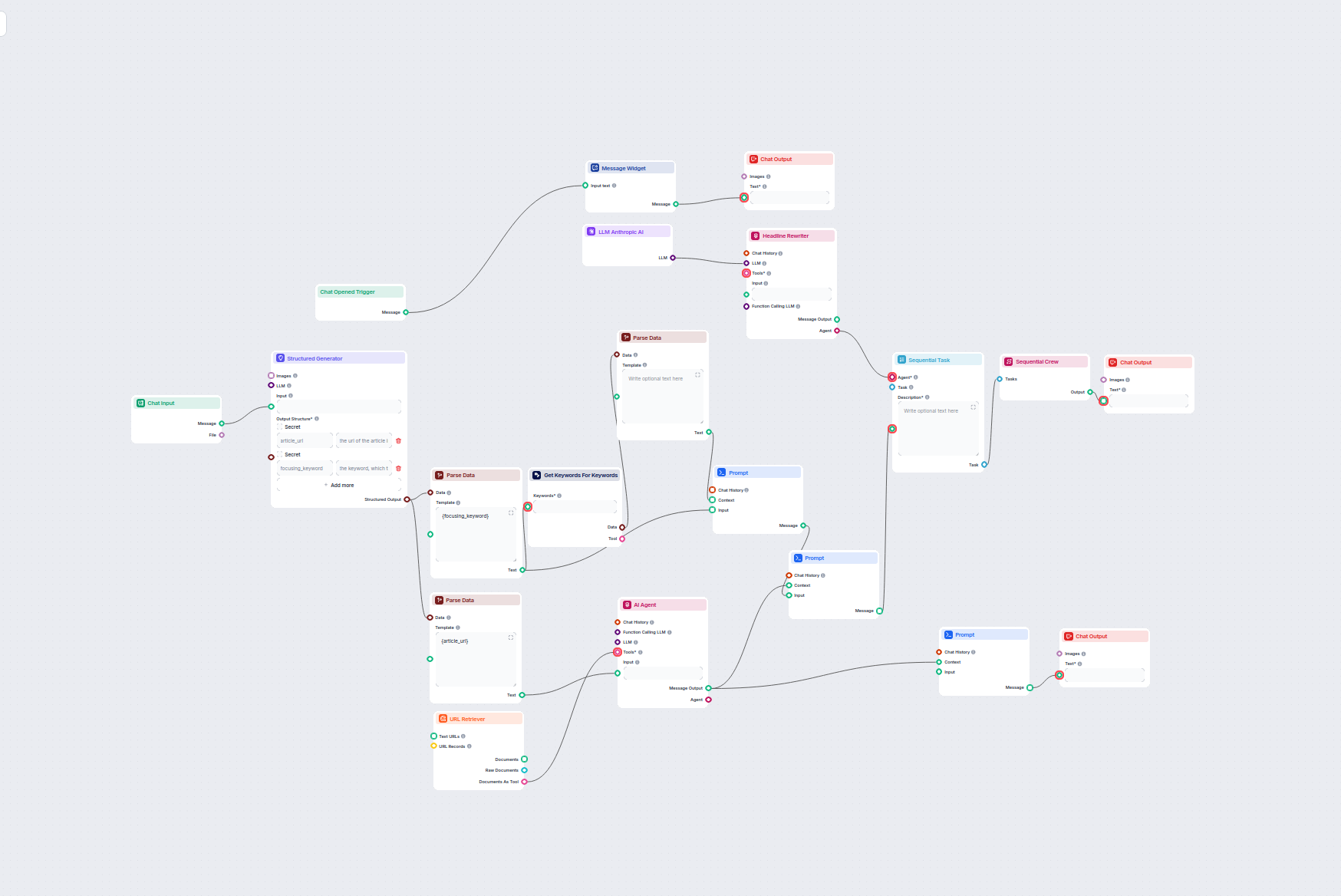

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Anthropic’s Claude 3.5 Sonnet to generate responses. You can think of it as a basic Anthropic chatbot.

This simple Chatbot Flow includes:

- Chat input: Represents the message a user sends in chat.

- Chat history: Ensures the chatbot can remember and factor in past responses.

- Chat output: Represents the chatbot’s final response.

- AI Agent: An autonomous AI agent that generates responses.

- LLM Anthropic AI: The connection to Anthropic’s text generation models.

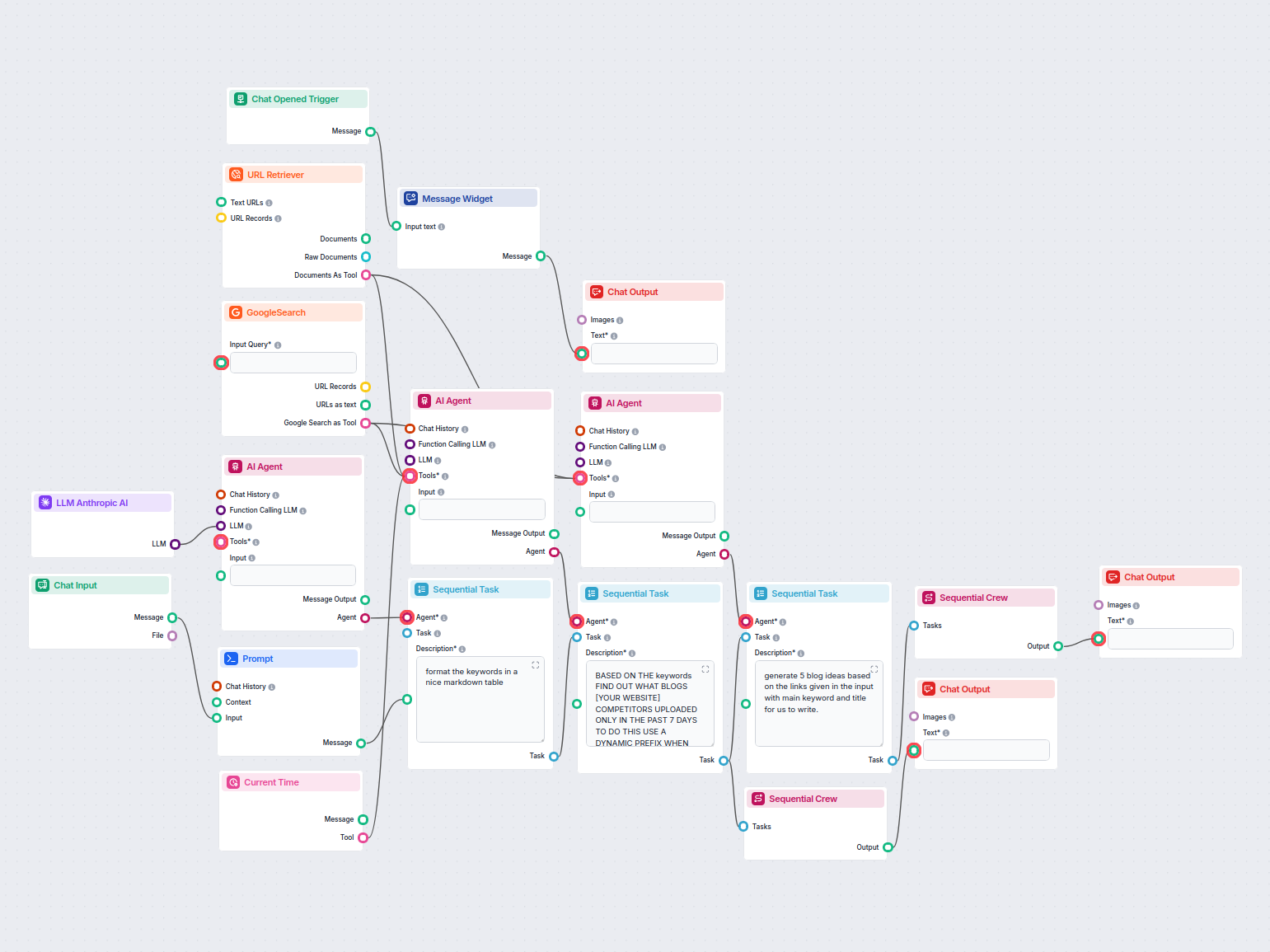

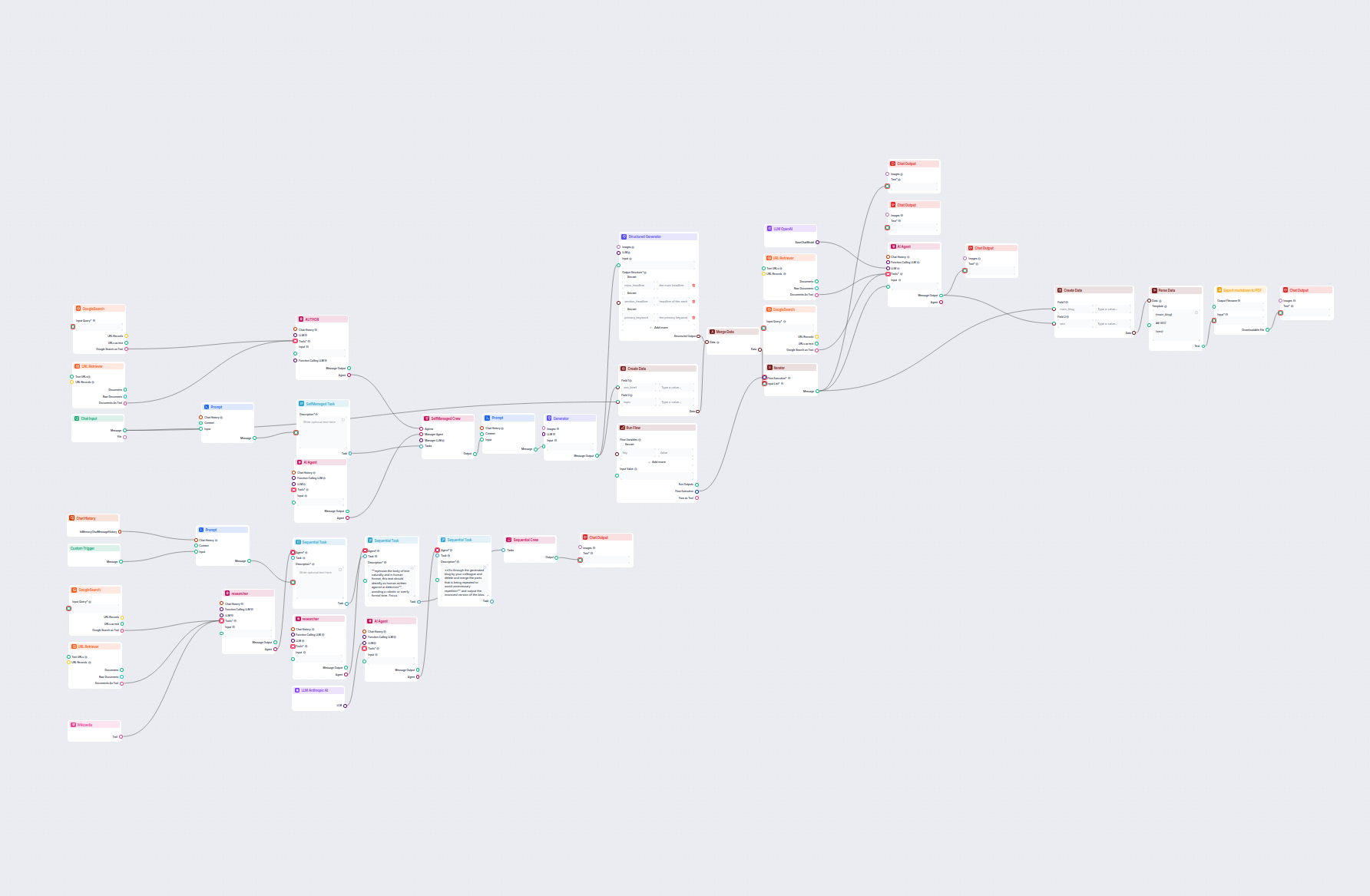

Exemples de modèles de flux utilisant le composant LLM Anthropic AI

Pour vous aider à démarrer rapidement, nous avons préparé plusieurs exemples de modèles de flux qui démontrent comment utiliser efficacement le composant LLM Anthropic AI. Ces modèles présentent différents cas d'utilisation et meilleures pratiques, facilitant votre compréhension et l'implémentation du composant dans vos propres projets.

Analyse de blogs concurrents & Générateur d'idées d'articles

Analysez automatiquement les blogs concurrents les mieux classés de la semaine passée et générez de nouvelles idées d’articles pour votre site web. Ce flux de t...

Analyseur de concurrents publicitaires LinkedIn

Ce workflow automatise l’étude de marché publicitaire sur LinkedIn en identifiant les principaux concurrents pour un mot-clé, en analysant leurs textes et visue...

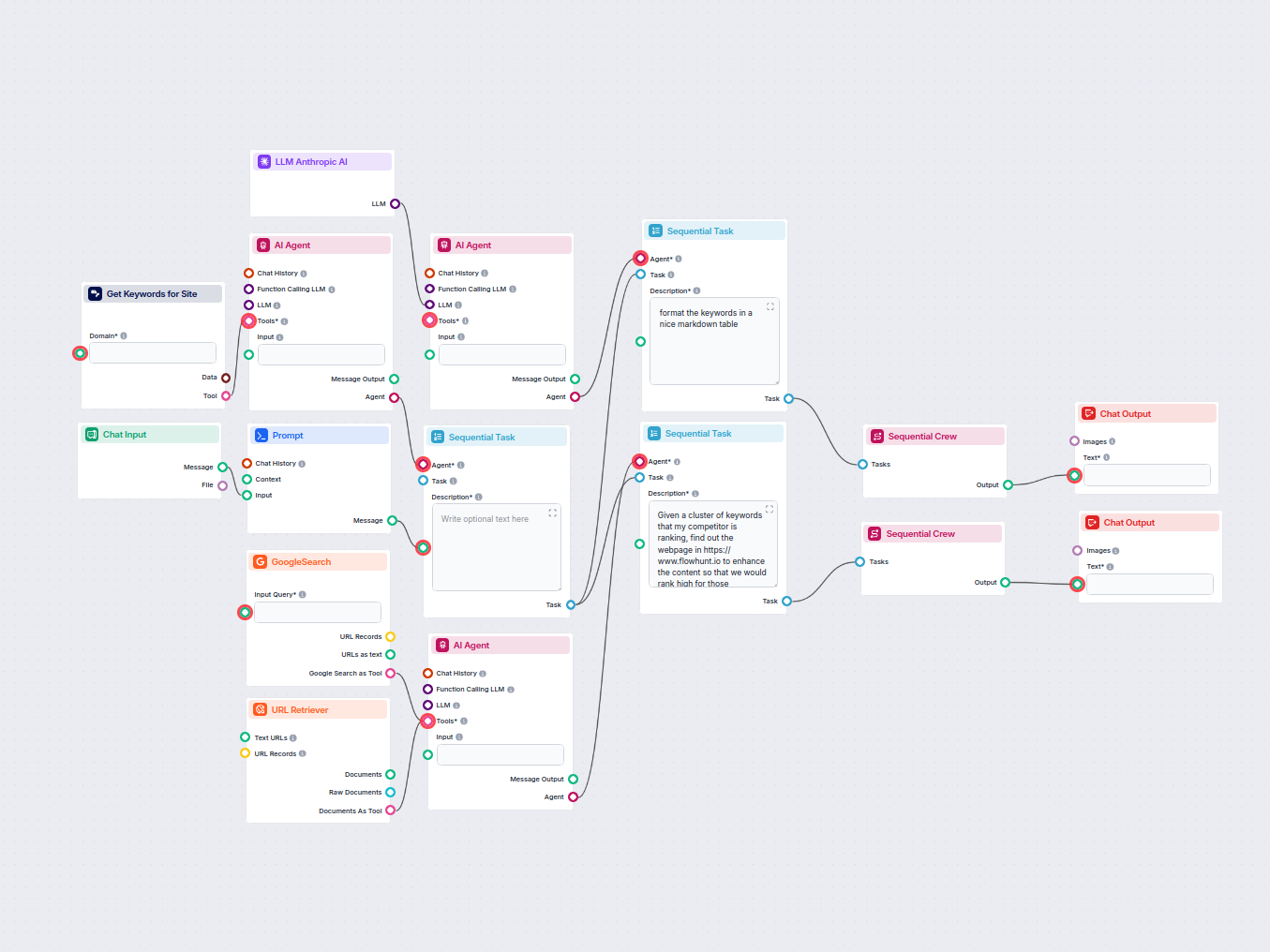

Analyseur de mots-clés concurrents SEO par IA

Analysez automatiquement l’URL de la page d’accueil de votre concurrent pour découvrir ses mots-clés les mieux classés, collectez les données de mots-clés depui...

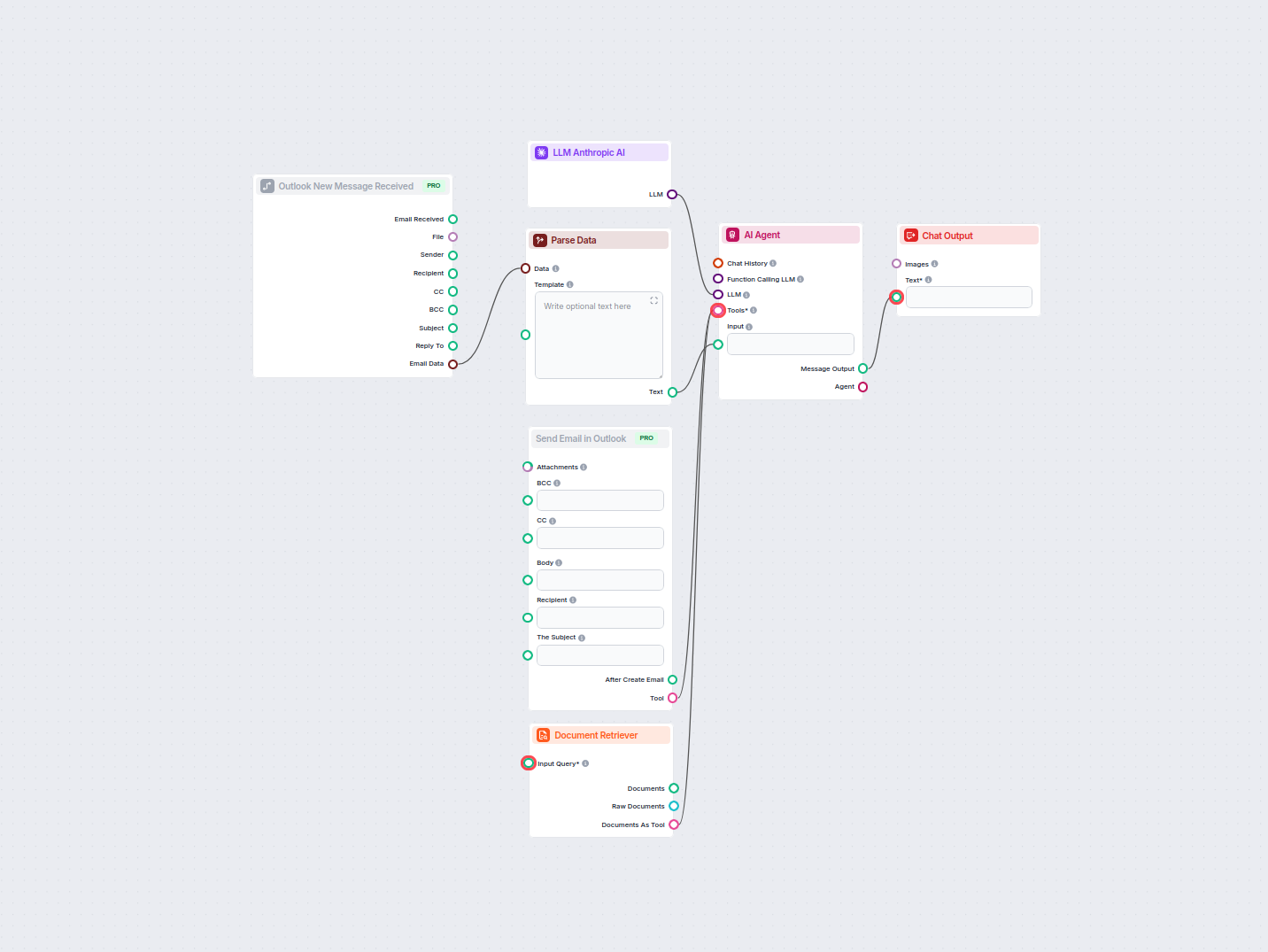

Automatisation des réponses email Outlook alimentée par l’IA

Automatisez les réponses professionnelles aux emails dans Outlook grâce à un agent IA exploitant les sources de connaissances organisationnelles. Les emails ent...

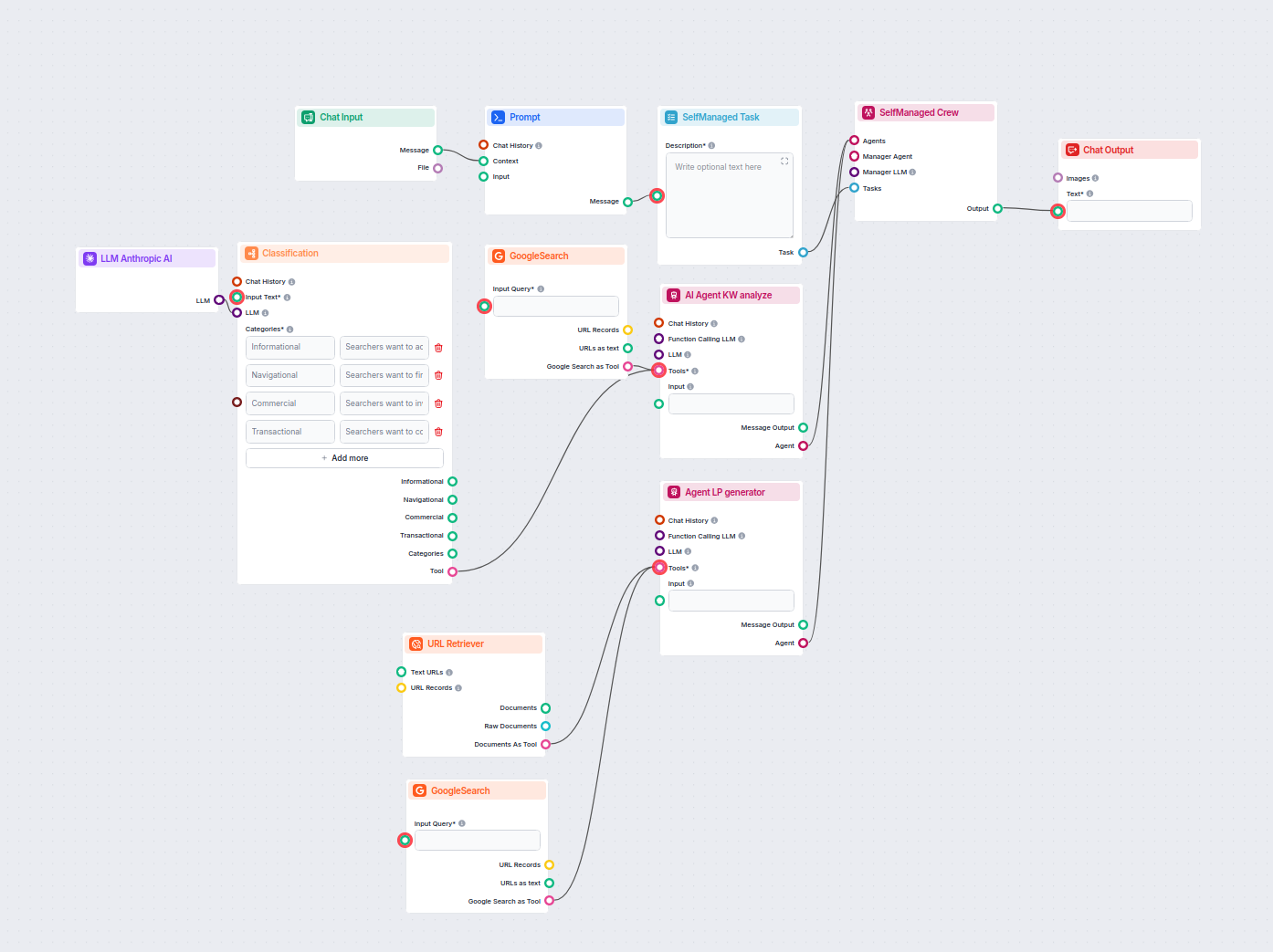

Classificateur d’Intentions de Recherche & Générateur de Page d’Atterrissage

Ce workflow alimenté par l’IA classe les requêtes de recherche selon leur intention, recherche les URLs les mieux positionnées, et génère une page d’atterrissag...

Générateur Avancé d’Articles de Blog par IA

Générez des articles de blog complets, optimisés pour le SEO, avec une structure avancée et un nombre de mots élevé grâce à plusieurs agents IA. Le workflow inc...

Générateur d'idées de blog IA pour l'analyse des concurrents et des tendances

Ce workflow propulsé par l'IA analyse les concurrents et les sujets tendance pour générer des idées de blog à fort impact, optimisées SEO pour FlowHunt.io. En u...

Générateur de descriptions de catégories e-commerce par IA

Générez automatiquement des descriptions optimisées pour le référencement (SEO) des pages de catégories e-commerce grâce à l'IA. Il suffit de fournir une URL de...

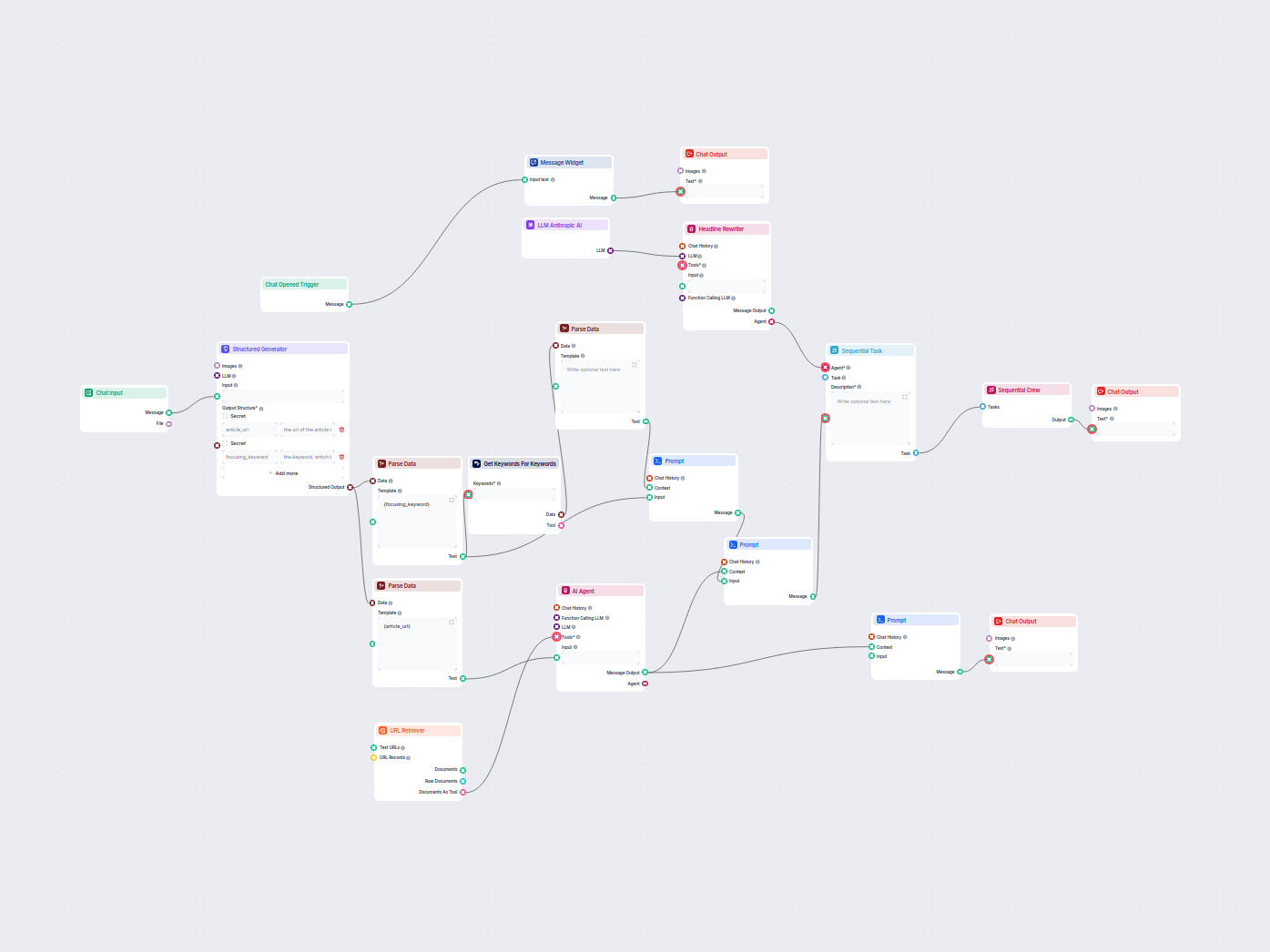

Optimiseur de titres d'articles SEO

Optimisez automatiquement les titres et en-têtes de vos articles pour un mot-clé ou un cluster de mots-clés spécifique afin d'améliorer la performance SEO. Ce w...

Optimiseur de titres de blog et de mots-clés par IA

Ce flux de travail alimenté par l'IA identifie les meilleurs mots-clés SEO pour votre article de blog et réécrit automatiquement les titres afin de cibler ces m...

Questions fréquemment posées

- Qu'est-ce que le composant LLM Anthropic AI dans FlowHunt ?

Le composant LLM Anthropic AI connecte les modèles Claude d’Anthropic à vos flows FlowHunt, vous permettant de personnaliser le modèle utilisé pour la génération de texte et de contrôler des paramètres comme le nombre maximal de jetons et la température.

- Quels modèles Claude sont pris en charge ?

FlowHunt prend en charge tous les derniers modèles de la famille Claude, notamment Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku et Claude 2.

- Que contrôlent le nombre maximal de jetons et la température ?

Le nombre maximal de jetons définit la limite de longueur de chaque réponse, tandis que la température contrôle l’aléa : des valeurs basses rendent les réponses ciblées, des valeurs élevées augmentent la créativité.

- Est-il obligatoire de connecter un composant LLM Anthropic AI ?

Non, connecter le composant LLM Anthropic AI est facultatif. Par défaut, les composants utilisent ChatGPT-4o, mais vous pouvez ajouter ce composant pour passer aux modèles Claude et affiner les paramètres.

Essayez LLM Anthropic AI de FlowHunt

Commencez à créer des outils et chatbots IA personnalisés en utilisant les modèles Claude d’Anthropic avec une intégration facile dans vos flows et une configuration puissante.

En savoir plus

LLM OpenAI

FlowHunt prend en charge des dizaines de modèles de génération de texte, y compris ceux d’OpenAI. Voici comment utiliser ChatGPT dans vos outils IA et chatbots....

LLM Meta AI

FlowHunt prend en charge des dizaines de modèles de génération de texte, y compris les modèles Llama de Meta. Découvrez comment intégrer Llama dans vos outils e...

LLM xAI

FlowHunt prend en charge des dizaines de modèles de génération de texte, y compris ceux de xAI. Voici comment utiliser les modèles xAI dans vos outils et chatbo...