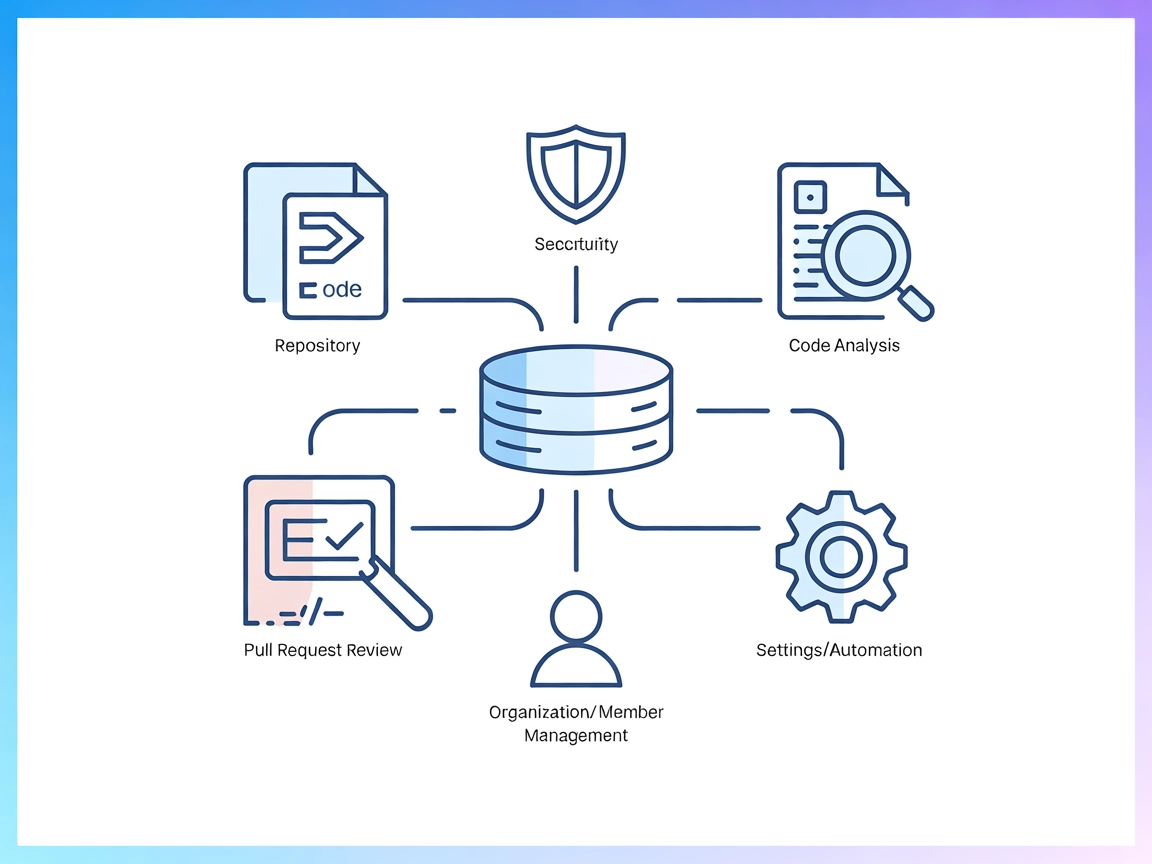

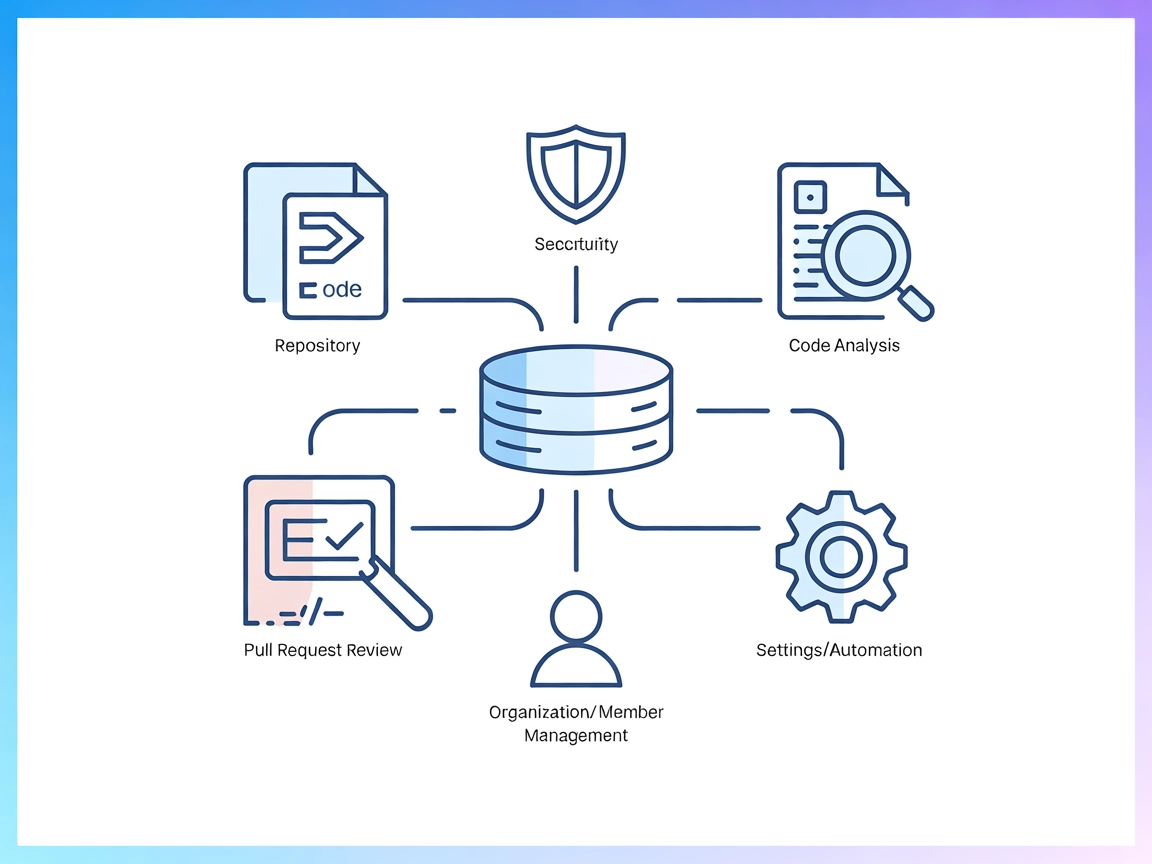

Intégration du serveur MCP Codacy

Le serveur MCP Codacy fait le lien entre les assistants IA et la plateforme Codacy, permettant l'automatisation de l’analyse de qualité de code, la sécurité, la...

Intégrez l’API de Coda avec FlowHunt grâce au serveur MCP Coda universel pour la gestion documentaire pilotée par l’IA et l’automatisation des workflows.

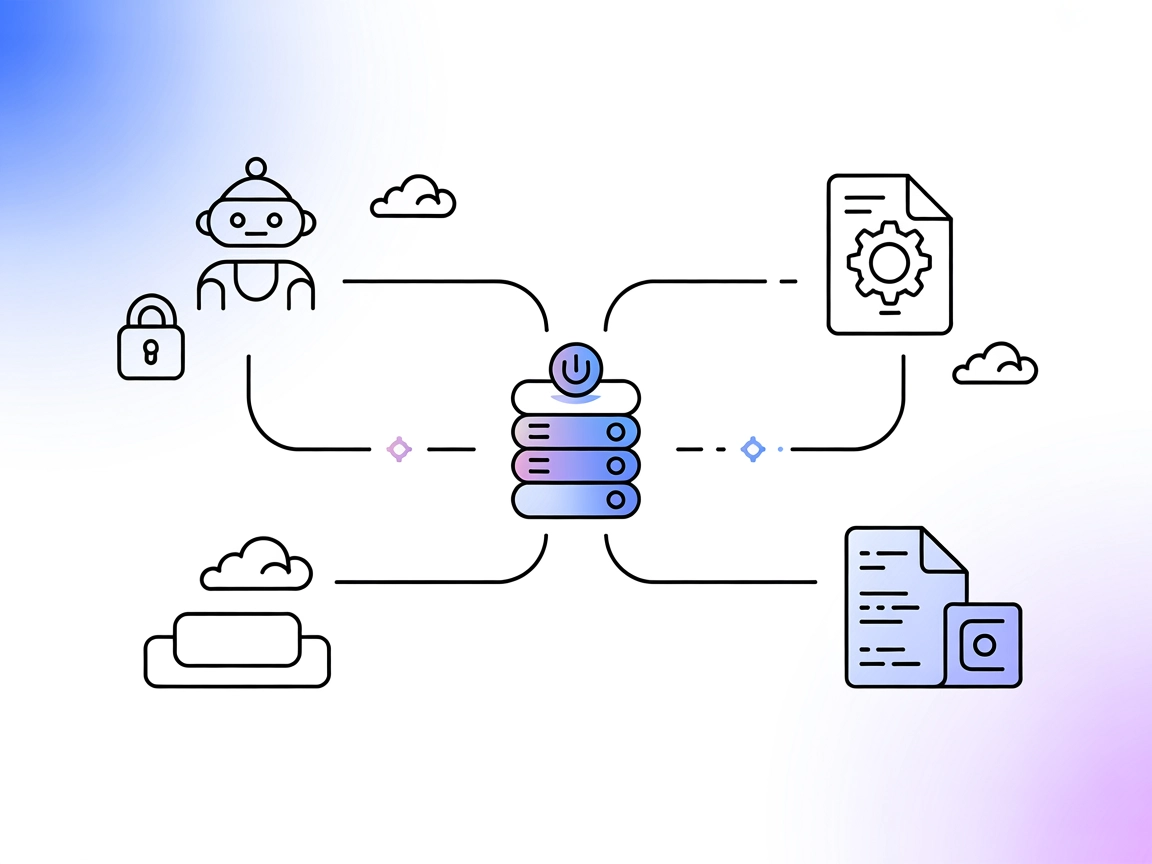

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

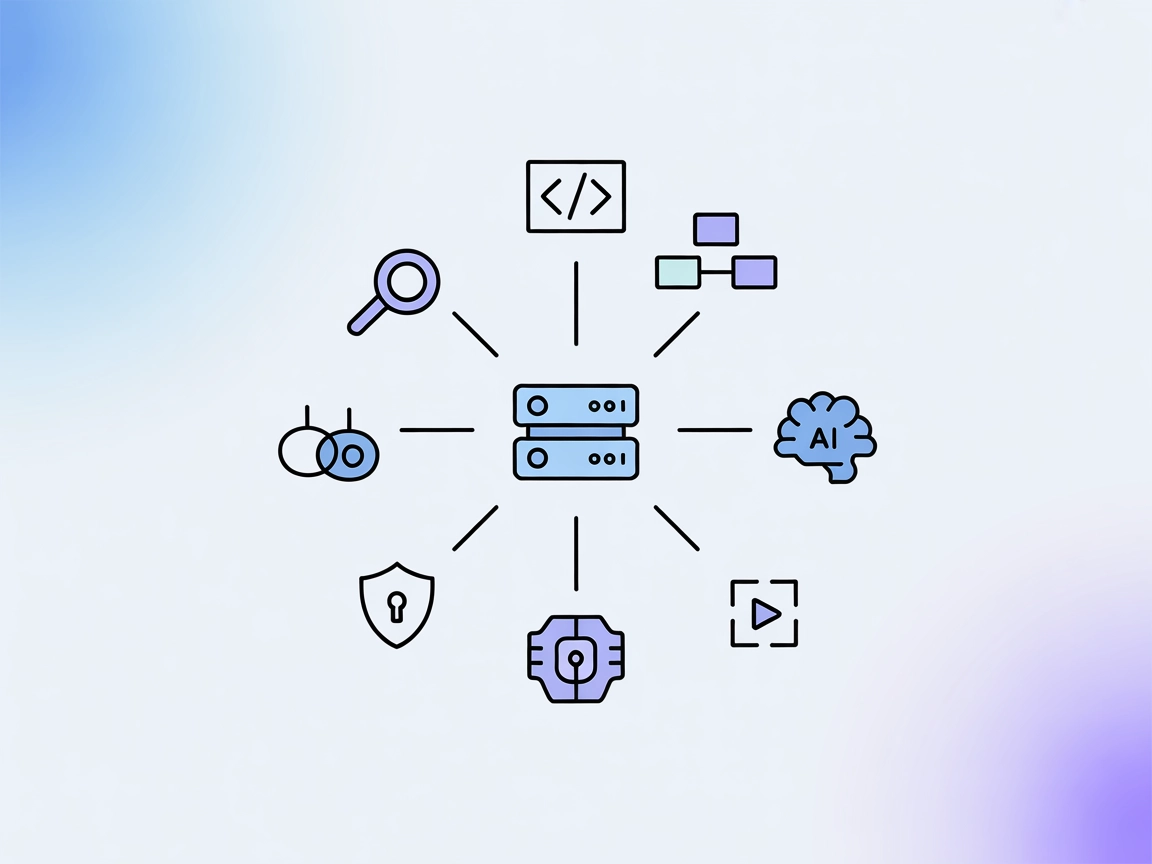

Le serveur MCP Coda (Model Context Protocol) est un serveur API universel et standardisé qui connecte les assistants IA à la suite d’outils et services de Coda. En implémentant la spécification MCP, le serveur MCP Coda permet aux clients IA d’interagir de manière programmatique avec Coda, facilitant ainsi des tâches telles que la recherche de documents, l’automatisation de workflows et la gestion de fichiers ou de données dans l’écosystème Coda. Cela permet aux développeurs de créer des workflows de développement améliorés, d’intégrer des données contextuelles dans les interactions avec des LLM et d’orchestrer des actions à travers des systèmes externes via un protocole unifié. Le serveur est conçu pour garantir la compatibilité avec d’autres services compatibles MCP, ce qui en fait un pont précieux entre les agents IA et la puissante plateforme de Coda.

Aucune information concernant des modèles de prompts n’a été trouvée dans les fichiers du dépôt.

Aucune ressource MCP explicite n’est documentée ou listée dans les fichiers disponibles.

Pour la liste complète des outils disponibles, la documentation fait référence à src/universal_mcp_coda/README.md . Cependant, le contenu de ce fichier n’étant pas disponible dans les informations fournies, les détails des outils ne peuvent pas être listés.

La documentation disponible ne fournit pas de cas d’usage spécifiques ni d’exemples de workflows pour le serveur MCP Coda.

uv sync

source .venv/bin/activate.venv\Scripts\Activatemcp dev src/universal_mcp_coda/server.py

mcp install src/universal_mcp_coda/server.py

Exemple de configuration JSON : Non fourni dans la documentation disponible.

Sécurisation des clés API : Aucun exemple ni instruction trouvé.

Aucune instruction d’installation spécifique à Claude n’est fournie.

Aucune instruction d’installation spécifique à Cursor n’est fournie.

Aucune instruction d’installation spécifique à Cline n’est fournie.

Utiliser MCP dans FlowHunt

Pour intégrer des serveurs MCP dans votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flow et connectez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration système MCP, insérez les détails de votre serveur MCP en utilisant ce format JSON :

{

"coda": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA peut désormais utiliser ce MCP comme un outil avec accès à toutes ses fonctions et capacités. N’oubliez pas de remplacer “coda” par le nom réel de votre serveur MCP et de renseigner l’URL de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Aperçu | ✅ | Résumé fourni dans le README.md |

| Liste des Prompts | ⛔ | Aucun prompt/modèle documenté |

| Liste des Ressources | ⛔ | Aucune ressource MCP explicite documentée |

| Liste des Outils | ⛔ | Outils mentionnés mais non listés dans le contenu disponible |

| Sécurisation des clés API | ⛔ | Aucune instruction ni exemple trouvé |

| Support de l’échantillonnage (moins important) | ⛔ | Aucun mention dans le README ou autres fichiers |

Sur la base de la documentation disponible, Coda MCP propose un aperçu basique et quelques instructions d’installation locale, mais manque de ressources détaillées, de modèles de prompts, de listes explicites d’outils et de conseils sur la sécurité. Il semble être dans un état précoce ou sous-documenté.

Le dépôt Coda MCP manque actuellement de documentation essentielle sur les ressources, outils, prompts et sécurité, ce qui limite fortement son utilité et sa découvrabilité. Sur la base du tableau ci-dessus, nous évaluerions ce serveur MCP à 2/10, car il montre une intention et un minimum de directives d’installation, mais ne fournit pas les détails complets attendus d’une implémentation MCP prête pour la production.

| Possède une LICENCE | ✅ (MIT) |

|---|---|

| Au moins un outil | ⛔ (non confirmé) |

| Nombre de Forks | 0 |

| Nombre d’étoiles | 1 |

Le serveur MCP Coda est un serveur API universel qui connecte les assistants IA à Coda, permettant une interaction programmable pour interroger des documents, automatiser des workflows et gérer les données au sein de l'écosystème Coda via le Model Context Protocol.

Ajoutez le composant MCP à votre flow, puis configurez les paramètres système MCP avec les détails de votre serveur MCP Coda au format JSON. Par exemple : { "coda": { "transport": "streamable_http", "url": "https://yourmcpserver.example/pathtothemcp/url" } }

La documentation actuelle ne fournit pas de modèles de prompts ni de listes explicites de ressources. Les détails sur les outils sont mentionnés mais non listés dans les fichiers disponibles.

Le dépôt Coda MCP propose un aperçu basique et des étapes d'installation locale pour Windsurf, mais manque de documentation complète concernant les outils, ressources, prompts et pratiques de sécurité. Il est actuellement considéré comme sous-documenté.

Le dépôt est sous licence MIT.

Débloquez des flux de travail IA sans couture en connectant FlowHunt à la puissante plateforme de Coda via le serveur MCP.

Le serveur MCP Codacy fait le lien entre les assistants IA et la plateforme Codacy, permettant l'automatisation de l’analyse de qualité de code, la sécurité, la...

Le serveur CodeLogic MCP connecte FlowHunt et les assistants de programmation IA aux données détaillées de dépendances logicielles de CodeLogic, permettant une ...

Le serveur Model Context Protocol (MCP) fait le lien entre les assistants IA et des sources de données externes, des API et des services, permettant une intégra...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.