Analyse des performances de Gemini 2.0 Thinking : une évaluation complète

Découvrez notre revue approfondie des performances de Gemini 2.0 Thinking, couvrant la génération de contenu, les calculs, la synthèse et plus encore—mettant en...

Découvrez notre revue approfondie des performances de Gemini 2.0 Thinking, couvrant la génération de contenu, les calculs, la synthèse et plus encore—mettant en...

Une courbe d'apprentissage en intelligence artificielle est une représentation graphique illustrant la relation entre la performance d'apprentissage d’un modèle...

Une courbe ROC (Receiver Operating Characteristic) est une représentation graphique utilisée pour évaluer la performance d'un système de classification binaire ...

Explorez le monde des modèles d'agents IA grâce à une analyse approfondie de 20 systèmes de pointe. Découvrez comment ils réfléchissent, raisonnent et performen...

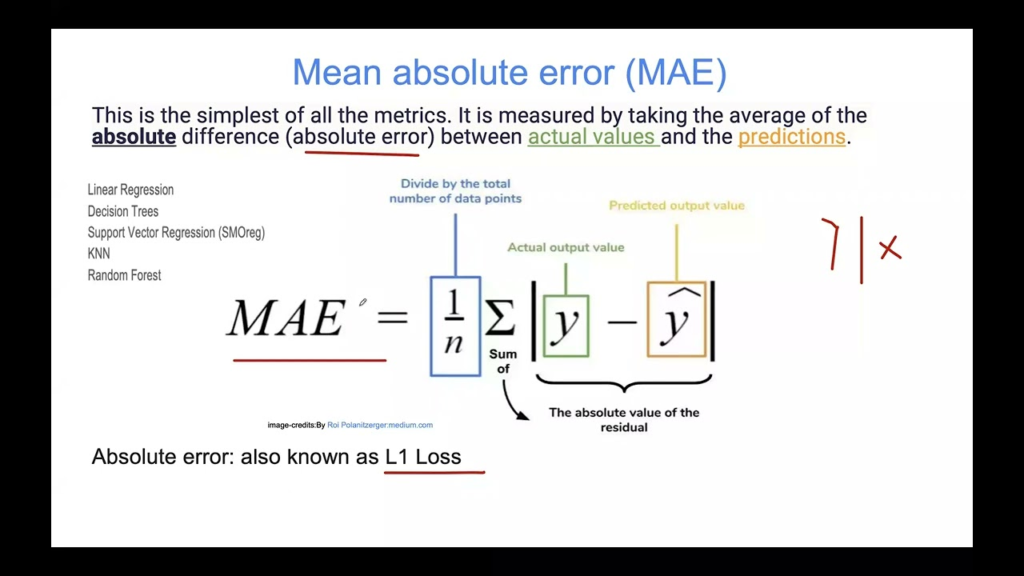

L'Erreur Absolue Moyenne (MAE) est une métrique fondamentale en apprentissage automatique pour évaluer les modèles de régression. Elle mesure l'amplitude moyenn...

L’erreur d'entraînement en IA et en apprentissage automatique est l’écart entre les prédictions d’un modèle et les résultats réels pendant l’entraînement. C’est...

L’erreur de généralisation mesure la capacité d’un modèle d’apprentissage automatique à prédire des données inédites, en équilibrant biais et variance pour gara...

L'étalonnage des modèles d'IA est l'évaluation et la comparaison systématiques de modèles d'intelligence artificielle à l'aide de jeux de données, de tâches et ...

Le F-Score, également appelé F-Mesure ou Score F1, est une métrique statistique utilisée pour évaluer la précision d’un test ou d’un modèle, en particulier en c...

Une matrice de confusion est un outil d'apprentissage automatique permettant d'évaluer les performances des modèles de classification, détaillant les vrais/faux...

La perte logarithmique, ou perte logarithmique/entropie croisée, est un indicateur clé pour évaluer la performance d’un modèle d’apprentissage automatique—parti...

La Précision Moyenne (mAP) est un indicateur clé en vision par ordinateur pour évaluer les modèles de détection d’objets, capturant à la fois la précision de dé...

Le R-carré ajusté est une mesure statistique utilisée pour évaluer la qualité d'ajustement d'un modèle de régression, en tenant compte du nombre de prédicteurs ...

La validation croisée est une méthode statistique utilisée pour évaluer et comparer les modèles d'apprentissage automatique en partitionnant les données en ense...