Interprétabilité des modèles

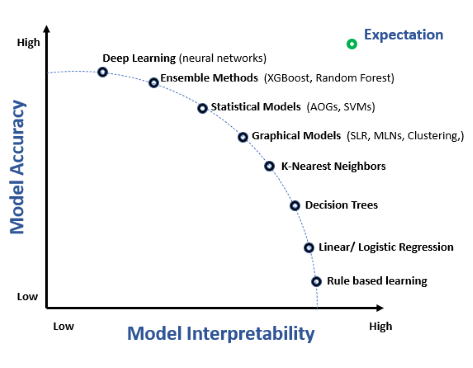

L'interprétabilité des modèles désigne la capacité à comprendre, expliquer et faire confiance aux prédictions et décisions prises par les modèles d'apprentissag...

8 min de lecture

Model Interpretability

AI

+4

L'interprétabilité des modèles désigne la capacité à comprendre, expliquer et faire confiance aux prédictions et décisions prises par les modèles d'apprentissag...