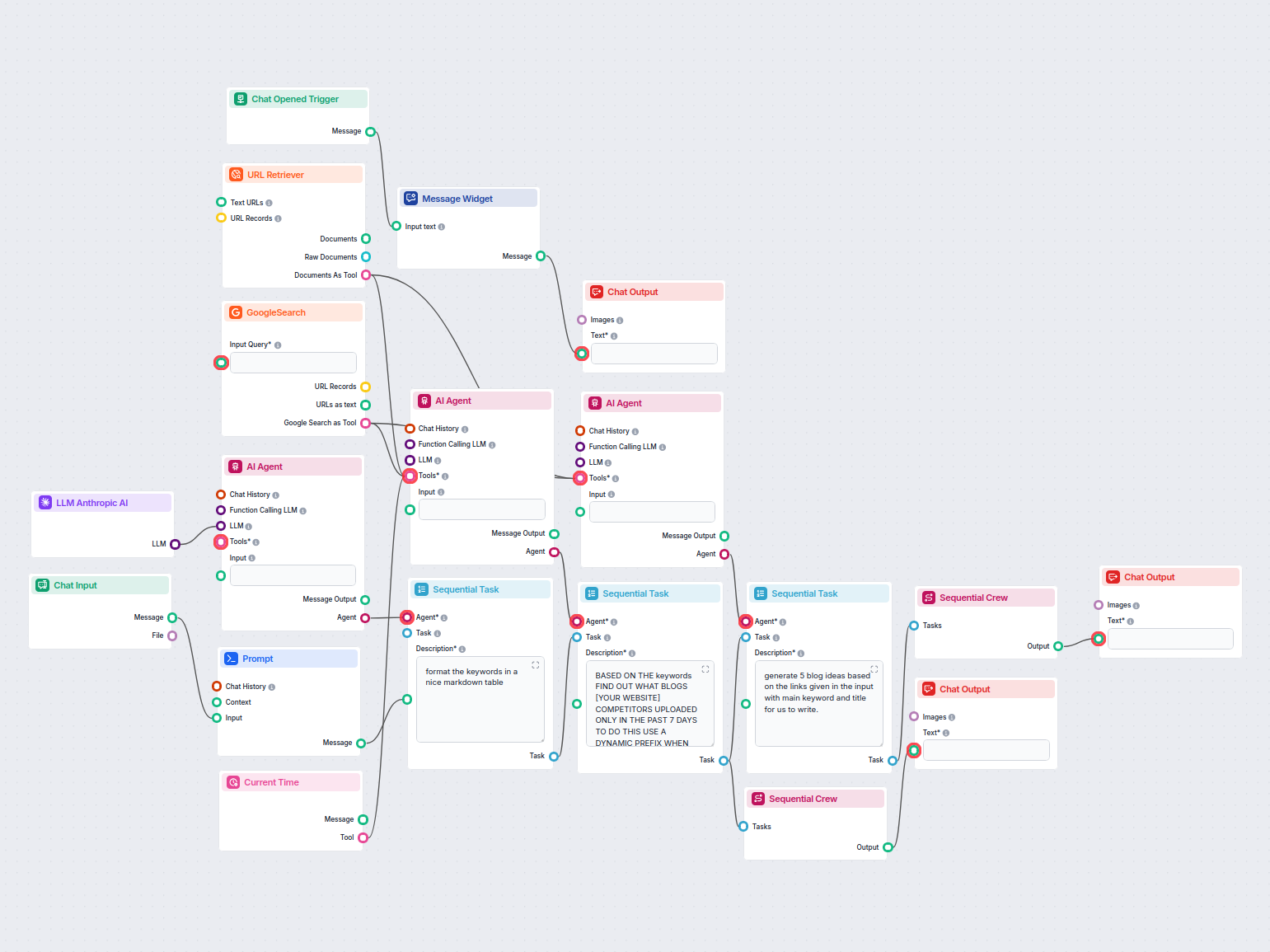

Analisi dei Blog dei Competitor e Generatore di Idee per Blog

Analizza automaticamente i blog dei competitor meglio posizionati dell’ultima settimana e genera nuove idee per articoli per il tuo sito. Questo workflow AI ric...

Collega i modelli Claude di Anthropic alla tua dashboard FlowHunt per una generazione di testo AI flessibile e soluzioni chatbot, con controllo su token, temperatura e selezione del modello.

Descrizione del componente

Different tasks call for different models, and FlowHunt is committed to giving you the best of AI without the need to sign up for countless subscriptions. Instead, you get dozens of text and image generator models in a single dashboard. The LLM type of components houses text generation and their diverse applications in AI, content creation, and automation.") models grouped by provider, allowing you to swap AI models on the fly.

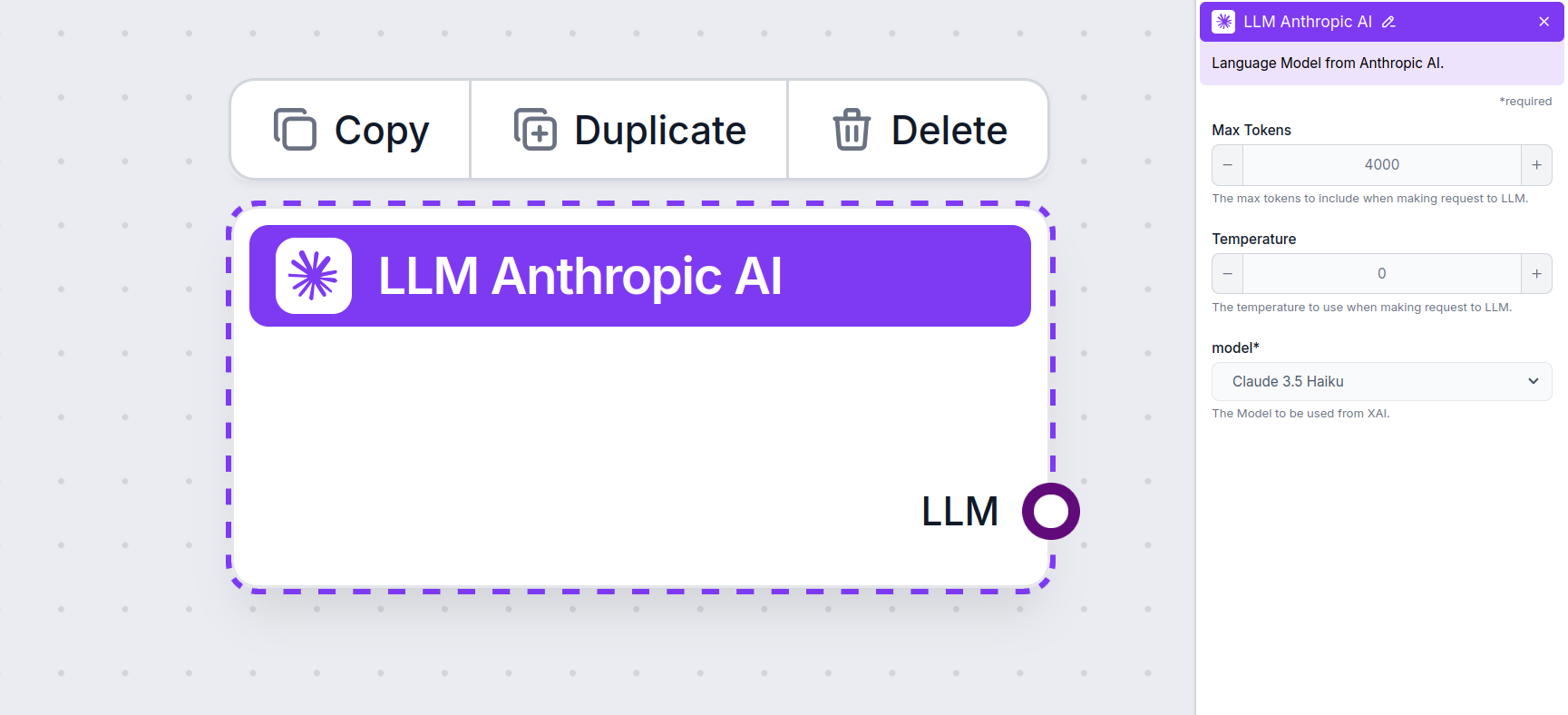

The LLM Anthropic AI component connects the Claude family of models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported models from Anthropic. We currently support all the latest models from the Claude family:

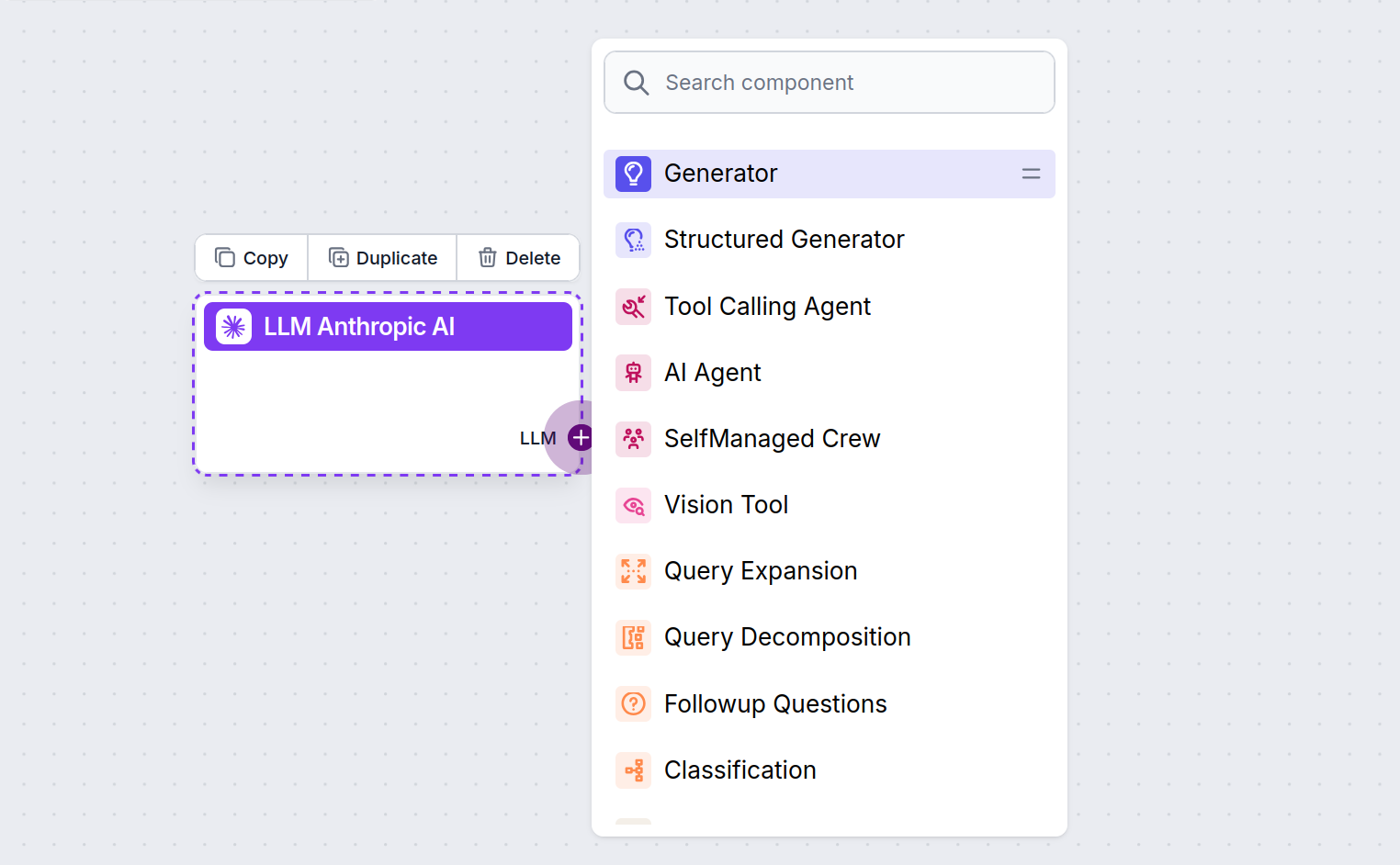

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

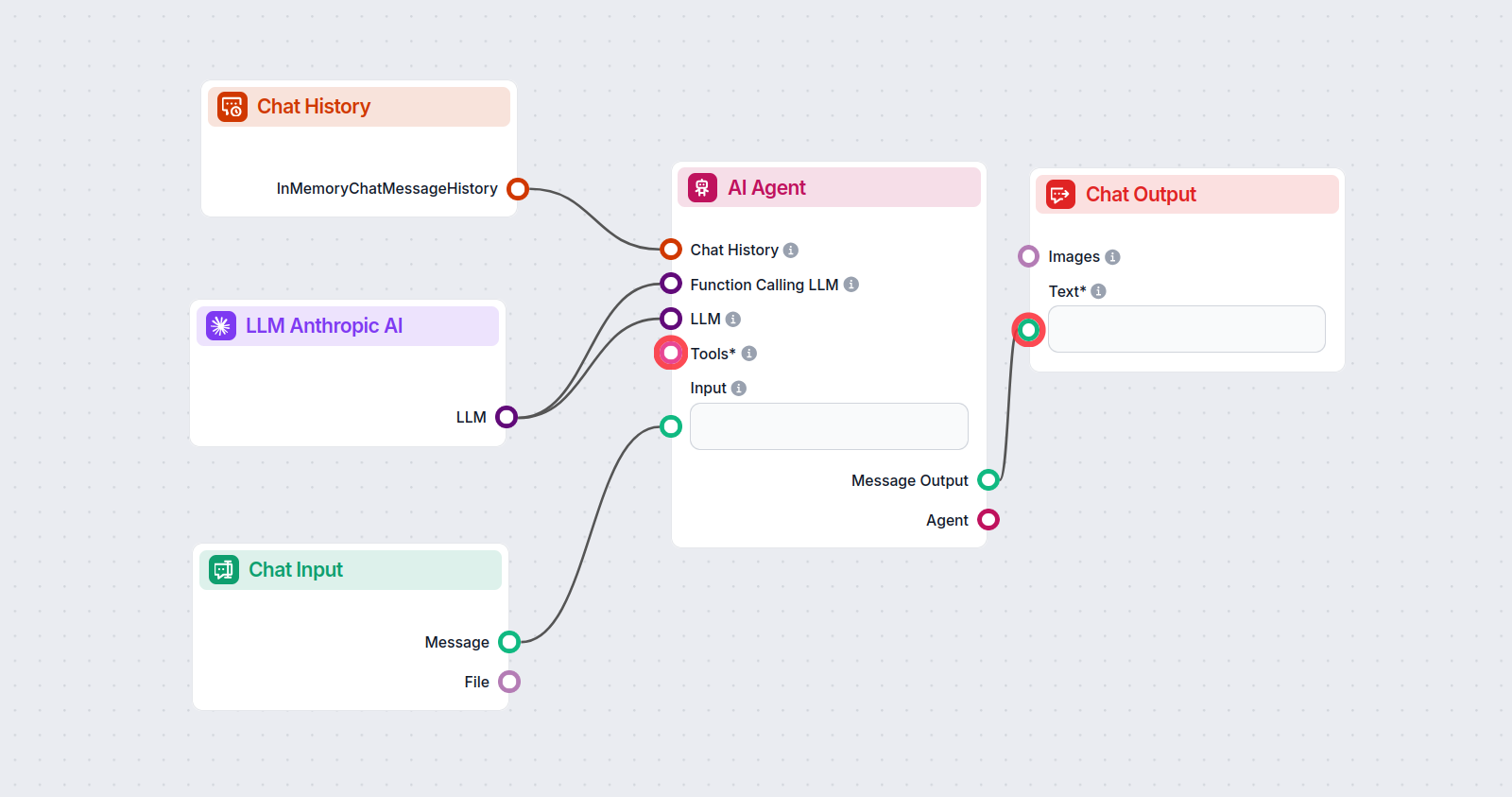

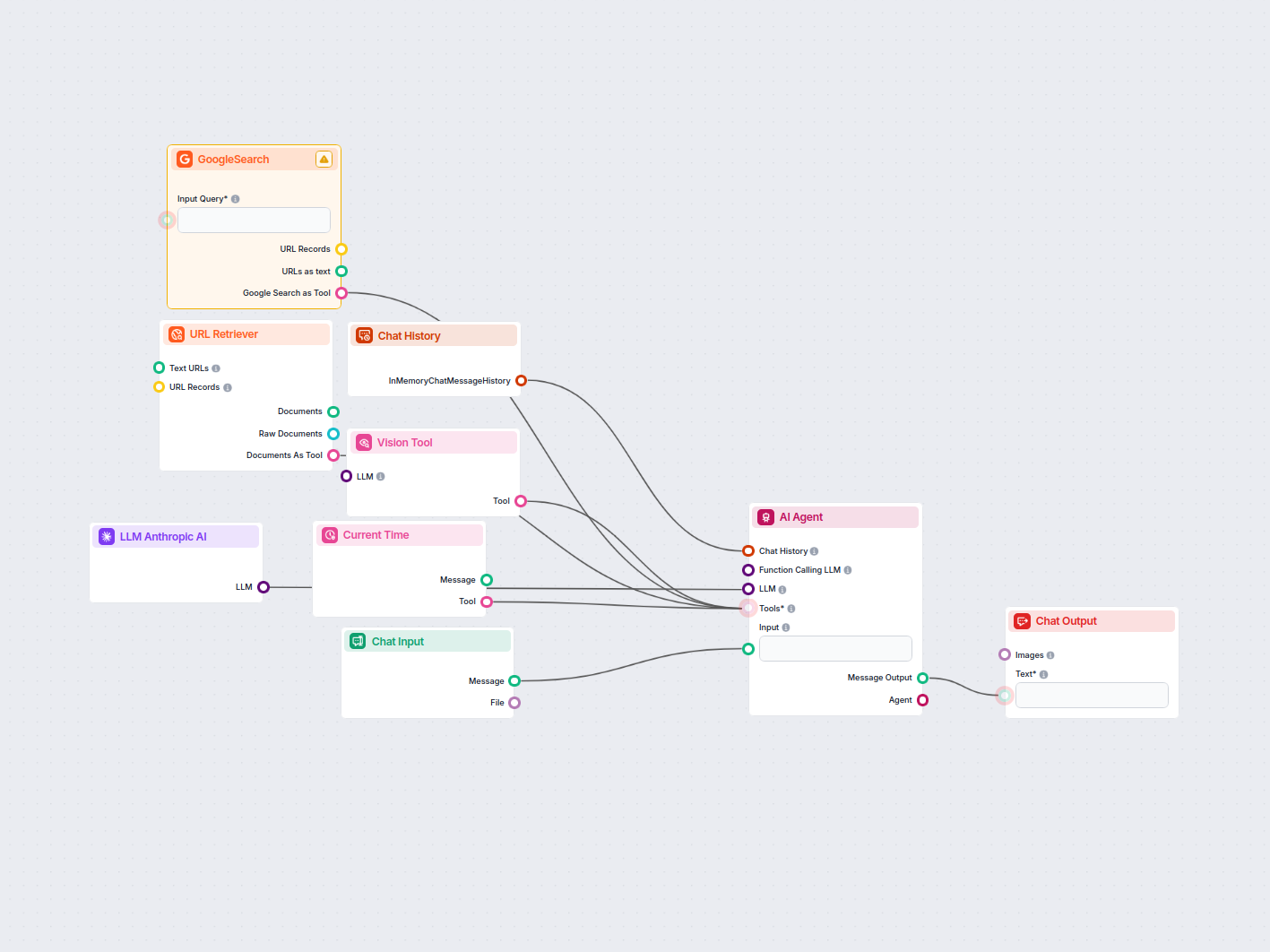

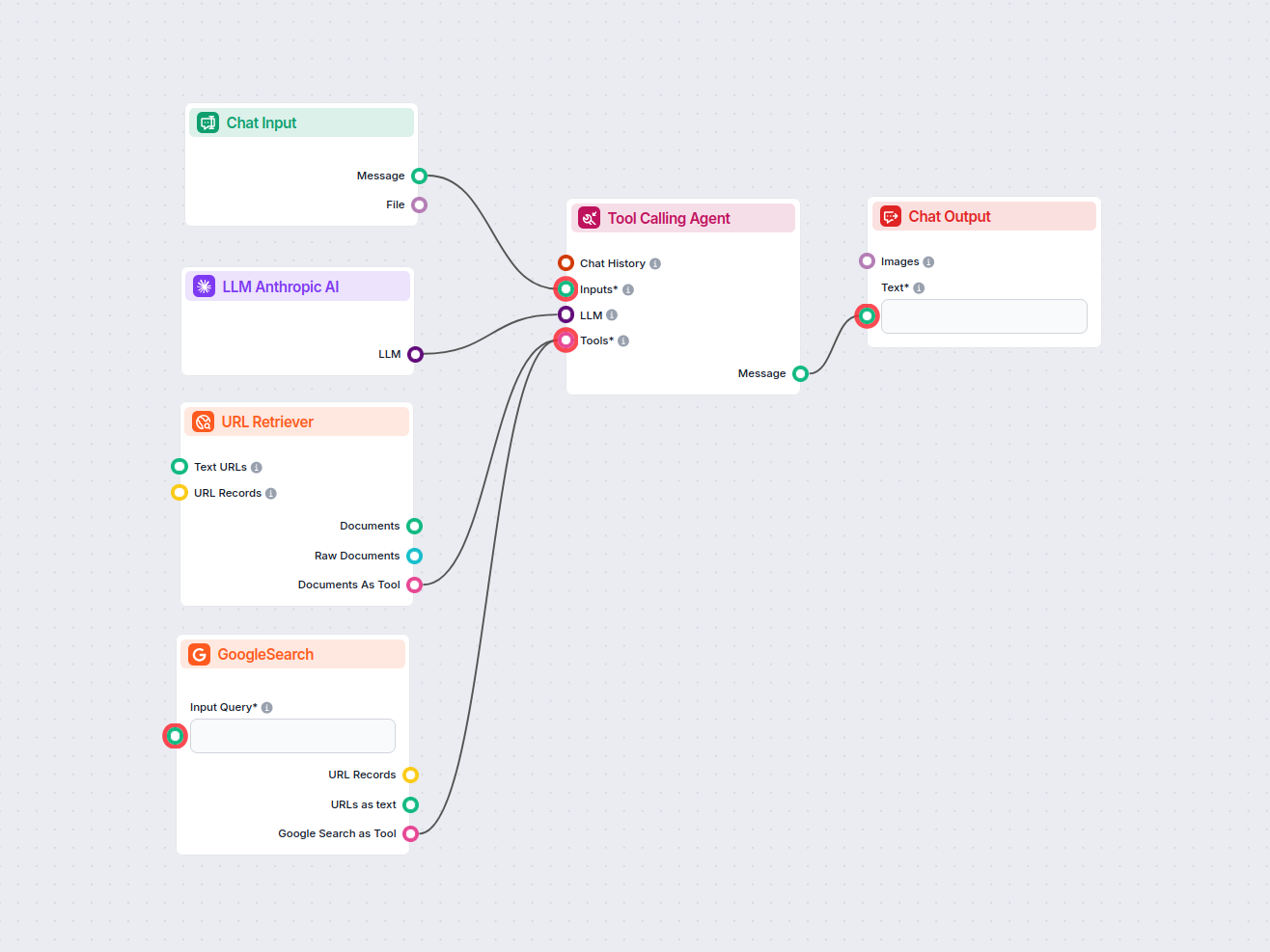

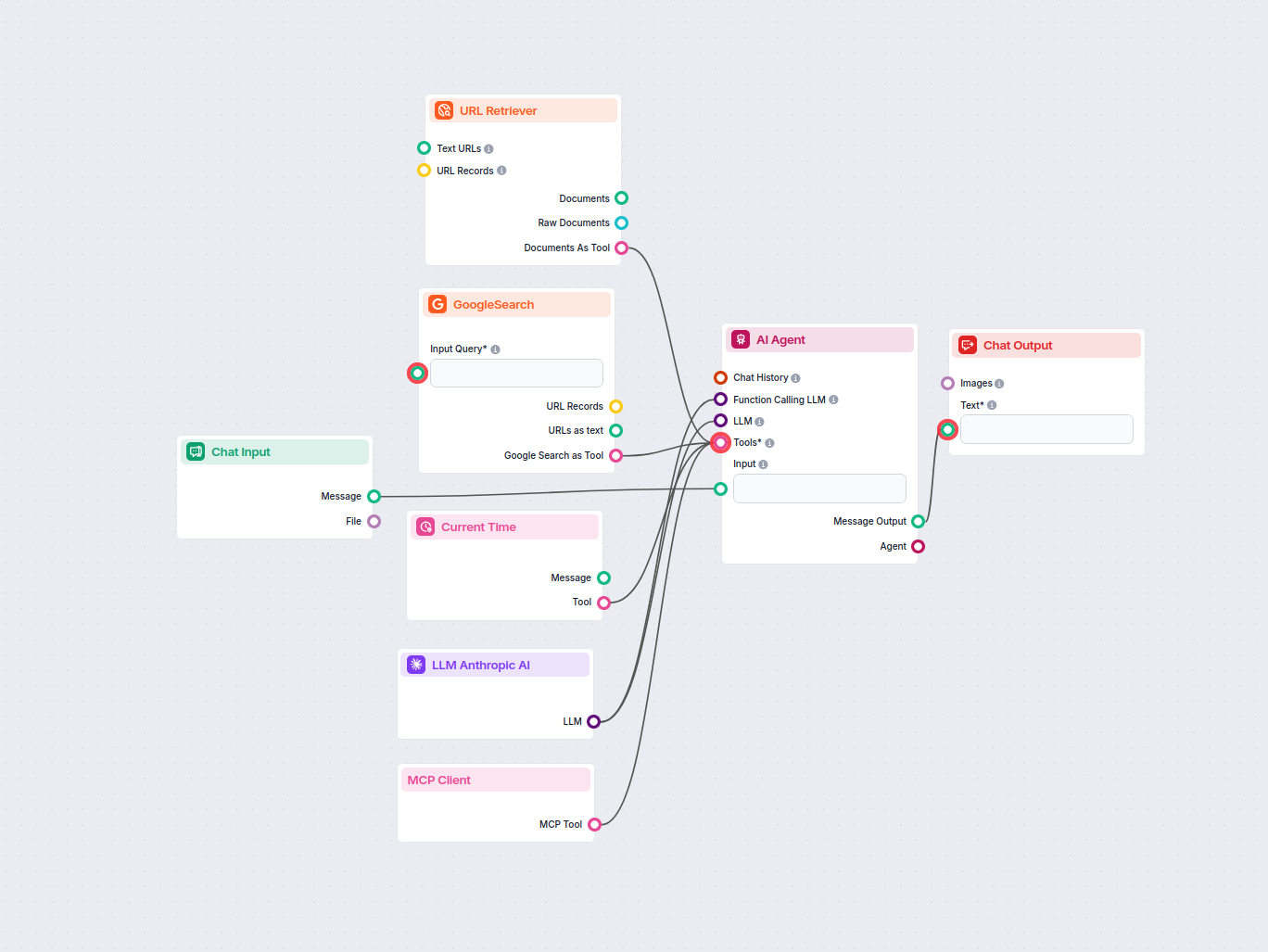

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Anthropic’s Claude 3.5 Sonnet to generate responses. You can think of it as a basic Anthropic chatbot.

This simple Chatbot Flow includes:

Per aiutarti a iniziare rapidamente, abbiamo preparato diversi modelli di flusso di esempio che mostrano come utilizzare efficacemente il componente LLM Anthropic AI. Questi modelli presentano diversi casi d'uso e best practice, rendendo più facile per te comprendere e implementare il componente nei tuoi progetti.

Analizza automaticamente i blog dei competitor meglio posizionati dell’ultima settimana e genera nuove idee per articoli per il tuo sito. Questo workflow AI ric...

Questo workflow automatizza la ricerca di mercato sugli annunci LinkedIn identificando i principali concorrenti per una parola chiave, analizzando i loro testi ...

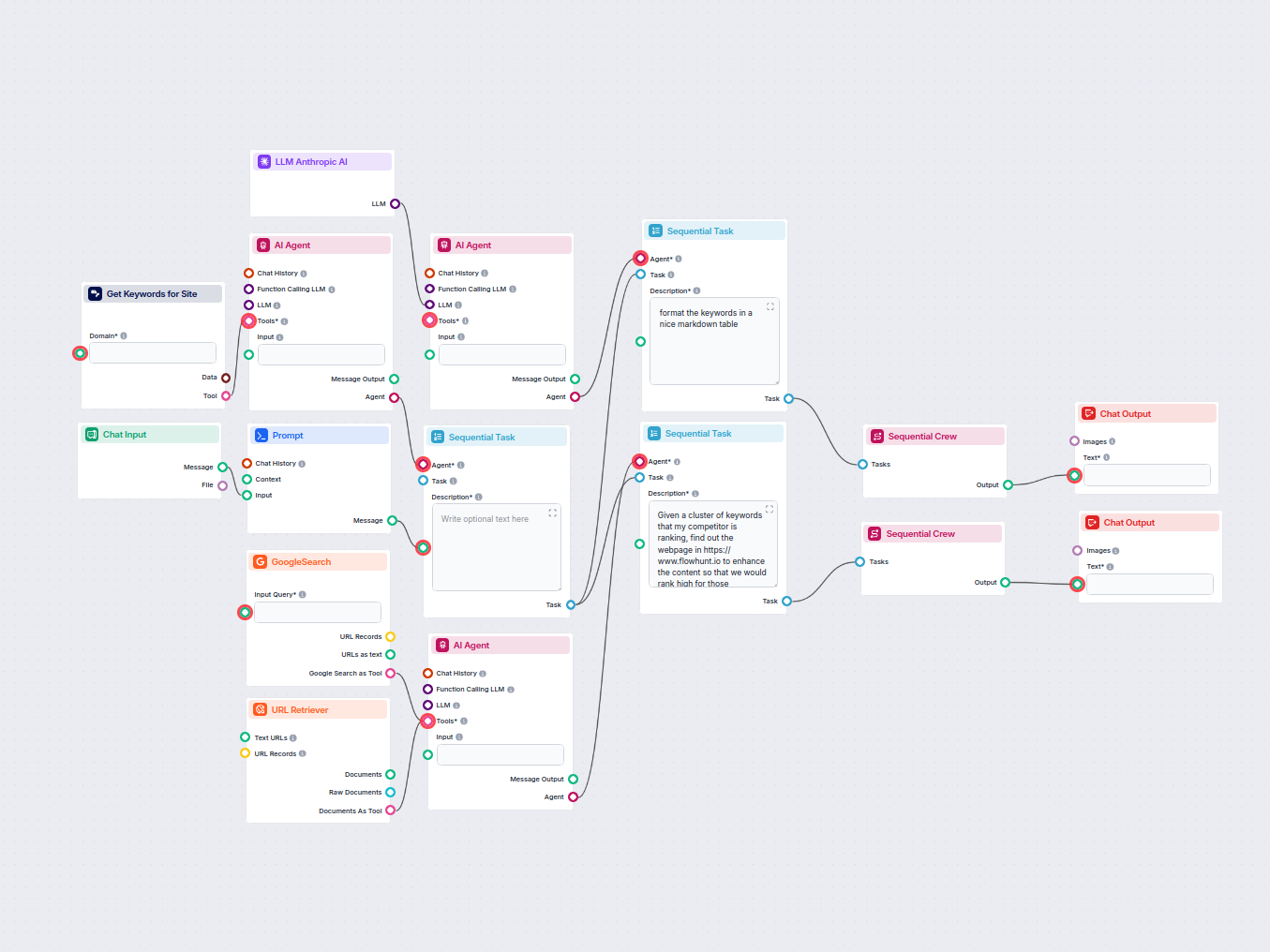

Analizza automaticamente l’URL della homepage del tuo competitor per scoprire le sue parole chiave con il miglior posizionamento, raccogliere dati sulle keyword...

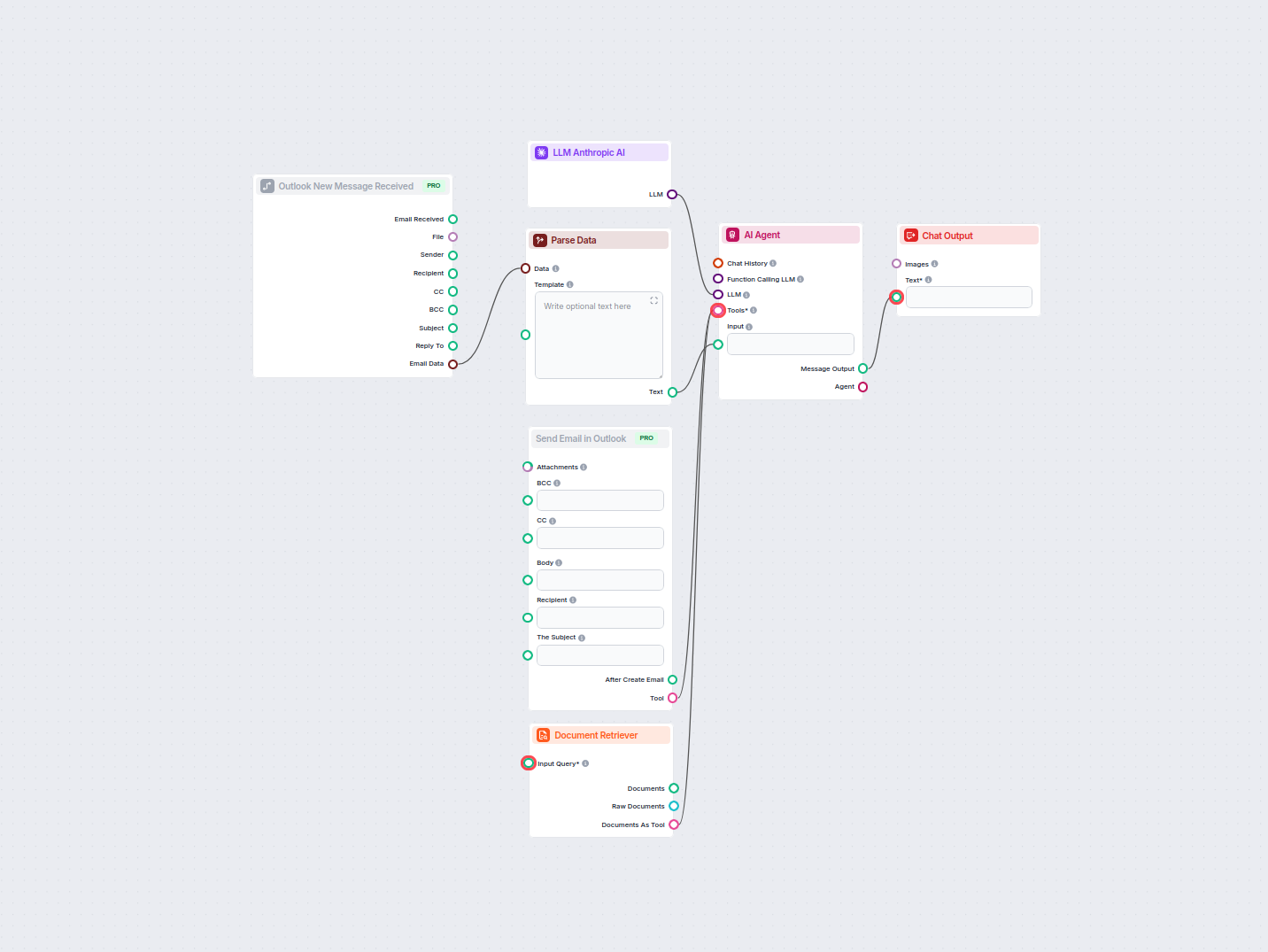

Automatizza le risposte professionali alle email in Outlook utilizzando un agente AI che sfrutta fonti di conoscenza aziendali. Le email in arrivo vengono ricev...

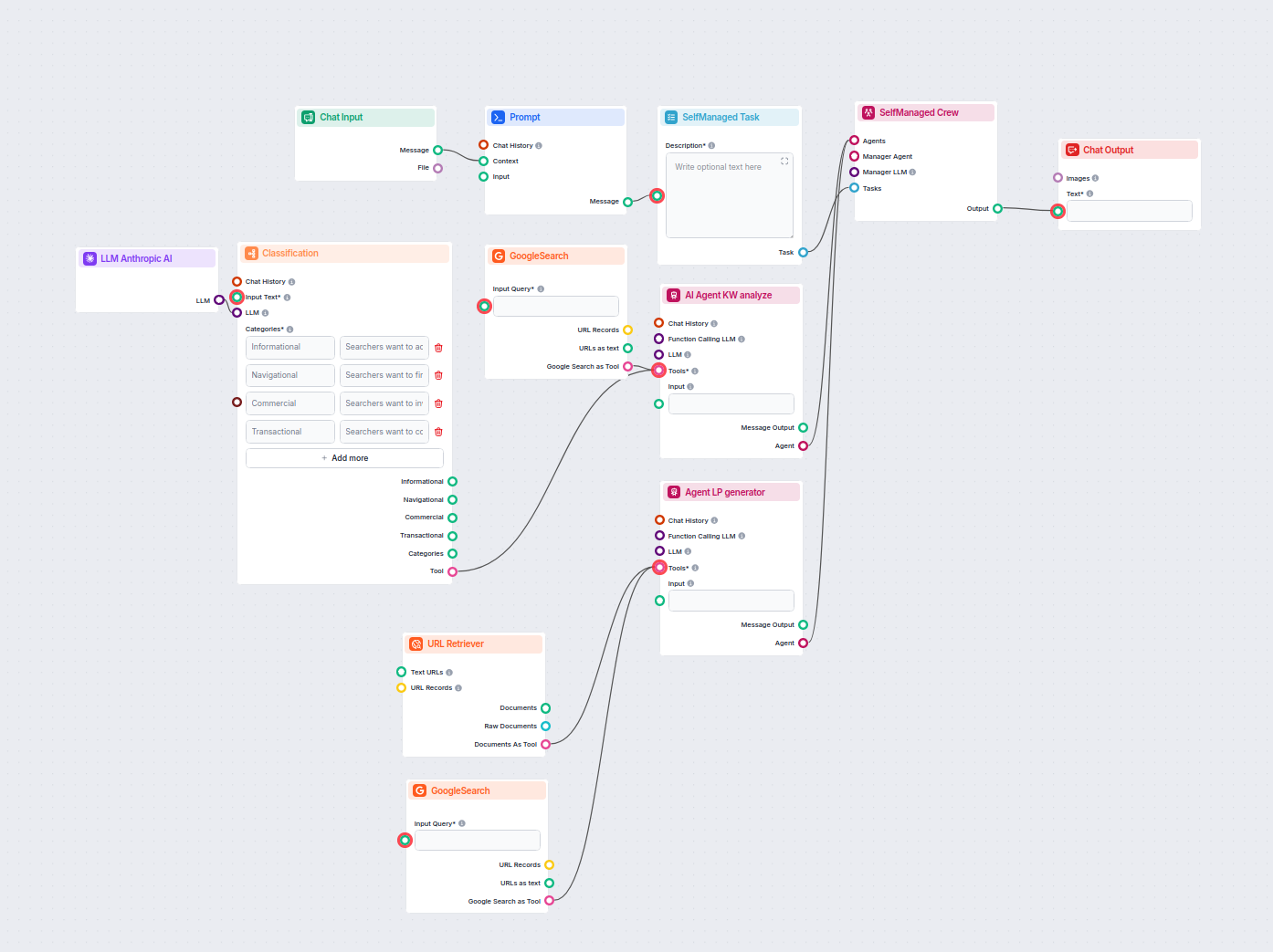

Questo workflow basato sull'AI classifica le query di ricerca per intento, ricerca le URL con il ranking più alto e genera una landing page altamente ottimizzat...

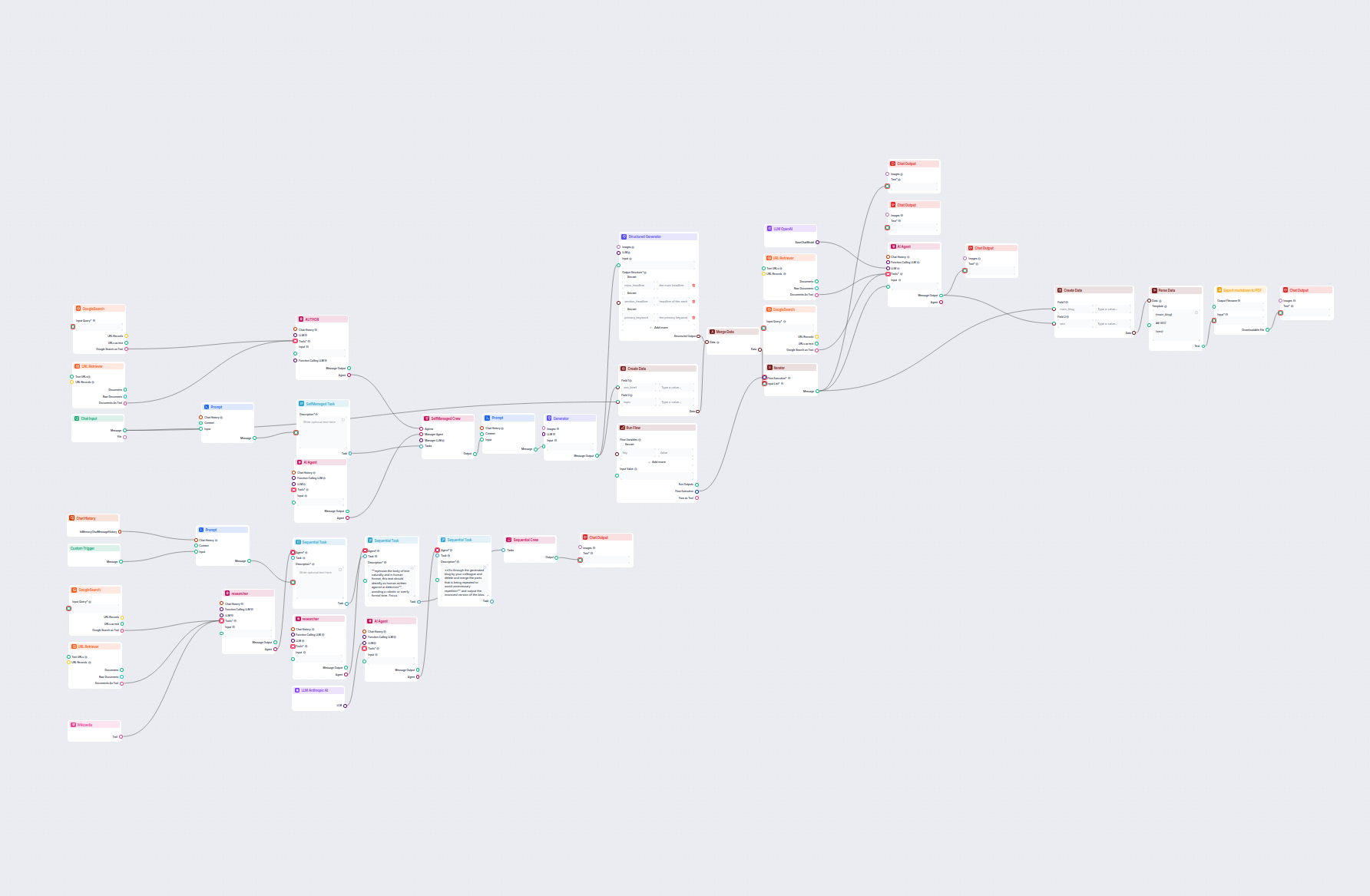

Genera post per blog completi, ottimizzati per SEO, con una struttura avanzata e un alto numero di parole utilizzando molteplici agenti IA. Il workflow include ...

Genera automaticamente descrizioni ottimizzate per la SEO delle pagine di categoria e-commerce utilizzando l'AI. Basta fornire un URL di categoria e il workflow...

Questo workflow potenziato dall'AI ricerca concorrenti e argomenti di tendenza per generare idee per blog ad alto impatto e ottimizzate SEO per FlowHunt.io. Uti...

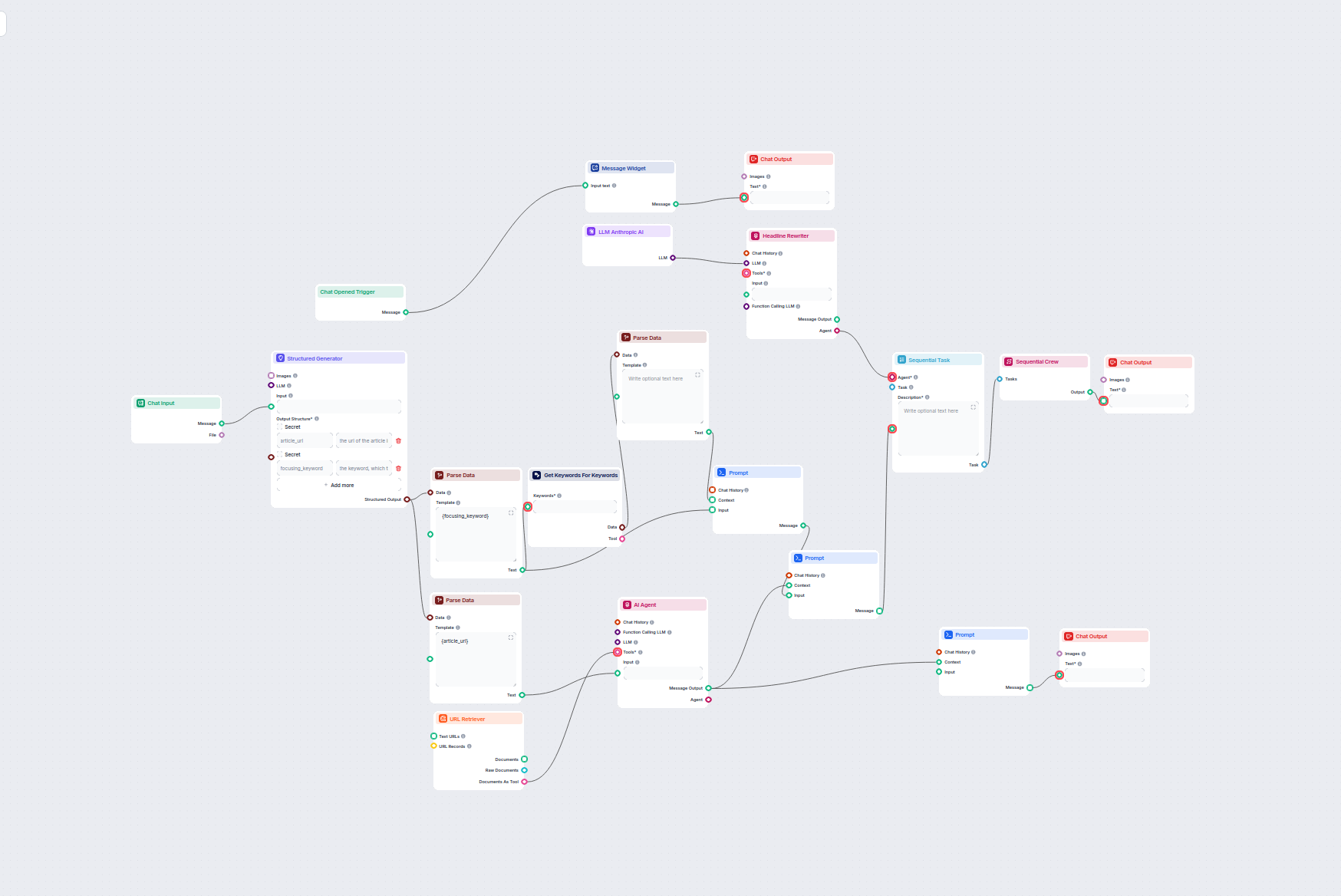

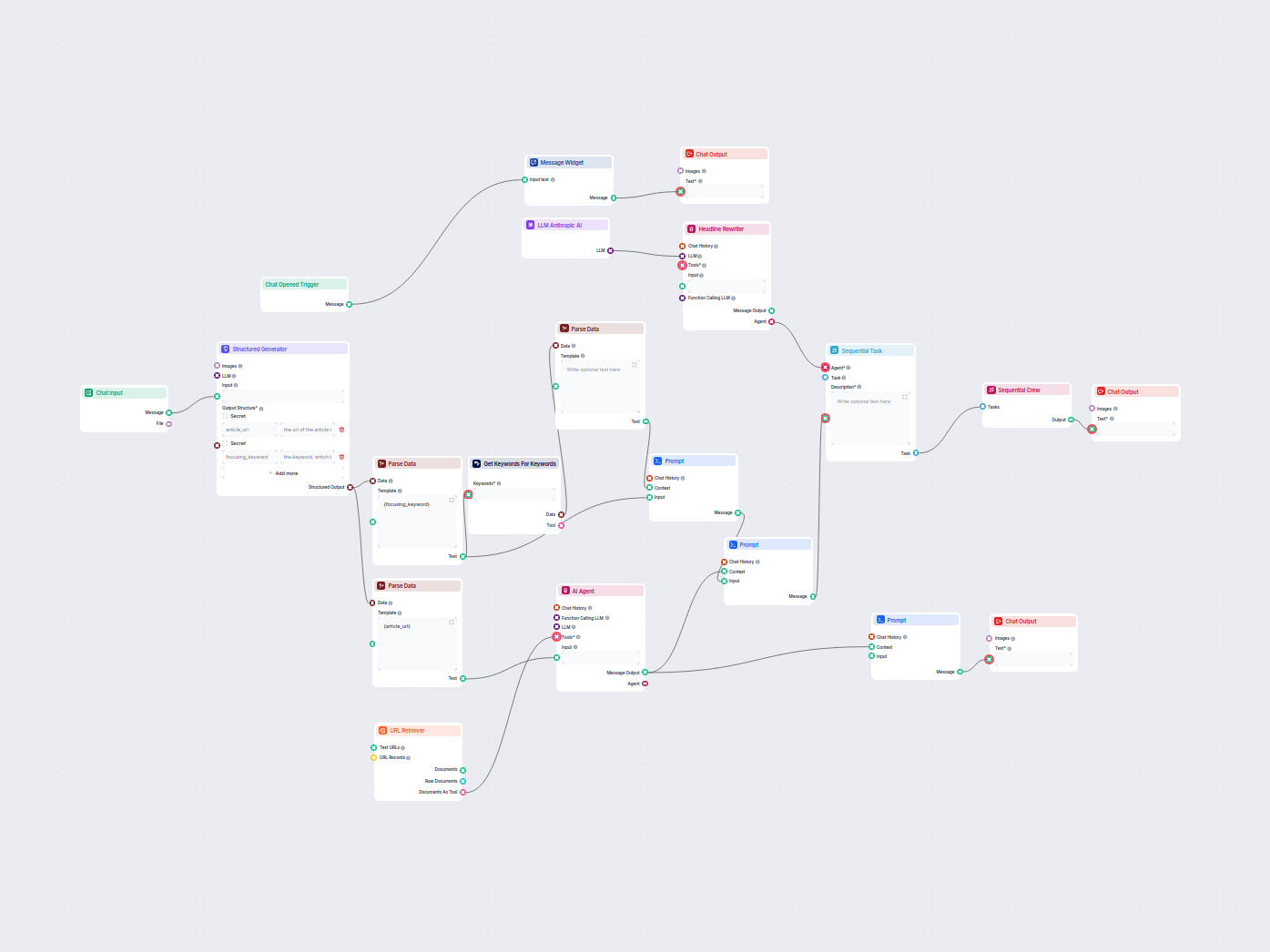

Questo workflow basato su AI trova le migliori parole chiave SEO per il tuo articolo di blog e riscrive automaticamente i titoli per mirare a quelle parole chia...

Ottimizza automaticamente i titoli e gli headline dei tuoi articoli per una parola chiave specifica o un cluster di keyword per migliorare le performance SEO. Q...

Questo workflow basato su IA migliora le descrizioni dei prodotti Shopify in base al nome del prodotto o all'URL fornito dall'utente. Sfrutta LLM, recupera cont...

Il componente LLM Anthropic AI collega i modelli Claude di Anthropic ai tuoi flussi FlowHunt, permettendoti di personalizzare quale modello usare per la generazione di testo e controllare impostazioni come max token e temperatura.

FlowHunt supporta tutti gli ultimi modelli della famiglia Claude, tra cui Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku e Claude 2.

Max token imposta il limite di lunghezza per ogni risposta, mentre la temperatura controlla la casualità—valori bassi rendono l’output più mirato, valori alti aumentano la creatività.

No, il collegamento del componente LLM Anthropic AI è opzionale. Di default, i componenti usano ChatGPT-4o, ma puoi aggiungere questo componente per passare ai modelli Claude e perfezionare le impostazioni.

Inizia a costruire strumenti AI e chatbot personalizzati utilizzando i modelli Claude di Anthropic con integrazione facile nei flussi e potenti opzioni di configurazione.

FlowHunt supporta dozzine di modelli di generazione di testo, inclusi i modelli di OpenAI. Ecco come utilizzare ChatGPT nei tuoi strumenti di IA e chatbot.

FlowHunt supporta dozzine di modelli di generazione di testo, inclusi i modelli Llama di Meta. Scopri come integrare Llama nei tuoi strumenti e chatbot AI, pers...

FlowHunt supporta dozzine di modelli di generazione del testo, inclusi i modelli di xAI. Ecco come utilizzare i modelli xAI nei tuoi strumenti e chatbot AI.