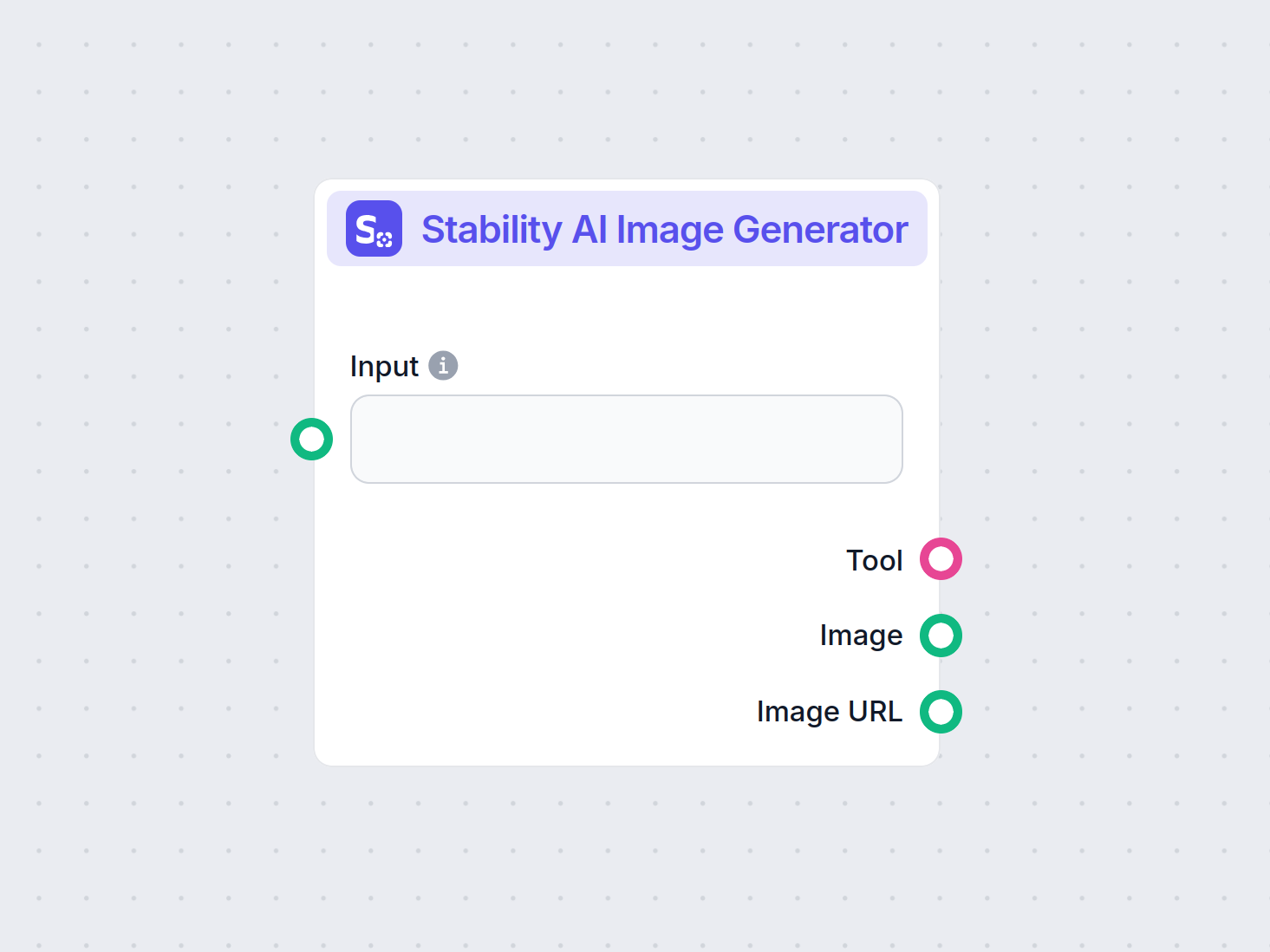

Generatore di Immagini Stability AI

Genera immagini di alta qualità da prompt testuali con il componente Generatore di Immagini Stability AI. Basato sui modelli Stable Diffusion, questo strumento ...

Stable Diffusion è un modello AI testo-immagine all’avanguardia che consente agli utenti di generare visuali fotorealistiche da prompt utilizzando tecniche avanzate di diffusione latente e deep learning.

Stable Diffusion è un modello AI testo-immagine che crea immagini di alta qualità da descrizioni utilizzando il deep learning. Impiega tecniche come i prompt negativi e immagini di riferimento per risultati migliori, specialmente con elementi complessi come le mani.

Stable Diffusion è un avanzato modello di generazione testo-immagine che utilizza tecniche di deep learning per produrre immagini di alta qualità e fotorealistiche basate su descrizioni testuali. Sviluppato come modello di diffusione latente, rappresenta un significativo progresso nel campo dell’intelligenza artificiale generativa, combinando i principi dei modelli di diffusione e dell’apprendimento automatico per creare immagini che rispecchiano fedelmente i prompt testuali forniti.

Stable Diffusion utilizza deep learning e modelli di diffusione per generare immagini raffinando il rumore casuale fino a creare visuali coerenti. Nonostante l’ampio addestramento su milioni di immagini, incontra difficoltà con elementi complessi come le mani. Col tempo, con l’addestramento su dataset sempre più grandi, questi problemi si stanno riducendo e la qualità delle immagini sta diventando sempre più realistica.

Un metodo efficace per affrontare il problema delle mani è l’utilizzo dei prompt negativi. Aggiungendo frasi come (-bad anatomy) oppure (-bad hands -unnatural hands) ai tuoi prompt, puoi istruire l’IA a evitare di produrre caratteristiche distorte. Fai attenzione a non esagerare con i prompt negativi, perché potrebbero limitare la creatività del modello.

Un’altra tecnica consiste nell’usare immagini di riferimento per guidare l’IA. Includendo un tag {image} con un link a un’immagine di riferimento nel prompt, fornisci all’IA un modello visivo per una resa accurata delle mani. Questo è particolarmente utile per mantenere proporzioni e pose corrette.

Per risultati migliori, combina sia i prompt negativi che le immagini di riferimento. Questo approccio doppio garantisce che l’IA eviti errori comuni mantenendosi fedele a esempi di alta qualità.

(-bent fingers) oppure (realistic perspectives) per migliorare ulteriormente la resa delle mani.Padroneggiando queste tecniche, puoi migliorare notevolmente la resa delle mani nelle tue creazioni con Stable Diffusion, ottenendo opere d’arte con la finezza di un artista esperto. Raccogli le tue immagini di riferimento, crea prompt precisi e guarda la tua arte AI evolvere!

Alla base, Stable Diffusion opera trasformando i prompt testuali in rappresentazioni visive tramite una serie di processi computazionali. Comprendere il suo funzionamento significa approfondire i concetti di modelli di diffusione, spazi latenti e reti neurali.

I modelli di diffusione sono una classe di modelli generativi nel machine learning che imparano a creare dati invertendo un processo di diffusione. Il processo di diffusione prevede l’aggiunta graduale di rumore ai dati—come le immagini—fino a renderli indistinguibili dal rumore casuale. Il modello impara poi a invertire questo processo, rimuovendo il rumore passo dopo passo per recuperare i dati originali. Questo processo inverso di diffusione è fondamentale per generare nuovi dati coerenti a partire dal rumore casuale.

Stable Diffusion utilizza specificamente un modello di diffusione latente. A differenza dei modelli tradizionali che operano direttamente nello spazio pixel ad alta dimensionalità, i modelli di diffusione latente lavorano in uno spazio latente compresso. Questo spazio latente è una rappresentazione a dimensionalità ridotta dei dati, che cattura le caratteristiche essenziali riducendo la complessità computazionale. Operando nello spazio latente, Stable Diffusion può generare immagini ad alta risoluzione in modo più efficiente.

Il meccanismo centrale di Stable Diffusion consiste nel processo inverso di diffusione nello spazio latente. Partendo da un vettore latente di rumore casuale, il modello affina iterativamente questa rappresentazione latente prevedendo e rimuovendo il rumore a ogni passaggio. Questo raffinamento è guidato dalla descrizione testuale fornita dall’utente. Il processo continua fino a quando il vettore latente converge a uno stato che, una volta decodificato, produce un’immagine coerente con il prompt testuale.

L’architettura di Stable Diffusion integra diversi componenti chiave che collaborano per trasformare i prompt testuali in immagini.

Il VAE funge da sistema encoder-decoder che comprime le immagini nello spazio latente e le ricostruisce nuovamente in immagini. L’encoder trasforma un’immagine nella sua rappresentazione latente, catturando le caratteristiche fondamentali in forma ridotta. Il decoder prende questa rappresentazione latente e la ricostruisce in un’immagine dettagliata.

Questo processo è cruciale perché permette al modello di lavorare con dati a dimensionalità ridotta, riducendo significativamente le risorse computazionali rispetto all’operare nello spazio pixel completo.

La U-Net è un’architettura di rete neurale specializzata utilizzata in Stable Diffusion per compiti di elaborazione delle immagini. Consiste in un percorso di encoding e uno di decoding con connessioni skip tra i livelli speculari. Nel contesto di Stable Diffusion, la U-Net funge da predittore di rumore durante il processo inverso di diffusione.

A ogni step del processo di diffusione, la U-Net prevede la quantità di rumore presente nella rappresentazione latente. Questa previsione viene quindi utilizzata per affinare il vettore latente sottraendo il rumore stimato, denoising progressivamente lo spazio latente verso un’immagine coerente con il prompt.

Per incorporare le informazioni testuali, Stable Diffusion impiega un encoder testuale basato sul modello CLIP (Contrastive Language-Image Pretraining). CLIP è progettato per comprendere e mettere in relazione informazioni testuali e visive mappandole in uno spazio latente condiviso.

Quando un utente fornisce un prompt testuale, l’encoder converte questo prompt in una serie di embedding—rappresentazioni numeriche dei dati testuali. Questi embedding condizionano la U-Net durante il processo inverso di diffusione, guidando la generazione dell’immagine affinché rifletta il contenuto del prompt.

Stable Diffusion offre versatilità nella generazione di immagini e può essere utilizzato in vari modi a seconda delle necessità.

L’uso principale di Stable Diffusion è la generazione di immagini da prompt testuali. Gli utenti inseriscono un testo descrittivo e il modello genera un’immagine che rappresenta la descrizione. Ad esempio, un utente può inserire “Una spiaggia tranquilla al tramonto con palme” e ricevere un’immagine che raffigura quella scena.

Questa capacità è particolarmente preziosa nelle industrie creative, nella creazione di contenuti e nel design, dove la visualizzazione rapida delle idee è essenziale.

Oltre a generare immagini da zero, Stable Diffusion può anche modificare immagini esistenti sulla base di istruzioni testuali. Fornendo un’immagine iniziale e un prompt di testo, il modello può produrre una nuova immagine che incorpora le modifiche descritte.

Ad esempio, un utente può fornire un’immagine di un panorama urbano diurno con il prompt “trasformalo in notturno con luci al neon”, ottenendo un’immagine che riflette tali modifiche.

L’inpainting consiste nel riempire parti mancanti o danneggiate di un’immagine. Stable Diffusion eccelle in questo campo utilizzando prompt testuali per guidare la ricostruzione di specifiche aree. Gli utenti possono mascherare porzioni di un’immagine e fornire descrizioni testuali di ciò che dovrebbe riempire lo spazio.

Questa funzione è utile nel restauro fotografico, nella rimozione di oggetti indesiderati o nella modifica di elementi specifici mantenendo la coerenza generale dell’immagine.

Generando sequenze di immagini con leggere variazioni, Stable Diffusion può essere esteso per creare animazioni o contenuti video. Strumenti come Deforum ampliano le capacità di Stable Diffusion per produrre contenuti visivi dinamici guidati da prompt testuali nel tempo.

Questo apre possibilità nell’animazione, negli effetti visivi e nella generazione di contenuti dinamici senza la necessità di tecniche tradizionali frame-by-frame.

La capacità di Stable Diffusion di generare immagini da descrizioni testuali lo rende uno strumento potente nell’automazione AI e nello sviluppo di chatbot.

Incorporando Stable Diffusion nei chatbot è possibile generare contenuti visivi in risposta alle richieste degli utenti. Ad esempio, in uno scenario di assistenza clienti, un chatbot può fornire guide visive o illustrazioni generate in tempo reale per assistere gli utenti.

I prompt di testo vengono convertiti in embedding tramite l’encoder CLIP. Questi embedding sono fondamentali per condizionare il processo di generazione delle immagini, garantendo che l’output sia allineato con la descrizione fornita.

Il processo inverso di diffusione affina iterativamente la rappresentazione latente rimuovendo il rumore previsto. A ogni step, il modello considera gli embedding testuali e lo stato corrente del vettore latente per prevedere accuratamente la componente di rumore.

L’abilità del modello nella gestione di immagini rumorose deriva dall’addestramento su grandi dataset, dove impara a distinguere e denoising le immagini in modo efficace. Questo consente di generare immagini nitide anche partendo da rumore casuale.

Operare nello spazio latente offre efficienza computazionale. Poiché lo spazio latente ha meno dimensioni rispetto allo spazio pixel, le operazioni sono meno onerose. Questa efficienza permette a Stable Diffusion di generare immagini ad alta risoluzione senza richiedere risorse eccessive.

Artisti e designer possono utilizzare Stable Diffusion per prototipare rapidamente visuali da descrizioni concettuali, facilitando il processo creativo e riducendo il tempo dall’idea alla visualizzazione.

I team di marketing possono generare immagini personalizzate per campagne, social media e pubblicità senza la necessità di risorse grafiche estese.

Gli sviluppatori possono creare asset, ambientazioni e concept art fornendo prompt descrittivi, ottimizzando la pipeline di creazione degli asset.

I rivenditori possono generare immagini di prodotti in diversi contesti o configurazioni, migliorando la visualizzazione dei prodotti e l’esperienza cliente.

Educatori e creatori di contenuti possono produrre illustrazioni e diagrammi per spiegare concetti complessi, rendendo il materiale didattico più coinvolgente.

I ricercatori in intelligenza artificiale e computer vision possono utilizzare Stable Diffusion per esplorare ulteriormente le capacità dei modelli di diffusione e degli spazi latenti.

Per utilizzare efficacemente Stable Diffusion, è importante considerare alcuni aspetti tecnici.

Per iniziare a utilizzare Stable Diffusion, segui questi passaggi:

Per gli sviluppatori che creano sistemi di automazione AI e chatbot, Stable Diffusion può essere integrato per ampliare le funzionalità.

Quando utilizzi Stable Diffusion, è importante considerare le implicazioni etiche.

La stable diffusion è un tema importante nel campo dei modelli generativi, in particolare per l’augmentazione dei dati e la sintesi di immagini. Studi recenti hanno esplorato diversi aspetti della stable diffusion, mettendo in luce applicazioni ed efficacia.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments di Fuxi Wen (2013):

Introduce un algoritmo LMP di diffusione progettato per la stima distribuita in ambienti caratterizzati da rumore alfa-stabile. Lo studio confronta il metodo LMP con l’algoritmo LMS di diffusione, dimostrando migliori prestazioni in condizioni di rumore alfa-stabile. Questa ricerca è cruciale per sviluppare tecniche di stima robuste in ambienti rumorosi. Leggi di più

Stable Diffusion for Data Augmentation in COCO and Weed Datasets di Boyang Deng (2024):

Indaga sull’uso dei modelli di stable diffusion per generare immagini sintetiche ad alta risoluzione e migliorare piccoli dataset. Sfruttando tecniche come la traduzione immagine-immagine, Dreambooth e ControlNet, la ricerca valuta l’efficienza della stable diffusion nei compiti di classificazione e rilevamento. I risultati suggeriscono applicazioni promettenti della stable diffusion in vari settori. Leggi di più

Diffusion and Relaxation Controlled by Tempered α-stable Processes di Aleksander Stanislavsky, Karina Weron, e Aleksander Weron (2011):

Deriva le proprietà della diffusione anomala e della rilassazione non esponenziale usando processi α-stable temperati. Affronta la problematica dei momenti infiniti associata al tempo operativo casuale α-stable e fornisce un modello che include la subdiffusione come caso particolare. Leggi di più

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion di Andreas Stöckl (2022):

Valuta immagini sintetiche generate dal modello Stable Diffusion utilizzando la tassonomia Wordnet. Analizza la capacità del modello di produrre immagini corrette per vari concetti, illustrando le differenze nell’accuratezza della rappresentazione. Queste valutazioni sono vitali per comprendere il ruolo della stable diffusion nell’augmentazione dei dati. Leggi di più

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion di Sanchayan Vivekananthan (2024):

Esplora tre framework generativi: VAE, GAN e Stable Diffusion. La ricerca evidenzia punti di forza e limiti di ciascun modello, sottolineando che mentre VAE e GAN hanno i loro vantaggi, la stable diffusion eccelle in determinati compiti di sintesi. Leggi di più

Vediamo come implementare un modello Stable Diffusion in Python utilizzando la libreria Diffusers di Hugging Face.

Installa le librerie richieste:

pip install torch transformers diffusers accelerate

pip install xformers # Opzionale

La libreria Diffusers offre un modo semplice per caricare modelli pre-addestrati:

from diffusers import StableDiffusionPipeline

import torch

# Carica il modello Stable Diffusion

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Sposta il modello su GPU per inferenza più rapida

Per generare immagini, basta fornire un prompt testuale:

prompt = "Un paesaggio sereno con montagne e un lago, fotorealistico, risoluzione 8K"

image = pipe(prompt).images[0]

# Salva o visualizza l'immagine

image.save("generated_image.png")

model_id.torch.float16 si riduce l’uso di memoria.Puoi personalizzare diversi parametri:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Numero di step di denoising

guidance

Stable Diffusion è un avanzato modello di intelligenza artificiale progettato per generare immagini di alta qualità e fotorealistiche a partire da prompt testuali. Utilizza la diffusione latente e il deep learning per trasformare descrizioni testuali in visuali.

Stable Diffusion opera convertendo i prompt testuali in embedding di immagini tramite un encoder testo CLIP, quindi denoising iterativamente una rappresentazione latente guidata dal prompt, ottenendo così un output d'immagine coerente.

Stable Diffusion viene utilizzato per generazione creativa di contenuti, materiali di marketing, creazione di asset per videogiochi, visualizzazione di prodotti e-commerce, illustrazioni educative e chatbot alimentati dall'IA.

Sì, Stable Diffusion supporta la traduzione immagine-immagine e l'inpainting, consentendo agli utenti di modificare immagini esistenti o riempire parti mancanti utilizzando prompt testuali.

Per una generazione efficiente di immagini con Stable Diffusion si consiglia un computer con GPU moderna. Il modello richiede inoltre Python e librerie come PyTorch e Diffusers.

Sì, Stable Diffusion è rilasciato con una licenza open source permissiva, incoraggiando i contributi della comunità, la personalizzazione e l'ampio accesso.

Libera la tua creatività con Stable Diffusion e scopri come l'IA può trasformare le tue idee in visuali straordinarie.

Genera immagini di alta qualità da prompt testuali con il componente Generatore di Immagini Stability AI. Basato sui modelli Stable Diffusion, questo strumento ...

Il Modello Flux AI di Black Forest Labs è un avanzato sistema di generazione testo-immagine che converte prompt in linguaggio naturale in immagini altamente det...

Esplora la nostra recensione approfondita di Stability AI SD3 Large. Analizza i suoi punti di forza, debolezze e risultati creativi su diversi prompt da testo a...