LLM OpenAI

FlowHunt supporta dozzine di modelli di generazione di testo, inclusi i modelli di OpenAI. Ecco come utilizzare ChatGPT nei tuoi strumenti di IA e chatbot.

OpenAI Whisper è un sistema ASR open-source che converte accuratamente la voce in testo in 99 lingue, supportando trascrizione, traduzione e identificazione della lingua per una solida automazione AI.

OpenAI Whisper può essere considerato sia un modello che un sistema, a seconda del contesto.

La funzione primaria di Whisper è trascrivere il parlato in testo. Si distingue per:

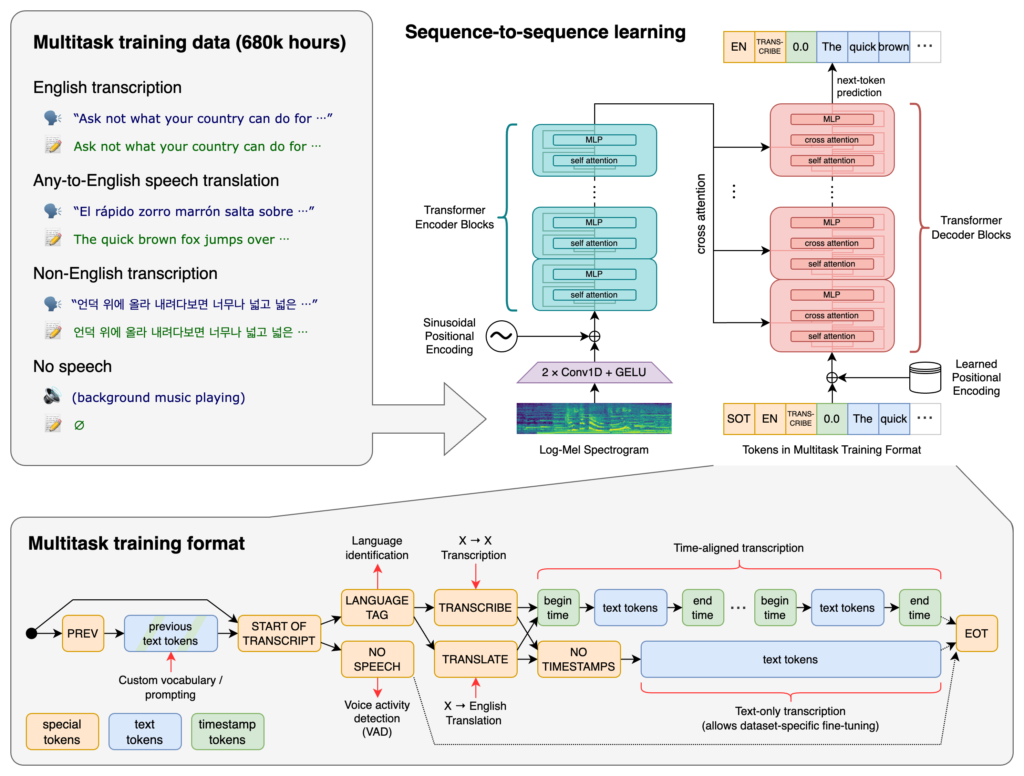

Al cuore di Whisper vi è l’architettura Transformer, nello specifico un modello encoder-decoder. I Transformer sono reti neurali eccellenti nell’elaborare dati sequenziali e comprendere il contesto su sequenze lunghe. Introdotti nell’articolo “Attention is All You Need” del 2017, i Transformer sono diventati fondamentali in molti compiti di NLP.

Il processo di Whisper prevede:

Whisper è stato addestrato su un enorme dataset di 680.000 ore di dati supervisionati raccolti dal web. Questo include:

Con la copertura di 99 lingue, Whisper si distingue per la sua capacità di gestire input linguistici diversi. Questa capacità multilingue lo rende adatto ad applicazioni e servizi globali rivolti a un pubblico internazionale.

Addestrato su una vasta quantità di dati supervisionati, Whisper raggiunge alti tassi di accuratezza nei compiti di trascrizione. La sua robustezza verso accenti, dialetti e rumori di fondo lo rende affidabile in diversi scenari reali.

Oltre alla trascrizione, Whisper può svolgere:

Rilasciato come software open-source, Whisper permette agli sviluppatori di:

Integrando Whisper in chatbot e assistenti AI, gli sviluppatori possono abilitare:

Whisper è implementato come libreria Python, consentendo una perfetta integrazione in progetti basati su Python. Usare Whisper in Python implica la preparazione dell’ambiente appropriato, l’installazione delle dipendenze necessarie e l’utilizzo delle funzioni della libreria per trascrivere o tradurre file audio.

Prima di utilizzare Whisper, è necessario preparare l’ambiente di sviluppo installando Python, PyTorch, FFmpeg e la libreria Whisper stessa.

Se non hai già Python, scaricalo dal sito ufficiale. Per installare PyTorch, usa pip:

pip install torch

In alternativa, visita il sito di PyTorch per istruzioni specifiche in base al tuo sistema operativo e versione di Python.

Whisper richiede FFmpeg per elaborare i file audio. Installa FFmpeg utilizzando il gestore pacchetti appropriato per il tuo sistema operativo.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (con Homebrew):

brew install ffmpeg

Windows (con Chocolatey):

choco install ffmpeg

Installa il pacchetto Python Whisper tramite pip:

pip install -U openai-whisper

Per installare l’ultima versione direttamente dal repository GitHub:

pip install git+https://github.com/openai/whisper.git

Assicurati che la Modalità Sviluppatore sia attivata:

Whisper offre diversi modelli che variano per dimensione e capacità. I modelli vanno da tiny a large, ciascuno con un diverso equilibrio tra velocità e accuratezza.

| Dimensione | Parametri | Modello Solo Inglese | Modello Multilingue | VRAM Richiesta | Velocità Relativa |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): Ottimizzati per la trascrizione in inglese, offrono prestazioni migliorate su audio in questa lingua.Dopo aver configurato l’ambiente e installato i componenti necessari, puoi iniziare a utilizzare Whisper nei tuoi progetti Python.

Inizia importando la libreria Whisper e caricando un modello:

import whisper

# Carica il modello desiderato

model = whisper.load_model("base")

Sostituisci "base" con il nome del modello più adatto alla tua applicazione.

Whisper fornisce una funzione transcribe semplice per convertire file audio in testo.

Esempio: Trascrivere un file audio in inglese

# Trascrivi il file audio

result = model.transcribe("path/to/english_audio.mp3")

# Stampa la trascrizione

print(result["text"])

model.transcribe(): Elabora il file audio e restituisce un dizionario contenente la trascrizione e altri metadati.result["text"]: Accede al testo trascritto dal risultato.Whisper può tradurre audio da varie lingue in inglese.

Esempio: Tradurre audio spagnolo in inglese

# Trascrivi e traduci l'audio spagnolo in inglese

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# Stampa il testo tradotto

print(result["text"])

task="translate": Indica al modello di tradurre l’audio in inglese invece di trascriverlo alla lettera.Anche se Whisper può rilevare automaticamente la lingua, specificandola puoi migliorarne accuratezza e velocità.

Esempio: Trascrivere audio francese

# Trascrivi audio francese specificando la lingua

result = model.transcribe("path/to/french_audio.wav", language="fr")

# Stampa la trascrizione

print(result["text"])

Whisper può identificare la lingua parlata in un file audio usando il metodo detect_language.

Esempio: Rilevamento lingua

# Carica e preelabora l'audio

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# Converti in spettrogramma log-Mel

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Rileva la lingua

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): Carica il file audio.whisper.pad_or_trim(): Adatta la lunghezza dell’audio ai requisiti di input del modello.whisper.log_mel_spectrogram(): Converte l’audio nel formato atteso dal modello.model.detect_language(): Restituisce le probabilità per ogni lingua, identificando quella più probabile.Per maggior controllo sul processo di trascrizione, puoi usare funzioni di basso livello e personalizzare le opzioni di decodifica.

decodeLa funzione decode permette di specificare opzioni come lingua, compito e se includere i timestamp.

Esempio: Opzioni di decodifica personalizzate

# Imposta le opzioni di decodifica

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Decodifica l'audio

result = whisper.decode(model, mel, options)

# Stampa il testo riconosciuto

print(result.text)

Puoi integrare Whisper per trascrivere input audio live da un microfono.

Esempio: Trascrivere input live dal microfono

import whisper

import sounddevice as sd

# Carica il modello

model = whisper.load_model("base")

# Registra audio dal microfono

duration = 5 # secondi

fs = 16000 # Frequenza di campionamento

print("Recording...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper è un avanzato sistema di riconoscimento automatico del parlato (ASR) sviluppato da OpenAI, progettato per trascrivere il linguaggio parlato in testo scritto utilizzando il deep learning. Supporta 99 lingue ed eccelle in trascrizione, traduzione e identificazione della lingua.

Whisper utilizza un'architettura encoder-decoder basata su transformer, elabora l'audio in spettrogrammi log-Mel e produce testo tramite un modello linguistico. È stato addestrato su 680.000 ore di dati multilingue e multitask per un'elevata accuratezza e robustezza.

Whisper supporta il riconoscimento vocale multilingue, la traduzione del parlato, l'identificazione automatica della lingua, la robustezza ad accenti e rumori, e offre accesso open-source per personalizzazione e integrazione.

I requisiti hardware dipendono dalla dimensione del modello: i modelli più piccoli come 'tiny' richiedono circa 1GB di VRAM, mentre il più grande ne richiede circa 10GB. Whisper è più veloce su GPU ma può funzionare su CPU con tempi di elaborazione più lunghi.

Sì, Whisper è implementato come libreria Python e può essere installato tramite pip. Permette una facile integrazione in progetti Python per trascrizione vocale, traduzione e applicazioni vocali in tempo reale.

Gli utilizzi comuni includono trascrizione automatica di riunioni, chatbot vocali, traduzione in tempo reale, strumenti per l'accessibilità (sottotitoli e tecnologie assistive), automazione dei call center e sistemi di automazione controllati dalla voce.

Sì, le alternative includono motori open-source come Mozilla DeepSpeech, Kaldi, Wav2vec e API commerciali come Google Cloud Speech-to-Text, Microsoft Azure AI Speech e AWS Transcribe.

Sì, OpenAI Whisper è open-source, consentendo agli sviluppatori di personalizzare, ottimizzare e integrare il sistema nei propri prodotti e servizi senza vincoli di licenza.

Integra funzionalità avanzate di conversione da voce a testo nelle tue applicazioni, automatizza i flussi di lavoro e migliora l'esperienza utente con OpenAI Whisper e FlowHunt.

FlowHunt supporta dozzine di modelli di generazione di testo, inclusi i modelli di OpenAI. Ecco come utilizzare ChatGPT nei tuoi strumenti di IA e chatbot.

Esplora come le avanzate capacità di ragionamento e l'apprendimento per rinforzo di OpenAI O1 superino GPT4o in accuratezza RAG, con benchmark e analisi dei cos...

Esplora le capacità avanzate dell'agente AI Mistral 8x7B. Questa analisi approfondita rivela come vada oltre la semplice generazione di testo, mettendo in mostr...