OpenCV MCP Server

L'OpenCV MCP Server collega le potenti funzionalità di elaborazione immagini e video di OpenCV con assistenti AI e piattaforme di sviluppo tramite il Model Cont...

L'OpenCV MCP Server collega le potenti funzionalità di elaborazione immagini e video di OpenCV con assistenti AI e piattaforme di sviluppo tramite il Model Cont...

Il server MCP mcp-vision connette i modelli di visione artificiale di HuggingFace—come il rilevamento di oggetti zero-shot—a FlowHunt e ad altre piattaforme AI,...

L'arricchimento dei contenuti con l'IA migliora i contenuti grezzi e non strutturati applicando tecniche di intelligenza artificiale per estrarre informazioni s...

Caffe è un framework open-source per il deep learning sviluppato da BVLC, ottimizzato per la velocità e la modularità nella costruzione di reti neurali convoluz...

Il Deep Learning è una branca del machine learning nell’intelligenza artificiale (AI) che imita il funzionamento del cervello umano nell’elaborazione dei dati e...

L'affinamento del modello adatta i modelli pre-addestrati a nuovi compiti mediante piccoli aggiustamenti, riducendo le necessità di dati e risorse. Scopri come ...

Scopri il Generatore di didascalie per immagini con IA di FlowHunt. Crea istantaneamente didascalie accattivanti e pertinenti per le tue immagini con temi e ton...

Hugging Face Transformers è una delle principali librerie Python open-source che semplifica l’implementazione di modelli Transformer per attività di machine lea...

Scopri i Modelli AI Discriminativi—modelli di machine learning focalizzati sulla classificazione e la regressione tramite la modellazione dei confini decisional...

Un Modello AI Foundation è un modello di apprendimento automatico su larga scala addestrato su enormi quantità di dati, adattabile a una vasta gamma di compiti....

OpenCV è una libreria open-source avanzata per la visione artificiale e il machine learning, che offre oltre 2500 algoritmi per l'elaborazione delle immagini, i...

La Precisione Media Media (mAP) è una metrica chiave nella visione artificiale per valutare i modelli di rilevamento oggetti, catturando sia l'accuratezza della...

PyTorch è un framework open-source per il machine learning sviluppato da Meta AI, rinomato per la sua flessibilità, i grafi computazionali dinamici, l'acceleraz...

Una Rete Neurale Convoluzionale (CNN) è un tipo specializzato di rete neurale artificiale progettata per elaborare dati strutturati a griglia, come le immagini....

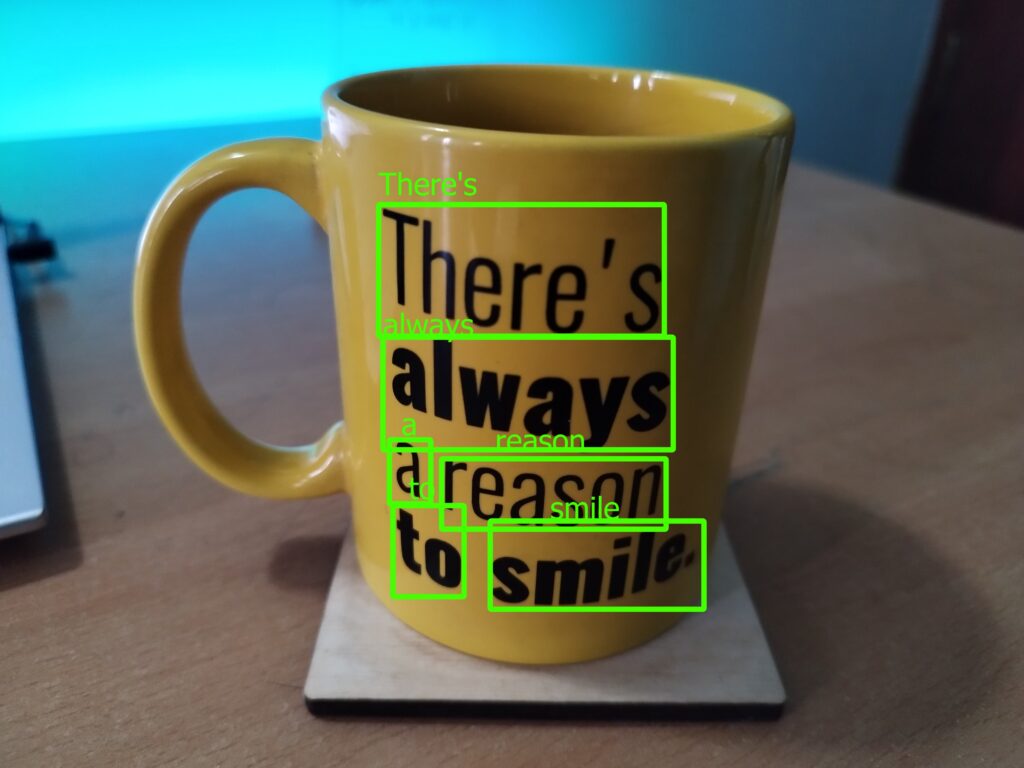

Il Riconoscimento del Testo nelle Scene (STR) è un ramo specializzato dell'OCR (Riconoscimento Ottico dei Caratteri) che si concentra sull'identificazione e l'i...

Scopri cos'è il riconoscimento delle immagini nell'IA. A cosa serve, quali sono i trend e come si differenzia da tecnologie simili.

Il riconoscimento di pattern è un processo computazionale per identificare schemi e regolarità nei dati, fondamentale in campi come l’IA, l’informatica, la psic...

Esplora la Ricostruzione 3D: scopri come questo processo avanzato cattura oggetti o ambienti reali e li trasforma in modelli 3D dettagliati utilizzando tecniche...

La segmentazione di istanza è un compito di visione artificiale che rileva e delinea ciascun oggetto distinto in un'immagine con precisione a livello di pixel. ...

La segmentazione semantica è una tecnica di visione artificiale che suddivide le immagini in più segmenti, assegnando a ciascun pixel un'etichetta di classe che...

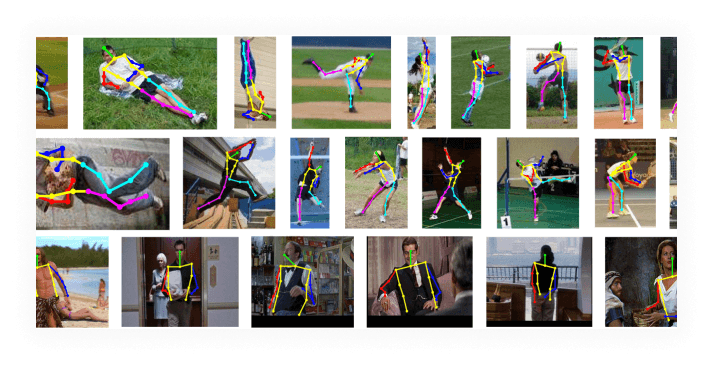

La stima della posizione è una tecnica di visione artificiale che prevede la posizione e l'orientamento di una persona o di un oggetto in immagini o video ident...

La stima della profondità è un compito fondamentale nella visione artificiale, incentrato sulla previsione della distanza degli oggetti all'interno di un'immagi...

La Visione Artificiale è un campo dell’intelligenza artificiale (IA) focalizzato sul permettere ai computer di interpretare e comprendere il mondo visivo. Sfrut...