IA nell'Intrattenimento

L'IA sta rivoluzionando l'intrattenimento, migliorando giochi, film e musica attraverso interazioni dinamiche, personalizzazione ed evoluzione in tempo reale de...

L'IA sta rivoluzionando l'intrattenimento, migliorando giochi, film e musica attraverso interazioni dinamiche, personalizzazione ed evoluzione in tempo reale de...

L'Intelligenza Artificiale (IA) nella cybersecurity sfrutta tecnologie come il machine learning e l'NLP per rilevare, prevenire e rispondere alle minacce inform...

L'Intelligenza Artificiale (IA) nella manifattura sta trasformando la produzione integrando tecnologie avanzate per aumentare produttività, efficienza e capacit...

L'Intelligenza Artificiale (IA) nella sanità sfrutta algoritmi avanzati e tecnologie come machine learning, NLP e deep learning per analizzare dati medici compl...

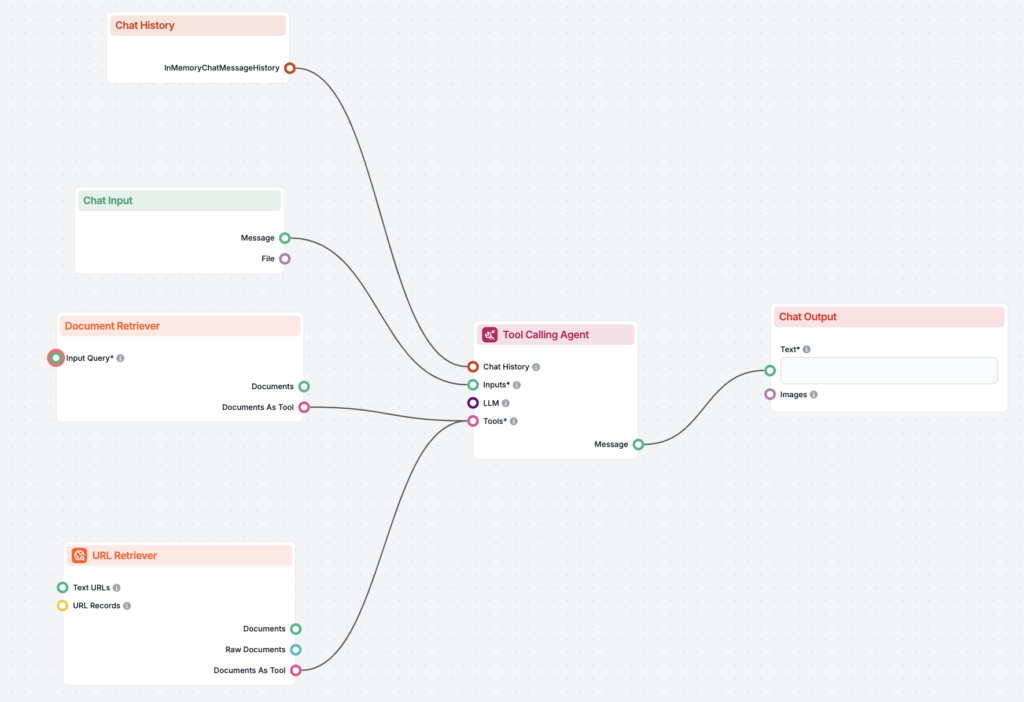

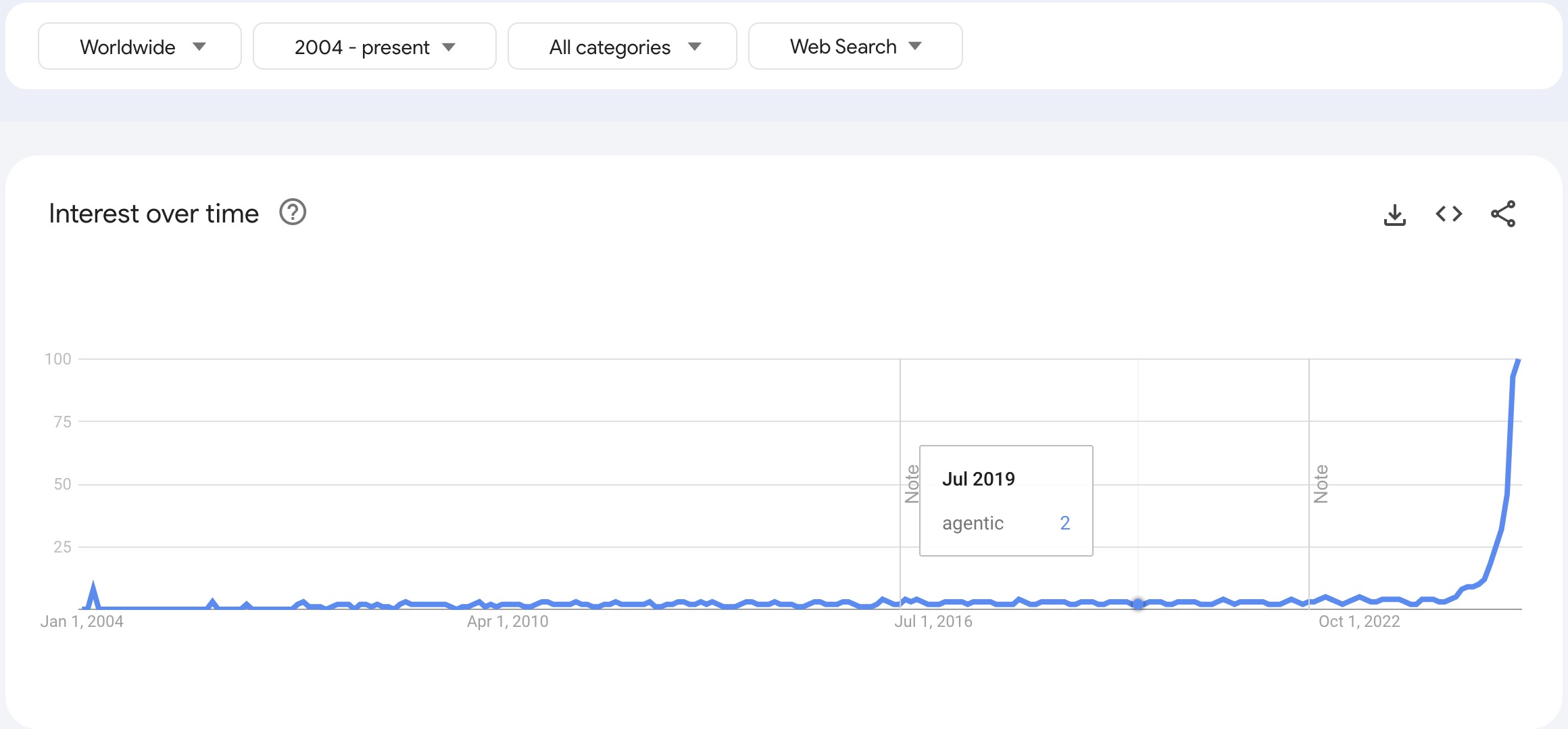

Scopri come l’IA agentica e i sistemi multi-agente rivoluzionano l’automazione dei workflow grazie a decisioni autonome, adattabilità e collaborazione—guidando ...

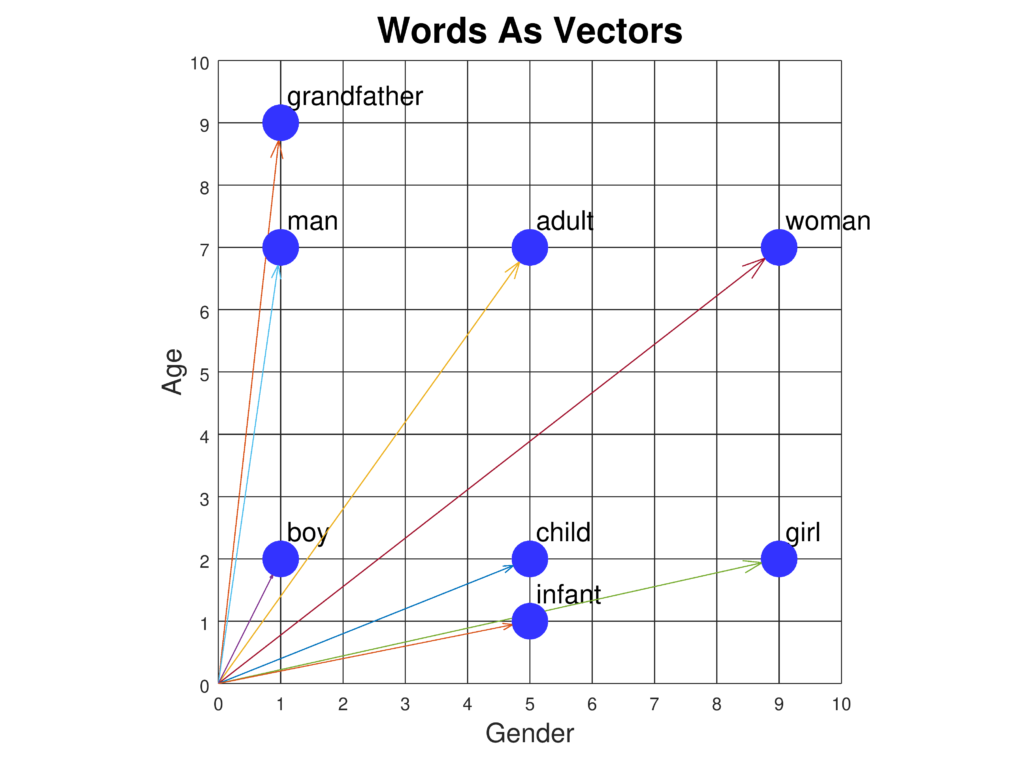

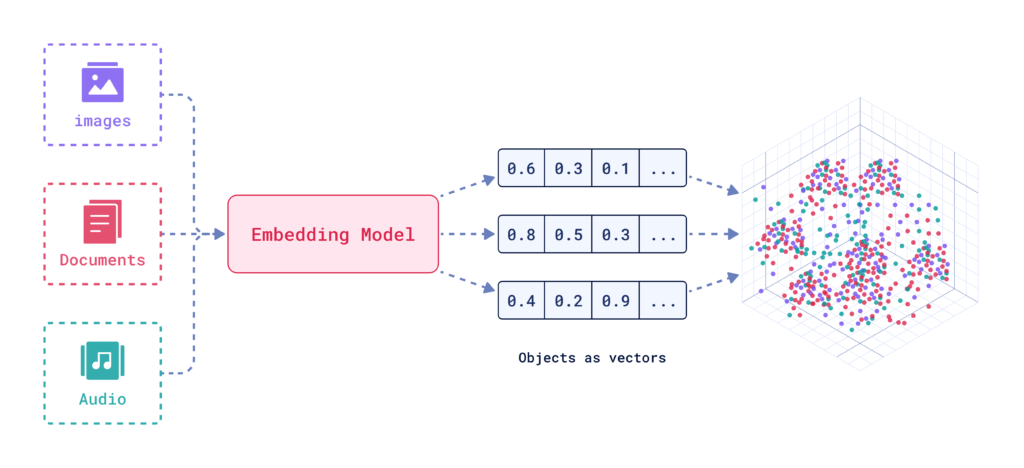

Gli incorporamenti di parole sono rappresentazioni sofisticate delle parole in uno spazio vettoriale continuo, che catturano le relazioni semantiche e sintattic...

L'inferenza causale è un approccio metodologico utilizzato per determinare le relazioni causa-effetto tra variabili, fondamentale nelle scienze per comprendere ...

L'informatica cognitiva rappresenta un modello tecnologico trasformativo che simula i processi di pensiero umano in scenari complessi. Integra l'IA e l'elaboraz...

Scopri il ruolo dell'Ingegnere di Sistemi AI: progettare, sviluppare e mantenere sistemi di intelligenza artificiale, integrare il machine learning, gestire l'i...

Scopri come l'Ingegneria ed Estrazione delle Caratteristiche migliorano le prestazioni dei modelli di IA trasformando dati grezzi in informazioni preziose. Appr...

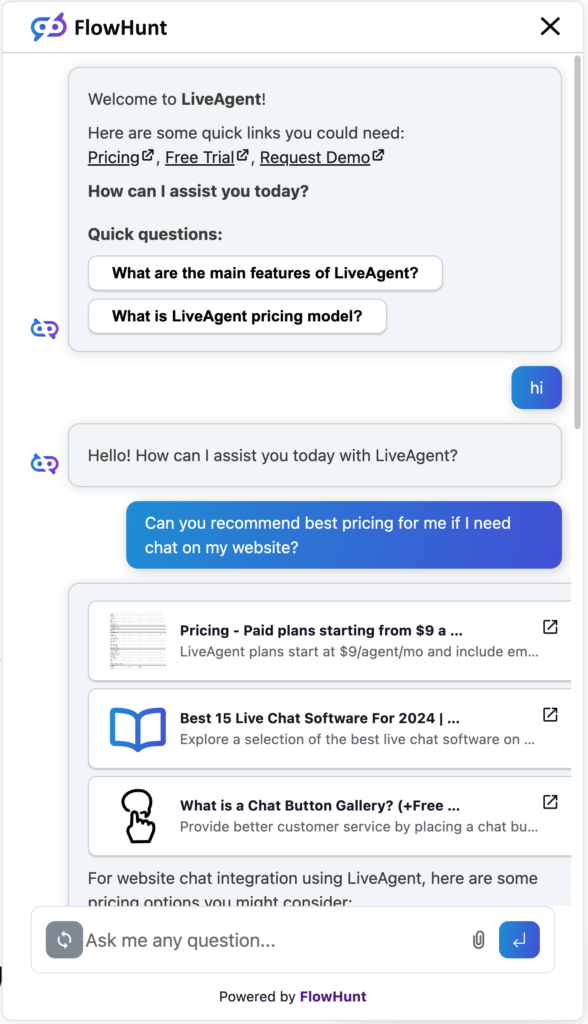

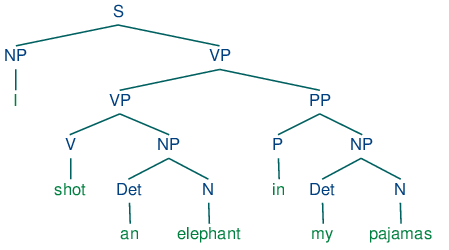

L'intelligenza artificiale conversazionale si riferisce a tecnologie che permettono ai computer di simulare conversazioni umane utilizzando NLP, machine learnin...

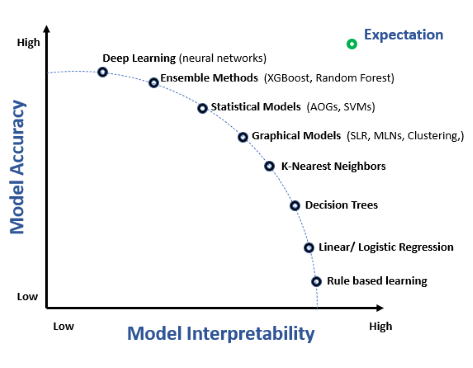

L’interpretabilità del modello si riferisce alla capacità di comprendere, spiegare e fidarsi delle previsioni e delle decisioni prese dai modelli di machine lea...

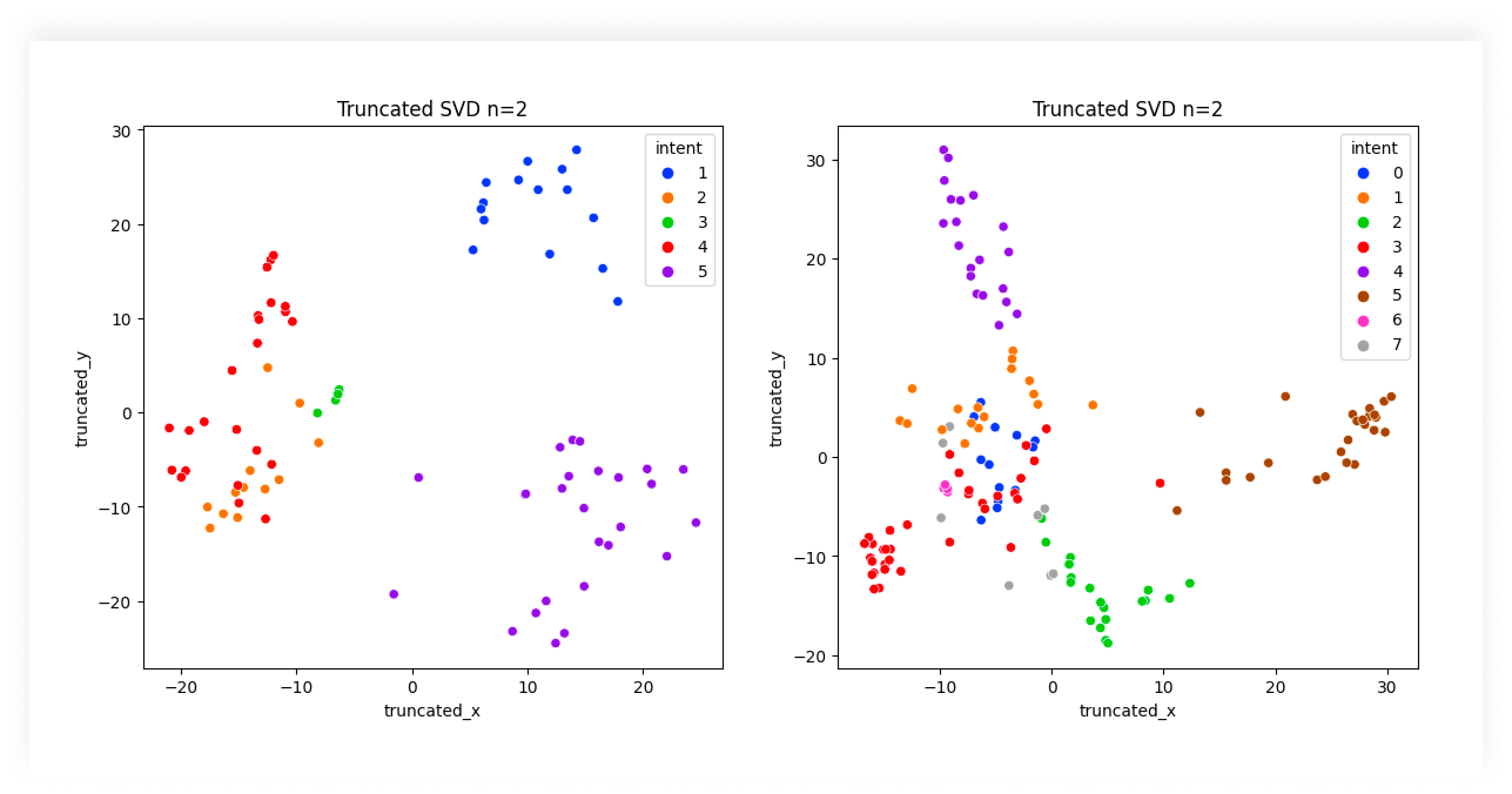

Scopri il ruolo essenziale della Classificazione delle Intenzioni nell’IA per migliorare le interazioni degli utenti con la tecnologia, ottimizzare il supporto ...

L'istruzione tuning è una tecnica nell'IA che affina i grandi modelli linguistici (LLM) su coppie istruzione-risposta, migliorando la loro capacità di seguire i...

Jupyter Notebook è un'applicazione web open-source che consente agli utenti di creare e condividere documenti con codice live, equazioni, visualizzazioni e test...

L'algoritmo dei k-nearest neighbors (KNN) è un algoritmo di apprendimento supervisionato non parametrico utilizzato per compiti di classificazione e regressione...

Kaggle è una comunità online e una piattaforma per data scientist e ingegneri di machine learning, pensata per collaborare, imparare, competere e condividere in...

Keras è una potente e intuitiva API open-source di reti neurali ad alto livello, scritta in Python e capace di funzionare sopra TensorFlow, CNTK o Theano. Perme...

KNIME (Konstanz Information Miner) è una potente piattaforma open-source per l'analisi dei dati che offre workflow visuali, integrazione dati senza soluzione di...

Kubeflow è una piattaforma open-source per il machine learning (ML) su Kubernetes, che semplifica il deployment, la gestione e la scalabilità dei flussi di lavo...

Anaconda è una distribuzione open-source completa di Python e R, progettata per semplificare la gestione dei pacchetti e il deployment per il calcolo scientific...

LightGBM, o Light Gradient Boosting Machine, è un avanzato framework di gradient boosting sviluppato da Microsoft. Progettato per compiti di machine learning ad...

Il marketing alimentato dall'IA sfrutta tecnologie di intelligenza artificiale come il machine learning, l'elaborazione del linguaggio naturale (NLP) e l'analis...

Il marketing personalizzato con l'IA sfrutta l'intelligenza artificiale per adattare strategie e comunicazioni di marketing ai singoli clienti in base a comport...

Una matrice di confusione è uno strumento di machine learning per valutare le prestazioni dei modelli di classificazione, dettagliando veri/falsi positivi e neg...

MLflow è una piattaforma open-source progettata per semplificare e gestire il ciclo di vita del machine learning (ML). Fornisce strumenti per il tracciamento de...

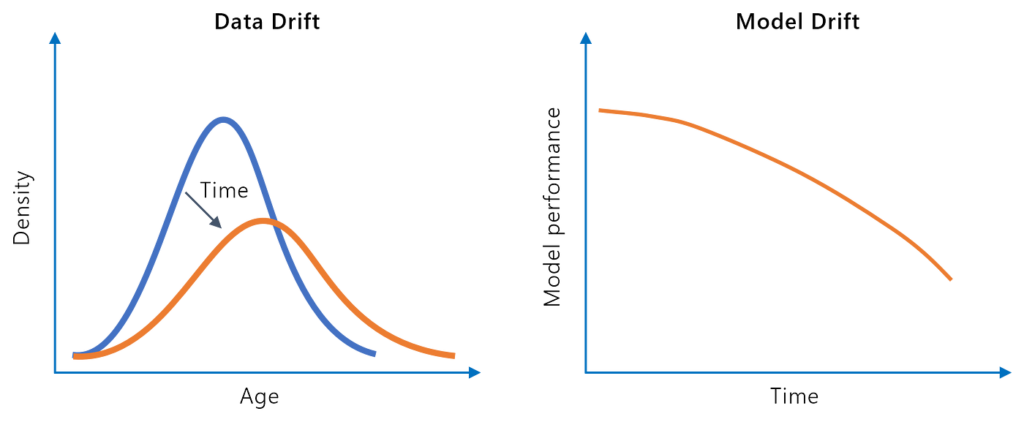

Il model drift, o decadimento del modello, si riferisce al declino delle prestazioni predittive di un modello di machine learning nel tempo a causa di cambiamen...

La modellazione predittiva è un processo sofisticato nella data science e nella statistica che prevede risultati futuri analizzando i pattern dei dati storici. ...

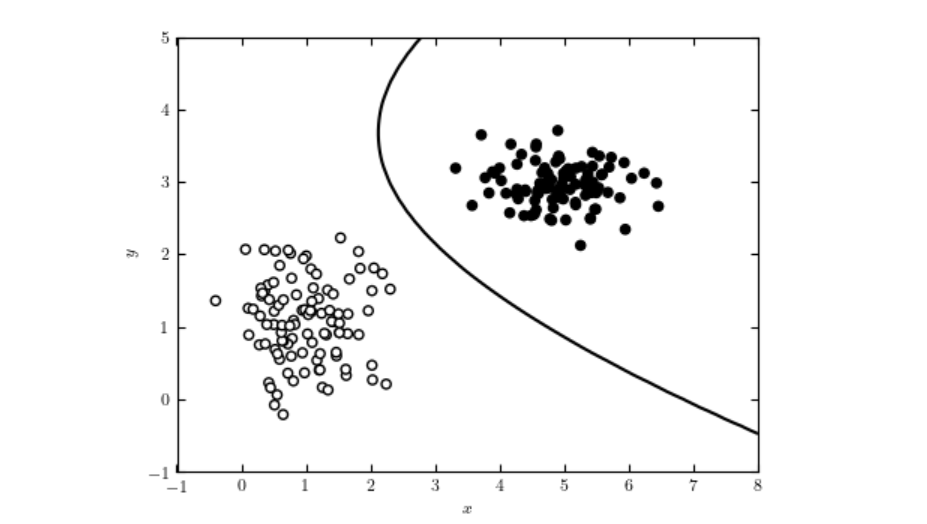

Scopri i Modelli AI Discriminativi—modelli di machine learning focalizzati sulla classificazione e la regressione tramite la modellazione dei confini decisional...

I Modelli di Markov Nascosti (HMM) sono modelli statistici sofisticati per sistemi in cui gli stati sottostanti non sono osservabili. Ampiamente utilizzati nel ...

Il Modello Flux AI di Black Forest Labs è un avanzato sistema di generazione testo-immagine che converte prompt in linguaggio naturale in immagini altamente det...

Un Modello AI Foundation è un modello di apprendimento automatico su larga scala addestrato su enormi quantità di dati, adattabile a una vasta gamma di compiti....

Scopri cos'è un Motore di Insight: una piattaforma avanzata guidata dall’IA che migliora la ricerca e l’analisi dei dati comprendendo contesto e intento. Scopri...

Apache MXNet è un framework open-source per il deep learning progettato per un addestramento e un deployment efficienti e flessibili di reti neurali profonde. C...

Naive Bayes è una famiglia di algoritmi di classificazione basati sul Teorema di Bayes, che applicano la probabilità condizionata con l’assunzione semplificata ...

Natural Language Toolkit (NLTK) è una suite completa di librerie e programmi Python per l'elaborazione del linguaggio naturale (NLP) simbolica e statistica. Amp...

Le piattaforme di AI No-Code permettono agli utenti di creare, distribuire e gestire modelli di intelligenza artificiale e machine learning senza scrivere codic...

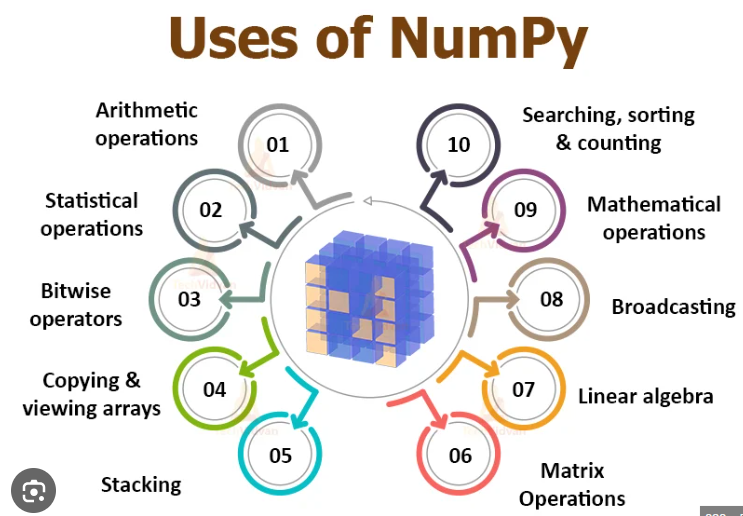

NumPy è una libreria open-source di Python fondamentale per il calcolo numerico, che fornisce operazioni su array efficienti e funzioni matematiche. Sostiene il...

Open Neural Network Exchange (ONNX) è un formato open-source per lo scambio senza soluzione di continuità di modelli di machine learning tra diversi framework, ...

OpenAI è una delle principali organizzazioni di ricerca sull'intelligenza artificiale, nota per lo sviluppo di GPT, DALL-E e ChatGPT, con l'obiettivo di creare ...

OpenCV è una libreria open-source avanzata per la visione artificiale e il machine learning, che offre oltre 2500 algoritmi per l'elaborazione delle immagini, i...

L'Ottimizzazione degli Iperparametri è un processo fondamentale nel machine learning per ottimizzare le prestazioni del modello regolando parametri come il lear...

L'overfitting è un concetto fondamentale nell'intelligenza artificiale (IA) e nel machine learning (ML), che si verifica quando un modello apprende troppo bene ...

Pandas è una libreria open-source per la manipolazione e l'analisi dei dati in Python, rinomata per la sua versatilità, le robuste strutture dati e la facilità ...

Il Pathways Language Model (PaLM) è la famiglia avanzata di grandi modelli linguistici di Google, progettata per applicazioni versatili come generazione di test...

La perdita logaritmica, o perdita log/cross-entropia, è una metrica chiave per valutare le prestazioni dei modelli di machine learning—specialmente per la class...

Perplexity AI è un motore di ricerca avanzato basato sull'intelligenza artificiale e uno strumento conversazionale che sfrutta NLP e machine learning per fornir...

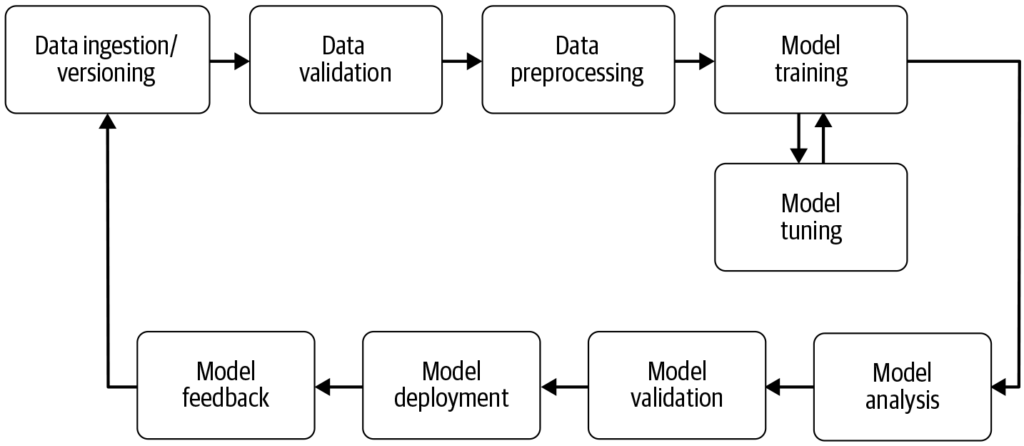

Una pipeline di machine learning è un flusso di lavoro automatizzato che semplifica e standardizza lo sviluppo, l'addestramento, la valutazione e la distribuzio...

Esplora il pregiudizio nell'IA: comprendi le sue origini, l'impatto sul machine learning, esempi reali e strategie di mitigazione per costruire sistemi di IA eq...

La previsione finanziaria è un sofisticato processo analitico utilizzato per prevedere i risultati finanziari futuri di un’azienda attraverso l’analisi dei dati...

La pulizia dei dati è il processo cruciale di rilevamento e correzione degli errori o delle incongruenze nei dati per migliorarne la qualità, garantendo accurat...

PyTorch è un framework open-source per il machine learning sviluppato da Meta AI, rinomato per la sua flessibilità, i grafi computazionali dinamici, l'acceleraz...

Q-learning è un concetto fondamentale nell'intelligenza artificiale (IA) e nell'apprendimento automatico, in particolare nell'ambito dell'apprendimento per rinf...

Il R-quadro corretto è una misura statistica utilizzata per valutare la bontà di adattamento di un modello di regressione, tenendo conto del numero di predittor...

Il ragionamento è il processo cognitivo di trarre conclusioni, fare inferenze o risolvere problemi basandosi su informazioni, fatti e logica. Esplora la sua imp...

Esplora il concetto di recall nel machine learning: una metrica fondamentale per valutare le prestazioni dei modelli, soprattutto nei compiti di classificazione...

Il Recupero dell'Informazione sfrutta l’IA, l’NLP e il machine learning per recuperare dati che soddisfano i requisiti degli utenti in modo efficiente e accurat...

La regolarizzazione nell’intelligenza artificiale (IA) si riferisce a una serie di tecniche utilizzate per prevenire l’overfitting nei modelli di apprendimento ...

La regressione lineare è una tecnica analitica fondamentale nelle statistiche e nel machine learning, che modella la relazione tra variabili dipendenti e indipe...

La regressione logistica è un metodo statistico e di machine learning utilizzato per prevedere esiti binari dai dati. Stima la probabilità che un evento si veri...

La Regressione Random Forest è un potente algoritmo di machine learning utilizzato per l'analisi predittiva. Costruisce più alberi decisionali e ne media i risu...

Una Rete Generativa Avversaria (GAN) è un framework di apprendimento automatico con due reti neurali—un generatore e un discriminatore—che competono per generar...

Una Rete Bayesiana (BN) è un modello grafico probabilistico che rappresenta variabili e le loro dipendenze condizionate tramite un Grafo Aciclico Diretto (DAG)....

Una Deep Belief Network (DBN) è un sofisticato modello generativo che utilizza architetture profonde e Restricted Boltzmann Machines (RBM) per apprendere rappre...

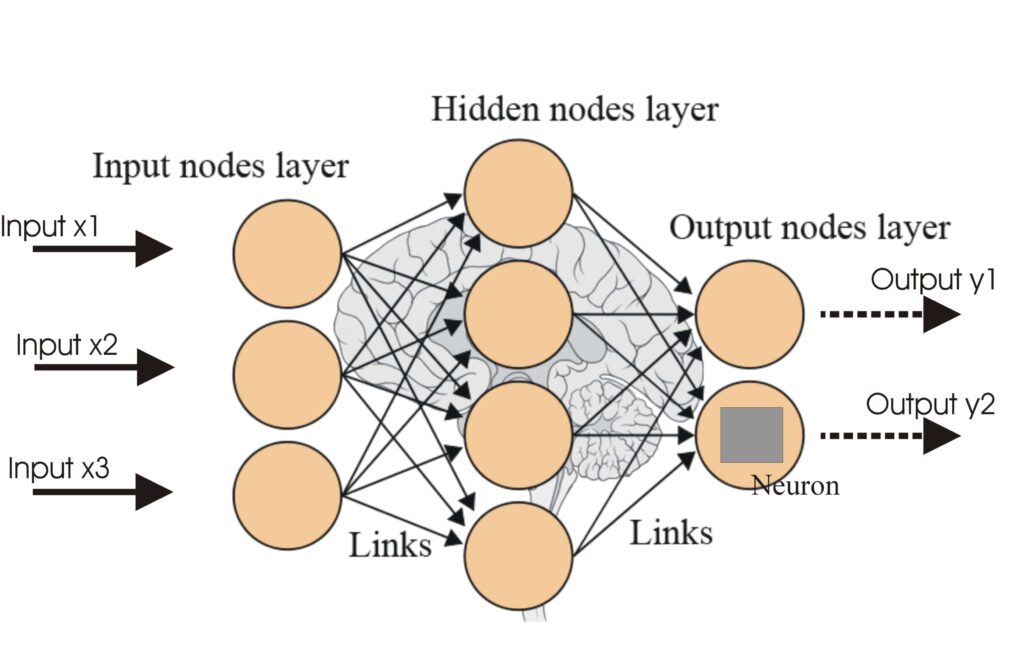

Una rete neurale, o rete neurale artificiale (ANN), è un modello computazionale ispirato al cervello umano, essenziale nell'IA e nell'apprendimento automatico p...

Le Reti Neurali Artificiali (ANNs) sono un sottoinsieme degli algoritmi di apprendimento automatico modellati sul cervello umano. Questi modelli computazionali ...

La retropropagazione è un algoritmo per l'addestramento delle reti neurali artificiali che regola i pesi per minimizzare l'errore di previsione. Scopri come fun...

L'Intelligenza Artificiale (IA) nella revisione dei documenti legali rappresenta un cambiamento significativo nel modo in cui i professionisti del diritto gesti...

La Ricerca AI è una metodologia di ricerca semantica o basata su vettori che utilizza modelli di machine learning per comprendere l’intento e il significato con...

Scopri cos'è il riconoscimento delle immagini nell'IA. A cosa serve, quali sono i trend e come si differenzia da tecnologie simili.

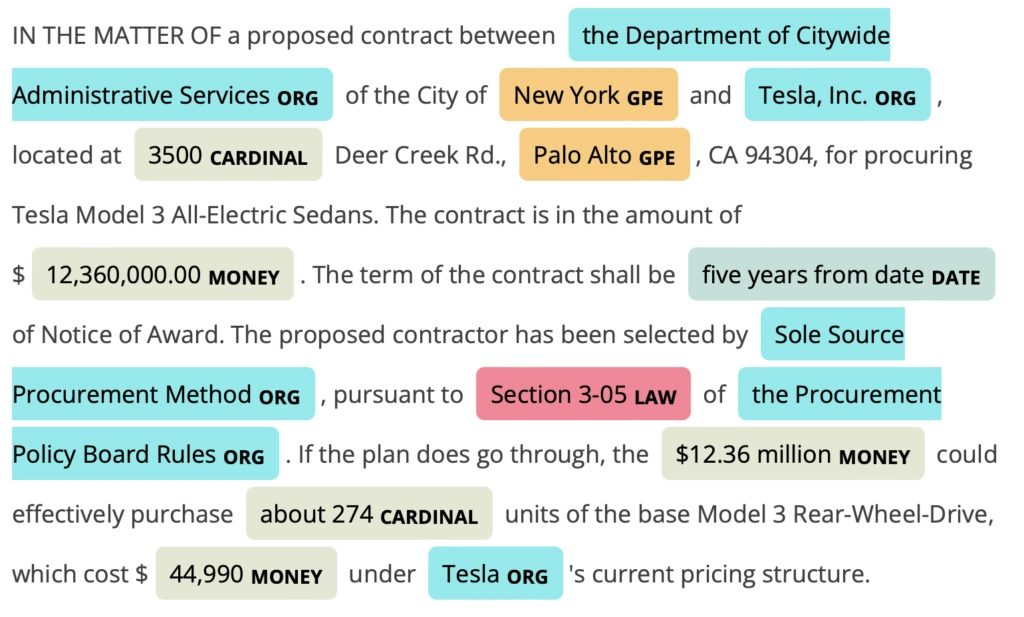

Il Riconoscimento di Entità Nominate (NER) è un sottocampo chiave dell'Elaborazione del Linguaggio Naturale (NLP) nell'IA, focalizzato sull'identificazione e la...

Il riconoscimento di pattern è un processo computazionale per identificare schemi e regolarità nei dati, fondamentale in campi come l’IA, l’informatica, la psic...

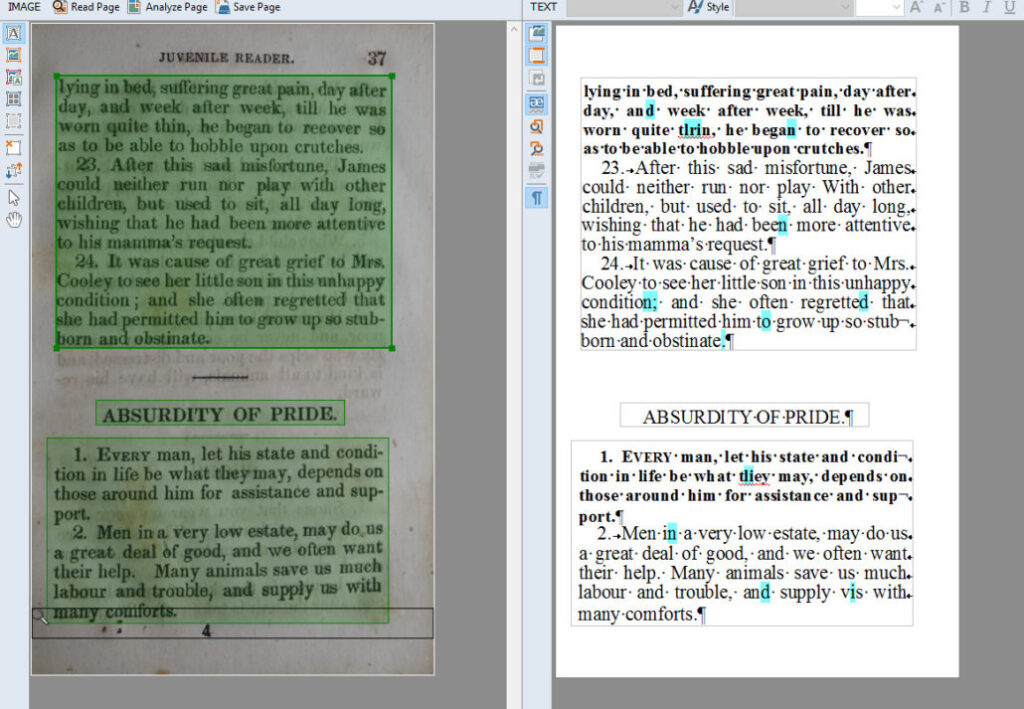

Il Riconoscimento Ottico dei Caratteri (OCR) è una tecnologia trasformativa che converte documenti come fogli scansionati, PDF o immagini in dati modificabili e...

Il riconoscimento vocale, noto anche come riconoscimento automatico della voce (ASR) o speech-to-text, consente ai computer di interpretare e convertire il ling...

Esplora la Ricostruzione 3D: scopri come questo processo avanzato cattura oggetti o ambienti reali e li trasforma in modelli 3D dettagliati utilizzando tecniche...

La riduzione della dimensione è una tecnica fondamentale nell'elaborazione dei dati e nel machine learning, volta a ridurre il numero di variabili di input in u...

Il rilevamento delle anomalie è il processo di identificazione di punti dati, eventi o schemi che si discostano dalla norma attesa all'interno di un insieme di ...

Il rilevamento delle frodi con l'IA sfrutta il machine learning per identificare e mitigare le attività fraudolente in tempo reale. Migliora l’accuratezza, la s...

L'IA nel rilevamento delle frodi finanziarie si riferisce all'applicazione di tecnologie di intelligenza artificiale per identificare e prevenire attività fraud...

La risoluzione della coreferenza è un compito fondamentale dell'ELN che identifica e collega espressioni nel testo che si riferiscono alla stessa entità, crucia...

La robustezza del modello si riferisce alla capacità di un modello di apprendimento automatico (ML) di mantenere prestazioni coerenti e accurate nonostante le v...

La scarsità di dati si riferisce alla quantità insufficiente di dati per addestrare modelli di machine learning o per un'analisi completa, ostacolando lo svilup...

Scikit-learn è una potente libreria open-source per il machine learning in Python, che offre strumenti semplici ed efficienti per l'analisi predittiva dei dati....

SciPy è una solida libreria open-source di Python per il calcolo scientifico e tecnico. Basandosi su NumPy, offre algoritmi matematici avanzati, ottimizzazione,...

Scopri cos'è un AI SDR e come i Sales Development Representative basati sull'intelligenza artificiale automatizzano il prospecting, la qualificazione dei lead, ...

Un Sistema di Automazione AI integra le tecnologie di intelligenza artificiale con i processi di automazione, potenziando l'automazione tradizionale con capacit...

spaCy è una solida libreria open-source Python per l’elaborazione avanzata del linguaggio naturale (NLP), nota per la sua velocità, efficienza e funzionalità pr...

Garbage In, Garbage Out (GIGO) evidenzia come la qualità dell'output di un'IA e di altri sistemi dipenda direttamente dalla qualità dell'input. Scopri le sue im...

Uno Specialista in Assicurazione Qualità AI garantisce l'accuratezza, l'affidabilità e le prestazioni dei sistemi di intelligenza artificiale sviluppando piani ...

La spiegabilità dell’AI si riferisce alla capacità di comprendere e interpretare le decisioni e le previsioni fatte dai sistemi di intelligenza artificiale. Man...

Stable Diffusion è un avanzato modello di generazione testo-immagine che utilizza il deep learning per produrre immagini di alta qualità e fotorealistiche a par...

Una startup guidata dall'IA è un'impresa che incentra le proprie operazioni, prodotti o servizi sulle tecnologie di intelligenza artificiale per innovare, autom...

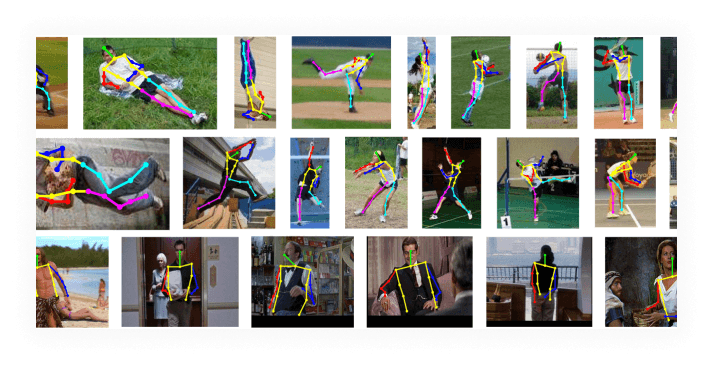

La stima della posizione è una tecnica di visione artificiale che prevede la posizione e l'orientamento di una persona o di un oggetto in immagini o video ident...

La Superintelligenza Artificiale (ASI) è un'IA teorica che supera l'intelligenza umana in tutti i domini, con capacità auto-migliorative e multimodali. Scopri l...

Lo Sviluppo di Prototipi di IA è il processo iterativo di progettazione e creazione di versioni preliminari di sistemi di intelligenza artificiale, che consente...

Esplora le principali tendenze dell'IA per il 2025, tra cui l'ascesa degli agenti e delle crew IA, e scopri come queste innovazioni stanno trasformando le indus...

Le tendenze della tecnologia AI comprendono i progressi attuali ed emergenti nell'intelligenza artificiale, tra cui il machine learning, i grandi modelli lingui...

TensorFlow è una libreria open-source sviluppata dal team Google Brain, progettata per il calcolo numerico e l’apprendimento automatico su larga scala. Supporta...

Torch è una libreria open-source per il machine learning e un framework di calcolo scientifico basato su Lua, ottimizzato per il deep learning e le attività di ...

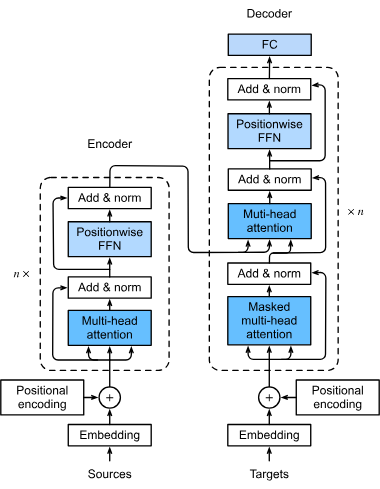

I transformer sono un'architettura rivoluzionaria di reti neurali che ha trasformato l'intelligenza artificiale, specialmente nell'elaborazione del linguaggio n...

Mostrando 101 a 200 di 211 risultati