mcp-local-rag

Integra FlowHunt con mcp-local-rag per potenziare i tuoi agenti AI con ricerca web dal vivo, embedding contestuale e recupero di informazioni in tempo reale—tut...

Integra FlowHunt con mcp-local-rag per potenziare i tuoi agenti AI con ricerca web dal vivo, embedding contestuale e recupero di informazioni in tempo reale—tut...

Integra FlowHunt con il Server MCP RAG Web Browser per abilitare agenti AI e LLM con funzionalità avanzate di navigazione web, ricerca in tempo reale ed estrazi...

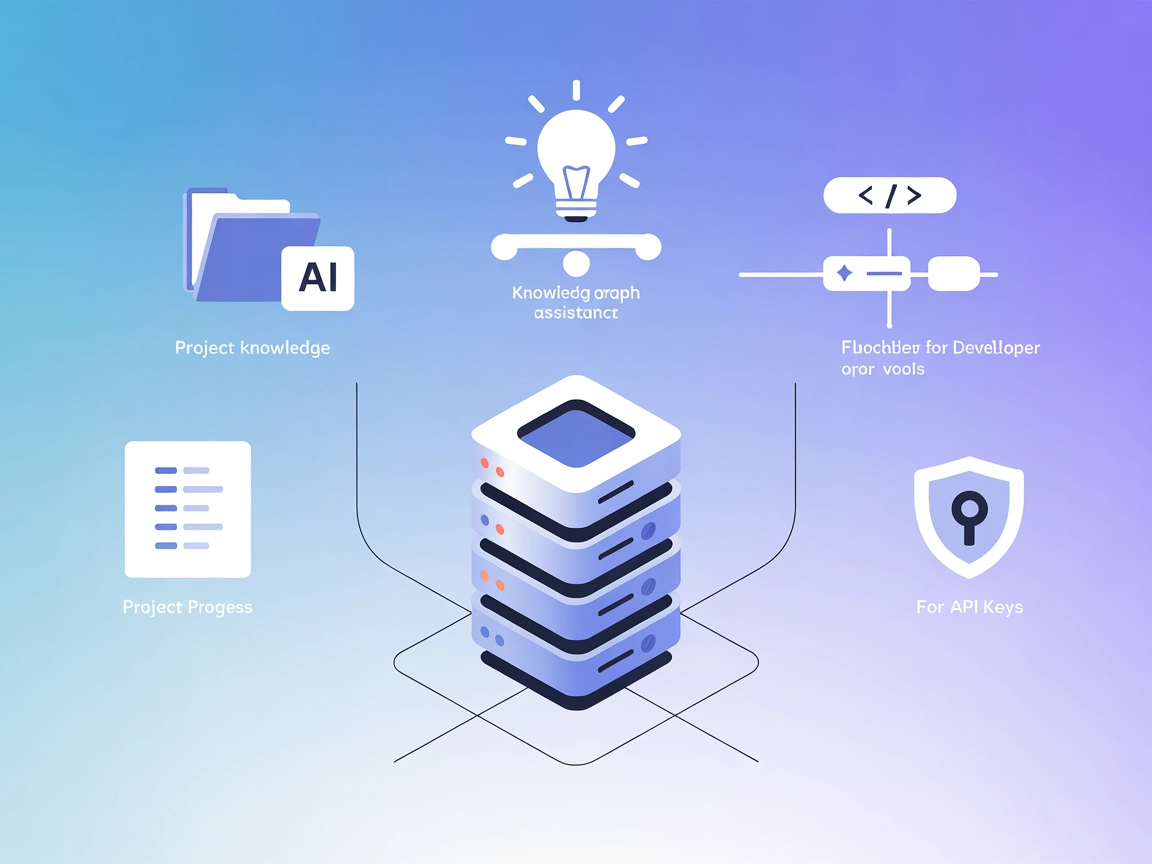

Integra FlowHunt con Context Portal per creare una potente banca della memoria per i tuoi progetti software. Gestisci, archivia e recupera con facilità il conte...

Integra FlowHunt con Agentset MCP, la piattaforma open-source per la Retrieval-Augmented Generation (RAG), per creare applicazioni AI basate su documenti scalab...

Integra FlowHunt con Inkeep MCP Server per offrire risposte istantanee e contestuali dalla documentazione del tuo prodotto utilizzando una potente Retrieval Aug...

Integra FlowHunt con Vectara MCP per potenziare i tuoi agenti IA e le applicazioni RAG con una ricerca affidabile e a bassa allucinazione utilizzando il Model C...

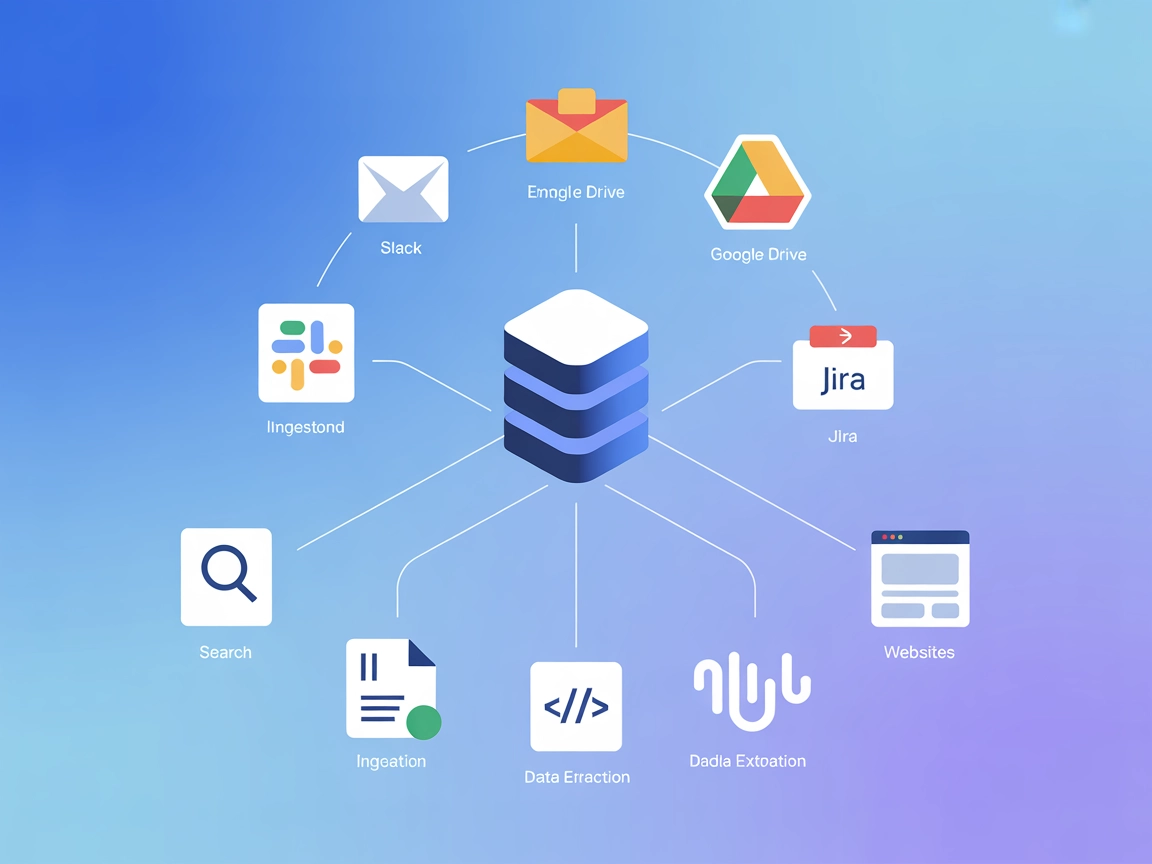

Integra FlowHunt con il server Graphlit Model Context Protocol (MCP) per unificare, ricercare e automatizzare le basi di conoscenza su Slack, Discord, Google Dr...

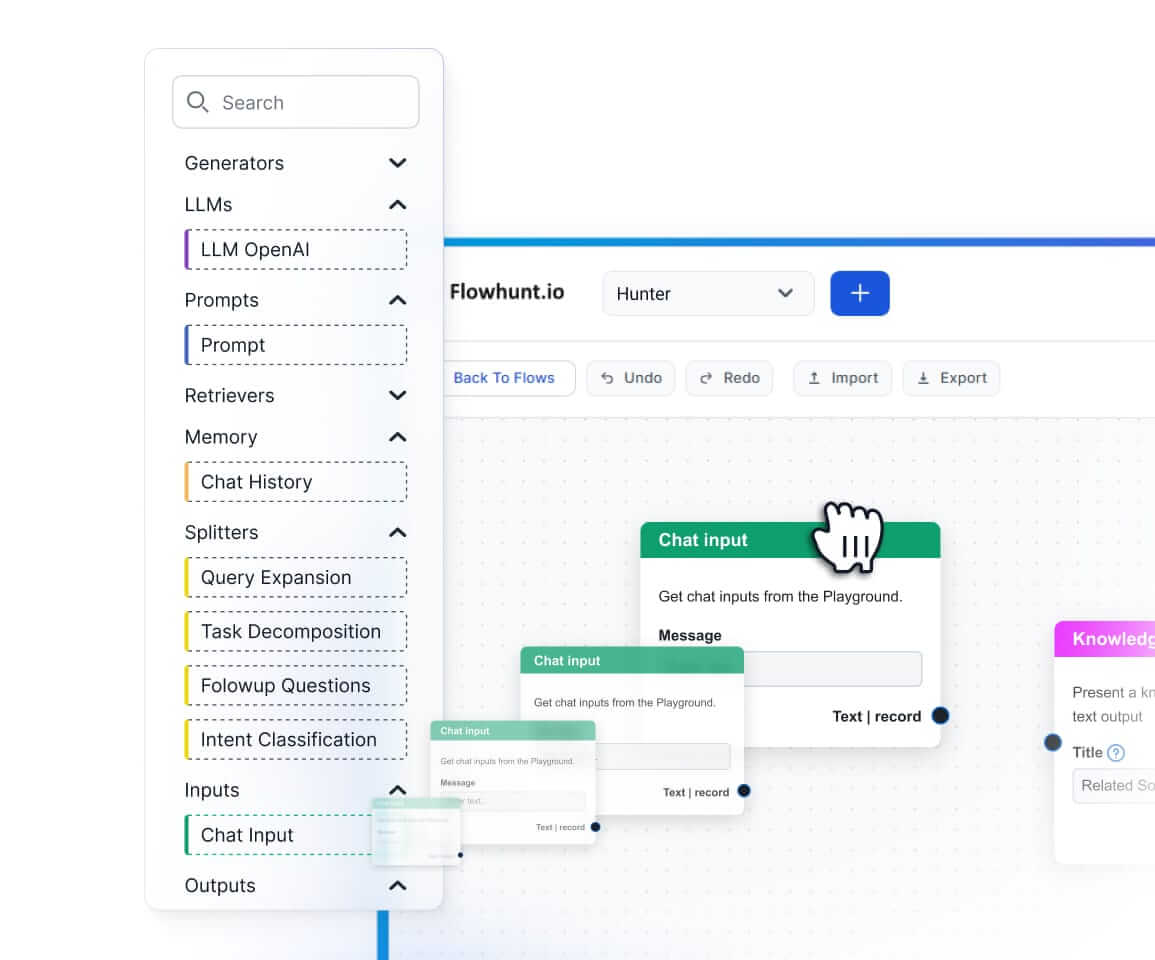

Il server MCP mcp-local-rag consente una ricerca web RAG (Retrieval-Augmented Generation) locale e rispettosa della privacy per LLM. Permette agli assistenti AI...

Integra FlowHunt con i database vettoriali Pinecone utilizzando il Pinecone MCP Server. Abilita la ricerca semantica, la Retrieval-Augmented Generation (RAG) e ...

Il RAG Web Browser MCP Server fornisce agli assistenti AI e ai LLM la capacità di effettuare ricerche web in tempo reale ed estrarre contenuti, abilitando la Re...

Context Portal (ConPort) è un server MCP memory bank che potenzia gli assistenti AI e gli strumenti di sviluppo gestendo il contesto strutturato del progetto, a...

Agentset MCP Server è una piattaforma open-source che abilita la Retrieval-Augmented Generation (RAG) con capacità agentiche, consentendo agli assistenti AI di ...

Il server Inkeep MCP collega assistenti AI e strumenti per sviluppatori alla documentazione di prodotto aggiornata gestita in Inkeep, consentendo il recupero di...

Il server MCP mcp-rag-local consente agli assistenti AI di avere una memoria semantica, permettendo l'archiviazione e il recupero di passaggi di testo in base a...

Il Server Graphlit MCP collega FlowHunt e altri client MCP a una piattaforma di conoscenza unificata, consentendo l'ingestione, l'aggregazione e il recupero sen...

Vectara MCP Server è un bridge open source tra assistenti AI e la piattaforma Trusted RAG di Vectara, che consente un Retrieval-Augmented Generation (RAG) sicur...

Cache Augmented Generation (CAG) è un approccio innovativo per migliorare i large language model (LLM) caricando preventivamente la conoscenza come cache di cop...

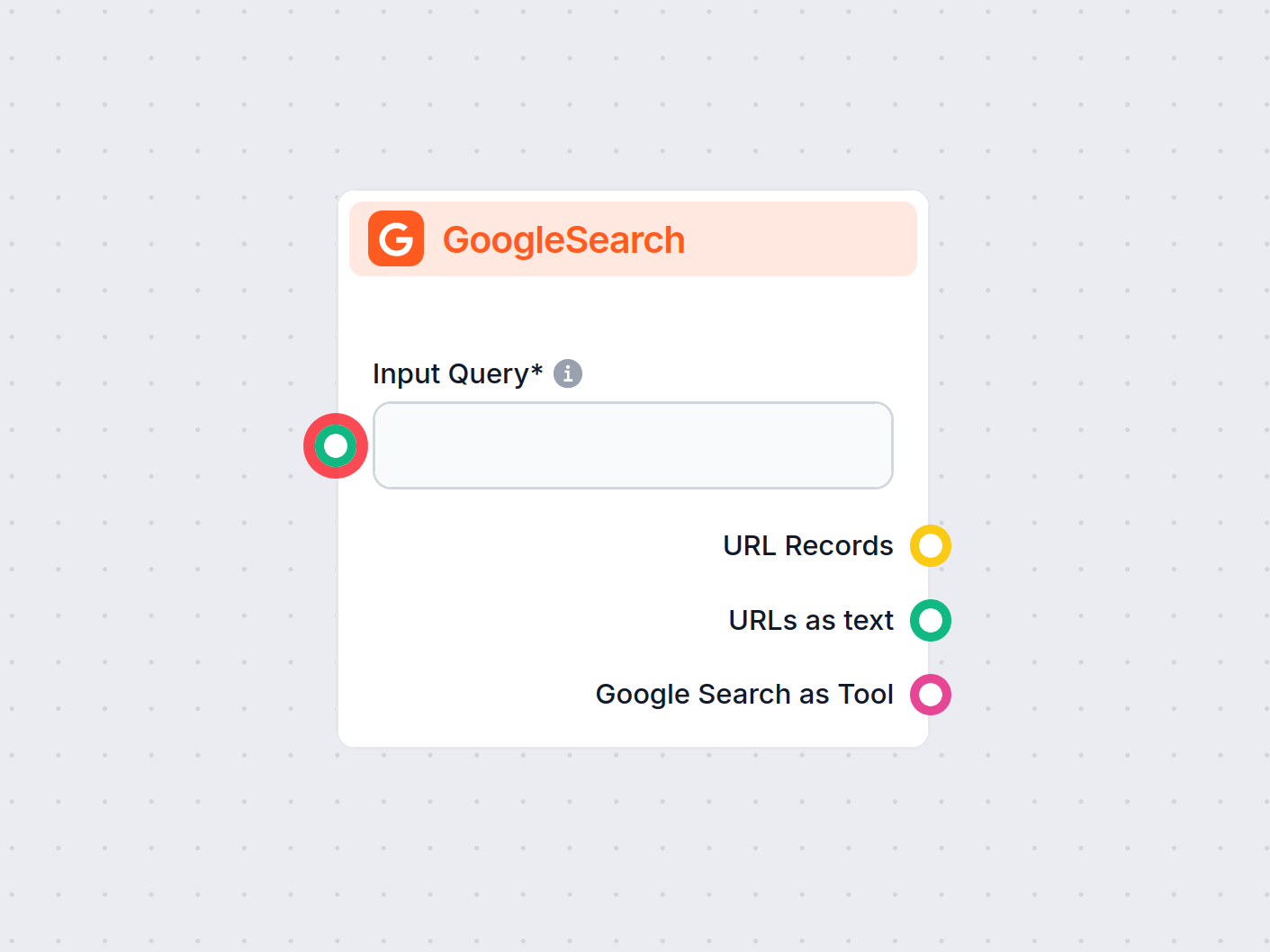

Il componente GoogleSearch di FlowHunt migliora l'accuratezza dei chatbot utilizzando la Retrieval-Augmented Generation (RAG) per accedere a conoscenze aggiorna...

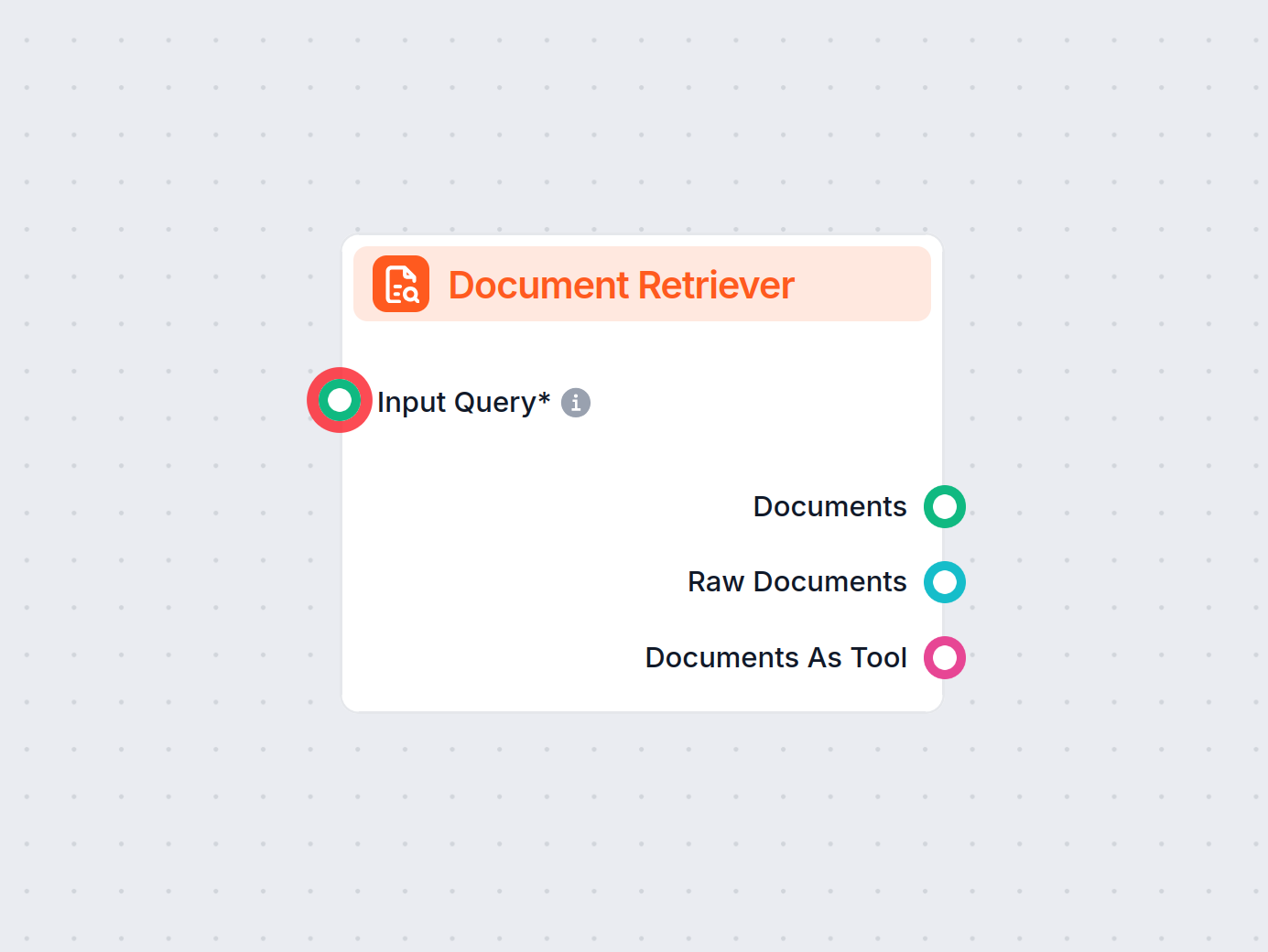

Il Document Retriever di FlowHunt migliora l'accuratezza dell’AI collegando i modelli generativi ai tuoi documenti e URL aggiornati, garantendo risposte affidab...

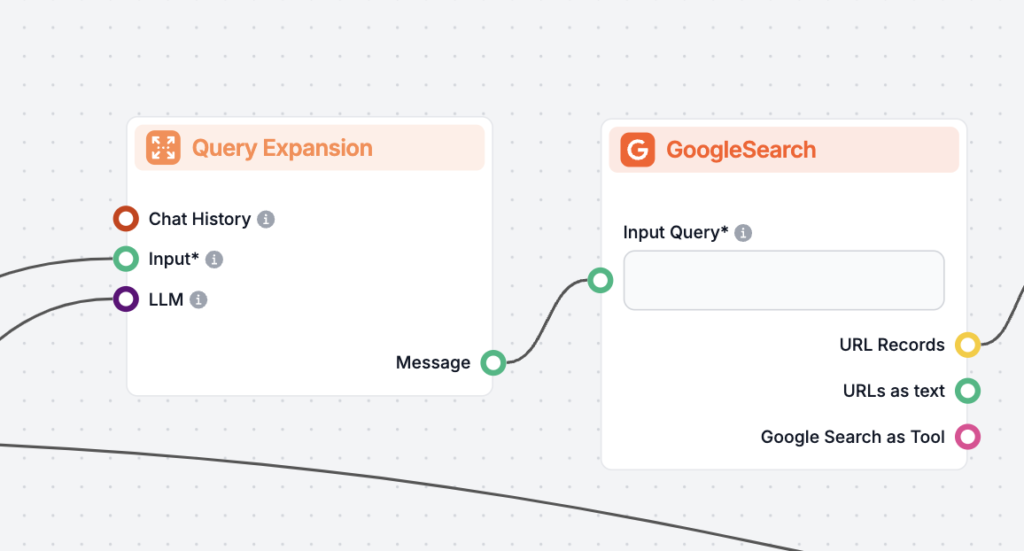

L'Espansione delle Query è il processo di arricchimento della query originale di un utente aggiungendo termini o contesto, migliorando il recupero dei documenti...

Aumenta l'accuratezza dell'IA con RIG! Scopri come creare chatbot che verificano le risposte utilizzando sia fonti di dati personalizzate sia generali per rispo...

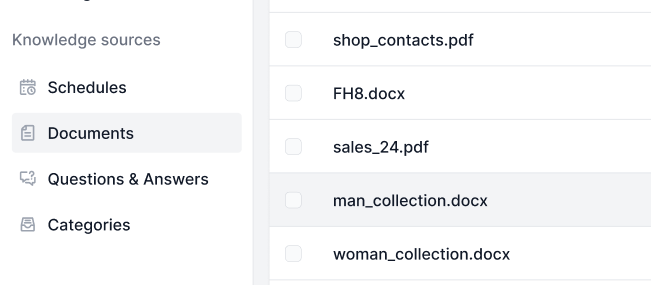

Le Fonti di Conoscenza rendono l'insegnamento dell'AI secondo le tue esigenze un gioco da ragazzi. Scopri tutti i modi per collegare la conoscenza con FlowHunt....

Scopri le principali differenze tra la Generazione Aumentata da Recupero (RAG) e la Generazione Aumentata da Cache (CAG) nell'IA. Scopri come RAG recupera dinam...

LazyGraphRAG è un approccio innovativo alla Retrieval-Augmented Generation (RAG), che ottimizza l'efficienza e riduce i costi nel recupero dei dati guidato dall...

Scopri cos'è una pipeline di recupero per chatbot, i suoi componenti, casi d'uso e come la Retrieval-Augmented Generation (RAG) e fonti di dati esterne consento...

Esplora come le avanzate capacità di ragionamento e l'apprendimento per rinforzo di OpenAI O1 superino GPT4o in accuratezza RAG, con benchmark e analisi dei cos...

Il reranking dei documenti è il processo di riordinamento dei documenti recuperati in base alla loro rilevanza rispetto alla query di un utente, affinando i ris...

La Retrieval Augmented Generation (RAG) è un framework AI avanzato che combina i tradizionali sistemi di recupero delle informazioni con modelli generativi di l...

La Risposta alle Domande con la Retrieval-Augmented Generation (RAG) combina il recupero delle informazioni e la generazione di linguaggio naturale per potenzia...

La valutazione dei documenti nella Retrieval-Augmented Generation (RAG) è il processo di valutazione e classificazione dei documenti in base alla loro rilevanza...