ツールコーリングエージェント

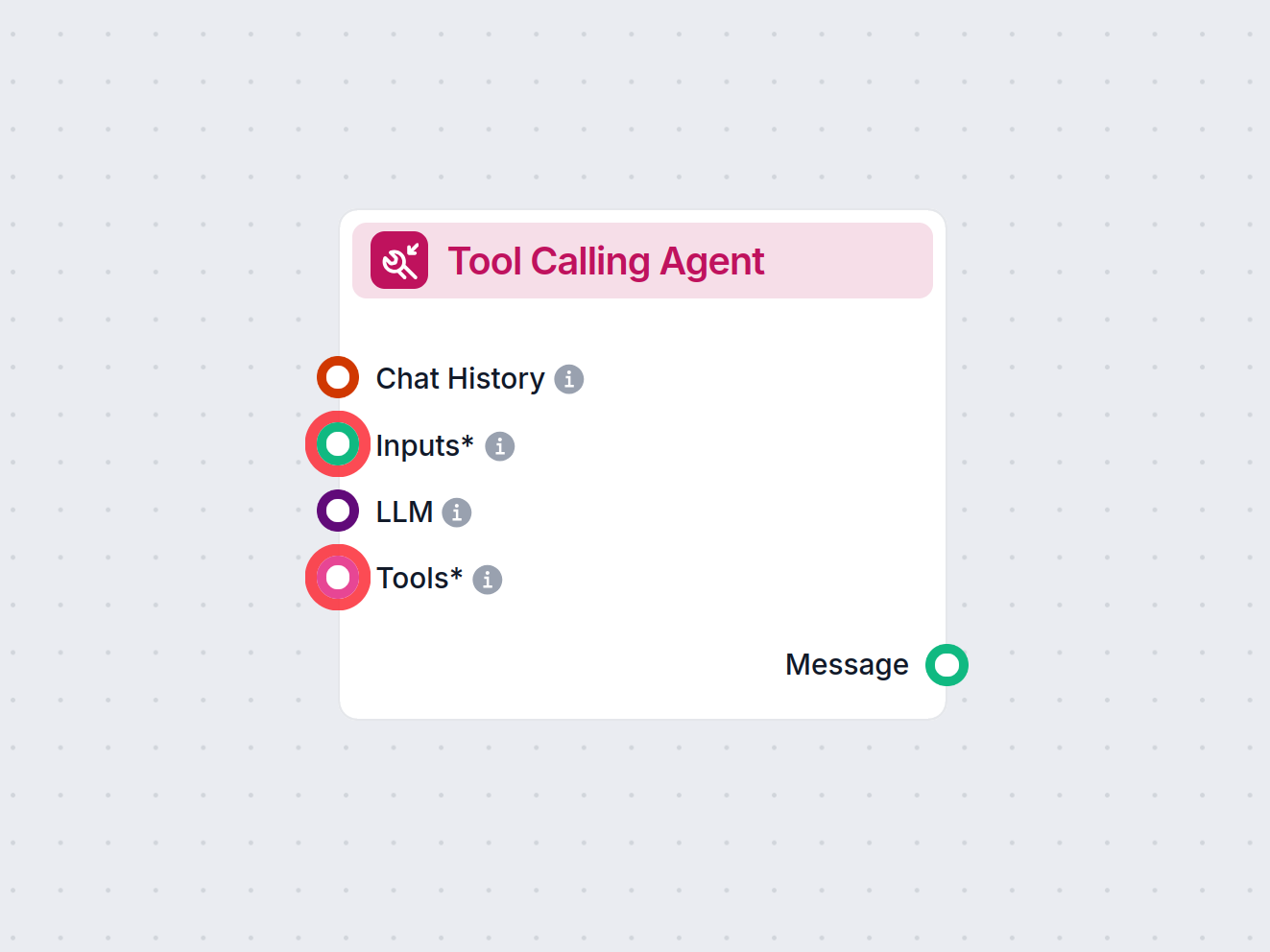

FlowHunt のツールコーリングエージェントは、AIエージェントが複雑なクエリに答えるために外部ツールを知的に選択し利用できる高度なワークフローコンポーネントです。動的なツール使用、反復的な推論、複数リソースとの統合が必要なスマートAIソリューションの構築に最適です。...

堅牢でスケーラブルなAIエージェントを構築するための12の要素を紹介:自然言語変換やプロンプトの所有から、人間との協働やステートレス設計まで。本番運用に耐えるAIシステムで実際のビジネス価値を実現します。

本題に入る前に、「AIエージェント」とは何かを明確にしましょう。AIエージェントとは、自然言語によるリクエストを解釈し、コンテキストに基づいて意思決定を行い、ツールやAPIを通じて特定のアクションを実行できるシステムです。さらに、首尾一貫したやりとりを継続できる能力も備えています。

最も強力なエージェントは、言語モデルの推論力と決定論的コードの信頼性を組み合わせています。しかし、そのバランスを取るためには慎重な設計判断が必要であり、それこそがここで紹介する「ファクター」の役割です。

自然言語リクエストを構造化されたツールコールへ変換する能力は、エージェント機能の中核です。たとえば「2月のAI TinkerersミートアップでTerriへ750ドルの支払いリンクを作成して」といった単純な指示も、適切なAPIコールに変換できます。

{

"function": {

"name": "create_payment_link",

"parameters": {

"amount": 750,

"customer": "cust_128934ddasf9",

"product": "prod_8675309",

"price": "prc_09874329fds",

"quantity": 1,

"memo": "Hey Jeff - see below for the payment link for the February AI Tinkerers meetup"

}

}

}

この仕組みを確実に実行するには、言語モデルからの構造化出力を決定論的なコードで処理することが重要です。APIペイロードは必ず実行前に検証し、LLMから一貫したJSON形式が返るように設計しましょう。

プロンプトはアプリケーションとLLMのインターフェースであり、一級コードとして扱うべきです。プロンプトを抽象化するフレームワークは便利に見えますが、多くの場合LLMへの指示内容が不透明になり、微調整が難しくなります。

その代わりに、プロンプトを明示的に自分で記述し直接管理しましょう:

function DetermineNextStep(thread: string) -> DoneForNow | ListGitTags | DeployBackend | DeployFrontend | RequestMoreInformation {

prompt #"

{{ _.role("system") }}

あなたはフロントエンドおよびバックエンドのデプロイ管理を行う有能なアシスタントです。

...

{{ _.role("user") }}

{{ thread }}

次のステップは何ですか?

"#

}

このアプローチの利点:

コンテキストウィンドウはLLMの入力として機能し、プロンプト・会話履歴・外部データを含みます。このウィンドウを最適化することで性能やトークン効率が向上します。

標準的なメッセージ形式から一歩進み、情報密度の高いカスタム構造にしましょう:

<slack_message>

From: @alex

Channel: #deployments

Text: Can you deploy the backend?

</slack_message>

<list_git_tags>

intent: "list_git_tags"

</list_git_tags>

<list_git_tags_result>

tags:

- name: "v1.2.3"

commit: "abc123"

date: "2024-03-15T10:00:00Z"

</list_git_tags_result>

この方法のメリット:

ツールの本質は「LLMから得たJSON出力をトリガーとして、コード側で決定論的なアクションを実行する」ことです。これによりAIの意思決定と実行ロジックを明確に分離できます。

ツールスキーマを明確に定義:

class CreateIssue {

intent: "create_issue";

issue: {

title: string;

description: string;

team_id: string;

assignee_id: string;

};

}

class SearchIssues {

intent: "search_issues";

query: string;

what_youre_looking_for: string;

}

LLMのJSON出力を確実にパースし、決定論的なコードでアクションを実行、そして結果をコンテキストにフィードバックして反復ワークフローを実現します。

多くのエージェントフレームワークは「実行状態(プロセスの現在のステップなど)」と「ビジネス状態(ツールコール履歴や結果)」を分離しますが、これは不要な複雑さをもたらします。

すべての状態をコンテキストウィンドウ内に保存し、イベントの時系列から実行状態を推論しましょう:

<deploy_backend>

intent: "deploy_backend"

tag: "v1.2.3"

environment: "production"

</deploy_backend>

<error>

error running deploy_backend: Failed to connect to deployment service

</error>

この統合アプローチの利点:

本番運用レベルのエージェントは、外部システムとシームレスに統合し、長時間タスクの一時停止やWebhooksなどのイベントでの再開が必要です。

エージェントの起動・一時停止・再開を可能にするAPIを実装し、各操作間で堅牢に状態保存しましょう。これにより:

AIエージェントは重要な意思決定や曖昧な状況で人間の入力が必要です。構造化ツールコールを使えば、このやり取りもシームレスに:

class RequestHumanInput {

intent: "request_human_input";

question: string;

context: string;

options: {

urgency: "low" | "medium" | "high";

format: "free_text" | "yes_no" | "multiple_choice";

choices: string[];

};

}

この設計で、やり取りの種類や緊急度を明確に指定でき、複数ユーザーからの入力もサポート。APIと組み合わせて耐障害性の高いワークフローを実現します。

カスタム制御フローにより、人間の承認待ちで一時停止したり、結果をキャッシュしたり、レート制限を実装するなど、用途に合わせてエージェントの挙動を最適化できます。

async function handleNextStep(thread: Thread) {

while (true) {

const nextStep = await determineNextStep(threadToPrompt(thread));

if (nextStep.intent === 'request_clarification') {

await sendMessageToHuman(nextStep);

await db.saveThread(thread);

break;

} else if (nextStep.intent === 'fetch_open_issues') {

const issues = await linearClient.issues();

thread.events.push({ type: 'fetch_open_issues_result', data: issues });

continue;

}

}

}

このアプローチで得られること:

エラーをコンテキストウィンドウに直接含めることで、AIエージェントは失敗から学び、対応を調整できます:

try {

const result = await handleNextStep(thread, nextStep);

thread.events.push({ type: `${nextStep.intent}_result`, data: result });

} catch (e) {

thread.events.push({ type: 'error', data: formatError(e) });

}

この仕組みを有効にするには:

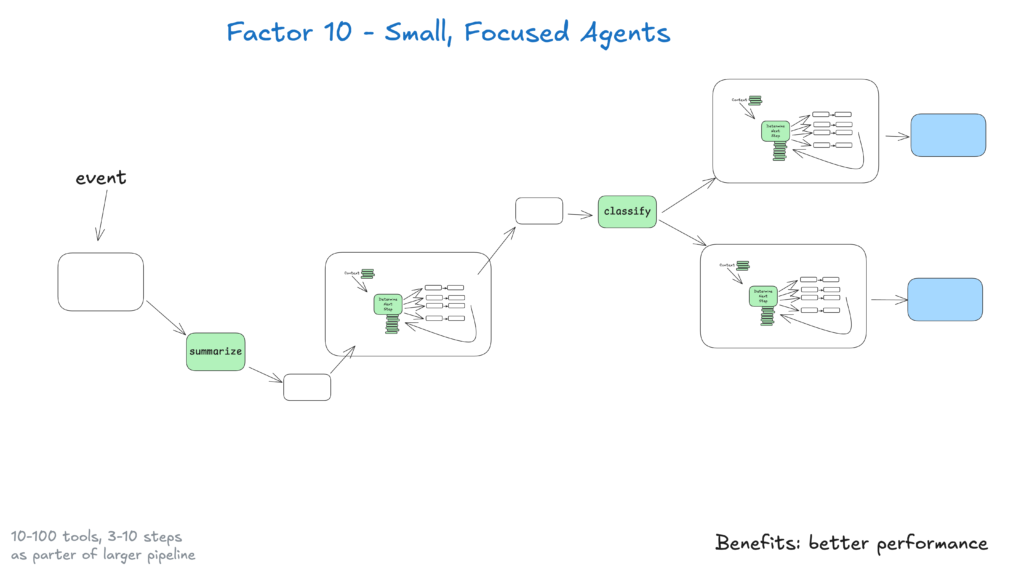

3~20ステップ程度の小さなエージェントはコンテキストウィンドウも管理しやすく、LLMの性能・信頼性が向上します。

今後LLMの進化により、こうした小さなエージェントもスコープを拡大しつつ品質を維持し、長期的なスケーラビリティを確保できます。

Slack、メール、イベントシステムなど、さまざまなチャネルからエージェントを起動できるようにし、ユーザーが普段使う場所でアクセス可能にしましょう。

各チャネルからエージェントを起動し、同じ媒体でレスポンスするAPIを実装。これにより:

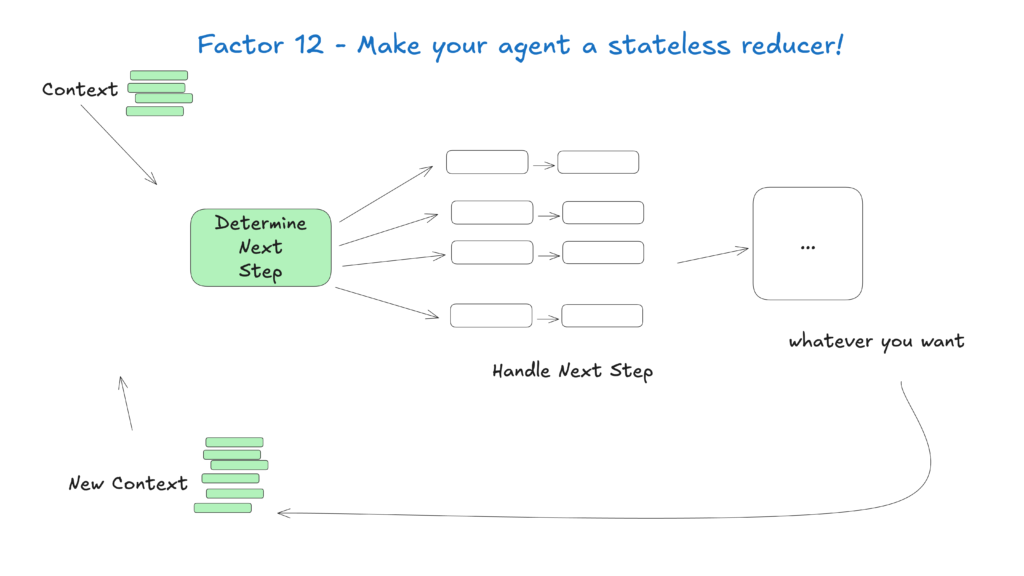

エージェントを「入力コンテキストを出力アクションへ変換するステートレスな関数」として扱うことで、状態管理がシンプルになり、予測可能性・デバッグ容易性が向上します。

この考え方では、エージェントは内部状態を保持せず純粋関数として動作し、次のメリットが得られます:

AIエージェント分野は急速に進化していますが、これらの基本原則は今後も有効です。まずは小さくフォーカスしたエージェントで着実に価値を提供しつつ、将来の進化にも適応できるシステムを目指しましょう。

最も効果的なAIエージェントは、言語モデルの推論力と決定論的コードの信頼性の両立により実現します。この12ファクターが、そのバランスを取るための指針となります。

FlowHuntでは、これらの原則を実践し、顧客向けのワークフロー自動化を自動生成するAIエージェントを開発しました。信頼性が高く本番運用に耐えるシステムを構築するため、12ファクター手法をどのように適用したかをご紹介します。

12ファクターAIエージェント手法は、12ファクターアプリモデルに着想を得たベストプラクティスのセットであり、開発者が堅牢で保守性・拡張性に優れ、実際の本番環境でも信頼性高く動作するAIエージェントを構築するための指針です。

コンテキスト管理により、AIエージェントは関連する会話履歴・プロンプト・ステートを維持でき、パフォーマンス最適化やトークン消費削減、意思決定の精度向上が実現します。

FlowHuntのAIエージェントは、必要に応じて人間の入力をリクエストするようにツールコールを構造化し、複雑または重要なシナリオでも円滑な協働・承認・耐障害性の高いワークフローを実現します。

ステートレスなAIエージェントは、予測可能でデバッグが容易かつスケールもしやすいです。これは、隠れた内部状態を持たず、入力コンテキストを出力アクションへ変換する設計だからです。

アルシアはFlowHuntのAIワークフローエンジニアです。コンピュータサイエンスのバックグラウンドとAIへの情熱を持ち、AIツールを日常業務に統合して効率的なワークフローを作り出し、生産性と創造性を高めることを専門としています。

FlowHunt のツールコーリングエージェントは、AIエージェントが複雑なクエリに答えるために外部ツールを知的に選択し利用できる高度なワークフローコンポーネントです。動的なツール使用、反復的な推論、複数リソースとの統合が必要なスマートAIソリューションの構築に最適です。...

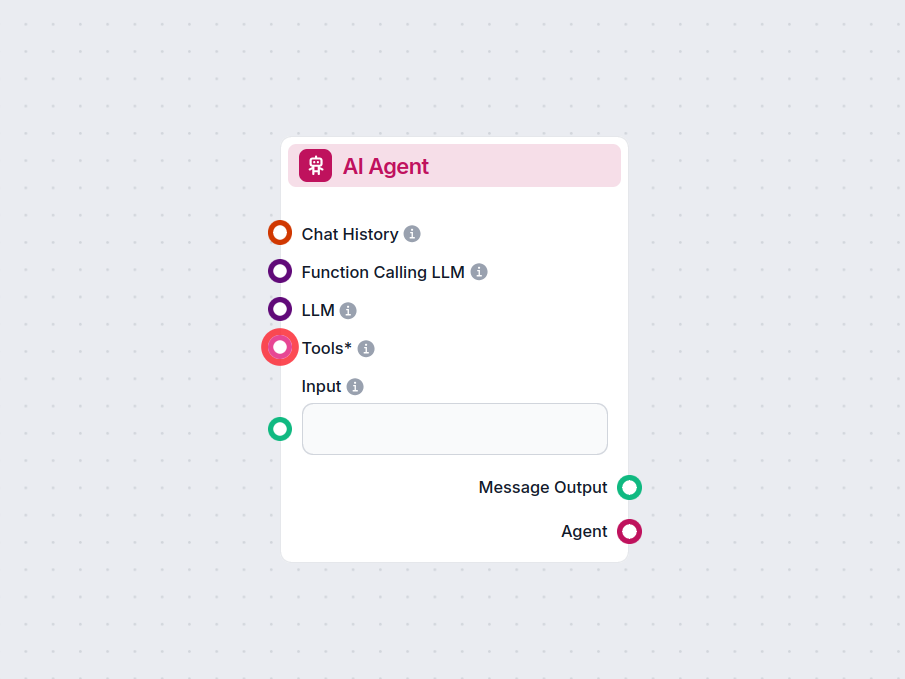

FlowHuntのAIエージェントコンポーネントは、ワークフローに自律的な意思決定とツール使用の能力を与えます。大規模言語モデルを活用し、さまざまなツールと連携してタスクを解決し、目標を達成し、知的な応答を提供します。高度な自動化や対話型AIソリューションの構築に最適です。...

エージェンティックAIは、高度な人工知能の分野であり、システムが自律的に行動し、意思決定を行い、最小限の人間の監督で複雑なタスクを達成できるようにします。従来のAIとは異なり、エージェンティックシステムはデータを分析し、動的な環境に適応し、自律的かつ効率的に複数のステップを実行します。...