企業におけるAIの誤用:それは従業員の問題ではなく、リーダーシップの危機だ

職場でのAIの誤用は従業員の問題ではなく、リーダーシップの危機です。従業員がなぜAIツールを秘密裏に使うのか、そのリスク、そしてリーダーがAIの可能性を最大限に引き出すために必要なポリシー・トレーニング・信頼の構築について解説します。...

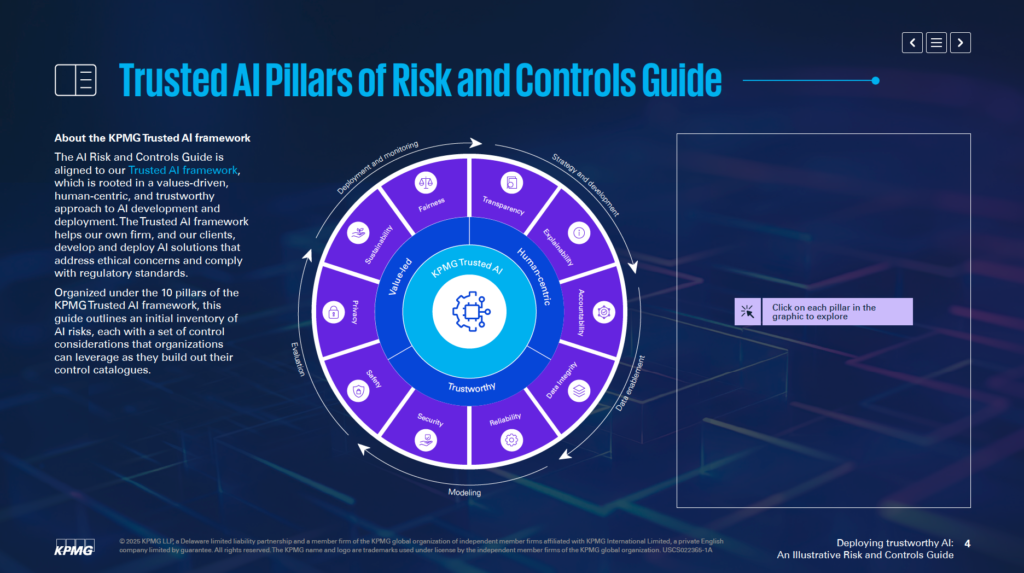

KPMGのAIリスクおよびコントロールガイドは、組織に構造化された倫理的なAIリスク管理アプローチを提供し、責任ある導入とグローバルスタンダードへの準拠を支援します。

この最初の統計は昨年のものかもしれませんが、今まさに重要性が高まっています。KPMGの2024年米国CEOアウトルックによれば、68%のCEOがAIを最優先投資分野に挙げています。経営者たちはAIによる効率化、従業員スキルアップ、イノベーション創出に大きな期待を寄せているのです。

AIへの大きな信頼の表れですが、それだけに重要な疑問も浮かびます。「AIの利用を、いかに責任を持って倫理的に進めるか?」

そこで登場するのがKPMGのAIリスクおよびコントロールガイドです。このガイドは、AIの可能性を最大限に活かしつつ、現実的なリスクにも対処できる明確かつ実践的なフレームワークを提供します。今や信頼できるAIの構築は、単なる良い取り組みではなく、ビジネスの必須要件なのです。

人工知能(AI)は産業界に革命をもたらし、効率性・革新性・競争力の新たな次元を切り開いています。しかし同時に、AIの導入には独自のリスクや倫理的課題が伴い、信頼維持と責任ある活用のために慎重な管理が不可欠です。KPMGのAIリスクおよびコントロールガイドは、こうした複雑さを乗り越えるための実践的・構造的・価値観主導のAIガバナンスアプローチを提供します。

KPMGのTrusted AIフレームワークと整合し、グローバル規制基準に準拠した倫理的・人間中心のAIソリューション開発・導入を支援。10の基本的柱を軸に、AIリスク管理の重要側面を網羅しています。

これらの柱に注力することで、組織はAIライフサイクルのあらゆる段階――戦略策定から開発、導入、モニタリングに至るまで――で倫理的価値観を組み込むことができます。本ガイドはリスク耐性を高めるだけでなく、持続的かつ信頼され、社会的期待に沿ったイノベーション促進にもつながります。

リスク専門家、経営リーダー、データサイエンティスト、法務アドバイザーなど、どなたにとっても、責任あるAI活用に不可欠なツールと洞察を提供します。

KPMGのAIリスクおよびコントロールガイドは、人工知能(AI)に起因する特有リスクの管理を目的とした専門リソースです。AIには大きな可能性がある一方、その複雑性と倫理的懸念はリスク管理への特化したアプローチを必要とします。本ガイドは、こうした課題に責任を持って効果的に対処できる構造的フレームワークを提供します。

本ガイドは、既存のシステムを置き換えるものではなく、現行のリスク管理プロセスを補完するよう設計されています。主な目的は、AI特有の観点を組織のガバナンス構造に組み込み、現在の運用実務と円滑に連動させること。これによりフレームワークの抜本的見直しをせずとも、リスク管理能力を強化できます。

ガイドはKPMGのTrusted AIフレームワークに基づいており、価値観主導かつ人間中心のAIアプローチを推進します。ISO 42001、NIST AIリスク管理フレームワーク、EU AI法など、広く認められた基準の原則を取り入れ、実践的かつグローバルに通用するAIガバナンスのベストプラクティス・規制要件にも整合しています。

本ガイドは、AIリスクへの具体的な提案や実践例を提供します。AIシステムが社内開発かベンダー調達か、データ種別や技術に応じて柔軟に適用できるよう工夫されています。こうした適応性により、幅広い業界・AI用途にも有用です。

本ガイドは、組織が安全・倫理的で透明性の高いAI技術を導入できるよう支援します。技術的・運用的・倫理的側面のリスクに対応し、利害関係者の信頼構築とAIの変革力活用を両立します。

AIシステムがビジネス目標と整合しつつ、リスクを低減できるよう、リソースとして活用可能です。イノベーションを推進しつつ、アカウンタビリティと責任を最優先します。

KPMGのAIガバナンスガイドは、安全・倫理的・効果的なAI導入を担うあらゆる専門家向けです。組織内の各分野――

CEOやCIO、CTOなど経営層にとっても、AIを戦略優先事項として管理するのに有用です。KPMGの2024年米国CEOアウトルックによれば、68%のCEOがAIを主要投資分野としています。ガイドは、組織目標に沿ったAI戦略の策定とリスク対応を後押しします。

ソフトウェアエンジニアやデータサイエンティストなど、AI開発・導入を担う担当者は、本ガイドを活用して倫理的原則や堅牢なコントロールをシステムに直接組み込めます。AIモデルの設計やデータフローに応じてリスク管理手法を適用することに重点を置きます。

社内開発・ベンダー調達・独自データ活用など、さまざまなAI導入形態にも対応可能。金融、医療、テクノロジーなど、先進AIと機微データが事業の要となる業界にも特に有用です。

明確なガバナンスフレームワークなしにAIを導入すると、財務・規制・評判リスクが生じます。KPMGガイドは既存プロセスと連動し、構造化された倫理的AIリスク管理アプローチを提供。アカウンタビリティ、透明性、倫理的実践の促進を通じ、AIの可能性を責任もって活用できます。

まずはAI特有のリスクを、組織の既存リスク分類(リスクタクソノミー)と紐付けましょう。リスクタクソノミーとは、潜在的脆弱性を体系的に特定・管理する枠組みです。AIには独自課題があるため、従来の分類にデータフロー精度やアルゴリズムの論理性、データソースの信頼性といったAI特有観点を追加する必要があります。こうすることで、AIリスクも全社リスク管理の一環として効果的に対処できます。

本ガイドでは、AIシステムのライフサイクル全体の評価が重要と指摘しています。データの発生源、プロセス内での流れ、AIモデルの基盤論理などを広範囲に見直すことで、開発・活用段階での脆弱性を正確に洗い出せます。

AIシステムは、目的や開発手法、データの種類によって異なります。社内開発か外部調達かによってもリスクは大きく変化。独自データ、公開データ、機微データなど、活用データの違いや構築技術に合わせリスク管理戦略も最適化が必要です。

ガイドは、AIシステムごとの特性に合わせてコントロール策のカスタマイズを推奨しています。たとえば独自データを活用する場合は厳格なアクセス制御、ベンダーAIシステム活用時はサードパーティリスク評価の徹底など。こうした個別最適化で、AI特有の課題に的確に対応できます。

ガイドでは、設計段階から運用中のモニタリング・定期的な評価更新まで、AIライフサイクルすべての段階でリスク管理を組み込むことを推奨。各段階でリスクを見直すことで、脆弱性を低減し、倫理的かつ信頼できるAIシステムを維持できます。

AIリスクを既存リスク分類と連携し、組織ニーズに合わせたコントロールを設計することで、信頼できるAI基盤を構築できます。これにより、リスクの体系的な特定・評価・管理が可能となり、強固なAIガバナンス体制が実現します。

KPMG Trusted AIフレームワークは、倫理的・技術的・運用的なAI課題に対応する10の柱で構成されています。これらはAIシステムの設計・開発・導入における指針となり、AIライフサイクル全体での信頼性と責任ある運用を実現します。

AIライフサイクルの各段階で人間の監督と責任が必要です。誰がAIリスク管理や法令遵守を担うかを明確化し、必要に応じて意思決定の介入や是正・取消しも可能な体制を確立します。

AIシステムは、個人やコミュニティ、集団への不当なバイアスを低減・排除することを目指すべきです。多様な人口を反映したデータ選定、公平性を担保した開発、結果の継続的監視による公正な取り扱いを推進します。

AIシステムの仕組みや意思決定理由を積極的に公開し共有することが求められます。システムの制限、性能、テスト手法を明確化し、データ収集時のユーザーへの通知やAI生成コンテンツの明示、バイオメトリクスなど機微分野での明確な説明も含みます。

AIシステムは意思決定の理由を理解可能に示す必要があります。データセットやアルゴリズム、性能指標を詳細に記録し、関係者が分析・再現できるようにします。

データの収集・ラベリング・保管・分析といったライフサイクル全体での品質と信頼性が不可欠です。データの破損やバイアスなどのリスクに対処するコントロールを設け、品質チェックや回帰テストを定期的に実施します。

AIソリューションはプライバシー・データ保護法の遵守が必須。データ主体からの請求対応、プライバシー影響評価、差分プライバシーのような先進的手法で、データ有用性と個人プライバシー保護の両立を図ります。

AIシステムは、意図した目的と求められる精度で一貫して動作すべきです。十分なテスト、異常検知メカニズム、フィードバックループによる出力検証を確立します。

AIシステムが人・組織・財産に損害を与えないよう、安全設計やフェールセーフ、データポイズニングやプロンプトインジェクション攻撃などへの監視体制を構築し、倫理・運用基準を遵守します。

AIシステムへの脅威や悪意ある行為から守るため、定期的な監査、脆弱性評価、暗号化など強固なセキュリティ対策を講じます。

AIシステムの設計段階からエネルギー消費や環境目標への配慮を組み込み、ライフサイクル全体でエネルギー効率や排出量を継続的に監視します。

これら10の柱を実践することで、組織は倫理的・信頼性の高いAIシステムを構築できます。本フレームワークは、AIの課題管理と責任あるイノベーション推進の明確な指針となります。

データ完全性は、AIシステムの正確性・公平性・信頼性を保つ上で極めて重要です。データ管理が不十分だと、バイアス・不正確・不安定といったリスクが発生し、AI出力への信頼が損なわれ、大きな運用・評判リスクにもつながります。KPMG Trusted AIフレームワークは、AIシステムの効果的な運用と倫理基準担保のため、データライフサイクル全体での高品質維持を強調しています。

強固なデータガバナンスがなければ、AIシステムは不正確な結果を生み出す恐れがあります。不完全・不正確・関連性のないデータは、バイアスや不安定な出力を引き起こし、さまざまなAI用途でリスクを増大させます。

AI開発・運用ではデータが複数システム間で頻繁に移動します。転送時の管理が不十分だと、データ破損・消失・劣化が発生し、AIシステムの性能に影響します。

データガバナンス強化のために、以下を推奨します:

データ転送時のリスク低減には、以下の対策が有効です:

継続的なモニタリングシステムを活用すると、AIライフサイクル全体でデータ完全性を維持できます。データセット品質の想定外変動や処理の不整合を検知し、問題発生時は迅速に是正措置を取ることが可能です。

信頼できるAIシステム導入には、データ完全性の維持が不可欠です。強固なガバナンスフレームワーク構築、データ連携の保護、継続的な検証体制により、AI出力の信頼性・倫理性・運用基準を確保し、AI技術への信頼を醸成できます。

データ主体からのアクセス請求対応は、AIにおける大きなプライバシー課題です。組織は、GDPRやCCPAなどの法律のもと、個人が自身の情報へのアクセス・訂正・削除を行えるよう保証しなければなりません。不適切な対応は法令違反・消費者信頼の喪失・企業評判毀損につながります。

このリスク低減には、AI利用時に個人へデータ権利を教育するプログラムの整備が有効です。請求対応の迅速・透明な体制構築、処理記録の詳細な保存で、監査時のコンプライアンス証明も可能となります。

AIシステムはしばしば機微な個人情報を扱うため、サイバー攻撃の標的となりやすいです。漏洩時には多額の規制罰金や信頼失墜、顧客離れのリスクが生じます。

KPMG Trusted AIフレームワークでは、個人データを活用するAIシステムの倫理審査やプライバシー規制順守の徹底を推奨。定期的なデータ保護監査・プライバシー影響評価(PIA)も不可欠です。AIモデル訓練のような機微データ利用時は特に重要。差分プライバシーなど統計的ノイズ付与手法で匿名性を確保しつつ分析可能です。

開発段階からプライバシー配慮がなければ、重大な問題が発生します。プライバシー・バイ・デザイン原則の未適用は、機微データ露出や法令違反リスクを高めます。

AI開発初期から明確なプライバシー対策を講じましょう。プライバシー法・データ保護規制を遵守し、厳格なデータ管理実践が重要です。データ収集・利用・保管の詳細な記録を残し、バイオメトリクスなど機微領域では明示的なユーザー同意取得も必須です。

AIシステムがユーザーデータの扱いを明示しない場合、不信や法的監視を招く恐れがあります。ユーザーは自身のデータがいつ収集され、どのように使用されるかを知るべきです

KPMGのAIリスクおよびコントロールガイドは、AI特有のリスクを管理するために設計された実践的フレームワークであり、責任ある倫理的かつコンプライアンスに則ったAI導入を業界横断で実現します。

ガイドは10の主要な柱で構成されています:アカウンタビリティ、公平性、透明性、説明性、データ完全性、信頼性、セキュリティ、安全性、プライバシー、サステナビリティ――それぞれがAIリスク管理の重要側面をカバーしています。

本ガイドは、リスク専門家、コンプライアンスチーム、サイバーセキュリティ担当、法務アドバイザー、経営層、AI開発者、エンジニア、そしてAIを責任もって管理したいあらゆる規模の組織を対象としています。

ISO 42001、NIST AIリスク管理フレームワーク、EU AI法などのグローバルスタンダードと整合し、AI特有のコントロールを既存のガバナンスプロセスに組み込み、規制要件の遵守をサポートします。

強力なデータガバナンス、プライバシー・バイ・デザイン、継続的モニタリング、AI意思決定の透明性、異常検知、フィードバックループ、サステナビリティ目標など、AIリスク低減につながる具体策を提案しています。

職場でのAIの誤用は従業員の問題ではなく、リーダーシップの危機です。従業員がなぜAIツールを秘密裏に使うのか、そのリスク、そしてリーダーがAIの可能性を最大限に引き出すために必要なポリシー・トレーニング・信頼の構築について解説します。...

欧州AI法がチャットボットにどのような影響を及ぼすのかを解説。リスク分類、コンプライアンス要件、期限、不遵守時の罰則などを詳しく紹介し、倫理的で透明性と安全性の高いAI対話を実現するための情報をお届けします。...

ビジネスリーダーが責任あるAIガバナンス、リスク低減、コンプライアンス、そして企業AIシステムへの信頼構築のためにHuman-in-the-Loop(HITL)フレームワークを導入するための実践的なガイド。...