json2video-mcp

FlowHuntをjson2video-mcpサーバーと統合することで、プログラムによる動画生成の自動化、カスタムテンプレートの管理、柔軟かつ安全なAPIを通じたエージェント・LLM・自動化ツールとの動画ワークフロー接続が可能になります。...

Wan 2.1はAlibabaが開発した強力なオープンソースAI動画生成モデルで、テキストや画像からスタジオ品質の動画を誰でもローカルで無料生成できます。

Wan 2.1(WanX 2.1とも呼ばれる)は、AlibabaのTongyi Labによって開発された完全オープンソースのAI動画生成モデルとして新たな地平を切り拓いています。多くの有料・API限定の動画生成システムとは異なり、Wan 2.1は同等またはそれ以上の品質を無償で提供し、開発者・研究者・クリエイティブなプロフェッショナルに広く開放されています。

Wan 2.1が特に優れているのは、手軽さと性能の両立です。小型のT2V-1.3Bバリアントは約8.2GBのGPUメモリで動作し、ほとんどの一般的なGPUで利用可能です。一方、大規模な14Bパラメータ版は、オープンソース・商用問わず従来モデルをベンチマークで凌駕する最先端のパフォーマンスを発揮します。

Wan 2.1はテキストから動画生成だけではありません。柔軟なアーキテクチャにより、以下をサポートします:

この柔軟性により、テキストプロンプト・静止画像・既存動画など、どこからでも自由な発想で変換が可能です。

Wan 2.1は、生成した動画内に読みやすい英語と中国語のテキストを描画できる初の動画モデルとして、国際的なクリエイターに新たな可能性をもたらします。特に多言語動画の字幕やシーンテキスト生成に重宝します。

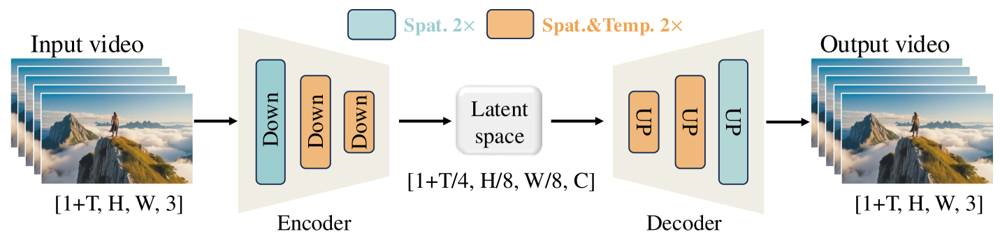

Wan 2.1の効率性の核となるのが、3D因果型Video Variational Autoencoderです。この技術的ブレークスルーにより、空間・時間情報を効率的に圧縮し、以下を実現します:

小型1.3Bモデルは8.19GBのVRAMで動作し、RTX 4090なら約4分で5秒間・480pの動画を生成できます。これほどの効率性でありながら、遥かに大型のモデルと同等かそれ以上の品質を実現し、スピードと画質の理想的なバランスを実現しています。

公開評価では、Wan 14BがWan-Benchテストで総合最高スコアを記録し、以下の項目で競合を上回りました:

OpenAIのSoraやRunwayのGen-2などのクローズドソースシステムとは異なり、Wan 2.1はローカルで自由に利用可能です。従来のオープンソースモデル(CogVideo, MAKE-A-VIDEO, Pikaなど)はもちろん、多くの商用ソリューションとも品質面で肩を並べるか上回っています。

最近の業界調査では「多くのAI動画モデルの中で、Wan 2.1とSoraが際立っている」と評価されています。Wan 2.1はオープン性と効率性、Soraは独自性で際立ちます。コミュニティによるテストでも、Wan 2.1の画像から動画生成は他モデルよりも鮮明さや映画的な表現で高評価を得ています。

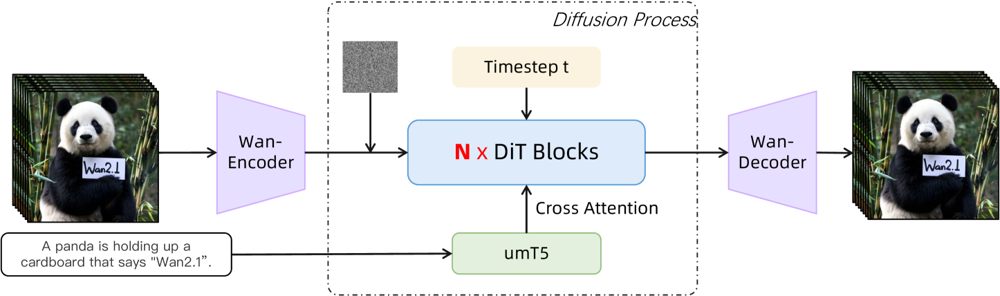

Wan 2.1は拡散トランスフォーマーのバックボーンと新しい時空間VAEを組み合わせています。仕組みは次の通りです:

図: Wan 2.1の高レベルアーキテクチャ(テキストから動画の場合)。動画(または画像)はまずWan-VAEエンコーダで潜在表現に変換されます。この潜在表現はN個の拡散トランスフォーマーブロックを通り、テキスト埋め込み(umT5から)にクロスアテンションします。最後にWan-VAEデコーダが動画フレームを再構築します。この「3D因果VAEエンコーダ/デコーダが拡散トランスフォーマーを囲む」設計(ar5iv.org)により、時空間データを効率よく圧縮し、高品質な動画出力を実現しています。

この革新的なアーキテクチャ―「3D因果VAEエンコーダ/デコーダで拡散トランスフォーマーを囲む」―は、時空間データの効率的な圧縮と高品質な動画出力を両立します。

Wan-VAEは動画専用に設計されており、入力動画を(時間方向4倍+空間方向8倍=)大幅に圧縮した潜在表現に変換し、再度フル動画にデコードします。3D畳み込みと因果(時系列維持)層により、一貫した動きのある生成が可能です。

図: Wan 2.1のWan-VAEフレームワーク(エンコーダ・デコーダ)。Wan-VAEエンコーダ(左)は入力動画(形状 [1+T, H, W, 3] フレーム)に一連のダウンサンプリング層(“Down”)を適用し、コンパクトな潜在表現([1+T/4, H/8, W/8, C])に変換します。Wan-VAEデコーダ(右)は対称的にこの潜在表現をアップサンプリング(“UP”)し、元の動画フレームへ戻します。青ブロックは空間圧縮、オレンジブロックは空間+時間圧縮を示します(ar5iv.org)。動画を時空間で256分の1に圧縮することで、Wan-VAEは後続の拡散モデルで高解像度動画生成を現実的にしています。

Wan 2.1を実際に触ってみたい方のために、導入方法を解説します。

リポジトリをクローンし、依存関係をインストール:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

モデル重みをダウンロード:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

動画を生成:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "A futuristic city skyline at sunset, with flying cars zooming overhead."

--offload_model True --t5_cpu でモデルの一部をCPUにオフロード可能--size パラメータ(例: 832*480で16:9 480p)でアスペクト比を調整参考までに、RTX 4090なら約4分で5秒間・480pの動画を生成可能です。大規模利用向けにマルチGPUや多様なパフォーマンス最適化(FSDP・量子化等)にも対応しています。

AI動画生成分野で巨人たちに挑むオープンソースの強力な存在として、Wan 2.1はアクセシビリティの概念を大きく変えています。無料・オープンな特性により、十分なGPUさえあれば誰でも最先端の動画生成をサブスクリプションやAPIコストなしで体験できます。

開発者はライセンスのもとモデルを自由にカスタマイズ・改良でき、研究者は機能拡張、クリエイターは迅速かつ効率的に動画制作の試作が行えます。

プロプライエタリAIモデルが有料化・閉鎖化する時代において、Wan 2.1は最先端の性能を民主化し、コミュニティ全体と分かち合えることを証明しています。

Wan 2.1はAlibabaのTongyi Labが開発した完全オープンソースのAI動画生成モデルです。テキストプロンプト・画像・既存の動画から高品質な動画を生成できます。無料で利用でき、複数のタスクに対応し、一般的なGPUでも効率的に動作します。

Wan 2.1はマルチタスク動画生成(テキストから動画、画像から動画、動画編集など)、動画内での多言語テキスト描画、3D因果Video VAEによる高効率、そして多くの商用・オープンソースモデルを上回るベンチマーク性能を誇ります。

Python 3.8以上、CUDA対応PyTorch 2.4.0以上、NVIDIA GPU(小モデルは8GB以上、大モデルは16~24GB VRAM)が必要です。GitHubリポジトリをクローンし、依存関係をインストール、モデル重みをダウンロードし、付属のスクリプトでローカル生成できます。

Wan 2.1は最先端の動画生成をオープンソース・無料で提供することで、開発者・研究者・クリエイターが課金や制約なしに自由に実験・革新できる環境を実現しています。

SoraやRunway Gen-2などのクローズドソースとは異なり、Wan 2.1は完全オープンソースかつローカル実行可能です。従来のオープンソースモデルを概ね上回り、多くの商用ソリューションにも品質面で匹敵または凌駕しています。

アルシアはFlowHuntのAIワークフローエンジニアです。コンピュータサイエンスのバックグラウンドとAIへの情熱を持ち、AIツールを日常業務に統合して効率的なワークフローを作り出し、生産性と創造性を高めることを専門としています。

FlowHuntをjson2video-mcpサーバーと統合することで、プログラムによる動画生成の自動化、カスタムテンプレートの管理、柔軟かつ安全なAPIを通じたエージェント・LLM・自動化ツールとの動画ワークフロー接続が可能になります。...

Gemini Flash 2.0は、強化されたパフォーマンス、スピード、そしてマルチモーダル機能によってAIの新たな基準を確立しています。現実世界での応用可能性を探ってみましょう。...

FlowHunt 2.4.1では、Claude、Grok、Llama、Mistral、DALL-E 3、Stable Diffusionなど、主要な新AIモデルを導入し、AIプロジェクトでの実験・創造・自動化の選択肢を広げます。...