LLM Meta AIコンポーネントとは?

LLM Meta AIコンポーネントは、ClaudeファミリーのモデルをFlowに接続します。実際の生成やエージェント処理はGeneratorsやAgentsで実行されますが、LLMコンポーネントでは使用するモデルをコントロールできます。すべてのコンポーネントはデフォルトでChatGPT-4を搭載しています。モデルを変更したい、またはさらに細かなコントロールを行いたい場合は、このコンポーネントを接続してください。

LLMコンポーネントの接続は任意であることを覚えておいてください。LLMを使用するすべてのコンポーネントにはデフォルトでChatGPT-4oが設定されています。LLMコンポーネントを使うことで、モデルの切り替えやモデル設定の調整ができます。

LLM Meta AIコンポーネントの設定

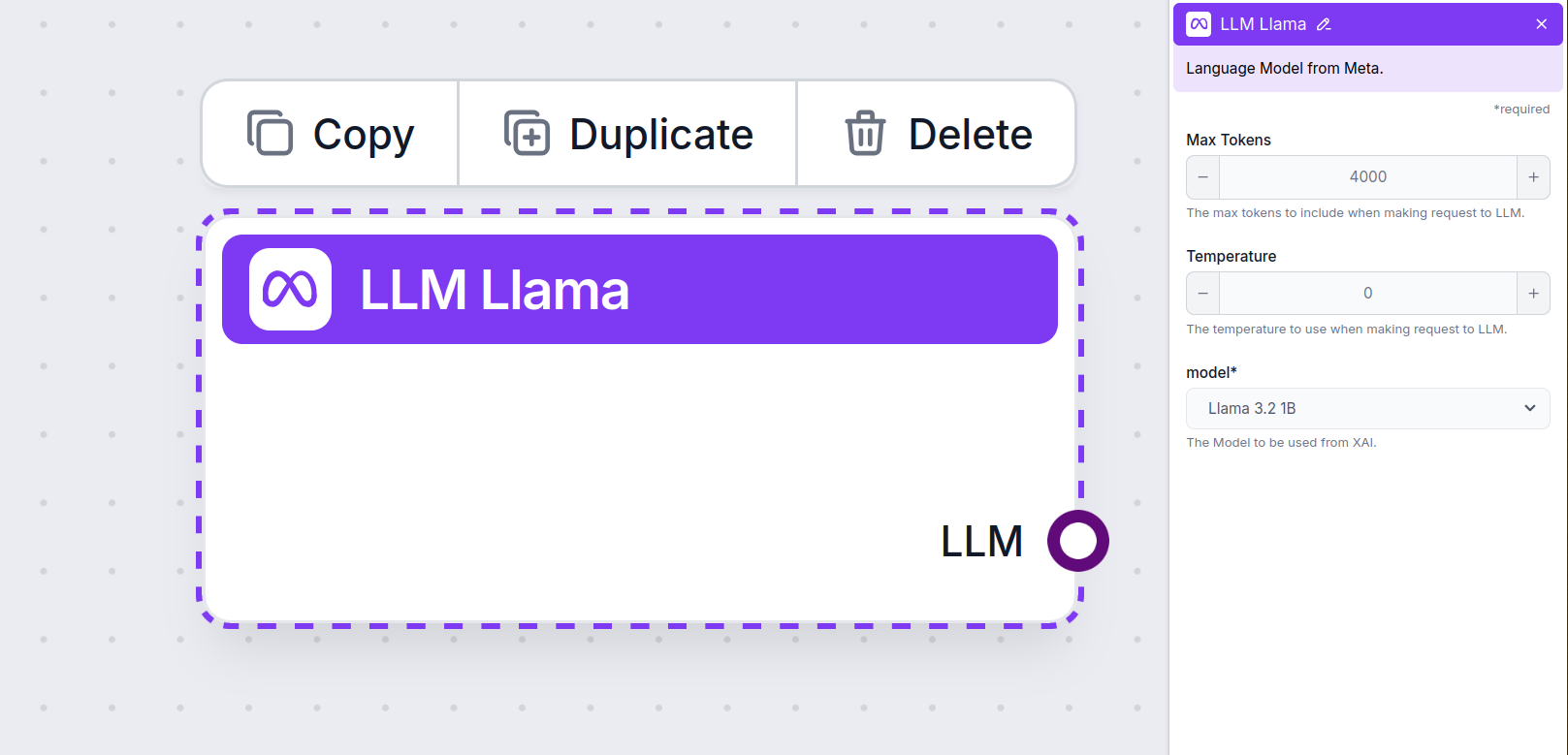

最大トークン数

トークンは、モデルが処理・生成するテキストの最小単位です。モデルごとにトークンのカウント方法は異なり、単語・サブワード・1文字などさまざまです。通常、モデルは数百万トークン単位で価格設定されています。

最大トークン数の設定は、1回の対話やリクエストで処理できるトークン数の上限を制御し、応答が適切な範囲内に収まるようにします。デフォルトでは4,000トークンで、文書や複数ソースの要約などに最適なサイズです。

温度

温度は、応答の多様性(ばらつき)を0から1の範囲で調整します。

0.1の低い温度では、応答が簡潔で一貫性が高くなりますが、繰り返しが多く内容が乏しくなる場合があります。

1の高い温度では、最大限に創造的な応答が得られますが、無関係な内容や幻覚的な回答が生じるリスクも高まります。

例えば、カスタマーサービスボットでは0.2~0.5の温度がおすすめです。この範囲では、スクリプトどおりかつ自然なバリエーションを持たせた応答が期待できます。

モデル

ここがモデル選択欄です。Meta AIがサポートするすべてのモデルが表示されます。Metaのオープンソース軽量Llamaモデルに対応しています。これらはオンデバイス・エッジ用途に最適化されています。

- Llama 3.2 1B – 約12.3億パラメータを持ち、コンテキスト長は最大128,000トークン。要約、指示追従、リライトなどに最適化されており、モバイルや組み込みデバイス利用に適しています。詳細やモデルの思考については関連記事をご覧ください。

- Llama 3.2 3B – 約32.1億パラメータを持ち、コンテキスト長は同じく最大128,000トークン。さまざまなタスクへの対応力については詳細記事で紹介しています。

LLM Meta AIをフローに追加する方法

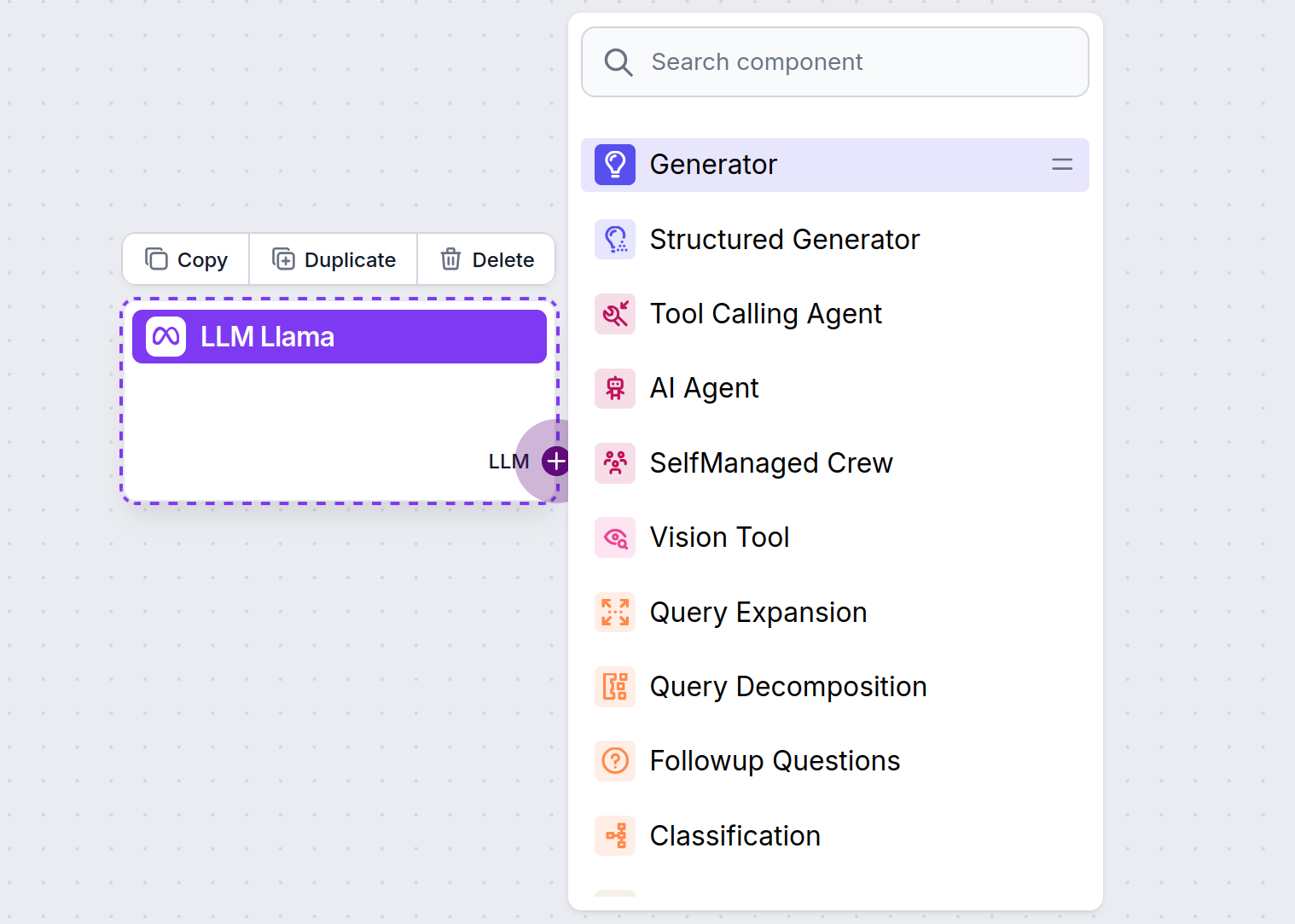

すべてのLLMコンポーネントには出力ハンドルのみがあることに気付くでしょう。入力はこのコンポーネントを通過しません。これはあくまで「モデル」を示し、実際の生成はAIエージェントやジェネレーターで行われます。

LLMハンドルは常に紫色です。LLM入力ハンドルは、テキスト生成やデータ処理にAIを使うコンポーネントすべてにあります。ハンドルをクリックするとオプションが表示されます。

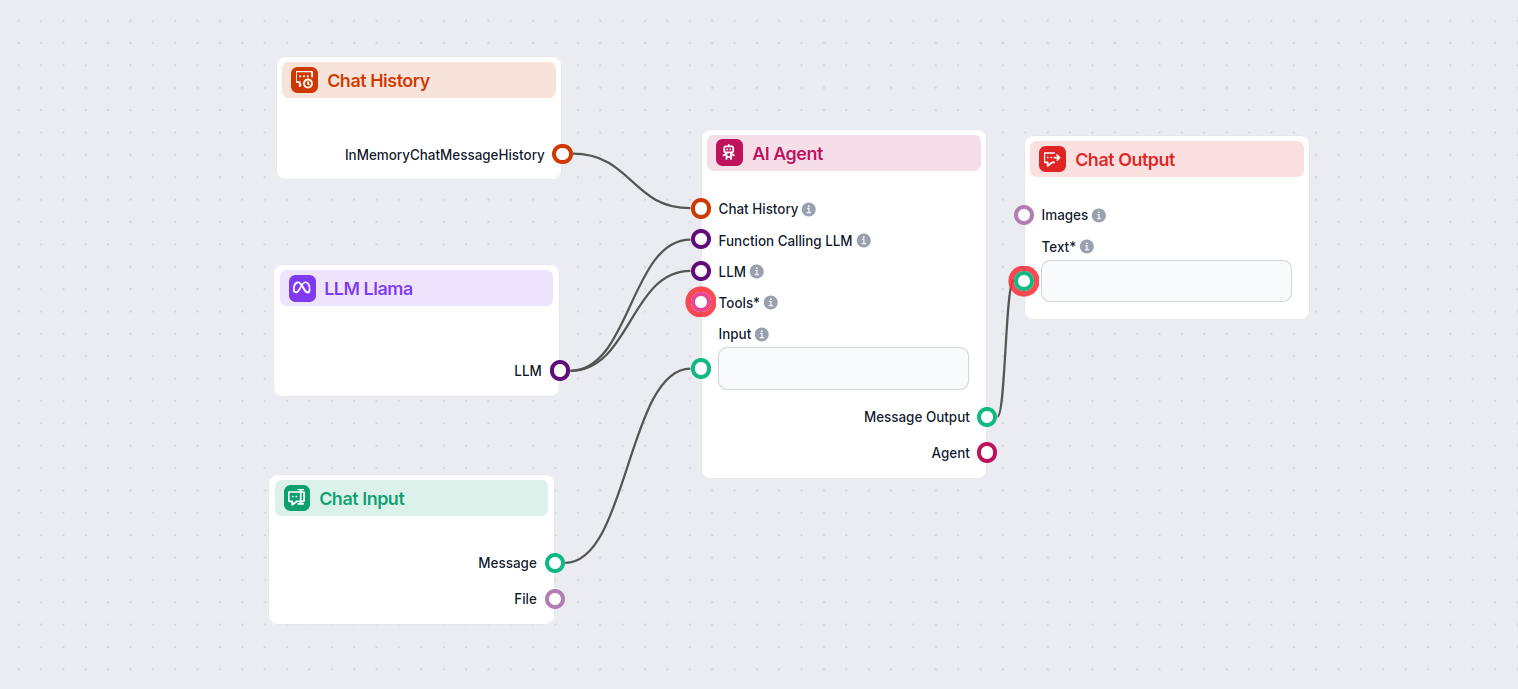

これにより、さまざまなツールを自由に作成できます。実際の動作例を見てみましょう。下図はMeta AIのLlama 3.2 1Bを使って応答を生成する、シンプルなAIエージェントチャットボットのフローです。これは基本的なLlamaチャットボットと捉えることができます。

このシンプルなチャットボットフローは以下で構成されています:

- チャット入力:ユーザーが送信するメッセージを表します。

- チャット履歴:過去の応答を記憶し、チャットボットが参照できるようにします。

- チャット出力:チャットボットの最終的な応答です。

- AIエージェント:自律的に応答を生成するAIエージェントです。

- LLM Meta AI:Metaのテキスト生成モデルへの接続部分です。