LLM Gemini

FlowHuntはGoogle Geminiを含む多数のAIモデルに対応しています。GeminiをAIツールやチャットボットで使う方法、モデルの切り替え方、トークンや温度などの高度な設定の管理方法について解説します。...

FlowHuntのLLM DeepSeekを使えば、DeepSeek R1のような優れたAIモデルでテキストや画像生成をチャットボットやAIツールに簡単に導入・カスタマイズできます。すべてを一つのダッシュボードで管理可能です。

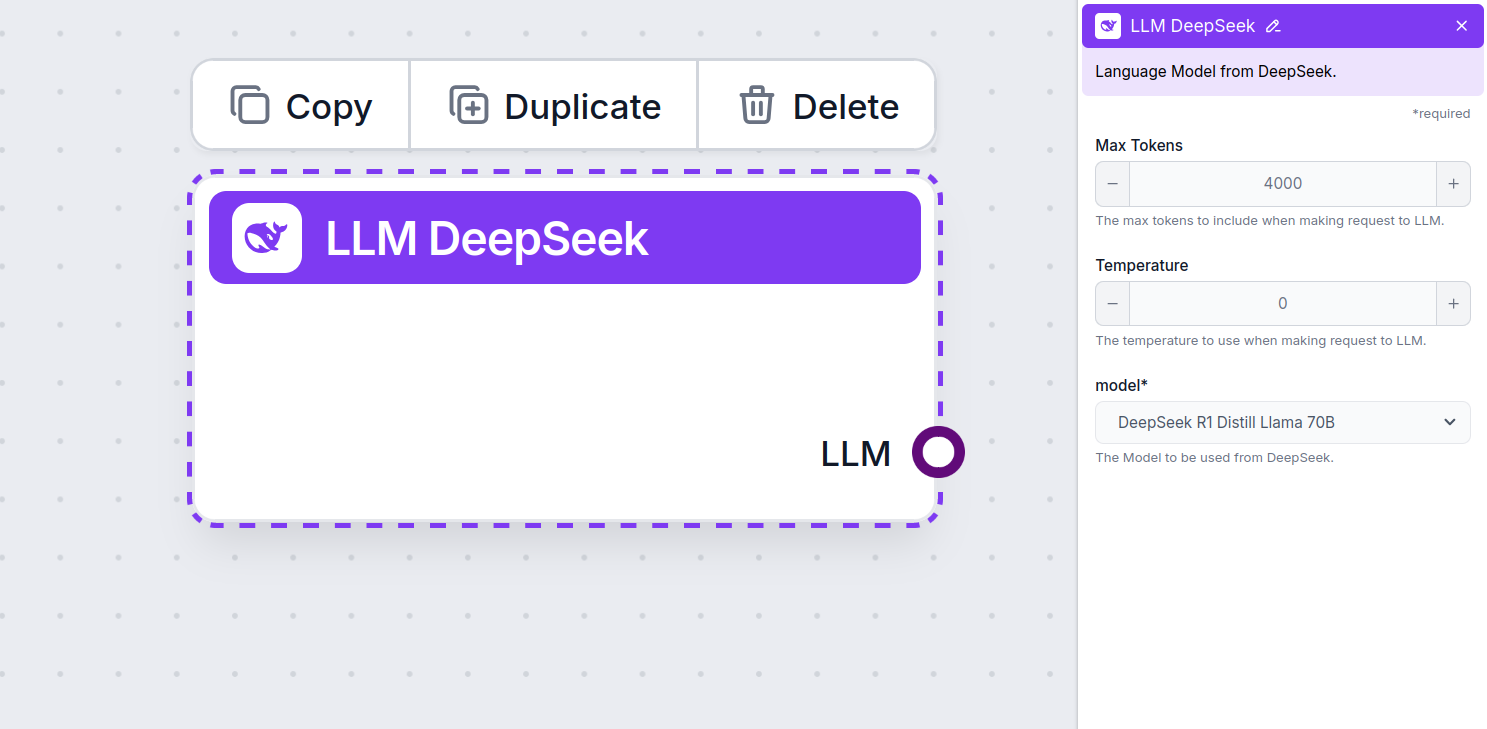

コンポーネントの説明

LLM DeepSeekコンポーネントは、DeepSeekモデルをあなたのフローに接続します。実際の生成やエージェント機能は「ジェネレーター」や「エージェント」で行われますが、LLMコンポーネントを使うことでモデルの切り替えや制御が可能になります。

LLMコンポーネントの接続は任意であることを覚えておきましょう。LLMを利用するすべてのコンポーネントには、デフォルトでChatGPT-4oが設定されています。LLMコンポーネントを使うことで、モデルの変更や設定の制御が行えます。

トークンは、モデルが処理・生成するテキストの最小単位です。トークンのカウント方法はモデルによって異なり、単語・サブワード・記号などさまざまです。通常、料金は数百万トークン単位で計算されます。

最大トークン数の設定は、一度のやり取りやリクエストで処理可能なトークンの上限を決定します。これにより、応答が適度な長さに収まるよう制御できます。デフォルトの上限は4,000トークンで、ドキュメントや複数資料の要約や回答生成に最適なサイズです。

温度は応答の多様性(ランダム性)を制御するパラメータで、0から1までの値を取ります。

0.1のような低温度では、応答は非常に的確ですが、繰り返しや単調さが目立つ場合があります。

逆に、1のような高温度では、応答の創造性が最大化されますが、無関係な内容や事実誤認(幻覚)が含まれるリスクも高まります。

例えば、カスタマーサポート用のチャットボットでは、0.2から0.5の範囲が推奨されます。この範囲なら、台本に沿った的確な応答を保ちつつ、自然なバリエーションも得られます。

こちらがモデル選択欄です。ここから、サポートされているすべてのDeepSeekモデルを選択できます。最新のGeminiモデルにも対応しています。

すべてのLLMコンポーネントには出力ハンドルのみがあることに気づくでしょう。入力はこのコンポーネントを通過せず、モデルを表現する役割のみを果たします。実際の生成はAIエージェントやジェネレーターで行われます。

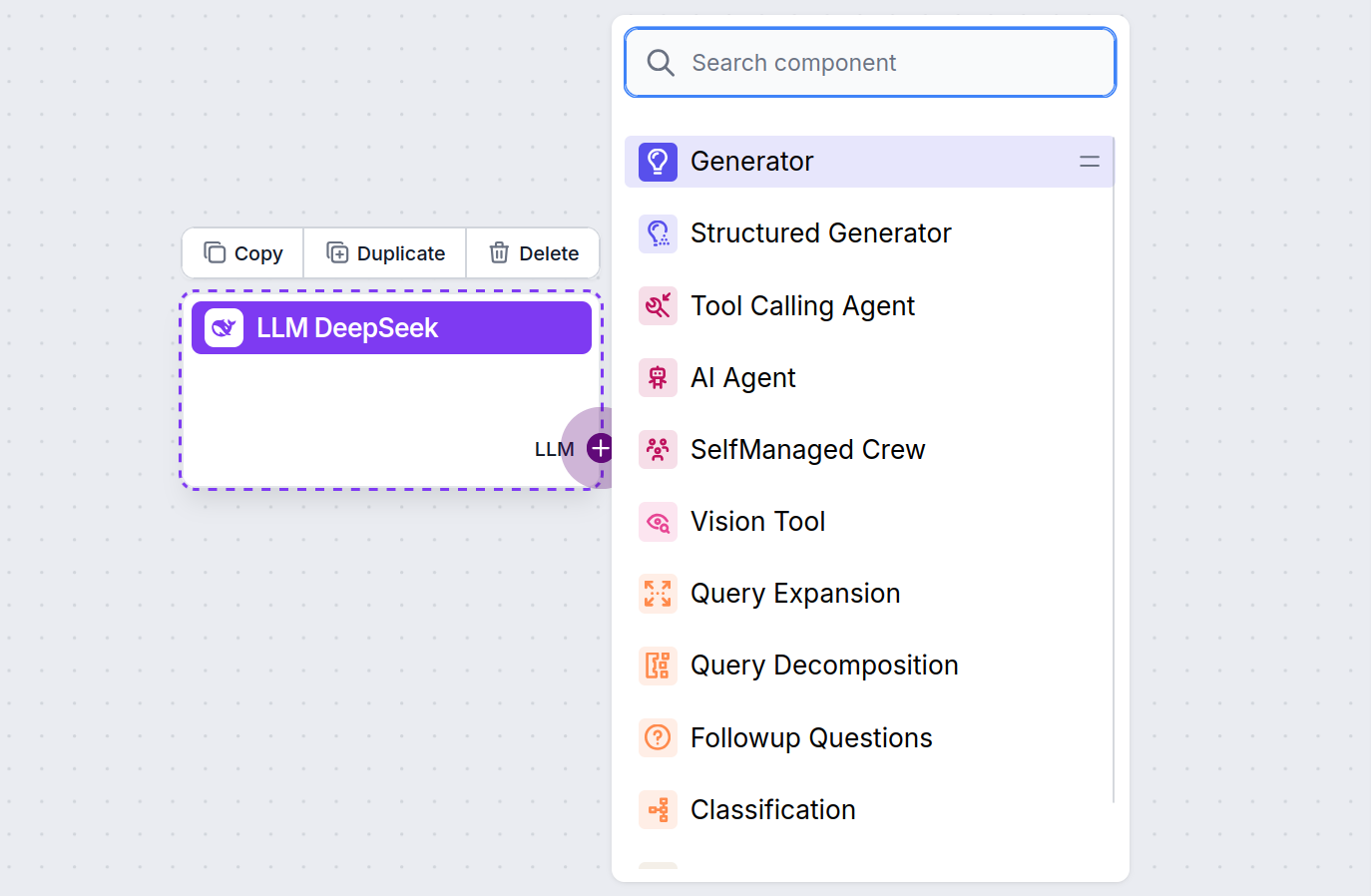

LLMのハンドルは常に紫色です。LLM入力ハンドルは、テキスト生成やデータ処理を行うAIコンポーネントすべてにあります。ハンドルをクリックするとオプションが表示されます。

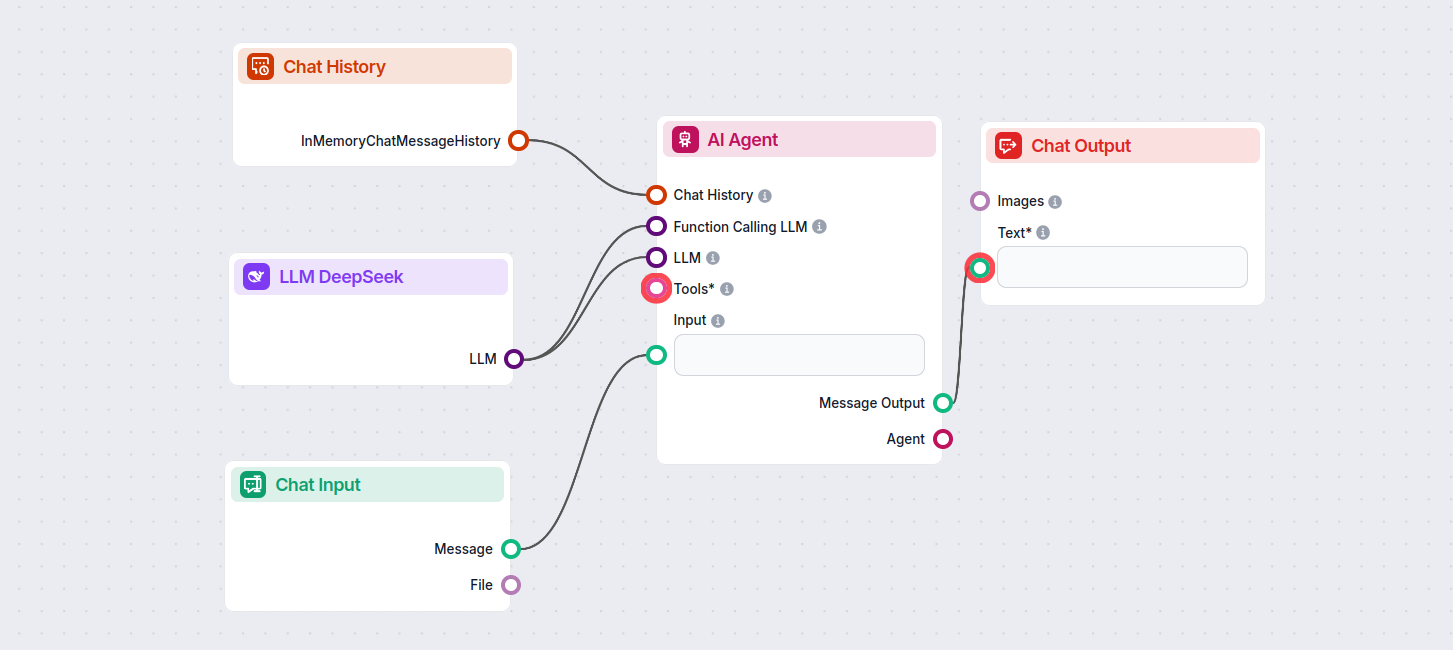

これにより、さまざまなツールを作成できます。実際のコンポーネントの使い方を見てみましょう。以下は、DeepSeek R1を使って応答を生成するシンプルなAIエージェントチャットボットフローです。基本的なDeepSeekチャットボットとしても利用できます。

このシンプルなチャットボットフローは以下で構成されます:

LLM DeepSeekは、DeepSeek AIモデルをテキストや画像生成に接続・制御できるFlowHuntのコンポーネントです。強力なチャットボットや自動化フローを実現します。

FlowHuntは、DeepSeek R1をはじめとする最新のDeepSeekモデルすべてに対応しています。これらのモデルは、その速度と性能で他の主要AIモデルを凌駕しています。

応答の長さを決める最大トークン数や、創造性を調整する温度、使用するDeepSeekモデルの切り替えなど、FlowHuntダッシュボード上で直接調整可能です。

いいえ、LLMコンポーネントの接続は任意です。デフォルトではFlowHuntはChatGPT-4oを使用しますが、LLM DeepSeekを追加することで利用するAIモデルを切り替えて制御できるようになります。

FlowHuntはGoogle Geminiを含む多数のAIモデルに対応しています。GeminiをAIツールやチャットボットで使う方法、モデルの切り替え方、トークンや温度などの高度な設定の管理方法について解説します。...

FlowHuntは、Mistralを含む多数のAIテキストモデルをサポートしています。ここでは、MistralをAIツールやチャットボットで利用する方法をご紹介します。...

FlowHuntは、AnthropicのClaudeモデルを含む数十種類のAIモデルに対応しています。カスタマイズ可能な設定で、ClaudeをAIツールやチャットボットに組み込み、最適な応答を得る方法をご紹介します。...