LLM Mistral

FlowHuntは、Mistralを含む多数のAIテキストモデルをサポートしています。ここでは、MistralをAIツールやチャットボットで利用する方法をご紹介します。...

FlowHuntのLLM Meta AIは、MetaのLlamaモデルと多数のAIモデルを、柔軟なテキスト・画像生成のために一元管理できる簡単なダッシュボードにまとめています。

コンポーネントの説明

LLM Meta AIコンポーネントは、ClaudeファミリーのモデルをFlowに接続します。実際の生成やエージェント処理はGeneratorsやAgentsで実行されますが、LLMコンポーネントでは使用するモデルをコントロールできます。すべてのコンポーネントはデフォルトでChatGPT-4を搭載しています。モデルを変更したい、またはさらに細かなコントロールを行いたい場合は、このコンポーネントを接続してください。

LLMコンポーネントの接続は任意であることを覚えておいてください。LLMを使用するすべてのコンポーネントにはデフォルトでChatGPT-4oが設定されています。LLMコンポーネントを使うことで、モデルの切り替えやモデル設定の調整ができます。

トークンは、モデルが処理・生成するテキストの最小単位です。モデルごとにトークンのカウント方法は異なり、単語・サブワード・1文字などさまざまです。通常、モデルは数百万トークン単位で価格設定されています。

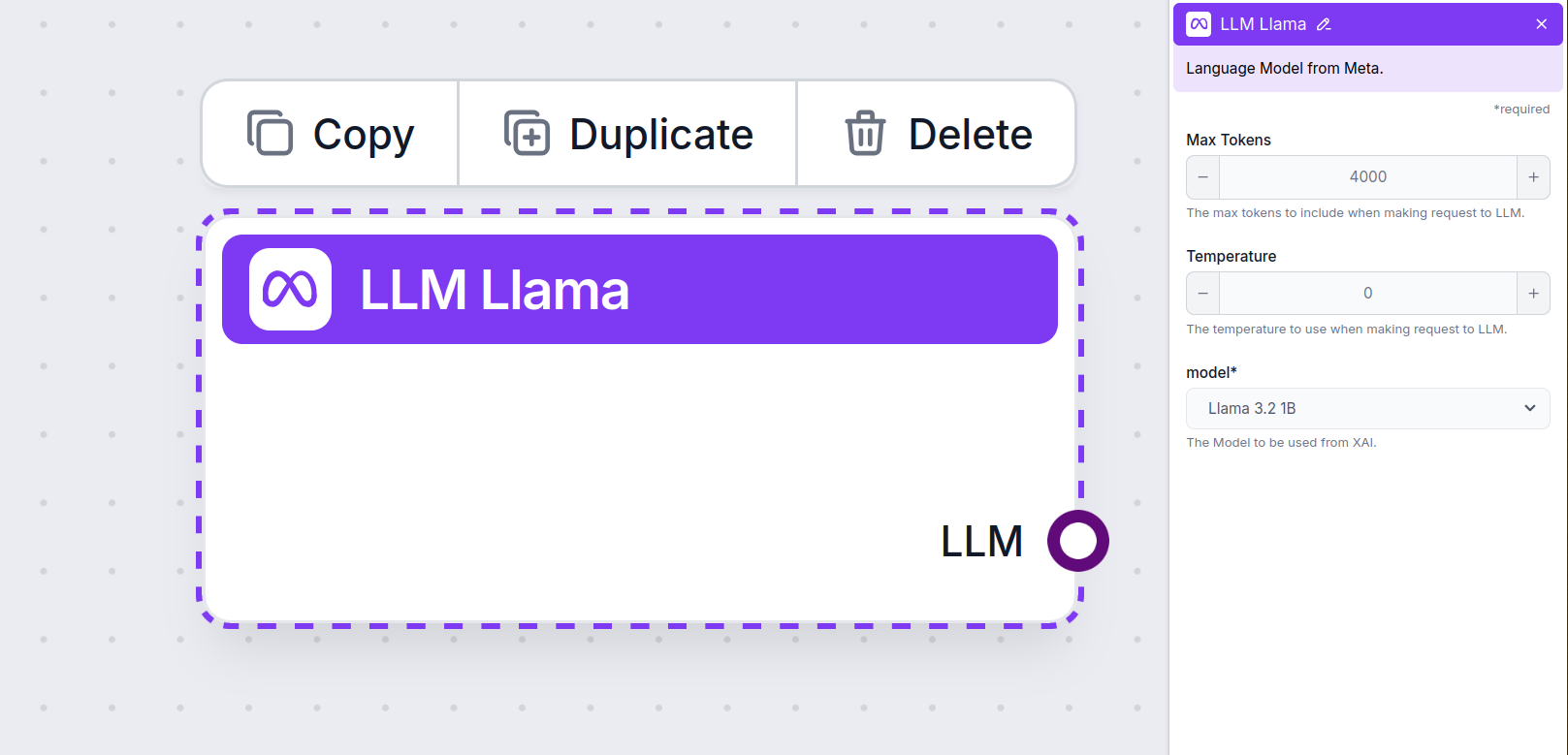

最大トークン数の設定は、1回の対話やリクエストで処理できるトークン数の上限を制御し、応答が適切な範囲内に収まるようにします。デフォルトでは4,000トークンで、文書や複数ソースの要約などに最適なサイズです。

温度は、応答の多様性(ばらつき)を0から1の範囲で調整します。

0.1の低い温度では、応答が簡潔で一貫性が高くなりますが、繰り返しが多く内容が乏しくなる場合があります。

1の高い温度では、最大限に創造的な応答が得られますが、無関係な内容や幻覚的な回答が生じるリスクも高まります。

例えば、カスタマーサービスボットでは0.2~0.5の温度がおすすめです。この範囲では、スクリプトどおりかつ自然なバリエーションを持たせた応答が期待できます。

ここがモデル選択欄です。Meta AIがサポートするすべてのモデルが表示されます。Metaのオープンソース軽量Llamaモデルに対応しています。これらはオンデバイス・エッジ用途に最適化されています。

すべてのLLMコンポーネントには出力ハンドルのみがあることに気付くでしょう。入力はこのコンポーネントを通過しません。これはあくまで「モデル」を示し、実際の生成はAIエージェントやジェネレーターで行われます。

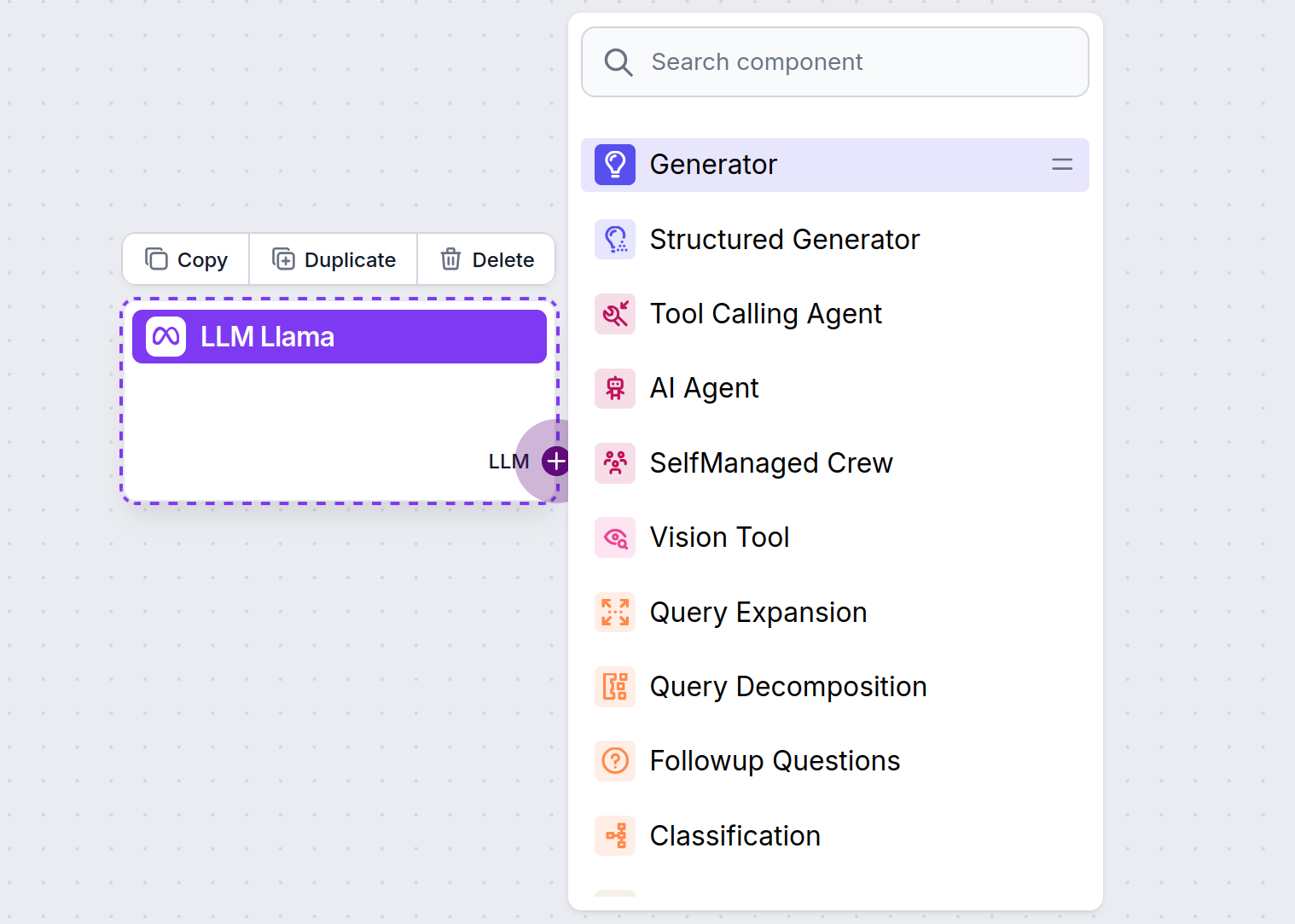

LLMハンドルは常に紫色です。LLM入力ハンドルは、テキスト生成やデータ処理にAIを使うコンポーネントすべてにあります。ハンドルをクリックするとオプションが表示されます。

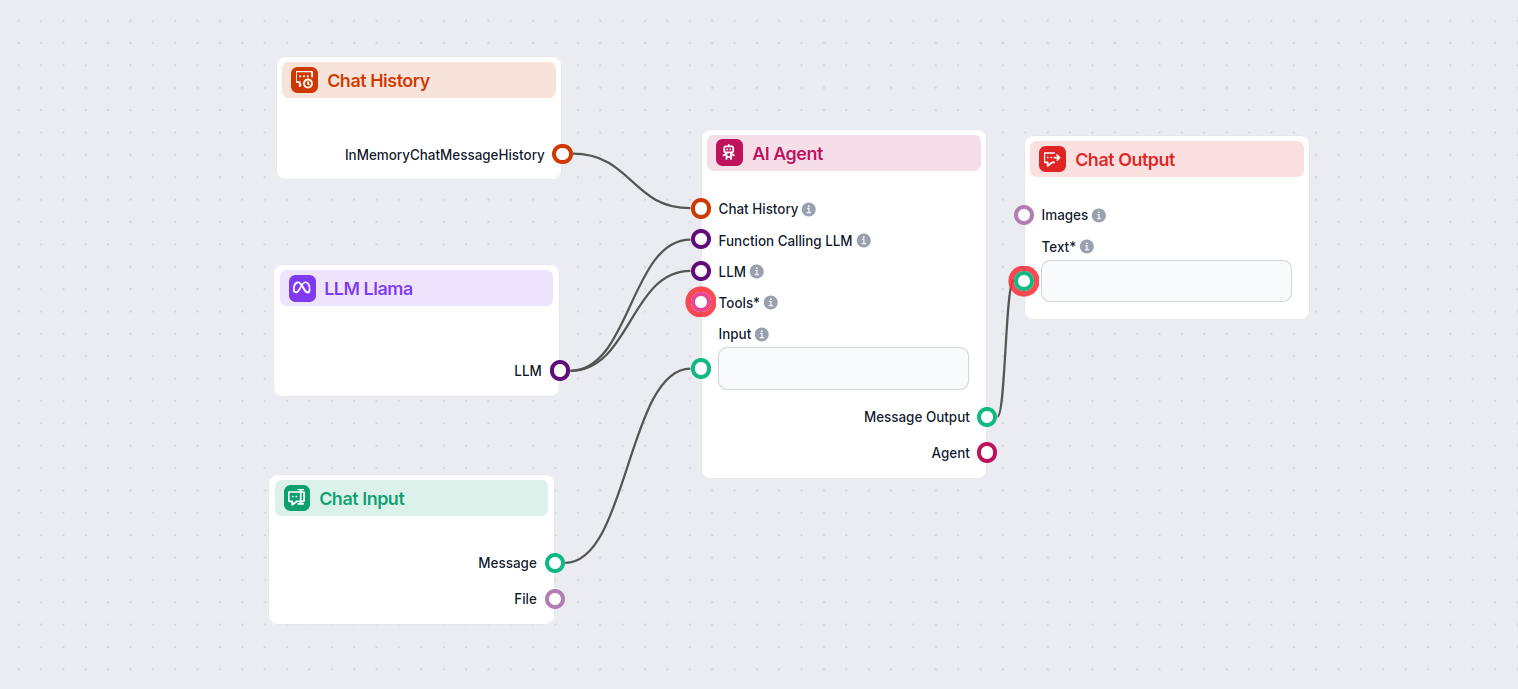

これにより、さまざまなツールを自由に作成できます。実際の動作例を見てみましょう。下図はMeta AIのLlama 3.2 1Bを使って応答を生成する、シンプルなAIエージェントチャットボットのフローです。これは基本的なLlamaチャットボットと捉えることができます。

このシンプルなチャットボットフローは以下で構成されています:

LLM Meta AIコンポーネントは、MetaのLlamaモデルや他のテキスト/画像生成モデルをフローに接続でき、簡単なモデル選択や最大トークン数・温度などの高度な設定が可能になります。

FlowHuntはMetaのオープンソースLlamaモデル(Llama 3.2 1Bおよび3Bなど)をサポートしており、効率性・要約・オンデバイス展開に最適化されています。

最大トークン数(応答の長さ制限)、温度(応答の創造性調整)、モデル選択などの設定を、各コンポーネントごとにFlowHuntダッシュボード上から直接調整できます。

いいえ、LLM Meta AIコンポーネントの追加は任意です。デフォルトではChatGPT-4oが使用されますが、より細かい制御や特定の用途に合わせてLlamaや他のモデルへ切り替えることができます。

FlowHuntは、Mistralを含む多数のAIテキストモデルをサポートしています。ここでは、MistralをAIツールやチャットボットで利用する方法をご紹介します。...

FlowHuntは、AnthropicのClaudeモデルを含む数十種類のAIモデルに対応しています。カスタマイズ可能な設定で、ClaudeをAIツールやチャットボットに組み込み、最適な応答を得る方法をご紹介します。...

FlowHuntは、xAIによるモデルを含む数十種類のテキスト生成モデルをサポートしています。ここでは、xAIモデルをAIツールやチャットボットで利用する方法をご紹介します。...