人工ニューラルネットワーク(ANN)

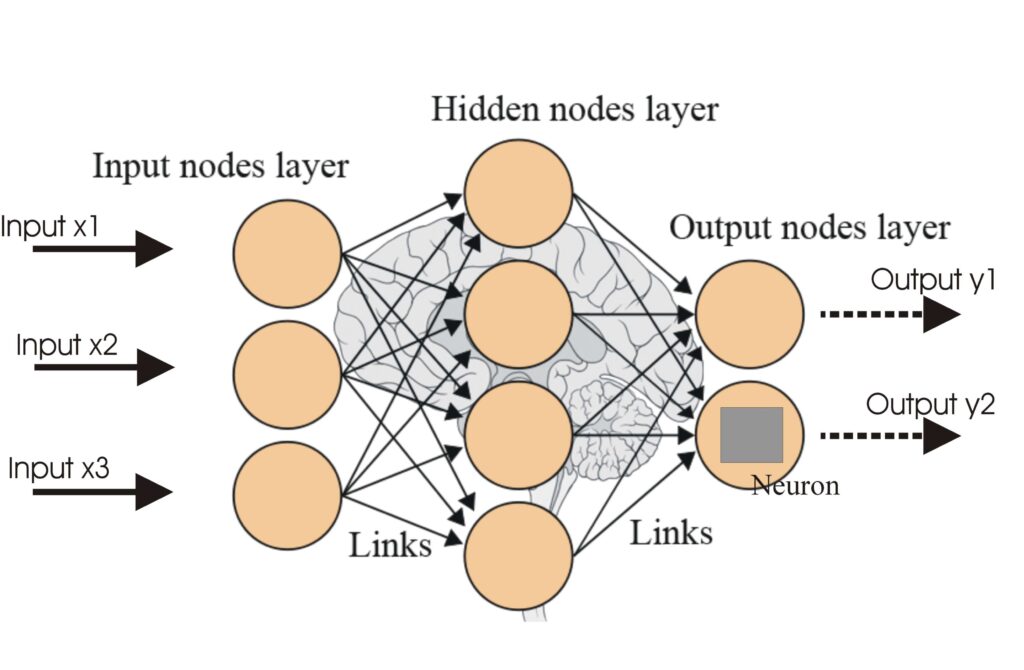

人工ニューラルネットワーク(ANN)は、人間の脳をモデルにした機械学習アルゴリズムの一種です。これらの計算モデルは、相互に接続されたノード(「ニューロン」)で構成されており、複雑な問題を解決するために協力します。ANNは、画像や音声認識、自然言語処理、予測分析などの分野で広く利用されています。...

活性化関数は人工ニューラルネットワーク(ANN)のアーキテクチャにおいて不可欠な要素であり、ネットワークが複雑なタスクを学習・実行する能力に大きな影響を与えます。本用語集記事では、活性化関数の目的や種類、応用例について、AI・ディープラーニング・ニューラルネットワーク分野を中心に詳しく解説します。

ニューラルネットワークにおける活性化関数とは、ニューロンの出力に適用される数学的な処理です。これにより、ニューロンが活性化すべきかどうかを決定し、モデルに非線形性を導入します。これによってネットワークは複雑なパターンを学習できるようになります。これらの関数がなければ、ニューラルネットワークは層の深さや数に関わらず、単なる線形回帰モデルとして振る舞ってしまいます。

シグモイド関数

Tanh関数

ReLU(Rectified Linear Unit)

Leaky ReLU

ソフトマックス関数

Swish関数

活性化関数はさまざまなAI分野で重要な役割を果たしています。

活性化関数は、ニューロンの出力に適用する数学的な処理であり、非線形性を導入してニューラルネットワークが単純な線形関係を超えて複雑なパターンを学習できるようにします。

活性化関数は、ニューラルネットワークが複雑かつ非線形な問題を解決できるようにし、画像分類や言語処理、自動化などのタスクに不可欠な複雑なパターンの学習を可能にします。

代表的な種類にはシグモイド、タンジェントハイパボリック(Tanh)、ReLU、Leaky ReLU、ソフトマックス、Swishなどがあり、それぞれ異なる特徴と用途を持ちます。

よくある課題には、(特にシグモイドやTanhでの)勾配消失問題、ReLUの死んだニューロン問題、ソフトマックスなどの計算負荷の高さ(リアルタイム用途で顕著)があります。

人工ニューラルネットワーク(ANN)は、人間の脳をモデルにした機械学習アルゴリズムの一種です。これらの計算モデルは、相互に接続されたノード(「ニューロン」)で構成されており、複雑な問題を解決するために協力します。ANNは、画像や音声認識、自然言語処理、予測分析などの分野で広く利用されています。...

ニューラルネットワーク(人工ニューラルネットワーク / ANN)は、人間の脳に着想を得た計算モデルであり、パターン認識、意思決定、ディープラーニング応用など、AIや機械学習に不可欠です。...

畳み込みニューラルネットワーク(CNN)は、画像のような構造化されたグリッドデータを処理するために設計された特殊な人工ニューラルネットワークです。CNNは、画像分類、物体検出、画像セグメンテーションなど、視覚データを扱うタスクに特に効果的です。人間の脳の視覚処理メカニズムを模倣しており、コンピュータビジョン分野の基盤と...