テキスト生成

大規模言語モデル(LLM)によるテキスト生成は、機械学習モデルを高度に活用し、プロンプトから人間らしいテキストを生成する技術を指します。トランスフォーマーアーキテクチャによって強化されたLLMが、コンテンツ制作、チャットボット、翻訳などをどのように革新しているかを探ります。...

GensimはNLP向けのオープンソースPythonライブラリで、トピックモデリング、意味ベクトル表現、大規模テキスト分析に優れています。

Gensim(「Generate Similar」の略称)は、自然言語処理(NLP)向けに特化した、非常に人気の高いオープンソースのPythonライブラリです。教師なしトピックモデリング、文書インデックス化、類似性検索に重点を置いています。2008年にRadim Řehůřekによって開発され、最初はPythonスクリプトのコレクションでしたが、現在では大規模テキストコーパスのセマンティック分析に不可欠な強力なツールへと進化しました。Gensimは最先端の学術モデルや統計的機械学習技術を用いて、テキストデータをセマンティックベクトルに変換し、非構造化テキストから意味的パターンやトピックを抽出するのに不可欠です。多くの機械学習ライブラリがデータ全体をメモリにロードする必要があるのに対し、Gensimはデータストリーミングとインクリメンタルなオンラインアルゴリズムにより、大規模データセットを効率的に扱えるよう設計されています。

教師なしトピックモデリング

Gensimは、潜在ディリクレ配分法(LDA)、潜在意味解析(LSA)、階層ディリクレ過程(HDP)など、さまざまなトピックモデリングアルゴリズムをサポートしています。これらのアルゴリズムは、大量の文書コレクションからトピックを特定・抽出するのに不可欠で、テキストデータに隠れたテーマ構造を明らかにします。例えばLDAは、観測値の集合を未観測のグループで説明する生成統計モデルです。

文書のインデックス化と検索

Gensimは、TF-IDF(Term Frequency-Inverse Document Frequency)などのモデルを利用して文書をインデックス化し、類似度スコアに基づいて検索します。この機能は検索エンジンや情報検索システムで重要で、ユーザーのクエリに対する文書の関連性のスコアリングやランキングを可能にします。TF-IDFはまた、テキスト要約や分類タスクでストップワードのフィルタリングにも使われます。

セマンティックベクトル表現

単語や文書をベクトルに変換することで、Gensimはテキストのセマンティック分析を実現します。Word2VecやFastTextなどのモデルを用い、単語間の意味的関係を捉え、文脈的な意味を保持したテキスト表現を提供します。Word2Vecは、単語の言語的文脈を再構築するために訓練された浅層2層ニューラルネットワークモデル群です。FastTextはFacebookのAI研究所で開発され、サブワード情報も考慮することで希少単語の処理にも優れています。

メモリ非依存性

Gensimのアーキテクチャは、データセット全体をメモリにロードせずに大規模データを処理できます。これは、スケーラブルなデータストリーミングやインクリメンタルトレーニングアルゴリズムによって実現されており、GensimはWeb規模アプリケーションにも対応可能です。

効率的なマルチコア実装

Gensimは、LSA、LDA、HDPなどの人気アルゴリズムの効率的なマルチコア実装を提供します。Cythonによる高速化で、並列処理や分散計算を実現しています。

クロスプラットフォーム対応

純粋なPythonライブラリであるため、GensimはLinux、Windows、macOSでシームレスに動作し、Python 3.8以降に対応しています。

オープンソース&コミュニティ主導

GensimはGNU LGPLライセンスのもと無償で個人・商用利用が可能で、活発なコミュニティによって豊富なドキュメントやサポート、継続的な機能強化が行われています。

トピックモデリングと分析

企業や研究者は、Gensimを使って大規模テキストコーパスから隠れたテーマ構造を発見しています。例えばマーケティング分野では、顧客フィードバックを分析しトレンドを抽出することで、戦略的意思決定に役立てています。

セマンティック類似度と情報検索

文書間の意味的類似度を計算できるGensimは、検索エンジンやレコメンデーションシステムに最適です。

テキスト分類

テキストを意味ベクトル化することで、Gensimは感情分析、スパム検出、コンテンツ分類などの文書分類を支援します。

自然言語処理研究

学術界でも広く利用されており、新しいNLP手法の探索や学術論文でしばしば引用されています。

チャットボットとAI自動化

AIやチャットボット開発において、Gensimはユーザー入力の理解や会話モデルの強化、トピックモデリングによる対話の質向上に役立っています。

Gensimはpipでインストールできます:

pip install --upgrade gensim

またはcondaで:

conda install -c conda-forge gensim

必要条件:

潜在意味インデキシング(LSI)

この例では、コーパスの読み込み、LSIモデルの訓練、別のコーパスをLSI空間に変換して類似度インデックス化を行います。

from gensim import corpora, models, similarities

# コーパスの読み込み

corpus = corpora.MmCorpus("path/to/corpus.mm")

# LSIモデルの訓練

lsi_model = models.LsiModel(corpus, num_topics=200)

# 別のコーパスをLSI空間に変換

index = similarities.MatrixSimilarity(lsi_model[corpus])

Word2Vecモデル

Word2Vecモデルを作成・訓練し、意味的に類似した単語を検索することで、単語埋め込みの威力を示します。

from gensim.models import Word2Vec

# サンプル訓練データ

sentences = [["cat", "say", "meow"], ["dog", "say", "woof"]]

# Word2Vecモデルの訓練

model = Word2Vec(sentences, vector_size=100, window=5, min_count=1, workers=4)

# 類似単語の検索

similar_words = model.wv.most_similar("cat")

潜在ディリクレ配分法(LDA)

コーパス作成、LDAモデルの訓練、トピック抽出の例で、Gensimのトピックモデリング機能を示します。

from gensim import corpora, models

# 文書コレクションからコーパス作成

texts = [['human', 'interface', 'computer'], ['survey', 'user', 'computer', 'system', 'response', 'time']]

dictionary = corpora.Dictionary(texts)

corpus = [dictionary.doc2bow(text) for text in texts]

# LDAモデルの訓練

lda = models.LdaModel(corpus, num_topics=2, id2word=dictionary)

# トピックの表示

topics = lda.print_topics(num_words=3)

Gensimの強力な機能は、業界のプロフェッショナルから学術研究者まで、大規模テキストデータを扱うすべての人にとって不可欠なツールです。AIやチャットボットシステムへの統合により、人間の言語理解・処理力を大幅に高め、よりインテリジェントで応答性の高い対話を実現します。成熟した広く普及しているライブラリであり、学術論文で2600件以上引用され商用にも広く使われているGensimは、自然言語処理分野のリーディングソリューションとして際立っています。

Gensimは自然言語処理や機械学習分野で、教師なしトピックモデリングや文書類似度分析に広く用いられている人気のオープンソースライブラリです。特に効率的なトピックモデリングアルゴリズムや、大規模テキストコレクションの処理能力で知られています。Word2Vec、Doc2Vec、FastTextなどの代表的なモデルの実装を提供し、セマンティック分析、テキスト分類、情報検索など多様なタスクに活用できる汎用性を持っています。

最新研究ハイライト:

GenSim: Generating Robotic Simulation Tasks via Large Language Models

(発表日: 2024-01-21)Lirui Wangら

GenSimと呼ばれるこの手法は、大規模言語モデルのグラウンディングおよびコーディング能力を活用し、ロボットポリシー訓練用の多様なシミュレーション環境の自動生成を実現します。これによりマルチタスクポリシー訓練のタスクレベル一般化が大幅に強化されました。GPT4生成のシミュレーションタスクで事前訓練されたポリシーは、実世界タスクへの高い転移性能を示しています。

詳細はこちら

Wembedder: Wikidata Entity Embedding Web Service

(発表日: 2017-10-11)Finn Årup Nielsen

GensimのWord2Vecを用いてWikidata知識グラフ内のエンティティを埋め込み表現するWebサービスを紹介。REST APIを通じて、60万以上のWikidataアイテムを多言語で問い合わせでき、知識グラフ埋め込みやセマンティックWebサービスにおけるGensimの応用例を示しています。

A Comparative Study of Text Embedding Models for Semantic Text Similarity in Bug Reports

(発表日: 2023-11-30)Avinash Patilら

バグ報告の類似文書検索を目的に、Gensimを含む様々な埋め込みモデルの性能を比較。BERTが最も高性能である一方、Gensimも競争力のある選択肢であり、ソフトウェア欠陥分析におけるセマンティックテキスト類似度や情報検索分野での有用性が示されました。

Gensimは、トピックモデリングや文書類似度分析、意味ベクトル表現、情報検索などの自然言語処理(NLP)タスクに使用されます。大規模なテキストデータセットを効率的に処理し、Word2Vec、LDA、FastTextなどのモデルの実装を提供しています。

Gensimはメモリ独立性とスケーラブルな処理のために設計されており、すべてのデータをメモリに読み込むことなく大規模データセットを扱うことができます。効率的なマルチコア実装をサポートし、セマンティック分析や教師なし学習に特化しているため、トピックモデリングや文書類似度タスクに最適です。

一般的なユースケースには、トピックモデリングと分析、セマンティック類似性や情報検索、テキスト分類、NLP研究、チャットボットや会話型AIシステムの強化などがあります。

Gensimはpipで「pip install --upgrade gensim」またはcondaで「conda install -c conda-forge gensim」としてインストールできます。Python 3.8以降が必要で、NumPyやsmart_openなどのライブラリに依存しています。

Gensimは2008年にRadim Řehůřekによって開発されました。オープンソースで、GNU LGPLのもとで提供されており、活発なコミュニティに支えられています。

GensimとFlowHuntが、効率的なトピックモデリングやセマンティック分析、スケーラブルなソリューションによって、あなたのNLPやAIプロジェクトをどのように強化できるかを発見しましょう。

大規模言語モデル(LLM)によるテキスト生成は、機械学習モデルを高度に活用し、プロンプトから人間らしいテキストを生成する技術を指します。トランスフォーマーアーキテクチャによって強化されたLLMが、コンテンツ制作、チャットボット、翻訳などをどのように革新しているかを探ります。...

生成型事前学習トランスフォーマー(GPT)は、深層学習技術を活用して人間の文章に極めて近いテキストを生成するAIモデルです。トランスフォーマーアーキテクチャに基づき、GPTは自己注意メカニズムを用いて効率的にテキストを処理・生成し、コンテンツ制作やチャットボットなどのNLPアプリケーションを革新しました。...

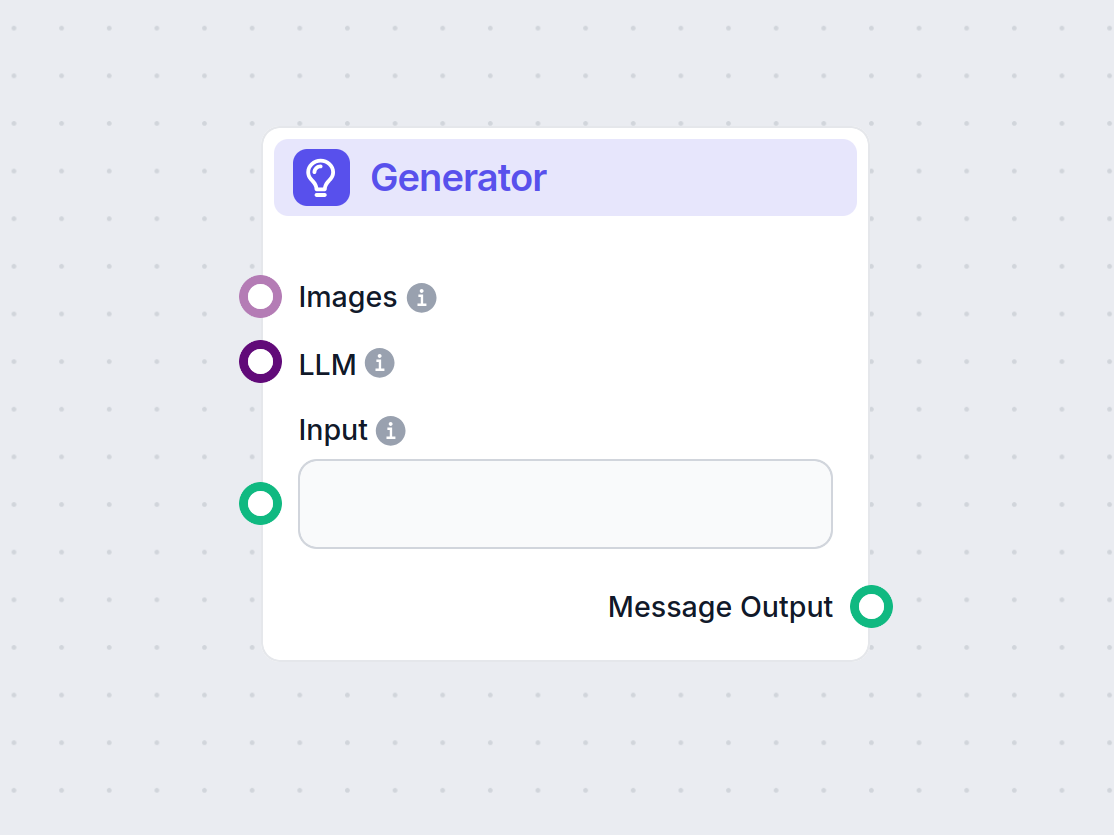

FlowHunt の Generator コンポーネントを探索しましょう。選択した LLM モデルを使って強力な AI テキスト生成を実現。プロンプト、オプションのシステム指示、さらには画像も入力として組み合わせることで、ダイナミックなチャットボット応答を簡単に作成でき、インテリジェントな会話型ワークフロー構築の中核ツ...