双方向LSTM

双方向長短期記憶(BiLSTM)は、順方向と逆方向の両方で系列データを処理する高度なリカレントニューラルネットワーク(RNN)アーキテクチャであり、NLP、音声認識、バイオインフォマティクスのアプリケーションにおいてコンテキスト理解を強化します。...

LSTMネットワークは、勾配消失問題を解決する高度なRNNアーキテクチャであり、時系列データにおける長期的な依存関係から効果的に学習することを可能にします。

長短期記憶(LSTM)は、時系列データ内の長期的な依存関係を学習するのに優れた再帰型ニューラルネットワーク(RNN)の一種です。LSTMネットワークは1997年にHochreiterとSchmidhuberによって開発され、従来型RNNが持つ主な制約、特に勾配消失問題を解決するために設計されました。この問題は、勾配が指数関数的に減衰することでRNNが長期的な依存関係をうまく学習できなくなる現象です。LSTMは、メモリーセルとゲーティング機構を備えた高度なアーキテクチャを採用しており、長期間にわたって情報を保持・活用できるようになっています。この能力により、文脈が重要となる言語翻訳や時系列予測などのシーケンスに関わるタスクに適しています。

メモリーセルはLSTMユニットの中核となる要素で、時間の経過とともに情報を動的に保持する役割を果たします。各LSTMセルにはセル状態と呼ばれる状態があり、これが情報の流れの通路となります。情報の流れは、入力ゲート、忘却ゲート、出力ゲートという3種類のゲートによって厳密に制御されます。これらのゲートは、セル状態が必要な情報を保持し、不要になった情報を破棄できるようにします。

各ゲートの動作はLSTMが勾配消失問題を克服する上で重要であり、情報の流れと保持を総合的に管理して長期的な依存関係を維持します。

LSTMネットワークのアーキテクチャは、LSTMセルが鎖状に連結されている構造を持ち、個々のデータポイントではなく一連のデータ全体を処理できるようになっています。このチェーン構造は、データ内の短期および長期の依存関係を捉える上で重要です。従来のRNNとは異なり、LSTMはフィードバック接続を取り入れることでシーケンス全体を効率的に処理できます。アーキテクチャにはゲートで制御されるメモリーセルが組み込まれており、情報の選択的な保持や破棄を可能にし、時系列データからの学習能力を高めています。

LSTMは、各タイムステップごとに入力、忘却、出力ゲートを巡回し、ネットワーク内の情報の流れを効果的に管理します。プロセスの概要は以下の通りです:

このゲーティング機構はLSTMの要であり、従来型RNNでよく発生する勾配消失問題を解決します。情報の流れと保持を適切に管理することで、LSTMは長いシーケンスにおいても関連する文脈を維持でき、時系列データタスクに特に有効です。

LSTMは、長期的な依存関係を持つ時系列データの処理能力に優れているため、さまざまな分野で広く利用されています。主な応用例は以下の通りです:

LSTMは強力な一方で、計算コストが高く、ハイパーパラメータの調整が重要です。特に小規模なデータセットで学習すると過学習しやすく、複雑なアーキテクチャは実装や解釈が難しい場合もあります。

性能向上や複雑性の低減を目指して、さまざまなLSTMバリアントが開発されています:

AIや自動化の分野において、LSTMはインテリジェントなチャットボットや音声アシスタントの開発で重要な役割を担っています。LSTMを用いることで、人間らしい応答の理解と生成が可能となり、シームレスで反応の良い顧客対応を実現します。自動化システムにLSTMを組み込むことで、より高精度かつ文脈を考慮したインタラクションを提供し、ユーザー体験の向上に貢献します。

ニューラルネットワークにおける長短期記憶(LSTM)

長短期記憶(LSTM)ネットワークは、従来型RNNの学習時に生じやすい勾配消失問題を解決するために設計された再帰型ニューラルネットワーク(RNN)の一種です。この特性により、LSTMは時系列や自然言語処理など長期的な依存関係が重要なシーケンスデータの学習に特に適しています。

Weizhi Wangらによる論文「Augmenting Language Models with Long-Term Memory」では、長期記憶機能を備えた言語モデルの強化フレームワークが提案されています。この研究は、既存モデルに長期記憶を統合し、より長いシーケンスにわたる文脈利用能力を拡張する方法を示しています。これは、LSTMが言語処理タスクで長期依存関係を捉える仕組みと類似しています。続きを読む。

Pier Francesco ProcacciとTomaso Asteによる論文「Portfolio Optimization with Sparse Multivariate Modelling」では、金融市場における多変量モデリングと、複雑なシステムのモデリングにおけるさまざまな誤差要因について考察されています。LSTMを直接扱った内容ではありませんが、非定常性の扱いやモデルパラメータの最適化など、金融データ分析向けの堅牢なLSTMアーキテクチャ設計に関連する重要な視点が述べられています。続きを読む。

Ho Kei ChengとAlexander G. Schwingによる「XMem: Long-Term Video Object Segmentation with an Atkinson-Shiffrin Memory Model」では、Atkinson-Shiffrin記憶モデルに着想を得た複数の特徴メモリーストアを組み込んだビデオ物体セグメンテーションのアーキテクチャが紹介されています。この研究は、LSTMがシーケンスデータ内の長期依存関係を管理するのと同様に、長いビデオシーケンスにおける効率的なメモリー管理の重要性を強調しています。続きを読む。

LSTM(長短期記憶)ネットワークは、メモリーセルとゲーティング機構を用いて情報の流れと保持を管理することで、時系列データの長期的な依存関係を学習可能な再帰型ニューラルネットワーク(RNN)の一種です。

LSTMネットワークは、長いシーケンスの文脈を保持できる特性から、自然言語処理、音声認識、時系列予測、異常検知、レコメンダーシステム、ビデオ解析などで広く利用されています。

LSTMはメモリーセルと3種類のゲート(入力、忘却、出力)を活用して情報の流れを調整し、長期間にわたって情報を保持・活用できるため、従来型RNNでよく発生する勾配消失問題を軽減します。

一般的なLSTMのバリアントには、双方向LSTM、ゲーティッド・リカレント・ユニット(GRU)、ピープホール接続付きLSTMなどがあり、タスクに応じて性能や効率性の向上を図るアーキテクチャ上の工夫がなされています。

LSTMは時系列データ向けに設計されており、時間的依存関係の学習に優れています。一方、CNNは画像のような空間データ処理に最適化されています。それぞれのアーキテクチャは、対象データやタスクに応じて最適な選択肢となります。

長短期記憶(LSTM)ネットワークの力を活用して、AIアプリケーションを強化しましょう。FlowHuntのAIツールを活用し、時系列データタスク向けのインテリジェントなソリューションを構築できます。

双方向長短期記憶(BiLSTM)は、順方向と逆方向の両方で系列データを処理する高度なリカレントニューラルネットワーク(RNN)アーキテクチャであり、NLP、音声認識、バイオインフォマティクスのアプリケーションにおいてコンテキスト理解を強化します。...

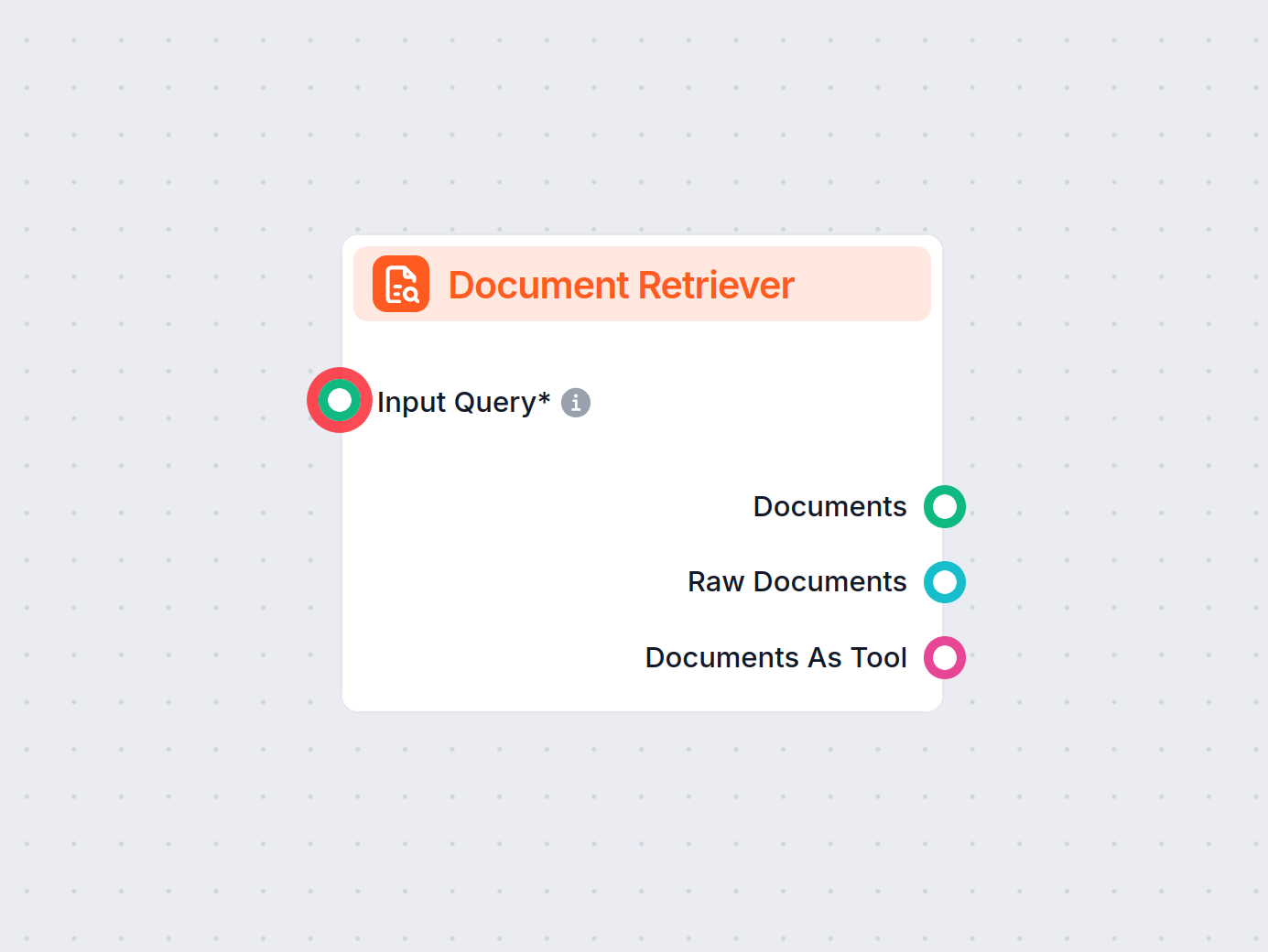

FlowHuntのドキュメントリトリーバーは、生成AIモデルをあなた自身の最新ドキュメントやURLへ接続し、Retrieval-Augmented Generation(RAG)を通じて信頼性と関連性の高い回答を実現します。...

大規模言語モデル(LLM)は、膨大なテキストデータで訓練されたAIの一種で、人間の言語を理解・生成・操作することができます。LLMはディープラーニングやトランスフォーマーニューラルネットワークを用い、テキスト生成、要約、翻訳など多様な業界でのタスクを実現します。...