Stable Diffusionモデルにおけるプロンプトの極意:完全ガイド

Stable Diffusionモデルで高品質なAI生成画像を作成するためのプロンプト技術を習得しましょう。被写体、スタイル、解像度などの重要要素を活用した効果的なプロンプトの作り方を学びます。段階的な構築、ネガティブプロンプト、キーワードブレンドなどのテクニックも紹介し、最適な結果に導きます。...

Stable Diffusionは、先進的な潜在拡散およびディープラーニング技術を用いて、プロンプトからフォトリアリスティックなビジュアルを生成できるテキストから画像へのAIモデルのリーダーです。

Stable Diffusionは、ディープラーニングを用いて説明文から高品質な画像を生成するテキストから画像へのAIモデルです。複雑な要素(例:手)の表現を改善するために、ネガティブプロンプトや参照画像などの手法が活用されています。

Stable Diffusionは、テキストの説明をもとに高品質でフォトリアリスティックな画像を生成する先進的なテキストから画像への生成モデルです。潜在拡散モデルとして開発され、拡散モデルと機械学習の原理を組み合わせることで、与えられたプロンプトにきわめて近い画像を生み出す生成AI分野の大きなブレークスルーとなっています。

Stable Diffusionは、ディープラーニングと拡散モデルを用い、ランダムノイズを洗練させて一貫したビジュアルを生成します。数百万枚の画像で大規模な学習を行っていますが、手などの複雑な要素の表現は依然として課題です。しかし、より大規模なデータセットでの訓練が進むにつれて、こうした問題は減少し、画像のクオリティはますますリアルになっています。

手の表現問題に有効な手法のひとつがネガティブプロンプトの活用です。(-bad anatomy)や(-bad hands -unnatural hands)のようなフレーズをプロンプトに追加することで、AIに歪んだ特徴を避けさせることができます。ただし、ネガティブプロンプトを使いすぎると創造性が制限される場合があるので注意しましょう。

もうひとつのテクニックは、参照画像を使ってAIを誘導する方法です。プロンプトに{image}タグとリンクを含めることで、AIに正確な手の描画のための視覚的テンプレートを提供できます。特に、正しい手のバランスやポーズを保つのに有効です。

最良の結果を得るには、ネガティブプロンプトと参照画像を組み合わせましょう。この2つのアプローチにより、AIがよくあるミスを避けつつ、質の高い例に従うことができます。

(-bent fingers)や(realistic perspectives)など、詳細を指定してプロンプトを工夫すると、さらに手の表現が向上します。これらのテクニックを習得することで、Stable Diffusionによる手の描画精度を大幅に向上でき、熟練アーティストのような作品が実現できます。参照画像を集め、精緻なプロンプトを作成し、AIアートの進化を楽しみましょう!

Stable Diffusionの基本は、テキストプロンプトを一連の計算プロセスを通じてビジュアル表現へと変換することです。その仕組みを理解するには、拡散モデル・潜在空間・ニューラルネットワークの概念が重要です。

拡散モデルは、機械学習における生成モデルの一種で、拡散プロセスを逆転させることでデータを生成します。拡散プロセスでは、画像などのデータに段階的にノイズを加えていき、最終的にはランダムノイズと区別がつかなくなります。モデルはこのプロセスを逆にたどり、ノイズを一段階ずつ取り除いて元のデータを再構成することを学習します。この逆拡散プロセスが、新たな一貫したデータをランダムノイズから生成する鍵となります。

Stable Diffusionは特に潜在拡散モデルを使用しています。従来の拡散モデルが画像の高次元ピクセル空間で動作するのに対し、潜在拡散モデルは圧縮された潜在空間で処理を行います。潜在空間はデータの本質的な特徴を低次元で表現したもので、計算コストを大幅に削減できます。このアプローチにより、Stable Diffusionは高解像度画像を効率的に生成できます。

Stable Diffusionのコアメカニズムは、潜在空間での逆拡散プロセスです。最初にランダムノイズの潜在ベクトルから始め、各ステップでノイズを予測・除去することで、この潜在表現を反復的に洗練していきます。この洗練はユーザーが入力したテキストによってガイドされます。プロセスは、最終的にテキストプロンプトに合致した画像がデコードされる状態に収束するまで続きます。

Stable Diffusionのアーキテクチャは、テキストプロンプトを画像へと変換するために複数の重要なコンポーネントを統合しています。

VAEはエンコーダ・デコーダシステムとして機能し、画像を潜在空間に圧縮し、再び画像へと復元します。エンコーダは画像を潜在表現に変換し、本質的な特徴を縮約された形で捉えます。デコーダはこの潜在表現を詳細な画像へと再構成します。

このプロセスにより、モデルは低次元データで処理できるため、ピクセル空間全体で動作するよりも計算リソースを大幅に削減できます。

U-Netは、Stable Diffusionの画像処理タスクで使われる特殊なニューラルネットワークアーキテクチャです。エンコーディングパスとデコーディングパス、さらにミラー層間のスキップ接続から構成されます。Stable Diffusionでは、U-Netは逆拡散プロセスにおけるノイズ予測器として機能します。

拡散プロセスの各タイムステップで、U-Netは潜在表現に含まれるノイズ量を予測します。この予測値を使って潜在ベクトルからノイズを差し引き、テキストプロンプトに合致する画像へ向けて徐々にデノイズしていきます。

テキスト情報を取り込むために、Stable DiffusionはCLIP(Contrastive Language-Image Pretraining)モデルに基づくテキストエンコーダを採用しています。CLIPは、テキストとビジュアル情報を共通の潜在空間にマッピングすることで、両者の関連性を理解できるよう設計されています。

ユーザーがテキストプロンプトを入力すると、テキストエンコーダがこのプロンプトを数値的な埋め込み(エンベディング)に変換します。これらの埋め込みが逆拡散プロセス中のU-Netに条件を与え、テキスト内容に沿った画像生成を導きます。

Stable Diffusionは画像生成の多様な用途に対応しており、ユーザーのニーズに合わせて様々な活用方法があります。

Stable Diffusionの主な用途は、テキストプロンプトから画像を生成することです。ユーザーが説明的なテキストを入力すると、それを表現する画像が生成されます。例えば「ヤシの木が並ぶ夕暮れの静かなビーチ」と入力すれば、その情景を描いた画像が得られます。

この機能は、クリエイティブ業界やコンテンツ制作、デザイン分野で、アイデアの迅速なビジュアライズに特に役立ちます。

ゼロから画像を生成するだけでなく、Stable Diffusionは既存画像にテキスト指示を加えて編集することも可能です。初期画像とテキストプロンプトを与えることで、プロンプトで記述した変更を反映した新たな画像を生み出せます。

例えば、昼間の都市景観画像に「夜のネオンでライトアップされた風景に変更」とプロンプトすれば、その内容を反映した画像が生成されます。

インペインティングは、画像の欠損や破損部を補完する技術です。Stable Diffusionはテキストプロンプトを使って特定領域の修復・再構築を得意とします。画像の一部をマスクし、埋めたい内容をテキストで指示することが可能です。

この機能は、写真修復や不要物の除去、特定要素の改変など、全体の一貫性を保ちつつ編集したい場面で重宝します。

わずかに異なる画像を連続生成することで、Stable Diffusionはアニメーションや動画コンテンツの作成にも拡張できます。Deforumのようなツールを組み合わせることで、テキストプロンプトに沿ったダイナミックなビジュアルコンテンツも制作可能です。

これにより、従来のフレームごとの手作業アニメーションなしで、アニメーションやVFX、動的コンテンツ生成の新しい可能性が広がります。

Stable Diffusionのテキストから画像生成能力は、AI自動化やチャットボット開発でも強力なツールとなります。

チャットボットにStable Diffusionを組み込むことで、ユーザーの質問に対して即座にビジュアルコンテンツを生成できます。例えばカスタマーサポートの現場で、チャットボットがその場でビジュアルガイドやイラストを生成し、ユーザーをサポートすることが可能です。

テキストプロンプトはCLIPテキストエンコーダによってエンベディング(数値表現)化されます。これが画像生成プロセスの条件付けに不可欠で、出力画像がユーザーのテキスト記述に沿うことを保証します。

逆拡散プロセスでは、潜在表現から予測されたノイズを段階的に取り除きます。各タイムステップで、モデルはテキストエンベディングと現在の潜在ベクトルの状態を考慮し、ノイズ成分を正確に予測します。

モデルがノイズ画像を効果的に扱えるのは、大規模なデータセットでの学習により、画像を識別・デノイズする能力を身につけているためです。これにより、ランダムノイズからでもクリアな画像生成が可能となっています。

潜在空間での作業は計算効率が高いです。潜在空間はピクセル空間より次元が少なく、処理コストが低減されます。この効率性により、Stable Diffusionは大きな計算負荷なしで高解像度画像を生成できます。

アーティストやデザイナーは、コンセプトの説明文から素早くビジュアルをプロトタイプでき、創造プロセスやアイデアの可視化を効率化できます。

マーケティングチームは、キャンペーンやSNS、広告用のカスタム画像を、グラフィックリソースに頼らず生成できます。

ゲーム開発者は、説明文からアセットや環境、コンセプトアートを作成し、アセット制作のパイプラインを効率化できます。

小売業者は、さまざまな設定や構成の製品画像を生成し、商品ビジュアライゼーションや顧客体験を向上できます。

教育者やコンテンツ制作者は、複雑な概念を説明するイラストや図解を生成し、教材の魅力を高められます。

AIやコンピュータビジョン分野の研究者は、拡散モデルや潜在空間の可能性を探るためにStable Diffusionを活用できます。

Stable Diffusionを効果的に利用するためには、いくつかの技術的注意点があります。

Stable Diffusionを利用するには、以下のステップで導入します。

AI自動化システムやチャットボットの開発者は、Stable Diffusionを組み込むことで機能を強化できます。

Stable Diffusionを利用する際は、倫理的な観点にも注意が必要です。

Stable Diffusionは、生成モデル分野、特にデータ拡張や画像合成のテーマとして重要視されています。近年は様々な側面からの研究が進んでいます。

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments(Fuxi Wen, 2013)

アルファ安定ノイズ環境下での分散推定用として、拡散最小平均p乗(LMP)アルゴリズムを提案。従来の拡散最小平均二乗(LMS)法と比較し、アルファ安定ノイズ環境での性能向上を示しています。ノイズの多い環境での堅牢な推定技術開発に重要な研究です。詳細はこちら

Stable Diffusion for Data Augmentation in COCO and Weed Datasets(Boyang Deng, 2024)

Stable Diffusionモデルを用いた高解像度合成画像による小規模データセットの拡張を検討。Image-to-Image、Dreambooth、ControlNetなどの技術を活用し、分類・検出タスクでの効率性を評価。さまざまな分野での応用が期待されます。詳細はこちら

Diffusion and Relaxation Controlled by Tempered α-stable Processes(Aleksander Stanislavsky, Karina Weron, Aleksander Weron, 2011)

テンパードα安定過程を用いて異常拡散や非指数緩和の特性を導出。α安定なランダムな運用時間に伴う無限モーメント問題を解決し、サブ拡散を特別なケースとして含むモデルを提示。詳細はこちら

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion(Andreas Stöckl, 2022)

Wordnetタクソノミーを用いてStable Diffusionモデルによる合成画像を評価。さまざまな概念に対する正しい画像生成能力や表現精度の違いを明らかにし、データ拡張における役割を示しています。詳細はこちら

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion(Sanchayan Vivekananthan, 2024)

VAE・GAN・Stable Diffusionの3つの生成フレームワークを比較検討。それぞれの長所短所を論じつつ、Stable Diffusionが特定の合成タスクに優れていることを指摘しています。詳細はこちら

Hugging Face Diffusersライブラリを使ったPythonでのStable Diffusionモデル実装例を紹介します。

必要なライブラリをインストールします:

pip install torch transformers diffusers accelerate

pip install xformers # オプション

Diffusersライブラリを使えば、学習済みモデルを簡単にロードできます。

from diffusers import StableDiffusionPipeline

import torch

# Stable Diffusionモデルのロード

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # 推論高速化のためGPUへ転送

テキストプロンプトを指定するだけで画像を生成できます。

prompt = "A serene landscape with mountains and a lake, photorealistic, 8K resolution"

image = pipe(prompt).images[0]

# 画像の保存または表示

image.save("generated_image.png")

model_idで指定された学習済みモデルを読み込みます。torch.float16を使うとメモリ使用量が削減されます。さまざまなパラメータをカスタマイズできます。

image = pipe(

prompt=prompt,

num_inference_steps=50, # ノイズ除去ステップ数

guidance

Stable Diffusionは、テキストプロンプトから高品質でフォトリアリスティックな画像を生成するために設計された先進的なAIモデルです。潜在拡散およびディープラーニングを用いて、テキストによる説明をビジュアルへ変換します。

Stable Diffusionは、CLIPテキストエンコーダでテキストプロンプトを画像埋め込みに変換し、プロンプトに従って潜在表現を反復的にノイズ除去することで、一貫した画像出力を生成します。

Stable Diffusionは、クリエイティブなコンテンツ生成、マーケティング素材、ゲームアセット作成、EC商品のビジュアライゼーション、教育用イラストレーション、AIチャットボットなどに利用されています。

はい。Stable Diffusionは画像から画像への変換やインペインティングをサポートしており、ユーザーが既存の画像をテキストプロンプトで変更したり、欠損部分を補完することができます。

Stable Diffusionによる効率的な画像生成には、最新のGPUを搭載したPCが推奨されます。また、PythonやPyTorch、Diffusersなどのライブラリも必要です。

はい。Stable Diffusionはパーミッシブなオープンソースライセンスのもとで公開されており、コミュニティによる貢献やカスタマイズ、幅広い利用が奨励されています。

Stable Diffusionモデルで高品質なAI生成画像を作成するためのプロンプト技術を習得しましょう。被写体、スタイル、解像度などの重要要素を活用した効果的なプロンプトの作り方を学びます。段階的な構築、ネガティブプロンプト、キーワードブレンドなどのテクニックも紹介し、最適な結果に導きます。...

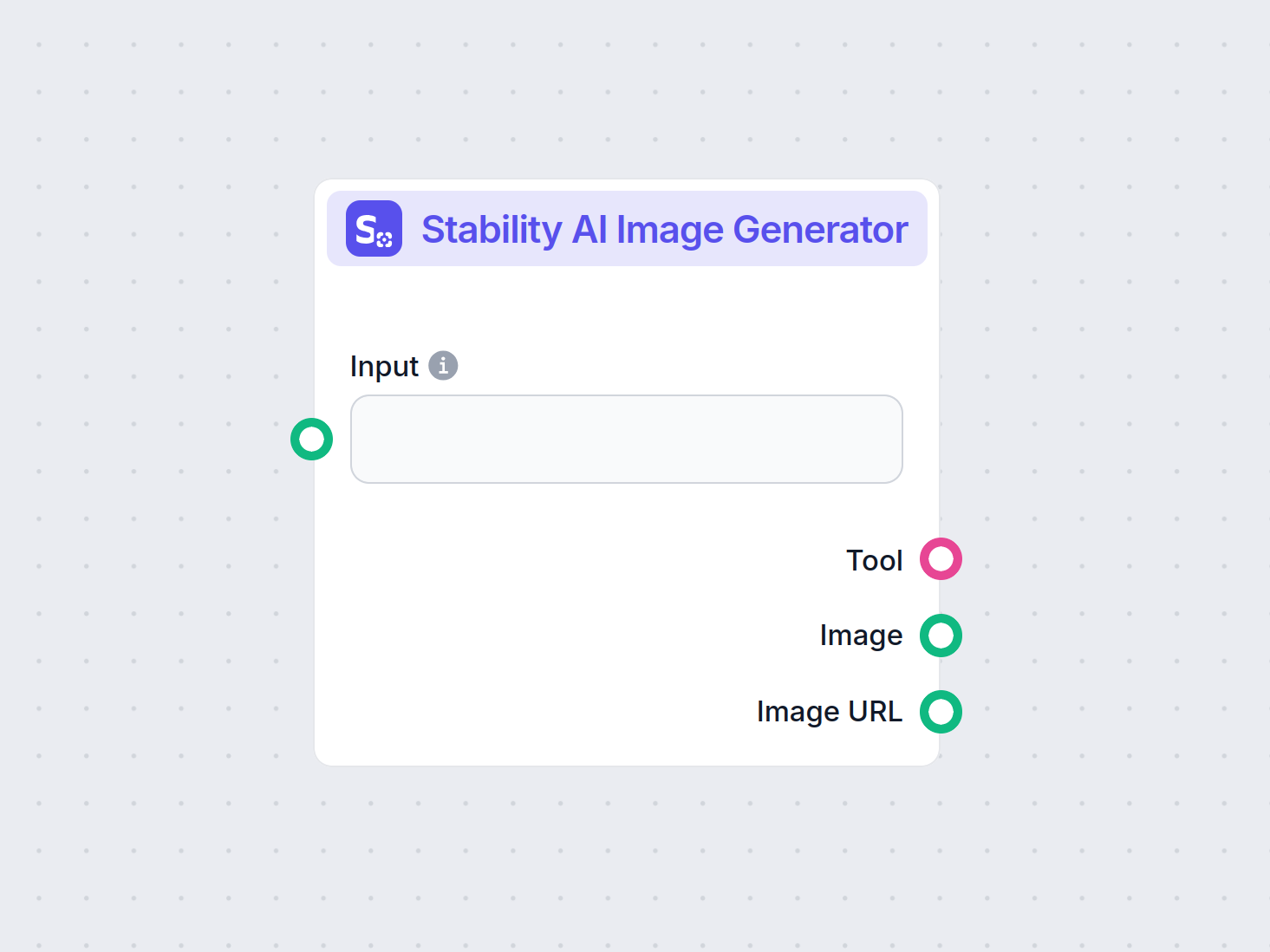

Stability AI画像生成コンポーネントでテキストプロンプトから高品質な画像を生成しましょう。Stable Diffusionモデルを搭載し、画像サイズ・モデル選択・CFGスケールなどのカスタマイズが可能。AIによる画像生成が必要なワークフローに最適です。...

Stability AI SD3 Largeの詳細なレビューをご覧ください。多様なテキストから画像へのプロンプトに対する強み・弱み・創造的な出力を分析し、このAI画像生成モデルの性能を発見しましょう。...