会話型AI

会話型AIとは、NLP(自然言語処理)、機械学習、その他の言語技術を用いて、コンピューターが人間の会話を模倣できるようにする技術を指します。チャットボット、バーチャルアシスタント、音声アシスタントなど、カスタマーサポート、ヘルスケア、小売業など幅広い分野で活用され、効率化やパーソナライズを実現します。...

OpenAI Whisperは、99言語に対応し、音声書き起こし・翻訳・言語識別をサポートする、高精度なオープンソースASRシステムです。堅牢なAI自動化を実現します。

OpenAI Whisperは、文脈によってモデルでもあり、システムでもあります。

Whisperの主な役割は、音声をテキスト出力に書き起こすことです。 得意とするのは以下の点です。

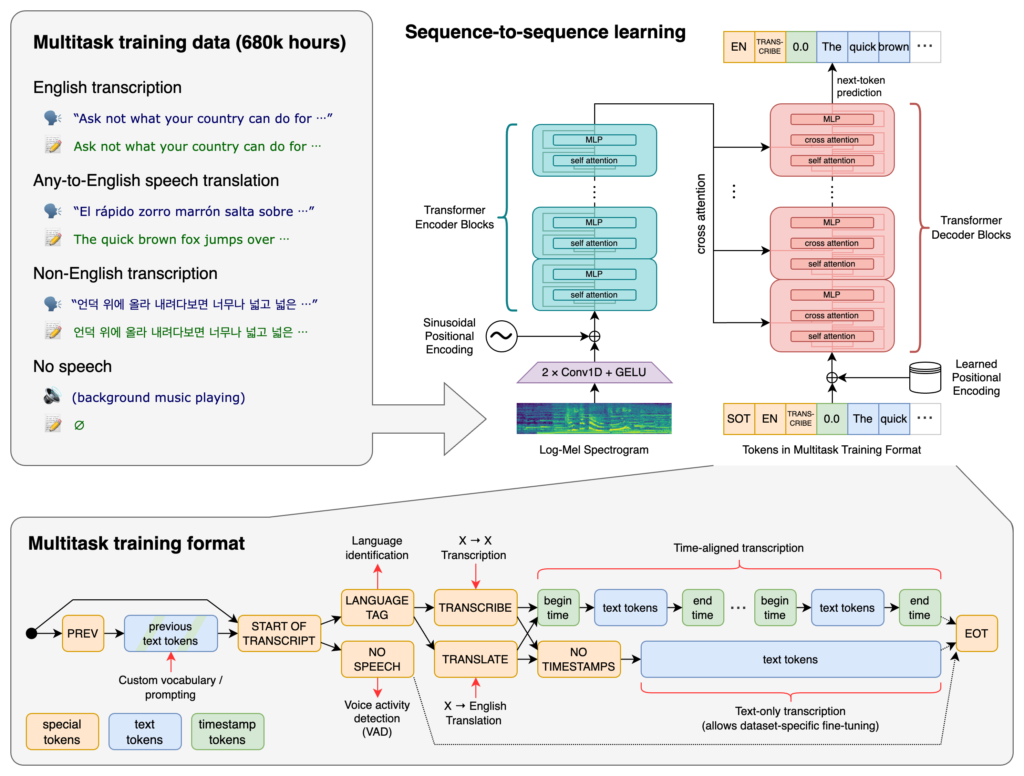

Whisperの中核はトランスフォーマーアーキテクチャ、特にエンコーダ・デコーダ型のモデルです。トランスフォーマーは、長いシーケンスの情報処理や文脈理解に優れたニューラルネットワークで、2017年の「Attention is All You Need」論文で提案され、NLP分野の基盤となっています。

Whisperの処理フロー:

Whisperは68万時間分のWeb上の教師ありデータで大規模に学習されました。その特徴:

99言語に対応し、多様な言語入力を扱える点が特長です。グローバルな用途や国際的なサービスに最適です。

膨大な教師ありデータで学習されており、書き起こし精度が非常に高いです。アクセントや方言、雑音環境での堅牢性も強みです。

書き起こし以外にも下記が可能です。

オープンソースソフトウェアとして公開されているため、

WhisperをチャットボットやAIアシスタントに組み込むことで、

WhisperはPythonライブラリとして実装されており、Pythonベースのプロジェクトにシームレスに統合できます。WhisperをPythonで利用するには、環境構築・依存ライブラリのインストール・各種関数の活用が必要です。

Whisperを使う前に、Python・PyTorch・FFmpeg・Whisperライブラリをセットアップします。

Pythonが未導入の場合は公式サイトからインストール。PyTorchはpipでインストールできます:

pip install torch

またはPyTorch公式サイトでOSやPythonバージョンに合った手順を確認してください。

Whisperでは音声処理のためFFmpegが必要です。OSごとにパッケージマネージャーでインストールします。

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS(Homebrew利用):

brew install ffmpeg

Windows(Chocolatey利用):

choco install ffmpeg

pipでWhisper Pythonパッケージをインストールします:

pip install -U openai-whisper

最新版をGitHubリポジトリから直接インストールする場合:

pip install git+https://github.com/openai/whisper.git

Developer Modeを有効にしてください:

Whisperには、サイズや能力が異なる複数のモデルが用意されています。tinyからlargeまであり、速度と精度に差があります。

| サイズ | パラメータ数 | 英語専用モデル | 多言語モデル | 必要VRAM | 相対速度 |

|---|---|---|---|---|---|

| tiny | 39M | tiny.en | tiny | ~1GB | ~32倍 |

| base | 74M | base.en | base | ~1GB | ~16倍 |

| small | 244M | small.en | small | ~2GB | ~6倍 |

| medium | 769M | medium.en | medium | ~5GB | ~2倍 |

| large | 1550M | N/A | large | ~10GB | 1倍 |

必要な環境が整ったら、PythonプロジェクトでWhisperを使い始められます。

まずWhisperライブラリをインポートし、モデルをロードします。

import whisper

# 希望するモデルを読み込む

model = whisper.load_model("base")

用途に合わせて"base"を他のモデル名に変更可能です。

Whisperのtranscribe関数で音声ファイルをテキスト化できます。

例:英語音声ファイルの書き起こし

# 音声ファイルを書き起こし

result = model.transcribe("path/to/english_audio.mp3")

# 書き起こし結果を表示

print(result["text"])

model.transcribe():音声ファイルを解析し、書き起こしやメタデータを辞書で返します。result["text"]:書き起こしテキストを取得。Whisperは多言語音声を英語に翻訳できます。

例:スペイン語音声を英語に翻訳

# スペイン語音声を書き起こし・英語に翻訳

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# 翻訳結果を表示

print(result["text"])

task="translate":逐語書き起こしではなく、英語への翻訳を指定。Whisperは自動で言語を検出できますが、明示的に指定すると精度や速度が向上します。

例:フランス語音声の書き起こし

# フランス語を指定して書き起こし

result = model.transcribe("path/to/french_audio.wav", language="fr")

# 書き起こし結果を表示

print(result["text"])

Whisperはdetect_languageメソッドで音声内の言語を判別できます。

例:言語検出

# 音声ファイルを読み込み・前処理

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# log-Melスペクトログラムへ変換

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# 言語を検出

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio():音声ファイルを読み込む。whisper.pad_or_trim():モデル入力長に合わせて音声を調整。whisper.log_mel_spectrogram():モデル用フォーマットに変換。model.detect_language():各言語の確率を返し、最も確率の高い言語を検出。書き起こし処理を詳細に制御したい場合は、低レベル関数やデコードオプションを利用できます。

decode関数の利用decode関数では、言語・タスク・タイムスタンプ有無などを細かく指定可能です。

例:カスタムデコードオプション

# デコードオプションを設定

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# 音声をデコード

result = whisper.decode(model, mel, options)

# 認識結果を表示

print(result.text)

Whisperを使ってマイクからのライブ音声をリアルタイムで書き起こすことも可能です。

例:マイク入力の書き起こし

import whisper

import sounddevice as sd

# モデルをロード

model = whisper.load_model("base")

# マイクから音声を録音

duration = 5 # 秒数

fs = 16000 # サンプリングレート

print("Recording...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisperは、OpenAIが開発した高度な自動音声認識(ASR)システムで、ディープラーニングを用いて話し言葉をテキストに書き起こします。99言語に対応し、書き起こし、翻訳、言語識別に優れています。

Whisperはトランスフォーマー型のエンコーダ・デコーダ構造を採用し、音声をlog-Melスペクトログラムに変換して言語モデルでテキスト出力します。68万時間の多言語・マルチタスクデータで学習され、高精度かつ堅牢です。

Whisperは多言語音声認識、音声翻訳、自動言語識別、アクセントやノイズへの強さ、カスタマイズや統合が可能なオープンソースといった特徴があります。

ハードウェア要件はモデルサイズによって異なります。小型モデル('tiny'など)は約1GBのVRAM、大型モデルは約10GB必要です。WhisperはGPUで高速動作しますが、CPUでも動作可能です(処理時間は長くなります)。

はい、WhisperはPythonライブラリとして実装されており、pipでインストール可能です。音声書き起こしや翻訳、リアルタイム音声アプリへの統合が簡単に行えます。

自動会議書き起こし、音声対応チャットボット、ライブ翻訳、アクセシビリティツール(字幕・支援技術)、コールセンター自動化、音声制御自動化システムなどで活用されています。

はい、Mozilla DeepSpeech、Kaldi、Wav2vecなどのオープンソースエンジンや、Google Cloud Speech-to-Text、Microsoft Azure AI Speech、AWS Transcribeなどの商用APIがあります。

はい、OpenAI Whisperはオープンソースで提供されており、開発者がカスタマイズやチューニング、独自プロダクトへの統合をライセンス制約なしで行えます。

高度な音声からテキスト変換機能をアプリケーションに組み込み、ワークフローを自動化し、OpenAI WhisperとFlowHuntでユーザー体験を向上させましょう。

会話型AIとは、NLP(自然言語処理)、機械学習、その他の言語技術を用いて、コンピューターが人間の会話を模倣できるようにする技術を指します。チャットボット、バーチャルアシスタント、音声アシスタントなど、カスタマーサポート、ヘルスケア、小売業など幅広い分野で活用され、効率化やパーソナライズを実現します。...

AIチャットボットの新しいチャットセッション開始時にユーザーを迎えるウェルカムメッセージの種類と設定方法について解説します。...

フローはFlowHuntの頭脳です。ノーコードのビジュアルビルダーで、最初のコンポーネントの配置からWebサイトへの統合、チャットボットの展開、テンプレートの活用まで、フローの作り方を学びましょう。...