Hugging Face Transformers(ハギングフェイス トランスフォーマーズ)

Hugging Face Transformersは、NLP(自然言語処理)、コンピュータビジョン、音声処理などの機械学習タスク向けに、トランスフォーマーモデルを簡単に実装できる先進的なオープンソースPythonライブラリです。数千の事前学習済みモデルにアクセスでき、PyTorch、TensorFlow、JAXといった...

Hugging Face Transformersは、NLP(自然言語処理)、コンピュータビジョン、音声処理などの機械学習タスク向けに、トランスフォーマーモデルを簡単に実装できる先進的なオープンソースPythonライブラリです。数千の事前学習済みモデルにアクセスでき、PyTorch、TensorFlow、JAXといった...

AIや機械学習におけるシーケンスモデリングを解説—テキスト、音声、DNAなどのデータで、RNN・LSTM・GRU・Transformerを使ってシーケンスを予測・生成。主要な概念、応用例、課題、最新研究を探ります。...

大規模言語モデル(LLM)によるテキスト生成は、機械学習モデルを高度に活用し、プロンプトから人間らしいテキストを生成する技術を指します。トランスフォーマーアーキテクチャによって強化されたLLMが、コンテンツ制作、チャットボット、翻訳などをどのように革新しているかを探ります。...

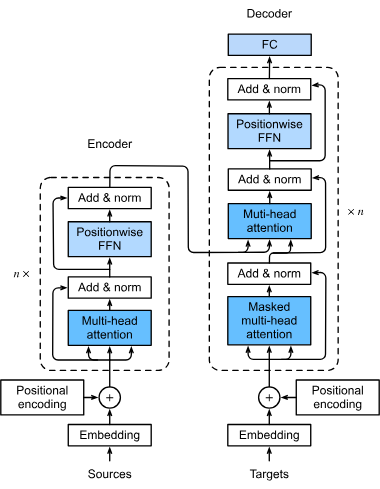

トランスフォーマーは、人工知能、特に自然言語処理に革命をもたらしたニューラルネットワークアーキテクチャです。2017年の「Attention is All You Need」で導入され、効率的な並列処理を可能にし、BERTやGPTなどのモデルの基盤となり、NLPや画像処理など幅広い分野に影響を与えています。...

大規模言語モデル(LLM)は、膨大なテキストデータで訓練されたAIの一種で、人間の言語を理解・生成・操作することができます。LLMはディープラーニングやトランスフォーマーニューラルネットワークを用い、テキスト生成、要約、翻訳など多様な業界でのタスクを実現します。...