Think MCP サーバー

Think MCP サーバーは、エージェント型AIワークフローのための構造化推論ツールを提供し、明示的な思考記録、ポリシー遵守、逐次的な意思決定、高度な批評・計画機能を実現します。ClaudeやFlowHunt、その他のエージェント型LLMとシームレスに統合でき、AIエージェントの行動の透明性と監査性を高めます。...

Think MCP サーバーは、エージェント型AIワークフローのための構造化推論ツールを提供し、明示的な思考記録、ポリシー遵守、逐次的な意思決定、高度な批評・計画機能を実現します。ClaudeやFlowHunt、その他のエージェント型LLMとシームレスに統合でき、AIエージェントの行動の透明性と監査性を高めます。...

人工知能(AI)における透明性とは、AIシステムの意思決定プロセス、アルゴリズム、データなどの運用に関する開示性と明確さを指します。これはAI倫理とガバナンスに不可欠であり、説明責任、信頼性、法規制遵守を確保します。...

AIの透明性とは、人工知能システムの仕組みや意思決定プロセスを関係者にとって理解可能にする実践です。その重要性、主要構成要素、規制枠組み、実装手法、課題、実際のユースケースについて学びましょう。...

AI監督機関は、AIの開発および導入を監視・評価・規制する役割を担う組織であり、責任ある倫理的かつ透明性のある利用を確保し、差別やプライバシー侵害、説明責任の欠如といったリスクを軽減します。...

AI規制フレームワークは、人工知能技術の開発、導入、利用を管理するために設計された、体系的なガイドラインや法的措置です。これらのフレームワークは、AIシステムが倫理的かつ安全に、社会的価値観と調和して運用されることを目的としています。データプライバシー、透明性、説明責任、リスク管理などの側面に対応し、責任あるAIイノベ...

AI倫理ガイドラインについて探求しましょう:AI技術の倫理的な開発、導入、利用を保証するための原則やフレームワーク。公正性、透明性、説明責任、国際基準、責任あるAIのための戦略について学べます。...

RIG Wikipediaアシスタントは、Wikipediaから正確な情報を取得するために設計されたツールです。研究やコンテンツ制作に最適で、信頼できる情報源に基づいた回答を迅速に提供します。正確なデータと透明性で知識を深めましょう。...

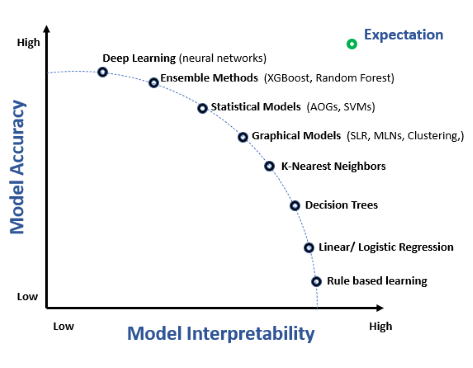

説明可能なAI(XAI)は、AIモデルの出力を人間が理解できるようにするための一連の手法とプロセスです。これにより、複雑な機械学習システムにおける透明性、解釈性、説明責任が促進されます。...

アルゴリズムの透明性とは、アルゴリズムの内部動作や意思決定プロセスについての明確さと開示性を指します。AIや機械学習の分野では、説明責任、信頼性、法的・倫理的基準への準拠を確保するために非常に重要です。...

コンプライアンス報告は、組織が内部方針、業界基準、規制要件への準拠を文書化し、証拠として提示するための、構造化された体系的なプロセスです。リスク管理、透明性、法的保護をさまざまな分野で実現します。...

AIモデルのベンチマークは、標準化されたデータセット、タスク、パフォーマンス指標を用いて人工知能モデルを体系的に評価・比較することです。これにより客観的な評価、モデル間の比較、進捗管理が可能となり、AI開発の透明性と標準化を促進します。...

FlowHuntのマルチソースAIアンサージェネレーターで、複数のフォーラムやデータベースからリアルタイムかつ信頼性の高い情報を取得できる強力なツールをご体験ください。学術、医療、一般的な質問に最適で、透明性のために出典へのリンクを付与し、必要に応じて接続先ツールもカスタマイズ可能です。...

モデルの解釈性とは、機械学習モデルが行う予測や意思決定を理解し、説明し、信頼できる能力を指します。これはAIにとって重要であり、特に医療、金融、自律システムにおける意思決定の際に不可欠です。複雑なモデルと人間の理解力のギャップを埋める役割を果たします。...

欧州AI法がチャットボットにどのような影響を及ぼすのかを解説。リスク分類、コンプライアンス要件、期限、不遵守時の罰則などを詳しく紹介し、倫理的で透明性と安全性の高いAI対話を実現するための情報をお届けします。...

AIの説明可能性とは、人工知能システムが行った決定や予測を理解し、解釈できる能力を指します。AIモデルがより複雑になるにつれて、説明可能性はLIMEやSHAPなどの手法を通じて透明性、信頼性、規制遵守、バイアスの軽減、モデルの最適化を実現します。...