LLM 오픈AI

FlowHunt는 OpenAI를 포함한 수십 가지 텍스트 생성 모델을 지원합니다. AI 도구와 챗봇에서 ChatGPT를 사용하는 방법을 알아보세요....

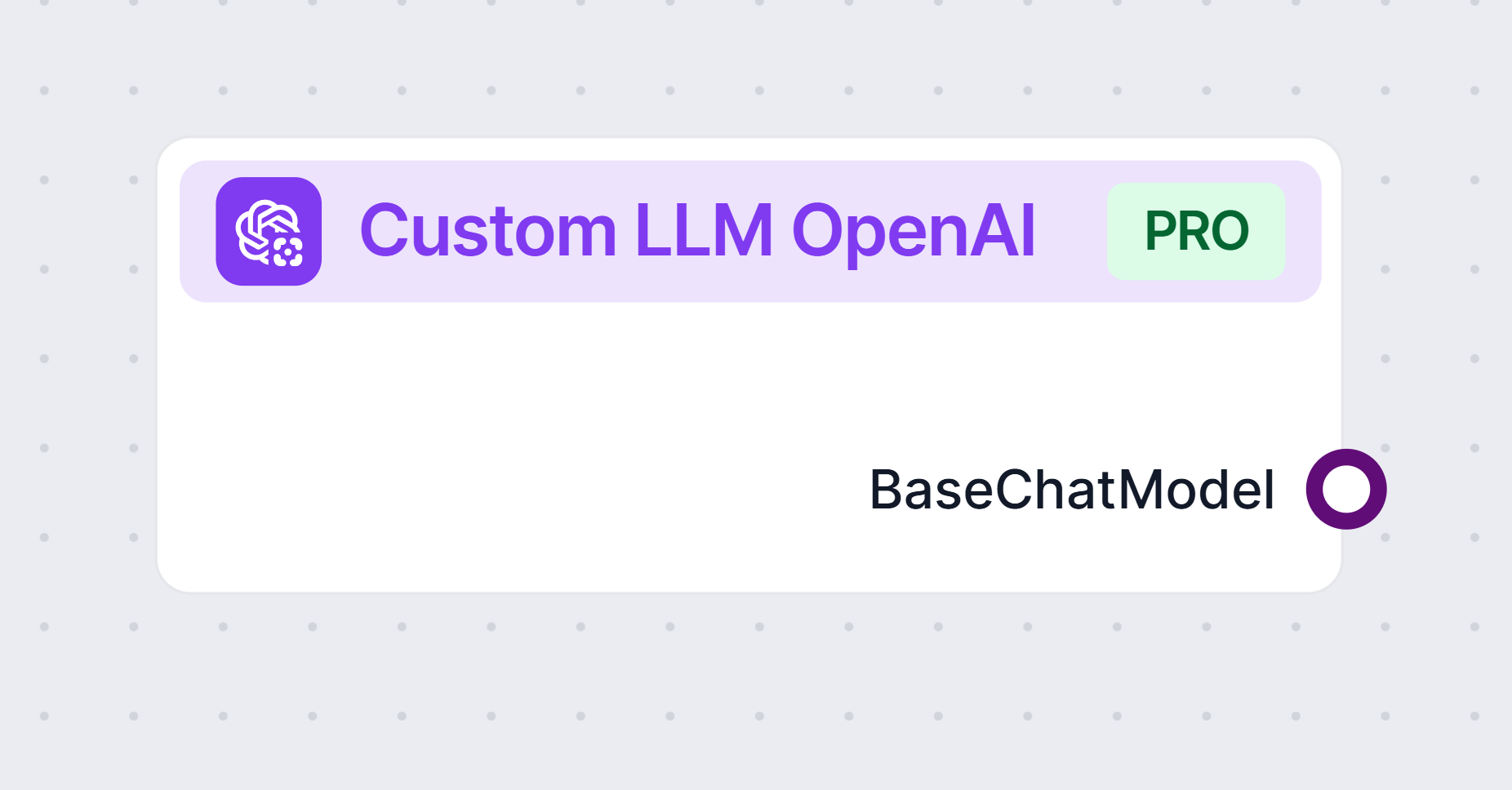

Custom OpenAI LLM 컴포넌트는 OpenAI 호환 언어 모델을 직접 연결·설정하여 유연하고 고도화된 대화형 AI 플로우를 구축할 수 있도록 합니다.

컴포넌트 설명

Custom LLM OpenAI 컴포넌트는 OpenAI API와 호환되는 대형 언어 모델과 상호작용할 수 있는 유연한 인터페이스를 제공합니다. 이 컴포넌트는 OpenAI뿐 아니라 JinaChat, LocalAI, Prem과 같은 대안 제공업체의 모델도 지원합니다. 다양한 자연어 처리 작업이 필요한 AI 워크플로우에 적합하도록 고도로 설정할 수 있도록 설계되었습니다.

이 컴포넌트는 AI 워크플로우와 OpenAI API 표준을 따르는 언어 모델 간의 다리 역할을 합니다. 모델 제공자, API 엔드포인트, 기타 매개변수를 직접 지정하여 워크플로우 내에서 텍스트 생성, 채팅, 기타 언어 기반 출력 생성 및 처리가 가능합니다. 콘텐츠 요약, 질문 답변, 창의적 텍스트 생성, 기타 NLP 작업 등 다양한 용도에 맞게 맞춤 설정할 수 있습니다.

다음과 같은 여러 매개변수로 컴포넌트의 동작을 제어할 수 있습니다:

| 매개변수 | 타입 | 필수 여부 | 기본값 | 설명 |

|---|---|---|---|---|

| 최대 토큰(Max Tokens) | int | 아니오 | 3000 | 생성되는 텍스트 출력의 최대 길이를 제한합니다. |

| 모델 이름(Model Name) | string | 아니오 | (비어 있음) | 사용할 모델명을 지정합니다(예: gpt-3.5-turbo). |

| OpenAI API Base | string | 아니오 | (비어 있음) | JinaChat, LocalAI, Prem 등 사용자 지정 API 엔드포인트를 설정할 수 있습니다. 비워두면 기본 OpenAI 사용. |

| API 키(API Key) | string | 예 | (비어 있음) | 선택한 언어 모델 제공업체에 접근하기 위한 비밀 API 키입니다. |

| 온도(Temperature) | float | 아니오 | 0.7 | 출력의 창의성을 조절합니다. 값이 낮을수록 결과가 더 결정론적입니다. 범위: 0~1. |

| 캐시 사용(Use Cache) | bool | 아니오 | true | 쿼리 결과를 캐싱하여 효율성을 높이고 비용을 줄일 수 있습니다. |

참고: 이 모든 설정은 고급 옵션으로, 모델의 동작과 통합을 세밀하게 제어할 수 있습니다.

입력:

이 컴포넌트에는 입력 핸들이 없습니다.

출력:

BaseChatModel 객체를 생성하며, 이후 워크플로우의 다른 컴포넌트에서 추가 처리나 상호작용에 사용할 수 있습니다.| 기능 | 설명 |

|---|---|

| 지원 제공자 | OpenAI, JinaChat, LocalAI, Prem 또는 모든 OpenAI API 호환 서비스 |

| 출력 타입 | BaseChatModel |

| API 엔드포인트 | 설정 가능 |

| 보안 | API 키 필요(비밀 유지) |

| 사용성 | 파워 유저를 위한 고급 설정 지원, 대부분의 사용 사례에서는 기본값으로 충분 |

이 컴포넌트는 OpenAI뿐만 아니라 대안 제공자를 사용하는 경우에도, 유연하고 강력하며 맞춤 설정 가능한 LLM 기능을 AI 워크플로우에 통합하려는 모든 분께 이상적입니다.

Custom OpenAI LLM 컴포넌트는 JinaChat, LocalAI, Prem 등 OpenAI 호환 언어 모델을 API 인증 정보와 엔드포인트를 제공하여 연결할 수 있게 해주며, AI의 기능을 완전히 제어할 수 있도록 합니다.

모델 이름, API 키, API 엔드포인트, 온도(temperature), 최대 토큰 수, 결과 캐싱 활성화 여부 등을 설정하여 성능과 유연성을 최적화할 수 있습니다.

네, 해당 모델이 OpenAI API 인터페이스를 사용한다면 JinaChat, LocalAI, Prem과 같은 대체 모델도 연결할 수 있습니다.

API 키는 모델 연결에 필요하며, 플랫폼에서 안전하게 처리되어 무단으로 노출되거나 공유되지 않습니다.

네, 캐싱을 활성화하면 이전 결과를 저장 및 재사용하여 반복 쿼리의 지연 시간과 API 사용량을 줄일 수 있습니다.

FlowHunt는 OpenAI를 포함한 수십 가지 텍스트 생성 모델을 지원합니다. AI 도구와 챗봇에서 ChatGPT를 사용하는 방법을 알아보세요....

FlowHunt는 Claude를 비롯한 Anthropic의 다양한 AI 모델을 지원합니다. 맞춤화 가능한 설정을 통해 AI 도구와 챗봇에서 Claude를 활용하는 방법을 알아보세요....

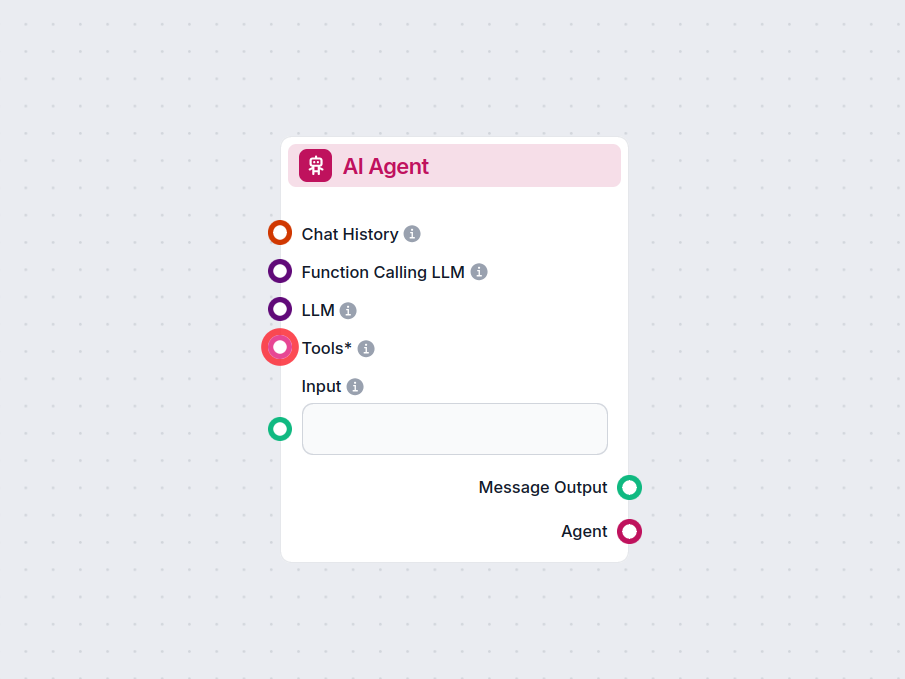

FlowHunt의 AI 에이전트 컴포넌트는 워크플로우에 자율적인 의사결정 및 도구 활용 기능을 부여합니다. 대형 언어 모델을 활용하고 다양한 도구와 연결하여 작업을 해결하고, 목표를 따르며, 지능적인 응답을 제공합니다. 고급 자동화 및 인터랙티브 AI 솔루션 구축에 이상적입니다....