검색 기반 생성(RAG) vs. 캐시 기반 생성(CAG)

AI에서 검색 기반 생성(RAG)과 캐시 기반 생성(CAG)의 주요 차이점을 알아보세요. RAG는 실시간 정보를 동적으로 검색해 유연하고 정확한 답변을 제공하며, CAG는 미리 캐시된 데이터를 사용해 빠르고 일관성 있는 결과를 제공합니다. 어떤 방식이 프로젝트에 적합한지, 실질적 사용 ...

캐시 증강 생성(CAG)은 정적 지식을 사전 로드하여 대규모 언어 모델의 효율성을 높이고, 지연 시간을 줄이며, 정적·저지연 작업에 대한 아키텍처를 단순화합니다.

캐시 증강 생성(CAG)은 미리 계산된 키-값(KV) 캐시 형태로 지식을 사전 로드하여 대규모 언어 모델(LLM)의 성능과 효율을 향상시키는 혁신적인 접근법입니다.

실행 중에 외부 지식을 동적으로 검색하는 Retrieval Augmented Generation(RAG)과 달리, CAG는 모든 관련 지식을 추론 전에 모델의 확장된 컨텍스트 윈도우에 직접 임베딩하여 검색 단계를 완전히 제거합니다. 이러한 사전 로딩 전략을 통해 LLM은 미리 계산된 정보를 활용해 응답을 생성할 수 있어 지연 시간이 크게 단축되고 시스템 아키텍처가 간소화됩니다.

처리된 지식을 키-값 캐시에 저장함으로써, CAG는 모델이 쿼리에 답변하는 데 필요한 컨텍스트에 즉시 접근할 수 있도록 보장합니다. 이 접근법은 지식 베이스가 정적이고 비교적 작거나, 저지연이 중요한 경우에 특히 유리합니다.

CAG는 세 가지 주요 단계로 운영됩니다:

추론 전에 모든 관련 문서 또는 데이터셋을 모델의 컨텍스트 윈도우에 사전 로드합니다.

사전 로드된 콘텐츠는 키-값(KV) 캐시로 처리되어, 모델의 내부 지식 표현을 포착합니다. 예시:

def preprocess_knowledge(model, tokenizer, prompt):

input_ids = tokenizer.encode(prompt, return_tensors="pt").to(model.device)

past_key_values = DynamicCache()

outputs = model(input_ids=input_ids, past_key_values=past_key_values, use_cache=True)

return outputs.past_key_values

이 단계는 모델이 미리 처리된 지식에 즉시 접근할 수 있도록 하여 실시간 검색이 필요 없게 만듭니다.

쿼리가 들어오면, 미리 계산된 KV 캐시가 쿼리 입력과 결합됩니다.

모델은 캐시된 지식과 쿼리만을 바탕으로 응답을 생성하며, 추가적인 지식 검색 연산을 피합니다. 예시:

def generate_response(model, query, kv_cache):

input_ids = tokenizer.encode(query, return_tensors="pt").to(model.device)

output_ids = model(input_ids=input_ids, past_key_values=kv_cache, use_cache=True)

return tokenizer.decode(output_ids)

새로운 쿼리가 처리될수록 캐시가 커집니다. 리셋 메커니즘을 통해 캐시를 원래 길이로 잘라 성능을 유지하고, 이후 쿼리도 의도된 컨텍스트 내에서 평가되도록 합니다. 캐시 리셋 예시:

def clean_up(kv_cache, original_length):

for i in range(len(kv_cache.key_cache)):

kv_cache.key_cache[i] = kv_cache.key_cache[i][:, :, :original_length, :]

kv_cache.value_cache[i] = kv_cache.value_cache[i][:, :, :original_length, :]

저지연

실시간 검색이 필요 없으므로, CAG는 RAG보다 더 빠른 응답 속도를 제공합니다. 이는 시간에 민감한 애플리케이션에 이상적입니다.

정확도 향상

모든 관련 문서를 사전 로드함으로써, CAG는 포괄적인 데이터셋을 모델이 처리하도록 하여 컨텍스트 누락이나 검색 오류 위험을 줄입니다.

단순화된 아키텍처

복잡한 검색 파이프라인이 필요한 RAG와 달리, CAG의 아키텍처는 간소화되어 시스템 복잡성과 유지 관리 부담이 줄어듭니다.

확장 시 효율성

지식이 사전 로드되어 캐시된 후에는, 이후 쿼리들은 최소한의 연산으로 처리되어 동일한 지식 도메인 내에서 반복 쿼리에 효율적입니다.

컨텍스트 윈도우 크기

CAG는 지식을 사전 로드하기 위해 모델의 컨텍스트 윈도우에 의존합니다. 현재 LLM은 최대 128,000 토큰의 컨텍스트 윈도우를 지원하며, 이는 사전 로드할 수 있는 지식의 양을 제한합니다.

지식 베이스 크기

CAG는 정적이고 관리 가능한 지식 베이스에 가장 적합합니다. 데이터셋이 크거나 동적인 경우, 모든 관련 정보를 컨텍스트 윈도우에 담기 어려울 수 있습니다.

정적 지식

CAG는 추론 중 지식 베이스가 변하지 않는다는 가정을 합니다. 실시간 업데이트나 동적 지식 통합이 필요한 경우에는 효과가 떨어집니다.

비용 문제

큰 컨텍스트 윈도우는 사전 로딩 시 연산 비용이 증가하므로, 지식 베이스가 자주 변경되거나 업데이트가 빈번한 경우 경제성이 떨어질 수 있습니다.

CAG는 지식 베이스가 정적이고 관리 가능하며, 저지연이 중요한 상황에 주로 적용됩니다:

고객 지원 챗봇

예시: 소프트웨어 제품의 일반적인 문제 해결 단계를 사전 로드하여 사용자에게 즉각적인 응답 제공

효과: 검색 오류를 제거하고 응답 속도를 높임

문서 분석

예시: 금융 기관이 분기 보고서, 법률 회사가 규제 문서를 쿼리하는 경우

효과: 모든 관련 문서를 사전 로드하여 일관되고 정확한 응답 보장

헬스케어 어시스턴트

예시: 환자 질의 지원을 위해 의료 가이드라인 사전 로드

효과: 다중 턴 대화에서도 연속성과 정확한 참조를 유지

교육 및 트레이닝

예시: 기업 교육 프로그램에서 자주 묻는 질문 답변

효과: 배포가 간편하며 일관된 응답 제공

| 특징 | CAG | RAG |

|---|---|---|

| 지식 처리 방식 | 컨텍스트 윈도우에 지식을 사전 로드 | 실행 시 지식을 동적으로 검색 |

| 시스템 복잡성 | 단순화, 검색 파이프라인 불필요 | 검색을 위한 추가 컴포넌트 필요 |

| 지연 시간 | 검색 단계가 없어 낮음 | 실시간 검색 과정으로 인해 더 높음 |

| 확장성 | 컨텍스트 윈도우 크기에 제한 | 대규모·동적 데이터셋에 잘 확장됨 |

| 오류 위험 | 검색 오류 없음 | 검색 및 랭킹 오류 취약 |

| 최적 사용 사례 | 정적·저지연 작업에 적합 | 동적·대규모·자주 업데이트되는 작업에 적합 |

인사 시스템

한 회사가 CAG를 활용해 직원 정책을 모델에 사전 로드합니다. 직원들은 특정 가이드라인을 쿼리할 수 있고, 응답은 즉시 생성됩니다.

법률 어시스턴트

법률 어시스턴트가 관련 판례를 모델의 컨텍스트에 사전 로드하여 검색 시스템 없이 빠르게 법률 질의에 답변합니다.

고객 서비스

SaaS 제품의 챗봇이 CAG로 FAQ 및 문제 해결 가이드를 사전 로드하여 원활하고 빠른 고객 응대를 제공합니다.

뉴스 집계

뉴스 앱이 RAG를 사용해 최신 기사를 검색·요약하여 사용자 쿼리에 가장 적합한 정보를 동적으로 제공합니다.

이커머스 검색

RAG를 통해 대규모·자주 업데이트되는 카탈로그에서 상품 정보 및 재고를 검색합니다.

연구 플랫폼

과학 연구 플랫폼이 외부 대형 데이터베이스에서 관련 논문과 연구를 RAG로 검색합니다.

아래 Python 코드 스니펫은 CAG를 위해 모델에 지식을 사전 로드하는 방법을 보여줍니다:

def preprocess_knowledge(model, tokenizer, prompt):

input_ids = tokenizer.encode(prompt, return_tensors="pt").to(model.device)

past_key_values = DynamicCache()

outputs = model(input_ids=input_ids, past_key_values=past_key_values, use_cache=True)

return outputs.past_key_values

이 사전 로딩 메커니즘은 외부 검색 없이 쿼리를 처리할 수 있게 해주어, 효율적이고 저지연 성능을 실현합니다.

정적 지식 베이스

지식 베이스가 자주 변경되지 않는 경우에 이상적입니다.

저지연 애플리케이션

고객 지원, 교육, 헬스케어 등 신속한 응답이 필요한 시스템에 적합합니다.

비용 효율적 시나리오

사전 로드된 지식이 여러 쿼리에서 일관되게 사용되는 경우, 연산 오버헤드를 줄여 경제적입니다.

CAG는 속도, 단순성, 일관성이 요구되는 작업에서 RAG의 효율적인 대안이지만, 지식 베이스의 크기와 정적 특성에 제한받습니다.

저자: Guangyuan Liu, Yinqiu Liu, Jiacheng Wang, Hongyang Du, Dusit Niyato, Jiawen Kang, Zehui Xiong

이 논문은 모바일 엣지 LLM 배포에서 제한된 연산 자원 및 높은 검색 지연 등 문제를 다룹니다. 저자는 사용자 컨텍스트, 문서 유사성, 캐시 미스 오버헤드를 고려한 딥러닝 기반 적응형 컨텍스트 캐싱(ACC) 프레임워크를 제안합니다. 실험 결과, ACC는 11회 학습 후 80% 이상의 캐시 적중률을 달성하고, 전통적 방법 대비 검색 지연을 최대 40% 줄이며, 로컬 캐싱 오버헤드를 최대 55%까지 감소시켰습니다. 이 연구는 엣지 LLM 시스템에서 ACC의 효율성 향상 가능성을 보여줍니다.

논문 읽기

저자: Hanchen Li, Yuhan Liu, Yihua Cheng, Kuntai Du, Junchen Jiang

이 연구는 LLM 애플리케이션에서 특히 반복 입력 텍스트에 대해 사전 채우기 지연을 줄이기 위한 키-값(KV) 캐시 재사용을 탐구합니다. 공용 클라우드 서비스에서 저장·처리 시 이 캐시 재사용이 경제적으로도 가능한지 분석합니다. 저자들은 다양한 워크로드 매개변수에 따라 KV 캐시 저장·재사용의 클라우드 비용(연산, 저장, 네트워크)을 평가하는 검증된 분석 모델을 제안하였고, 컨텍스트가 긴 워크로드에서 캐시 재사용이 지연과 비용을 모두 절감함을 보여줍니다.

논문 읽기

저자: Shiju Zhao, Junhao Hu, Rongxiao Huang, Jiaqi Zheng, Guihai Chen

이 논문은 멀티모달 LLM(MLLM) 추론에서 비효율성을 해결하는 위치 독립적 멀티모달 컨텍스트 캐싱 시스템(MPIC)을 소개합니다. 기존 시스템은 컨텍스트가 조금만 달라도 전체 KV 캐시를 다시 계산하여 비효율적입니다. MPIC는 캐시를 로컬 또는 원격에 저장하고, 추론 중 캐시 계산·로딩을 병렬화합니다. 재사용 및 재계산 메커니즘을 통합해 정확도 저하를 방지하면서 기존 방법 대비 응답 시간을 최대 54% 단축합니다. 이 연구는 멀티모달 LLM 서비스 시스템의 효율성 향상 가능성을 강조합니다.

논문 읽기

캐시 증강 생성(CAG)은 정적 지식을 미리 계산된 키-값(KV) 캐시에 사전 로드하여 대규모 언어 모델(LLM)의 성능을 향상시키는 방법입니다. 실행 시 외부 지식을 가져오는 RAG와 달리, CAG는 모든 관련 정보를 미리 임베딩하여 지연 시간을 줄이고 AI 시스템 아키텍처를 단순화합니다.

CAG는 추론 전에 필요한 모든 지식을 모델의 컨텍스트 윈도우에 사전 로드하고, 실시간 검색이 필요 없기 때문에 저지연을 보장합니다. 반면 RAG는 실행 시점에 관련 정보를 동적으로 검색하므로 검색 오류와 높은 지연 시간이 발생할 수 있지만, 동적이거나 자주 변경되는 지식 베이스에 더 적합합니다.

CAG의 주요 장점은 저지연, 포괄적 사전 로딩을 통한 정확도 향상, 단순화된 시스템 아키텍처, 그리고 정적 지식 도메인 내 반복 쿼리에 대한 효율성입니다.

CAG는 모델의 컨텍스트 윈도우 최대 크기(현재 최대 128,000 토큰)에 제한을 받으며, 정적이고 관리 가능한 지식 베이스에 가장 적합합니다. 동적 데이터셋이나 빈번한 업데이트가 필요한 상황에서는 효과가 떨어집니다. 또한, 큰 컨텍스트 윈도우는 사전 로딩 시 연산 비용이 증가할 수 있습니다.

CAG는 고객 지원 챗봇, 문서 분석, 헬스케어 어시스턴트, 교육 FAQ, 인사 정책 질의, 법률 어시스턴트 등 지식 베이스가 자주 변경되지 않고 즉각적인 응답이 필요한 정적·저지연 애플리케이션에 이상적입니다.

FlowHunt와 함께 CAG 및 기타 AI 도구의 강력함을 경험하세요. 저지연, 캐시 증강 솔루션이 비즈니스를 어떻게 혁신할 수 있는지 데모를 예약해보세요.

AI에서 검색 기반 생성(RAG)과 캐시 기반 생성(CAG)의 주요 차이점을 알아보세요. RAG는 실시간 정보를 동적으로 검색해 유연하고 정확한 답변을 제공하며, CAG는 미리 캐시된 데이터를 사용해 빠르고 일관성 있는 결과를 제공합니다. 어떤 방식이 프로젝트에 적합한지, 실질적 사용 ...

검색 기반 생성(RAG, Retrieval Augmented Generation)은 전통적인 정보 검색 시스템과 생성형 대규모 언어 모델(LLM)을 결합한 고급 AI 프레임워크로, 외부 지식을 통합하여 더 정확하고 최신이며 맥락에 맞는 텍스트를 생성할 수 있도록 합니다....

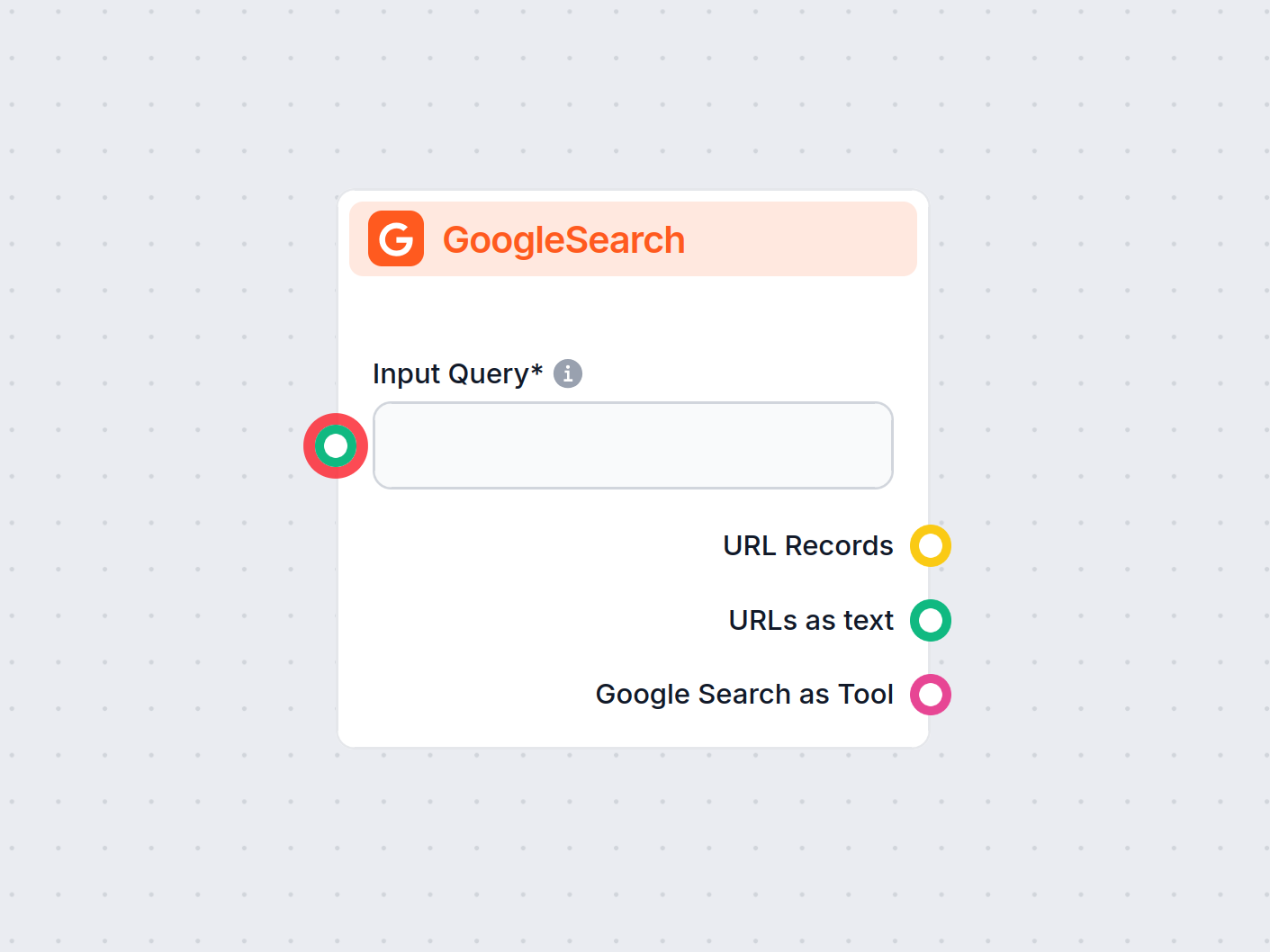

FlowHunt의 GoogleSearch 컴포넌트는 검색 기반 생성(RAG)을 활용하여 Google에서 최신 지식을 가져와 챗봇의 정확성을 향상시킵니다. 언어, 국가, 쿼리 접두사 등 다양한 옵션을 통해 결과를 정밀하게 제어할 수 있어, 더욱 정확하고 관련성 높은 답변을 제공합니다....