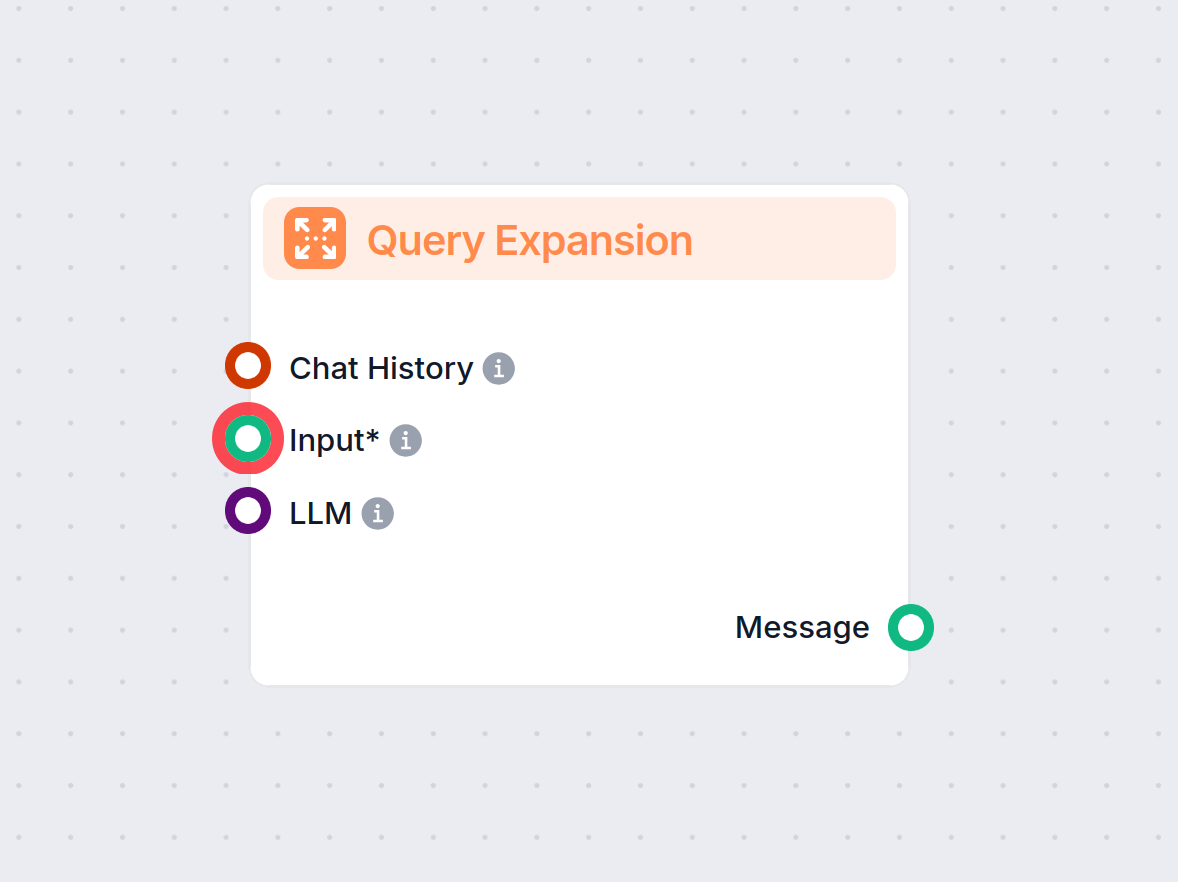

쿼리 확장

쿼리 확장은 사용자의 원래 쿼리에 용어나 맥락을 추가하여 문서 검색을 개선하고, 특히 RAG(검색 증강 생성) 시스템에서 더 정확하고 상황에 맞는 응답을 제공하는 과정입니다....

문서 재정렬은 사용자의 쿼리에 가장 관련성이 높은 문서를 우선시하여 검색 결과를 다듬어, AI 및 RAG 시스템의 정확도를 향상시킵니다.

문서 재정렬은 쿼리와의 관련성에 따라 검색된 문서의 순서를 다시 정렬하여 검색 결과를 세밀하게 다듬는 과정입니다. 쿼리 확장은 연관된 용어를 추가하여 검색 범위를 넓히고 재현율을 높이며, 모호성을 해소합니다. 두 기술을 RAG 시스템에 결합하면 검색 정확도와 답변 품질이 향상됩니다.

문서 재정렬은 사용자의 쿼리와의 관련성에 따라 검색된 문서의 순서를 다시 정렬하는 과정입니다. 초기 검색 이후, 각 문서의 관련성을 더 정밀하게 평가하고, 가장 중요한 문서가 우선시되도록 결과를 다듬습니다.

검색 증강 생성(RAG)은 대형 언어 모델(LLM)과 정보 검색 시스템을 결합한 고급 프레임워크입니다. RAG에서는 사용자가 쿼리를 입력하면, 시스템이 방대한 지식 베이스에서 관련 문서를 검색하여 LLM에 제공하고, 이를 바탕으로 더 사실적이고 맥락에 맞는 답변을 생성합니다. 이 방식은 AI가 생성하는 콘텐츠의 정확성과 관련성을 데이터에 기반하여 높여줍니다.

정의

쿼리 확장은 정보 검색에서 검색 쿼리의 효과를 높이기 위해 사용되는 기술입니다. 이는 원래의 쿼리에 의미적으로 연관된 용어나 구를 추가하여 확장하는 과정을 포함합니다. 주된 목적은 사용자의 의도와 관련 문서의 언어적 차이를 극복하여, 더 적절한 정보를 검색하는 데 있습니다.

동작 원리

실제로 쿼리 확장은 여러 방법으로 구현될 수 있습니다:

이처럼 쿼리를 확장하면 검색 시스템이 더 넓은 범위의 문서를 포착할 수 있어, 용어나 표현의 차이로 인해 놓칠 수 있는 문서까지 검색할 수 있습니다.

재현율 향상

재현율은 검색 시스템이 모든 관련 문서를 얼마나 잘 찾아내는지를 의미합니다. 쿼리 확장은 다음과 같이 재현율을 높입니다:

쿼리 모호성 해결

사용자는 종종 짧거나 모호한 쿼리를 입력합니다. 쿼리 확장은 다음과 같은 도움을 줍니다:

문서 매칭 강화

추가적인 연관 용어를 포함함으로써, 검색 시스템이 서로 다른 어휘를 사용한 문서와 쿼리 간의 매칭 가능성을 높여, 전반적인 검색 효율성을 향상시킵니다.

PRF란?

의사 관련 피드백은, 초기 검색에서 상위에 랭크된 문서들이 관련성이 높다고 가정하고, 이 문서들에서 중요 용어를 추출하여 원래 쿼리를 확장하는 자동 쿼리 확장 방법입니다.

PRF의 동작 원리

장점과 단점

대형 언어 모델 활용

최근 AI의 발전으로, GPT-3나 GPT-4 같은 LLM은 맥락과 의미를 이해하여 정교한 쿼리 확장을 생성할 수 있습니다.

LLM 기반 확장의 동작 원리

예시

원래 쿼리:

“매출 증가에 기여한 가장 중요한 요인은 무엇입니까?”

LLM 생성 답변:

“해당 회계연도에는 성공적인 마케팅 캠페인, 제품 다각화, 고객 만족 이니셔티브, 전략적 가격 정책, 기술 투자 등 여러 핵심 요인이 회사 매출 증가에 기여했습니다.”

확장 쿼리:

“원래 쿼리: 매출 증가에 기여한 가장 중요한 요인은 무엇입니까?

가상 답변: [LLM 생성 답변]”

장점

과제

단계별 프로세스

RAG 시스템에서의 이점

재정렬이 필요한 이유

개요

크로스 인코더는 쿼리와 문서를 쌍으로 입력받아 관련성 점수를 출력하는 신경망 모델입니다. 쿼리와 문서를 별도로 인코딩하는 바이 인코더와 달리, 둘을 함께 인코딩하여 상호작용을 깊이 있게 포착합니다.

동작 원리

장점

과제

ColBERT란?

ColBERT는 효율성과 효과를 모두 추구하는 검색 모델로, BERT 기반 토큰 단위 인코딩과 지연 상호작용 방식을 활용합니다. 쿼리와 문서 토큰을 각각 인코딩하고, 점수 산정 과정에서 토큰 간의 유사도를 비교합니다.

동작 원리

장점

활용 사례

개요

FlashRank는 최신 크로스 인코더 기반의 경량·고속 문서 재정렬 라이브러리입니다. 기존 파이프라인에 쉽게 통합할 수 있으며, 최소한의 오버헤드로 재정렬 성능을 개선합니다.

특징

사용 예시

from flashrank import Ranker, RerankRequest

query = '매출 증가에 기여한 가장 중요한 요인은 무엇입니까?'

ranker = Ranker(model_name="ms-marco-MiniLM-L-12-v2")

rerank_request = RerankRequest(query=query, passages=documents)

results = ranker.rerank(rerank_request)

이점

프로세스

고려사항

상호 보완적 기술

결합의 장점

예시 워크플로우

LLM을 활용한 쿼리 확장:

def expand_query(query):

prompt = f"Provide additional related queries for: '{query}'"

expanded_queries = llm.generate(prompt)

expanded_query = ' '.join([query] + expanded_queries)

return expanded_query

초기 검색:

documents = vector_db.retrieve_documents(expanded_query)

문서 재정렬:

from sentence_transformers import CrossEncoder

cross_encoder = CrossEncoder('cross-encoder/ms-marco-MiniLM-L-6-v2')

pairs = [[query, doc.text] for doc in documents]

scores = cross_encoder.predict(pairs)

ranked_docs = [doc for _, doc in sorted(zip(scores, documents), reverse=True)]

상위 문서 선택:

top_documents = ranked_docs[:top_k]

LLM으로 답변 생성:

context = '\n'.join([doc.text for doc in top_documents])

prompt = f"Answer the following question using the context provided:\n\nQuestion: {query}\n\nContext:\n{context}"

response = llm.generate(prompt)

모니터링 및 최적화

시나리오

한 기업이 제품 및 서비스 관련 고객 문의를 처리하기 위해 AI 챗봇을 운영합니다. 고객들은 다양한 용어나 표현으로 질문을 합니다.

과제

구현

효과

시나리오

연구자들이 연구에 필요한 논문, 데이터, 인사이트를 찾기 위해 AI 어시스턴트를 활용합니다.

과제

구현

문서 재정렬은 초기 검색 후 사용자의 쿼리와의 관련성에 따라 검색된 문서의 순서를 다시 정렬하는 과정입니다. 이를 통해 가장 관련성 높고 유용한 문서가 우선시되어 AI 기반 검색 및 챗봇의 품질이 향상됩니다.

RAG 시스템에서는 크로스 인코더나 ColBERT와 같은 모델을 활용하여, 1차 검색 후 각 문서가 사용자의 쿼리와 얼마나 관련성이 있는지 평가합니다. 이 과정은 대형 언어 모델에 제공할 문서 집합을 세밀하게 다듬어, 더 정확한 답변 생성을 돕습니다.

쿼리 확장은 정보 검색에서 원래의 사용자 쿼리에 연관된 용어나 구를 추가하여 재현율을 높이고 모호성을 해소하는 기술입니다. RAG 시스템에서는 다른 용어를 사용하는 더 많은 관련 문서를 찾는 데 도움이 됩니다.

주요 방법에는 쿼리와 문서를 함께 인코딩해 정밀한 점수를 매기는 크로스 인코더 신경망 모델, 효율적인 점수를 위한 지연 상호작용 방식을 사용하는 ColBERT, 빠르고 정확한 재정렬을 위한 FlashRank와 같은 라이브러리가 있습니다.

쿼리 확장은 더 많은 관련 문서를 검색할 수 있도록 검색 범위를 넓히고, 문서 재정렬은 이 결과를 필터링 및 정제하여 가장 핵심 문서만 AI의 답변 생성에 활용되도록 해 재현율과 정밀도를 모두 극대화합니다.

문서 재정렬과 쿼리 확장이 AI 챗봇 및 자동화 플로우의 정확성과 관련성을 어떻게 개선하는지 알아보세요. FlowHunt로 더 똑똑한 AI를 구축하세요.

쿼리 확장은 사용자의 원래 쿼리에 용어나 맥락을 추가하여 문서 검색을 개선하고, 특히 RAG(검색 증강 생성) 시스템에서 더 정확하고 상황에 맞는 응답을 제공하는 과정입니다....

검색 기반 생성(RAG, Retrieval Augmented Generation)은 전통적인 정보 검색 시스템과 생성형 대규모 언어 모델(LLM)을 결합한 고급 AI 프레임워크로, 외부 지식을 통합하여 더 정확하고 최신이며 맥락에 맞는 텍스트를 생성할 수 있도록 합니다....

FlowHunt의 질의 확장(Query Expansion)은 챗봇이 동의어를 찾고, 철자 오류를 수정하며, 사용자 질의에 대해 일관되고 정확한 답변을 제공함으로써 챗봇의 이해도를 높여줍니다....