대화형 AI

대화형 AI는 자연어 처리(NLP), 머신러닝, 기타 언어 기술을 활용하여 컴퓨터가 인간의 대화를 모방할 수 있게 하는 기술을 의미합니다. 이는 챗봇, 가상 비서, 음성 비서를 고객 지원, 의료, 소매 등 다양한 분야에 적용하여 효율성과 개인화를 향상시킵니다....

OpenAI Whisper는 99개 언어의 음성을 정확하게 텍스트로 변환하며, 전사, 번역, 언어 식별을 지원하는 오픈소스 ASR 시스템입니다. 강력한 AI 자동화에 적합합니다.

OpenAI Whisper는 상황에 따라 모델이자 시스템으로 간주할 수 있습니다.

Whisper의 주요 기능은 음성을 텍스트로 전사하는 것입니다. Whisper는 다음에 뛰어납니다:

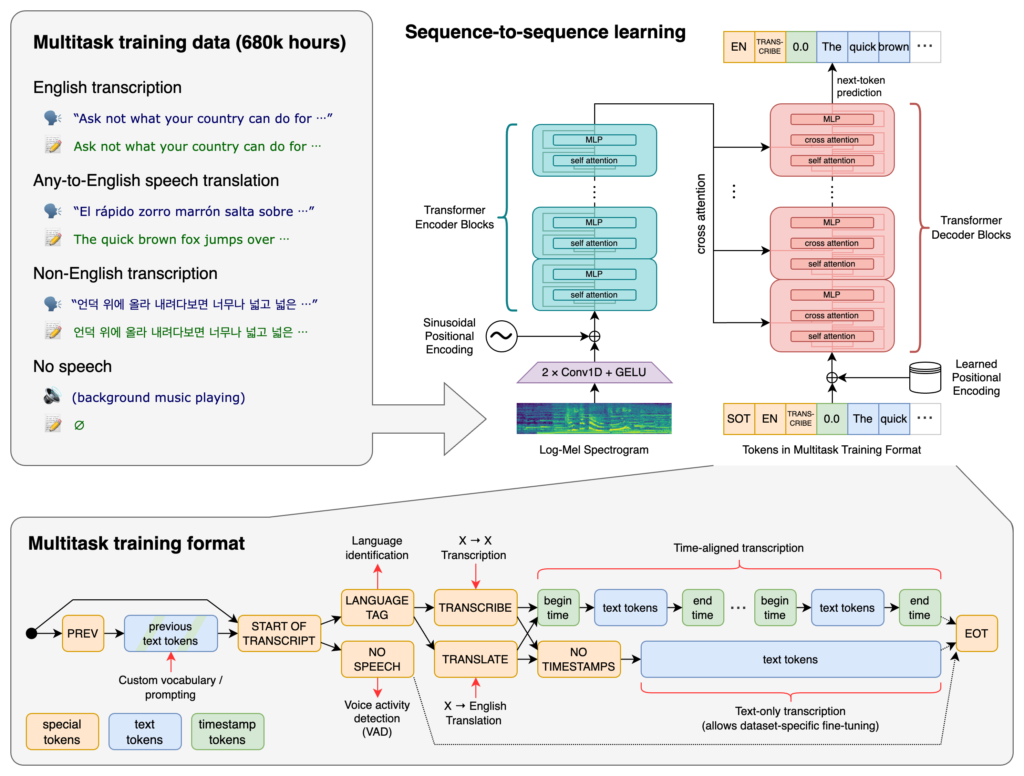

Whisper의 핵심에는 트랜스포머(Transformer) 아키텍처가 있습니다. 특히 인코더-디코더 모델을 사용합니다. 트랜스포머는 순차 데이터를 처리하고 긴 맥락을 이해하는 데 강점을 가진 신경망입니다. 2017년 “Attention is All You Need” 논문에서 소개된 이후 다양한 NLP 작업의 기반이 되었습니다.

Whisper의 처리 과정은 다음과 같습니다:

Whisper는 웹에서 수집한 68만 시간 분량의 감독 데이터로 학습되었습니다. 여기에는:

99개 언어를 지원하며, 다양한 언어 입력을 처리할 수 있습니다. 글로벌 서비스 및 국제 시장을 겨냥한 애플리케이션에 적합합니다.

방대한 감독 데이터로 학습되어 전사 작업에서 높은 정확도를 달성합니다. 다양한 악센트, 방언, 소음 환경에서도 견고하게 동작하여 실사용에 적합합니다.

전사 외에 Whisper는 다음을 수행할 수 있습니다:

오픈소스 소프트웨어로 배포되어 개발자는 다음을 할 수 있습니다:

Whisper를 챗봇 및 AI 어시스턴트에 통합하면 다음이 가능합니다:

Whisper는 Python 라이브러리로 구현되어 Python 기반 프로젝트에 손쉽게 통합할 수 있습니다. Whisper를 Python에서 사용하려면 환경을 준비하고, 필요한 의존성을 설치한 뒤, 라이브러리의 기능을 활용해 오디오 파일을 전사하거나 번역하면 됩니다.

Whisper를 사용하기 전에 Python, PyTorch, FFmpeg, Whisper 라이브러리를 설치해야 합니다.

Python이 설치되어 있지 않다면 공식 웹사이트에서 다운로드하세요. PyTorch는 pip로 설치할 수 있습니다:

pip install torch

운영체제 및 Python 버전에 맞는 자세한 설치법은 PyTorch 웹사이트를 참고하세요.

Whisper는 오디오 파일 처리를 위해 FFmpeg가 필요합니다. 운영체제별 패키지 관리자를 사용해 FFmpeg를 설치하세요.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (Homebrew 사용):

brew install ffmpeg

Windows (Chocolatey 사용):

choco install ffmpeg

pip로 Whisper Python 패키지를 설치하세요:

pip install -U openai-whisper

최신 버전을 GitHub 저장소에서 직접 설치하려면:

pip install git+https://github.com/openai/whisper.git

Developer Mode를 활성화해야 할 수 있습니다:

Whisper는 크기와 성능이 다양한 여러 모델을 제공합니다. tiny부터 large까지 모델마다 속도와 정확도에 차이가 있습니다.

| 크기 | 파라미터 수 | 영어 전용 모델 | 다국어 모델 | 필요 VRAM | 상대 속도 |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32배 빠름 |

| base | 74 M | base.en | base | ~1 GB | ~16배 빠름 |

| small | 244 M | small.en | small | ~2 GB | ~6배 빠름 |

| medium | 769 M | medium.en | medium | ~5 GB | ~2배 빠름 |

| large | 1550 M | N/A | large | ~10 GB | 1배(기준) |

.en): 영어 음성 전사에 최적화되어, 영어 오디오에서 더 나은 성능을 보입니다.환경 및 필수 컴포넌트를 설치한 후, Python 프로젝트에서 Whisper를 사용할 수 있습니다.

먼저 Whisper 라이브러리를 임포트하고 모델을 로드하세요:

import whisper

# 원하는 모델 로드

model = whisper.load_model("base")

애플리케이션에 맞는 모델명을 “base” 대신 지정하세요.

Whisper는 오디오 파일을 텍스트로 변환하는 간단한 transcribe 함수를 제공합니다.

예시: 영어 오디오 전사

# 오디오 파일 전사

result = model.transcribe("path/to/english_audio.mp3")

# 전사 결과 출력

print(result["text"])

model.transcribe(): 오디오 파일을 처리해 전사 결과와 기타 메타데이터가 담긴 딕셔너리를 반환합니다.result["text"]: 전사된 텍스트를 추출합니다.Whisper는 다양한 언어의 오디오를 영어로 번역할 수 있습니다.

예시: 스페인어 오디오를 영어로 번역

# 스페인어 오디오를 영어로 전사 및 번역

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# 번역 결과 출력

print(result["text"])

task="translate": 모델에 오디오를 그대로 전사하지 않고 영어로 번역하도록 지시합니다.Whisper는 자동으로 언어를 감지할 수 있지만, 직접 지정하면 정확도와 속도가 향상될 수 있습니다.

예시: 프랑스어 오디오 전사

# 언어를 명시해 프랑스어 오디오 전사

result = model.transcribe("path/to/french_audio.wav", language="fr")

# 전사 결과 출력

print(result["text"])

Whisper는 detect_language 메서드로 오디오에서 사용 언어를 감지할 수 있습니다.

예시: 언어 감지

# 오디오 파일 로드 및 전처리

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# 로그-멜 스펙트로그램 변환

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# 언어 감지

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): 오디오 파일을 로드합니다.whisper.pad_or_trim(): 모델 입력 요구에 맞게 오디오 길이를 조정합니다.whisper.log_mel_spectrogram(): 모델이 기대하는 포맷으로 변환합니다.model.detect_language(): 각 언어별 확률을 반환하며, 가장 높은 확률의 언어를 식별합니다.전사 과정을 세밀하게 제어하고 싶다면, 하위 함수와 디코딩 옵션을 사용할 수 있습니다.

decode 함수 활용decode 함수는 언어, 작업, 타임스탬프 포함 여부 등 옵션을 직접 지정할 수 있습니다.

예시: 커스텀 디코딩 옵션

# 디코딩 옵션 설정

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# 오디오 디코드

result = whisper.decode(model, mel, options)

# 인식된 텍스트 출력

print(result.text)

Whisper를 마이크 등에서 실시간 오디오 입력을 받아 전사하는 데 통합할 수 있습니다.

예시: 마이크 입력 실시간 전사

import whisper

import sounddevice as sd

# 모델 로드

model = whisper.load_model("base")

# 마이크로부터 오디오 녹음

duration = 5 # 초 단위

fs = 16000 # 샘플링 레이트

print("Recording...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper는 OpenAI가 개발한 고급 자동 음성 인식(ASR) 시스템으로, 딥러닝을 이용해 음성 언어를 텍스트로 전사하는 데 설계되었습니다. 99개 언어를 지원하며, 전사, 번역, 언어 식별에 탁월한 성능을 보입니다.

Whisper는 트랜스포머 기반 인코더-디코더 아키텍처를 사용하며, 오디오를 로그-멜 스펙트로그램으로 변환한 후 언어 모델을 통해 텍스트를 출력합니다. 68만 시간 분량의 다국어 및 멀티태스크 데이터로 학습되어 높은 정확도와 견고함을 자랑합니다.

Whisper는 다국어 음성 인식, 음성 번역, 자동 언어 식별, 악센트 및 소음에 대한 강인함, 오픈소스 제공(커스터마이징 및 통합 가능) 등의 기능을 지원합니다.

하드웨어 요구 사항은 모델 크기에 따라 다르며, 'tiny' 등 소형 모델은 약 1GB VRAM이 필요하고, 가장 큰 모델은 약 10GB가 요구됩니다. GPU에서 더 빠르게 동작하지만, CPU에서도 느리게 작동할 수 있습니다.

네, Whisper는 Python 라이브러리로 구현되어 pip로 설치할 수 있습니다. 음성 전사, 번역, 실시간 음성 애플리케이션 등 Python 프로젝트에 쉽게 통합할 수 있습니다.

주요 활용 예시는 자동 회의 전사, 음성 기반 챗봇, 실시간 번역, 접근성 도구(자막 및 보조 기술), 콜센터 자동화, 음성 제어 자동화 시스템 등이 있습니다.

네, Mozilla DeepSpeech, Kaldi, Wav2vec 같은 오픈소스 엔진과 Google Cloud Speech-to-Text, Microsoft Azure AI Speech, AWS Transcribe 같은 상용 API가 대안으로 있습니다.

네, OpenAI Whisper는 오픈소스이며 개발자가 라이선스 제약 없이 자유롭게 커스터마이징, 미세 조정, 통합할 수 있습니다.

OpenAI Whisper와 FlowHunt를 활용해 애플리케이션에 고급 음성-텍스트 기능을 통합하고, 워크플로우를 자동화하며, 사용자 경험을 향상하세요.

대화형 AI는 자연어 처리(NLP), 머신러닝, 기타 언어 기술을 활용하여 컴퓨터가 인간의 대화를 모방할 수 있게 하는 기술을 의미합니다. 이는 챗봇, 가상 비서, 음성 비서를 고객 지원, 의료, 소매 등 다양한 분야에 적용하여 효율성과 개인화를 향상시킵니다....

FlowHunt의 Custom OpenAI LLM 컴포넌트를 사용하여 맞춤형 언어 모델의 강력함을 활용하세요. JinaChat, LocalAI, Prem 등 OpenAI 호환 모델을 API 키와 엔드포인트만 지정하여 손쉽게 통합할 수 있습니다. 온도, 최대 토큰 등 핵심 설정을 세밀하게...

FlowHunt는 OpenAI를 포함한 수십 가지 텍스트 생성 모델을 지원합니다. AI 도구와 챗봇에서 ChatGPT를 사용하는 방법을 알아보세요....