mcp-local-rag MCP 서버

mcp-local-rag MCP 서버는 개인정보 보호를 중시하는 로컬 RAG(검색 증강 생성) 웹 검색을 LLM에 제공합니다. 외부 API 없이 AI 어시스턴트가 웹에서 최신 정보를 접근, 임베딩, 추출할 수 있게 하여 연구, 콘텐츠 제작, 질의응답 워크플로우를 향상시킵니다....

mcp-local-rag MCP 서버는 개인정보 보호를 중시하는 로컬 RAG(검색 증강 생성) 웹 검색을 LLM에 제공합니다. 외부 API 없이 AI 어시스턴트가 웹에서 최신 정보를 접근, 임베딩, 추출할 수 있게 하여 연구, 콘텐츠 제작, 질의응답 워크플로우를 향상시킵니다....

Pinecone MCP 서버를 사용하여 FlowHunt를 Pinecone 벡터 데이터베이스와 통합하세요. 시맨틱 검색, RAG(검색 증강 생성), 효율적인 문서 관리 기능을 AI 워크플로우 내에서 바로 활성화할 수 있습니다....

RAG 웹 브라우저 MCP 서버는 AI 어시스턴트와 LLM에 실시간 웹 검색 및 콘텐츠 추출 기능을 제공하여, Retrieval-Augmented Generation(RAG), 요약, 실시간 연구를 FlowHunt 워크플로우 내에서 구현할 수 있게 합니다....

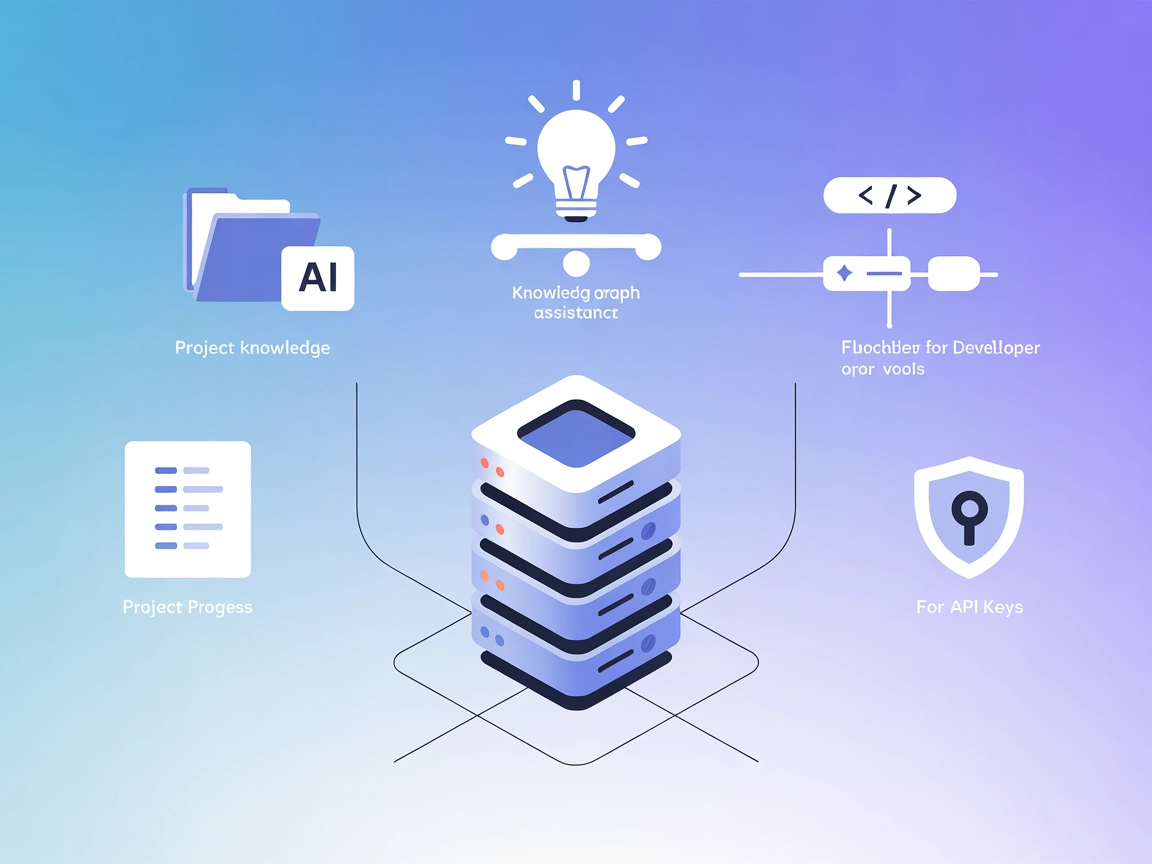

컨텍스트 포털(ConPort)은 AI 어시스턴트와 개발자 도구를 위한 구조화된 프로젝트 컨텍스트를 관리하여 RAG 및 IDE 내 컨텍스트 인지 코딩 지원을 가능하게 하는 메모리 뱅크 MCP 서버입니다....

Agentset MCP 서버는 RAG(Retrieval-Augmented Generation)와 에이전트 기능을 제공하는 오픈소스 플랫폼으로, AI 어시스턴트가 외부 데이터 소스, API, 서비스에 연결하여 지능적인 문서 기반 애플리케이션을 개발할 수 있도록 지원합니다....

Inkeep MCP 서버는 AI 어시스턴트와 개발자 도구를 Inkeep에서 관리하는 최신 제품 문서와 연결하여, RAG 워크플로, 챗봇 및 온보딩 솔루션을 위한 관련 콘텐츠를 직접, 안전하고 효율적으로 검색할 수 있도록 합니다....

mcp-rag-local MCP 서버는 AI 어시스턴트에 의미 기반의 시맨틱 메모리를 제공하여, 키워드뿐만 아니라 텍스트의 의미에 따라 텍스트 단락을 저장하고 검색할 수 있게 합니다. Ollama를 임베딩에, ChromaDB를 벡터 검색에 활용하여, 로컬 워크플로우에서 고급 지식 관리와...

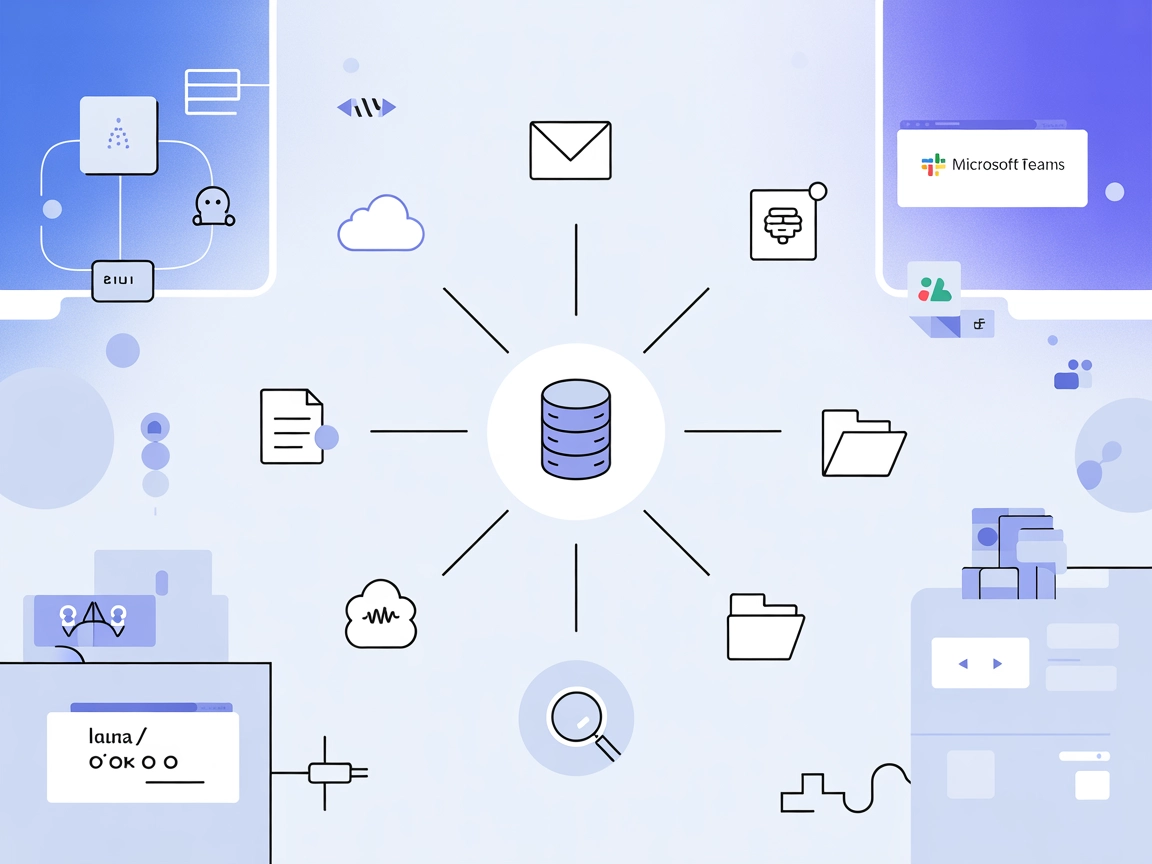

Graphlit MCP 서버는 FlowHunt 및 기타 MCP 클라이언트를 하나의 통합 지식 플랫폼에 연결하여, Slack, Google Drive, GitHub 등 다양한 플랫폼의 문서, 메시지, 이메일, 미디어를 손쉽게 수집, 집계, 검색할 수 있게 합니다. 검색, 추출, 콘텐츠 변...

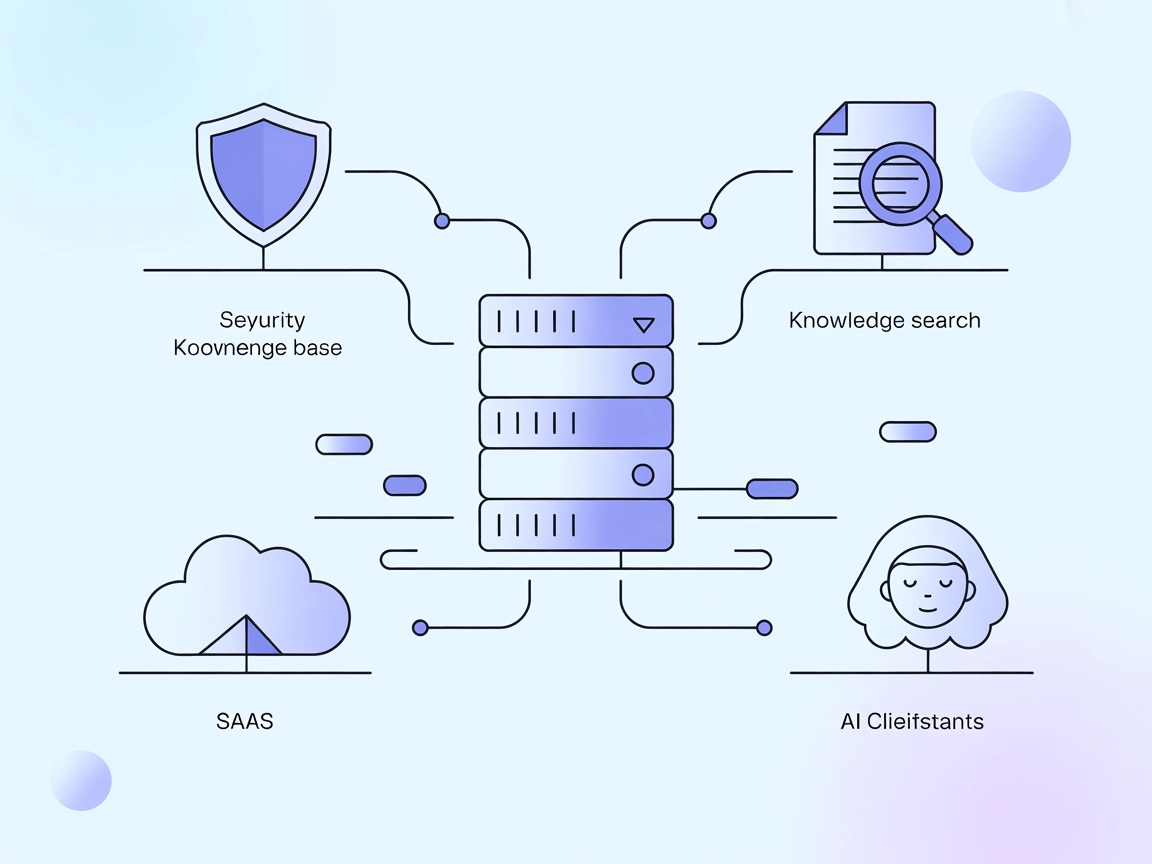

Vectara MCP 서버는 오픈 소스 브릿지로, AI 어시스턴트와 Vectara의 Trusted RAG 플랫폼을 연결하여 FlowHunt의 생성형 AI 워크플로우에 보안성 높고 효율적인 검색 및 Retrieval-Augmented Generation(RAG)을 제공합니다....

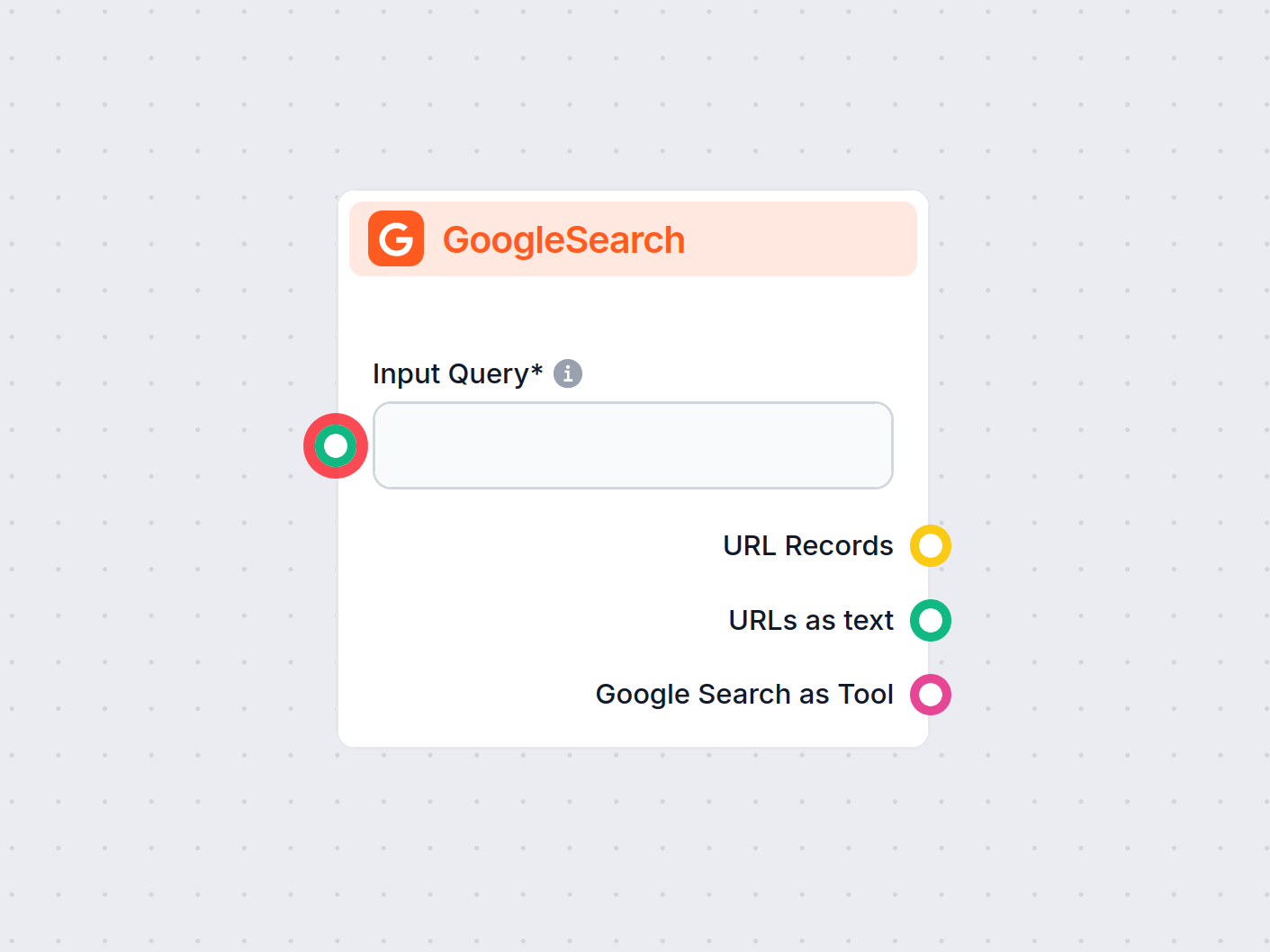

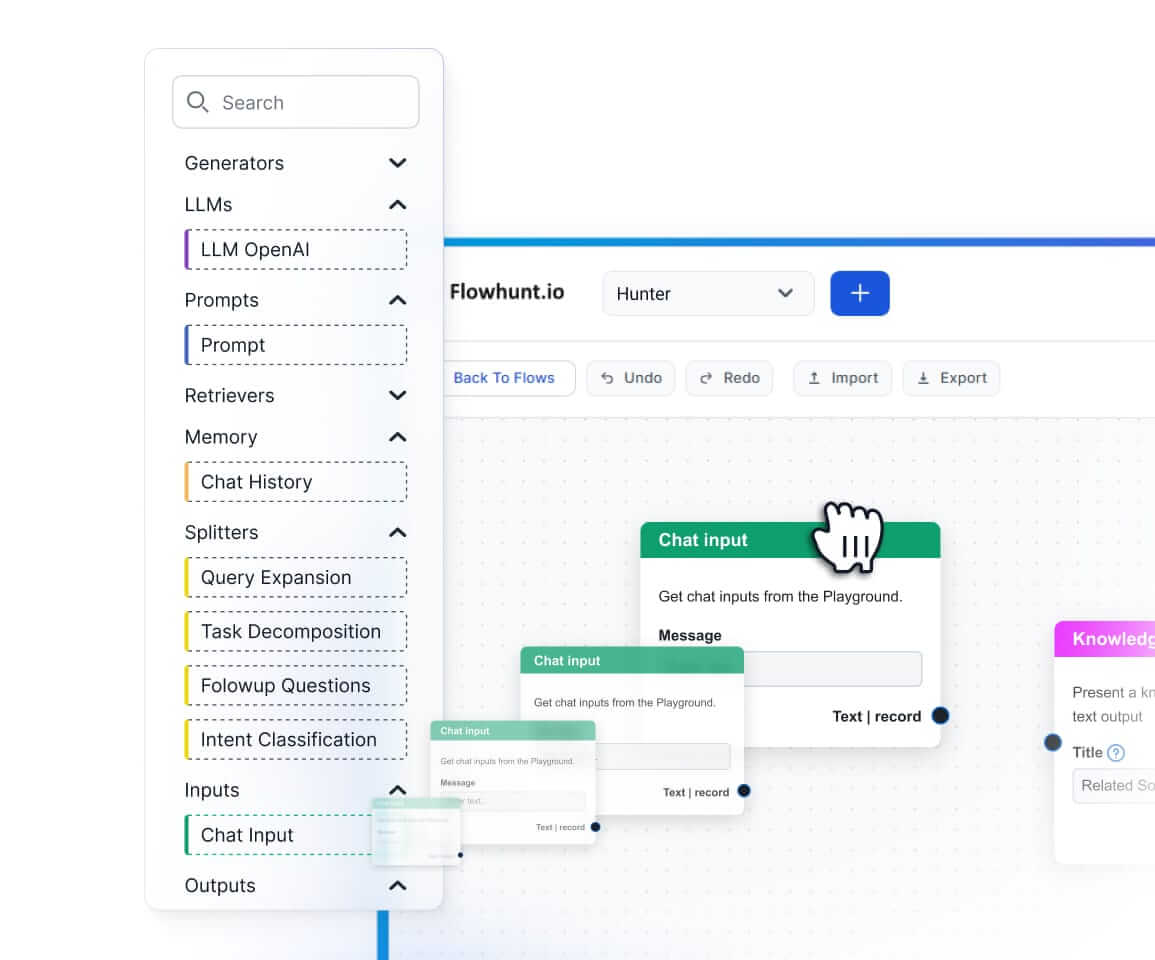

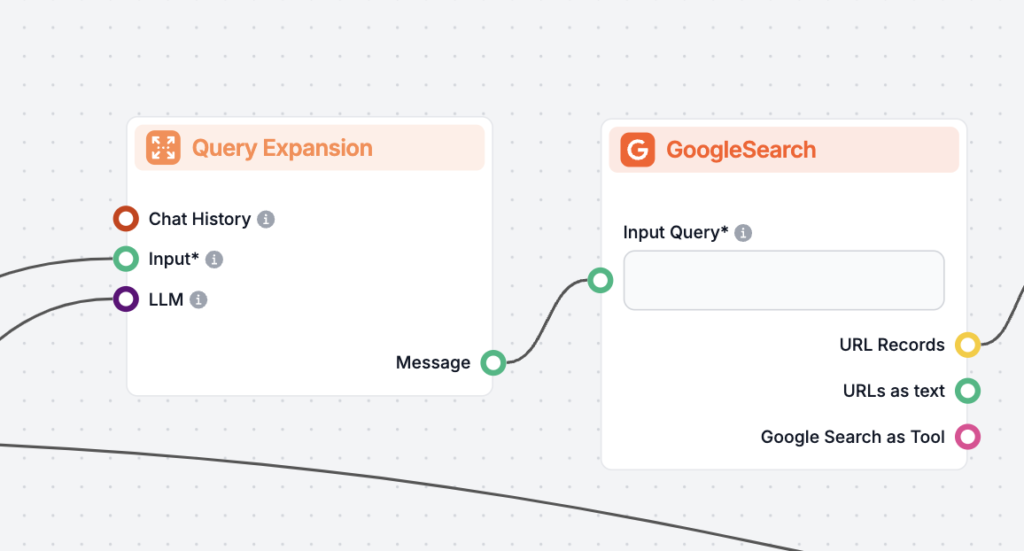

FlowHunt의 GoogleSearch 컴포넌트는 검색 기반 생성(RAG)을 활용하여 Google에서 최신 지식을 가져와 챗봇의 정확성을 향상시킵니다. 언어, 국가, 쿼리 접두사 등 다양한 옵션을 통해 결과를 정밀하게 제어할 수 있어, 더욱 정확하고 관련성 높은 답변을 제공합니다....

LazyGraphRAG는 그래프 이론과 자연어 처리를 결합하여 AI 기반 데이터 검색의 효율성과 비용을 혁신적으로 최적화하는 Retrieval-Augmented Generation(RAG)의 혁신적인 접근법입니다. 동적으로 고품질 쿼리 결과를 제공하여 효율성과 비용을 모두 절감합니다....

RIG로 AI 정확도를 높이세요! 신뢰할 수 있는 출처 기반 답변을 위해 맞춤형 및 일반 데이터 소스를 모두 활용하여 응답을 사실 확인하는 챗봇을 만드는 방법을 알아보세요....

검색 기반 생성(RAG, Retrieval Augmented Generation)은 전통적인 정보 검색 시스템과 생성형 대규모 언어 모델(LLM)을 결합한 고급 AI 프레임워크로, 외부 지식을 통합하여 더 정확하고 최신이며 맥락에 맞는 텍스트를 생성할 수 있도록 합니다....

AI에서 검색 기반 생성(RAG)과 캐시 기반 생성(CAG)의 주요 차이점을 알아보세요. RAG는 실시간 정보를 동적으로 검색해 유연하고 정확한 답변을 제공하며, CAG는 미리 캐시된 데이터를 사용해 빠르고 일관성 있는 결과를 제공합니다. 어떤 방식이 프로젝트에 적합한지, 실질적 사용 ...

챗봇을 위한 검색 파이프라인이 무엇인지, 그 구성 요소와 활용 사례, 그리고 RAG 및 외부 데이터 소스가 어떻게 정확하고 맥락을 고려한 실시간 응답을 가능하게 하는지 알아보세요....

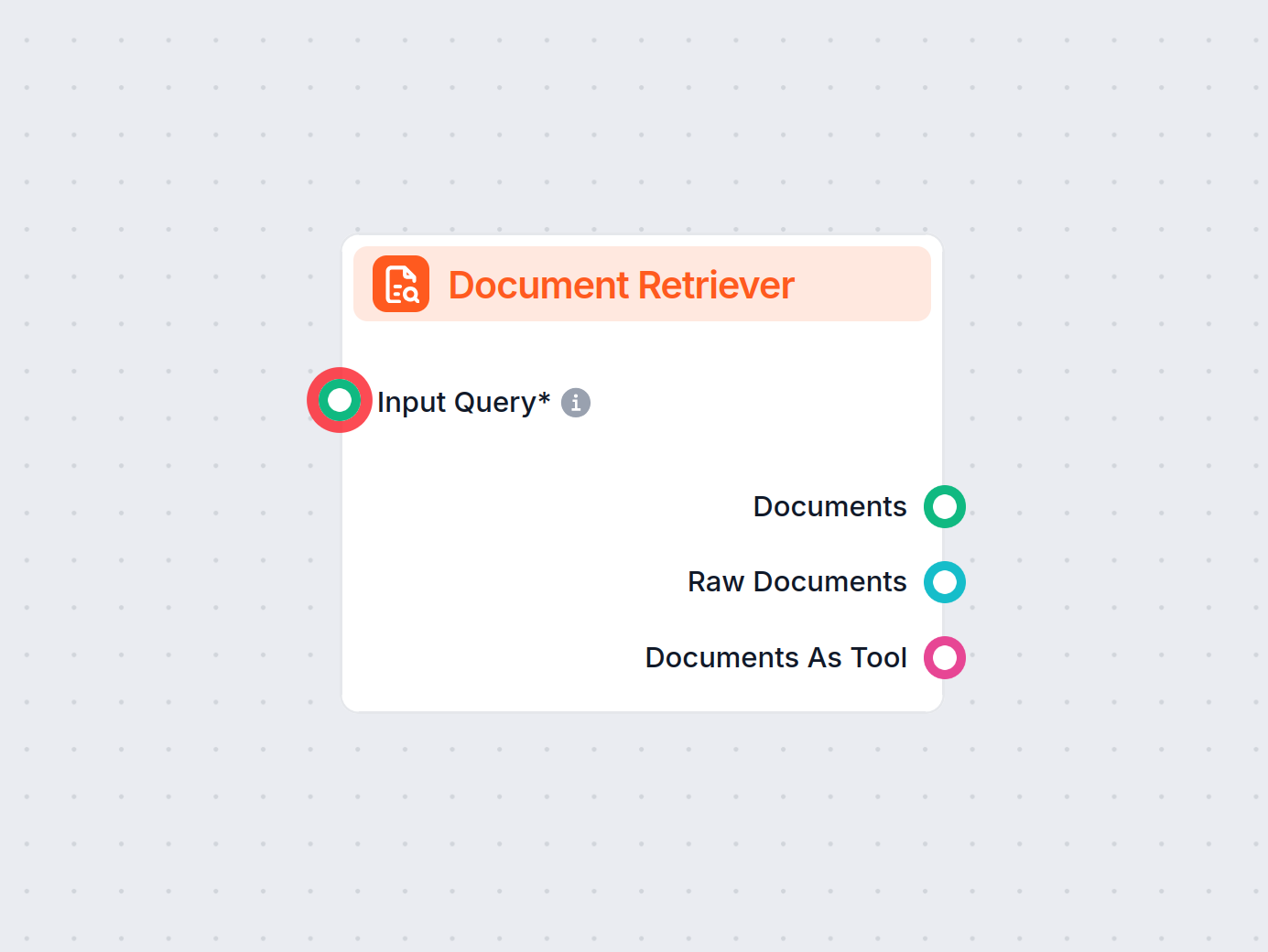

FlowHunt의 문서 검색기는 생성형 모델이 최신 문서와 URL에 연결되어 신뢰할 수 있고 관련성 높은 답변을 제공하도록 도와 AI의 정확도를 높입니다. 이는 검색 기반 생성(RAG)을 활용합니다....

검색 증강 생성(RAG)에서 문서 등급 평가는 쿼리에 대한 관련성과 품질을 기준으로 문서를 평가하고 순위를 매기는 과정으로, 가장 적합하고 고품질의 문서만을 사용하여 정확하고 문맥을 고려한 응답을 생성하도록 보장합니다....

문서 재정렬은 사용자의 쿼리와의 관련성에 따라 검색된 문서의 순서를 다시 정렬하여, 가장 중요한 정보를 우선시하도록 검색 결과를 세밀하게 다듬는 과정입니다. 이는 RAG(검색 증강 생성) 시스템에서 핵심적인 단계로, 쿼리 확장과 결합되어 AI 기반 검색 및 챗봇의 재현율과 정밀도를 모두...

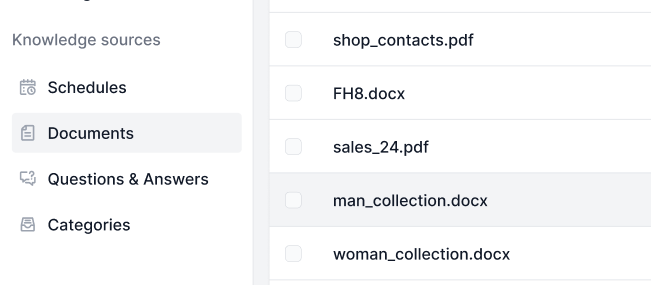

지식 소스를 사용하면 AI를 원하는 방식으로 쉽게 학습시킬 수 있습니다. FlowHunt와 지식을 연결하는 다양한 방법을 확인해보세요. 웹사이트, 문서, 동영상을 손쉽게 연결하여 AI 챗봇의 성능을 높일 수 있습니다....

검색 기반 생성(RAG)을 활용한 질문 응답은 정보 검색과 자연어 생성을 결합하여, 외부 소스의 관련성 있고 최신 데이터를 활용해 대형 언어 모델(LLM)의 답변을 보완합니다. 이 하이브리드 접근 방식은 정확성, 관련성, 그리고 변화하는 환경에 대한 적응력을 개선합니다....

OpenAI O1의 고급 추론 능력과 강화 학습이 어떻게 GPT4o보다 RAG 정확도에서 뛰어난 성능을 보이는지, 벤치마크와 비용 분석을 통해 알아보세요....

캐시 증강 생성(CAG)은 대규모 언어 모델(LLM)의 성능을 향상시키기 위해 지식을 미리 계산된 키-값 캐시로 사전 로드하여, 정적 지식 작업에 대해 저지연, 정확하고 효율적인 AI 성능을 가능하게 하는 혁신적인 접근 방식입니다....

쿼리 확장은 사용자의 원래 쿼리에 용어나 맥락을 추가하여 문서 검색을 개선하고, 특히 RAG(검색 증강 생성) 시스템에서 더 정확하고 상황에 맞는 응답을 제공하는 과정입니다....