LLM Meta AI

FlowHunt ondersteunt tientallen tekstgeneratiemodellen, waaronder de Llama-modellen van Meta. Leer hoe je Llama integreert in je AI-tools en chatbots, pas inste...

LLM Mistral op FlowHunt maakt flexibele integratie mogelijk van geavanceerde Mistral AI-modellen voor naadloze tekstgeneratie in chatbots en AI-tools.

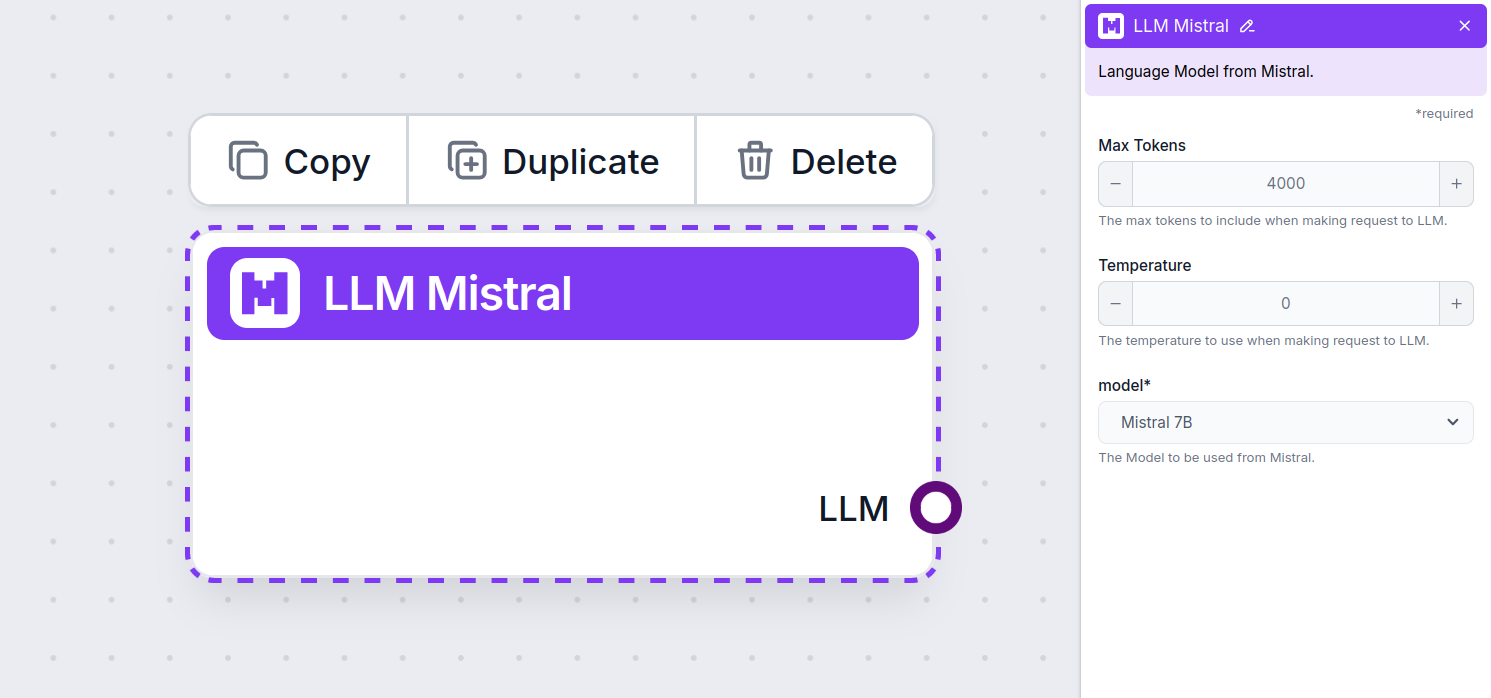

Componentbeschrijving

The LLM Mistral component connects the Mistral models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported models from Mistral. We currently support the following models:

How To Add The LLM Mistral To Your Flow

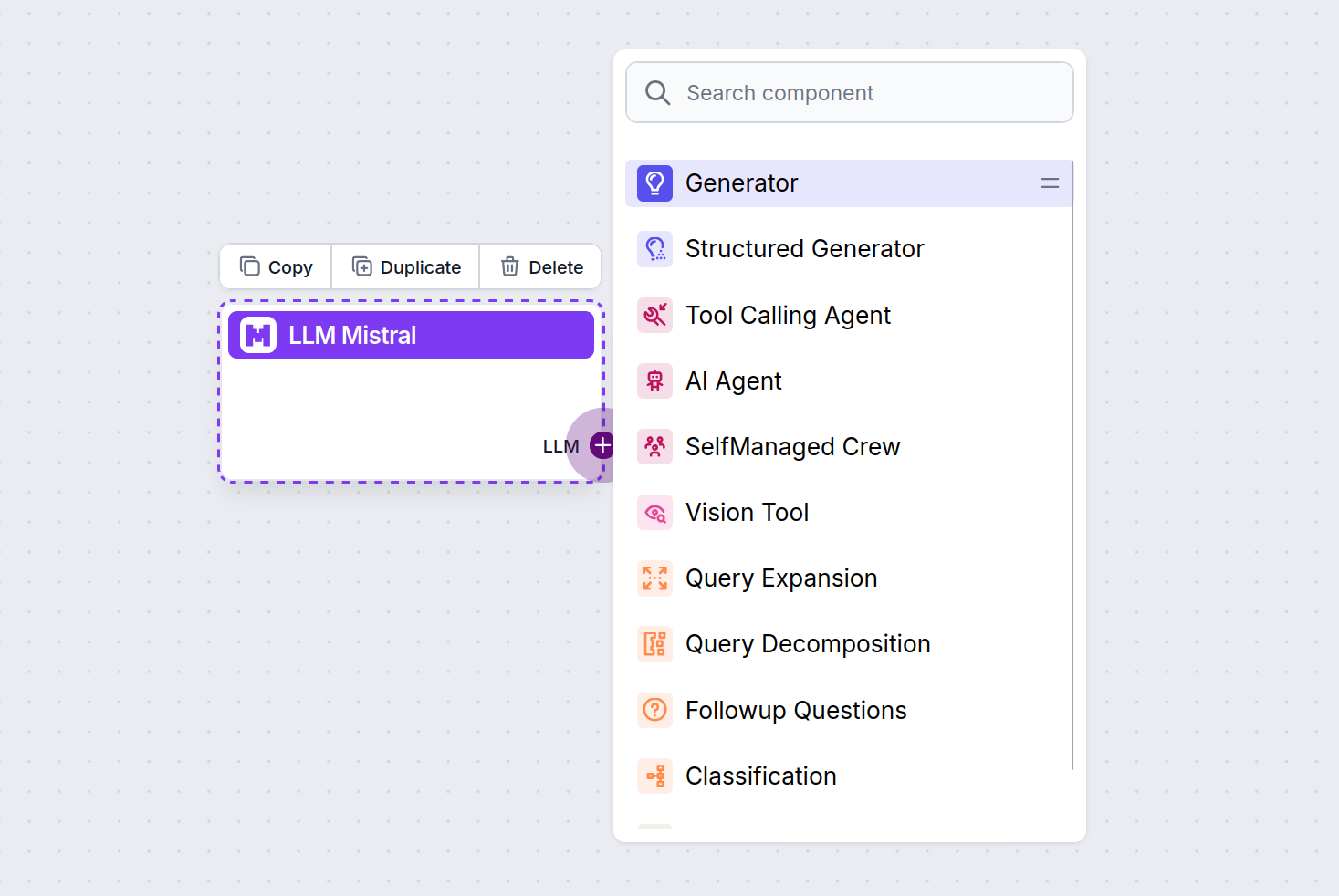

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

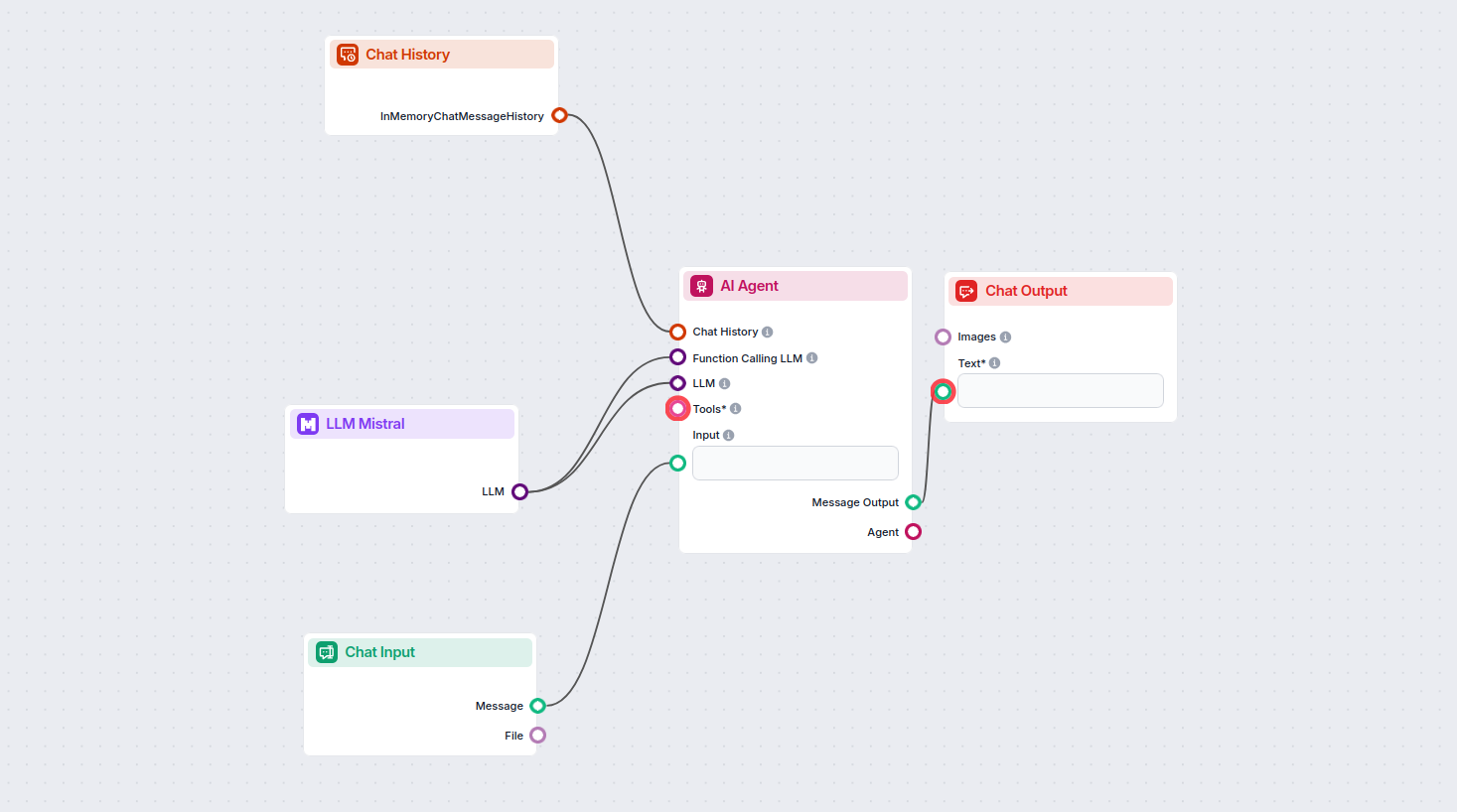

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using the Mistral 7B model to generate responses. You can think of it as a basic Mistral chatbot.

This simple Chatbot Flow includes:

De LLM Mistral-component laat je Mistral AI-modellen verbinden met je FlowHunt-projecten, waardoor geavanceerde tekstgeneratie mogelijk wordt voor je chatbots en AI-agenten. Je kunt modellen wisselen, instellingen beheren en modellen zoals Mistral 7B, Mixtral (8x7B) en Mistral Large integreren.

FlowHunt ondersteunt Mistral 7B, Mixtral (8x7B) en Mistral Large, die elk verschillende prestaties en parameter-niveaus bieden voor uiteenlopende tekstgeneratiebehoeften.

Je kunt instellingen zoals maximale tokens en temperatuur aanpassen, en kiezen tussen ondersteunde Mistral-modellen om de lengte van antwoorden, creativiteit en het modelgedrag binnen je flows te bepalen.

Nee, het verbinden van een LLM-component is optioneel. Standaard gebruiken FlowHunt-componenten ChatGPT-4o. Gebruik de LLM Mistral-component wanneer je meer controle wilt of een specifiek Mistral-model wilt inzetten.

Begin met het bouwen van slimmere AI-chatbots en tools door de krachtige taalmodellen van Mistral te integreren met FlowHunt’s no-code platform.

FlowHunt ondersteunt tientallen tekstgeneratiemodellen, waaronder de Llama-modellen van Meta. Leer hoe je Llama integreert in je AI-tools en chatbots, pas inste...

FlowHunt ondersteunt tientallen tekstgeneratiemodellen, waaronder modellen van xAI. Hier lees je hoe je de xAI-modellen gebruikt in je AI-tools en chatbots.

FlowHunt ondersteunt tientallen AI-modellen, waaronder de revolutionaire DeepSeek-modellen. Hier lees je hoe je DeepSeek gebruikt in je AI-tools en chatbots.