Stability AI SD3 Large: Een Diepgaande Review van de AI Beeldgenerator

Ontdek onze diepgaande review van Stability AI SD3 Large. Analyseer de sterke en zwakke punten, en de creatieve output op diverse tekst-naar-beeld prompts, en o...

Stable Diffusion is een toonaangevend tekst-naar-beeld AI-model waarmee gebruikers fotorealistische visuals kunnen genereren uit prompts met behulp van geavanceerde latent diffusion- en deep learning-technieken.

Stable Diffusion is een tekst-naar-beeld AI-model dat hoogwaardige afbeeldingen creëert uit beschrijvingen met behulp van deep learning. Het maakt gebruik van technieken zoals negatieve prompts en referentiebeelden voor betere resultaten, vooral bij complexe elementen zoals handen.

Stable Diffusion is een geavanceerd tekst-naar-beeld generatie model dat deep learning technieken gebruikt om hoogwaardige, fotorealistische afbeeldingen te produceren op basis van tekstuele beschrijvingen. Ontwikkeld als een latent diffusion model, vormt het een belangrijke doorbraak op het gebied van generatieve kunstmatige intelligentie, waarbij de principes van diffusion modellen en machine learning worden gecombineerd om beelden te creëren die nauw aansluiten bij de gegeven tekstprompts.

Stable Diffusion gebruikt deep learning en diffusion modellen om afbeeldingen te genereren door willekeurige ruis te verfijnen tot samenhangende visuals. Ondanks zijn uitgebreide training op miljoenen afbeeldingen, heeft het moeite met complexe elementen zoals handen. Naarmate de modellen getraind worden op steeds grotere datasets, nemen deze problemen af en worden de beelden steeds realistischer.

Een effectieve methode om het handenprobleem aan te pakken is het gebruik van negatieve prompts. Door zinnen toe te voegen zoals (-bad anatomy) of (-bad hands -unnatural hands) aan je prompts, kun je de AI instrueren om vervormde kenmerken te vermijden. Let erop dat je negatieve prompts niet overmatig gebruikt, omdat dit de creatieve output van het model kan beperken.

Een andere techniek is het gebruik van referentiebeelden om de AI te sturen. Door een {image} tag met een link naar een referentiebeeld toe te voegen aan je prompt, geef je de AI een visueel voorbeeld voor een nauwkeurige weergave van handen. Dit is vooral nuttig voor het behouden van correcte handproporties en -houdingen.

Voor de beste resultaten combineer je zowel negatieve prompts als referentiebeelden. Deze dubbele aanpak zorgt ervoor dat de AI veelvoorkomende fouten vermijdt en zich houdt aan hoogwaardige voorbeelden.

(-bent fingers) of (realistic perspectives) om de kwaliteit van handen verder te verbeteren.Door deze technieken te beheersen kun je de weergave van handen in je Stable Diffusion-creaties aanzienlijk verbeteren en kunstwerken bereiken met de finesse van een ervaren kunstenaar. Verzamel je referentiebeelden, stel nauwkeurige prompts op en zie je AI-kunst evolueren!

In de kern werkt Stable Diffusion door tekstprompts om te zetten in visuele representaties via een reeks computationele processen. Het begrijpen van de functionaliteit vereist inzicht in diffusion modellen, latente ruimtes en neurale netwerken.

Diffusion modellen zijn een klasse van generatieve modellen in machine learning die leren data te creëren door een diffusieproces om te keren. Het diffusieproces houdt in dat er geleidelijk ruis wordt toegevoegd aan data—zoals afbeeldingen—totdat ze niet meer te onderscheiden zijn van willekeurige ruis. Het model leert vervolgens dit proces om te keren, waarbij stap voor stap ruis wordt verwijderd om de oorspronkelijke data terug te krijgen. Dit omgekeerde diffusieproces is essentieel om nieuwe, samenhangende data uit willekeurige ruis te genereren.

Stable Diffusion gebruikt specifiek een latent diffusion model. In tegenstelling tot traditionele diffusion modellen, die direct werken in de hoge-dimensionale pixelruimte van afbeeldingen, werken latente diffusion modellen in een gecomprimeerde latente ruimte. Deze latente ruimte is een lagere-dimensionale representatie van de data en vat essentiële kenmerken samen terwijl de computationele complexiteit wordt verminderd. Door in de latente ruimte te werken kan Stable Diffusion efficiënter afbeeldingen met hoge resolutie genereren.

Het kernmechanisme van Stable Diffusion omvat het omgekeerde diffusieproces in de latente ruimte. Beginnend met een willekeurige ruis-latent vector verfijnt het model deze latente representatie iteratief door bij elke stap ruis te voorspellen en te verwijderen. Deze verfijning wordt gestuurd door de tekstuele beschrijving die door de gebruiker is opgegeven. Het proces gaat door totdat de latente vector convergeert naar een staat die, wanneer gedecodeerd, een afbeelding oplevert die overeenkomt met de tekstprompt.

De architectuur van Stable Diffusion integreert verschillende kernelementen die samenwerken om tekstprompts om te zetten in afbeeldingen.

De VAE fungeert als het encoder-decoder systeem dat afbeeldingen comprimeert naar de latente ruimte en ze weer reconstrueert naar afbeeldingen. De encoder zet een afbeelding om in zijn latente representatie en legt de fundamentele kenmerken vast in een verkleinde vorm. De decoder neemt deze latente representatie en reconstrueert deze tot de gedetailleerde afbeelding.

Dit proces is cruciaal omdat het het model in staat stelt te werken met data met een lagere dimensie, wat aanzienlijk minder computationele middelen kost dan werken in de volledige pixelruimte.

De U-Net is een gespecialiseerd neuraal netwerk binnen Stable Diffusion voor beeldverwerkingstaken. Het bestaat uit een encoder-pad en een decoder-pad met skip-connections tussen gespiegeld gelagen. In de context van Stable Diffusion fungeert de U-Net als de ruisvoorspeller tijdens het omgekeerde diffusieproces.

Bij elke tijdstap van het diffusieproces voorspelt de U-Net de hoeveelheid ruis die aanwezig is in de latente representatie. Deze voorspelling wordt vervolgens gebruikt om de latente vector te verfijnen door de geschatte ruis af te trekken, waardoor de latente ruimte geleidelijk wordt opgeschoond richting een afbeelding die aansluit bij de tekstprompt.

Om tekstuele informatie te integreren gebruikt Stable Diffusion een tekstencoder gebaseerd op het CLIP (Contrastive Language-Image Pretraining) model. CLIP is ontworpen om tekstuele en visuele informatie te begrijpen en te relateren door ze in een gedeelde latente ruimte te plaatsen.

Wanneer een gebruiker een tekstprompt geeft, zet de tekstencoder deze om in een reeks embeddings—numerieke representaties van de tekstuele data. Deze embeddings conditioneren de U-Net tijdens het omgekeerde diffusieproces en sturen de beeldgeneratie aan zodat deze overeenkomt met de inhoud van de tekstprompt.

Stable Diffusion biedt veelzijdigheid in het genereren van beelden en kan op verschillende manieren worden ingezet, afhankelijk van de behoeften van de gebruiker.

Het primaire gebruik van Stable Diffusion is het genereren van beelden vanuit tekstprompts. Gebruikers voeren een beschrijvende tekst in en het model genereert een afbeelding die de beschrijving weergeeft. Bijvoorbeeld, een gebruiker vult in: “Een serene strand bij zonsondergang met palmbomen” en ontvangt een afbeelding die deze scène uitbeeldt.

Deze mogelijkheid is vooral waardevol in creatieve sectoren, contentcreatie en design, waar snelle visualisatie van concepten essentieel is.

Naast het genereren van afbeeldingen vanaf nul kan Stable Diffusion ook bestaande beelden aanpassen op basis van tekstuele instructies. Door een initiële afbeelding en een tekstprompt te geven, kan het model een nieuwe afbeelding produceren die de beschreven wijzigingen bevat.

Bijvoorbeeld, een gebruiker geeft een afbeelding van een stadsgezicht overdag met de prompt “verander naar nacht met neonlichten”, wat resulteert in een afbeelding die deze aanpassingen weerspiegelt.

Inpainting houdt in dat ontbrekende of beschadigde delen van een afbeelding worden ingevuld. Stable Diffusion blinkt hierin uit door tekstprompts te gebruiken om de reconstructie van specifieke beeldgebieden te sturen. Gebruikers kunnen delen van een afbeelding maskeren en een tekstuele beschrijving geven van wat dat gebied moet vullen.

Deze functie is nuttig voor fotorestauratie, het verwijderen van ongewenste objecten of het aanpassen van specifieke elementen in een afbeelding terwijl de samenhang behouden blijft.

Door reeksen beelden met kleine variaties te genereren, kan Stable Diffusion worden uitgebreid om animaties of videocontent te maken. Tools zoals Deforum vergroten de mogelijkheden van Stable Diffusion om dynamische visuele content te produceren die door tekstprompts wordt geleid.

Dit opent mogelijkheden in animatie, visuele effecten en dynamische contentcreatie zonder traditionele frame-voor-frame animatietechnieken.

De mogelijkheid van Stable Diffusion om beelden te genereren uit tekstbeschrijvingen maakt het een krachtig hulpmiddel in AI-automatisering en chatbotontwikkeling.

Door Stable Diffusion te integreren in chatbots kun je visuele content genereren als antwoord op gebruikersvragen. Bijvoorbeeld, in een klantenservice scenario kan een chatbot direct visuele handleidingen of illustraties genereren om gebruikers te helpen.

Tekstprompts worden omgezet in embeddings via de CLIP-tekstencoder. Deze embeddings zijn essentieel om het beeldgeneratieproces te conditioneren en zorgen ervoor dat de outputafbeelding overeenkomt met de tekstuele omschrijving van de gebruiker.

Het omgekeerde diffusieproces houdt in dat de latente representatie iteratief wordt verfijnd door voorspelde ruis te verwijderen. Bij elke tijdstap houdt het model rekening met de tekstembeddings en de huidige staat van de latente vector om de ruiscomponent nauwkeurig te voorspellen.

De vaardigheid van het model om met ruisachtige beelden om te gaan komt voort uit training op grote datasets waarbij het leert afbeeldingen effectief te onderscheiden en te ontdoen van ruis. Dankzij deze training kan het heldere beelden genereren, zelfs vanuit willekeurige ruis.

Werken in de latente ruimte biedt computationele efficiëntie. Omdat de latente ruimte minder dimensies heeft dan de pixelruimte, zijn bewerkingen minder veeleisend voor de middelen. Deze efficiëntie stelt Stable Diffusion in staat om beelden met hoge resolutie te genereren zonder overmatige rekencapaciteit.

Artiesten en ontwerpers kunnen Stable Diffusion gebruiken om snel visuals te prototypen op basis van conceptuele beschrijvingen, wat het creatieve proces ondersteunt en de tijd van idee tot visualisatie verkort.

Marketingteams kunnen aangepaste beelden genereren voor campagnes, sociale media en advertenties zonder uitgebreide grafische ontwerpmiddelen.

Gameontwikkelaars kunnen assets, omgevingen en concept art creëren door beschrijvende prompts te geven, waardoor de asset creatie pipeline wordt gestroomlijnd.

Retailers kunnen afbeeldingen van producten in diverse settings of configuraties genereren, wat de productvisualisatie en klantbeleving verbetert.

Docenten en contentmakers kunnen illustraties en diagrammen produceren om complexe concepten uit te leggen en lesmateriaal aantrekkelijker te maken.

Onderzoekers in kunstmatige intelligentie en computervisie kunnen Stable Diffusion gebruiken om de mogelijkheden van diffusion modellen en latente ruimtes verder te verkennen.

Om Stable Diffusion effectief te gebruiken zijn er enkele technische aandachtspunten.

Om te beginnen met Stable Diffusion volg je deze stappen:

Voor ontwikkelaars die AI-automatisering systemen en chatbots bouwen, kan Stable Diffusion worden geïntegreerd om de functionaliteit te verbeteren.

Bij het gebruik van Stable Diffusion is het belangrijk om rekening te houden met ethische implicaties.

Stable diffusion is een belangrijk onderwerp binnen generatieve modellen, met name voor data-augmentatie en beeldsynthese. Recente studies hebben diverse aspecten van stable diffusion onderzocht en de toepassingen en effectiviteit ervan belicht.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments door Fuxi Wen (2013):

Introduceert een diffusion least mean p-power (LMP) algoritme voor gedistribueerde schatting in omgevingen met alpha-stable ruis. De studie vergelijkt de diffusion LMP-methode met het diffusion least mean squares (LMS) algoritme en toont verbeterde prestaties aan onder alpha-stable ruiscondities. Dit onderzoek is belangrijk voor het ontwikkelen van robuuste schattingstechnieken in ruisrijke omgevingen. Lees meer

Stable Diffusion for Data Augmentation in COCO and Weed Datasets door Boyang Deng (2024):

Onderzoekt het gebruik van stable diffusion modellen voor het genereren van synthetische beelden met hoge resolutie ter verbetering van kleine datasets. Door technieken als Image-to-image translation, Dreambooth en ControlNet te gebruiken, evalueert het onderzoek de efficiëntie van stable diffusion bij classificatie- en detectietaken. De bevindingen suggereren veelbelovende toepassingen van stable diffusion in diverse domeinen. Lees meer

Diffusion and Relaxation Controlled by Tempered α-stable Processes door Aleksander Stanislavsky, Karina Weron en Aleksander Weron (2011):

Beschrijft eigenschappen van anomalous diffusion en niet-exponentiële relaxatie met behulp van tempered α-stable processen. Het behandelt het probleem van oneindige momenten bij α-stable random operational time en biedt een model waarin subdiffusie als speciaal geval is opgenomen. Lees meer

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion door Andreas Stöckl (2022):

Evalueert synthetische beelden die door het Stable Diffusion model zijn gegenereerd met behulp van de Wordnet-taxonomie. Het beoordeelt het vermogen van het model om correcte beelden voor verschillende concepten te produceren en illustreert verschillen in representatieaccuratesse. Deze evaluaties zijn essentieel om de rol van stable diffusion in data-augmentatie te begrijpen. Lees meer

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion door Sanchayan Vivekananthan (2024):

Verkent drie generatieve frameworks: VAEs, GANs en Stable Diffusion modellen. Het onderzoek belicht de sterktes en beperkingen van elk model en stelt vast dat, hoewel VAEs en GANs hun voordelen hebben, stable diffusion uitblinkt in bepaalde synthese-taken. Lees meer

Laten we kijken hoe je een Stable Diffusion Model in Python implementeert met de Hugging Face Diffusers library.

Installeer de benodigde bibliotheken:

pip install torch transformers diffusers accelerate

pip install xformers # Optioneel

De Diffusers-bibliotheek biedt een handige manier om voorgetrainde modellen te laden:

from diffusers import StableDiffusionPipeline

import torch

# Laad het Stable Diffusion model

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Zet het model op de GPU voor snellere inferentie

Om afbeeldingen te genereren geef je eenvoudig een tekstprompt op:

prompt = "Een sereen landschap met bergen en een meer, fotorealistisch, 8K resolutie"

image = pipe(prompt).images[0]

# Sla de afbeelding op of toon deze

image.save("gegenereerde_afbeelding.png")

model_id.torch.float16 vermindert het geheugengebruik.Je kunt verschillende parameters aanpassen:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Aantal denoising stappen

guidance

Stable Diffusion is een geavanceerd AI-model dat is ontworpen voor het genereren van hoogwaardige, fotorealistische beelden uit tekstprompts. Het gebruikt latent diffusion en deep learning om tekstuele beschrijvingen om te zetten in visuals.

Stable Diffusion werkt door tekstprompts om te zetten in beeldembeddings met een CLIP-tekstencoder en vervolgens een latente representatie iteratief te denoisen, geleid door de prompt, wat resulteert in een samenhangende beeldoutput.

Stable Diffusion wordt gebruikt voor creatieve contentgeneratie, marketingmateriaal, game asset creatie, e-commerce productvisualisatie, educatieve illustraties en AI-gestuurde chatbots.

Ja, Stable Diffusion ondersteunt beeld-naar-beeld vertaling en inpainting, waardoor gebruikers bestaande beelden kunnen aanpassen of ontbrekende delen kunnen invullen op basis van tekstprompts.

Een computer met een moderne GPU wordt aanbevolen voor efficiënte beeldgeneratie met Stable Diffusion. Het model vereist ook Python en bibliotheken zoals PyTorch en Diffusers.

Ja, Stable Diffusion is uitgebracht onder een permissieve open-source licentie, wat bijdragen van de gemeenschap, maatwerk en brede toegankelijkheid stimuleert.

Ontketen je creativiteit met Stable Diffusion en zie hoe AI je ideeën kan omzetten in verbluffende visuals.

Ontdek onze diepgaande review van Stability AI SD3 Large. Analyseer de sterke en zwakke punten, en de creatieve output op diverse tekst-naar-beeld prompts, en o...

Het Flux AI Model van Black Forest Labs is een geavanceerd tekst-naar-beeld generatiesysteem dat natuurlijke taalprompts omzet in zeer gedetailleerde, fotoreali...

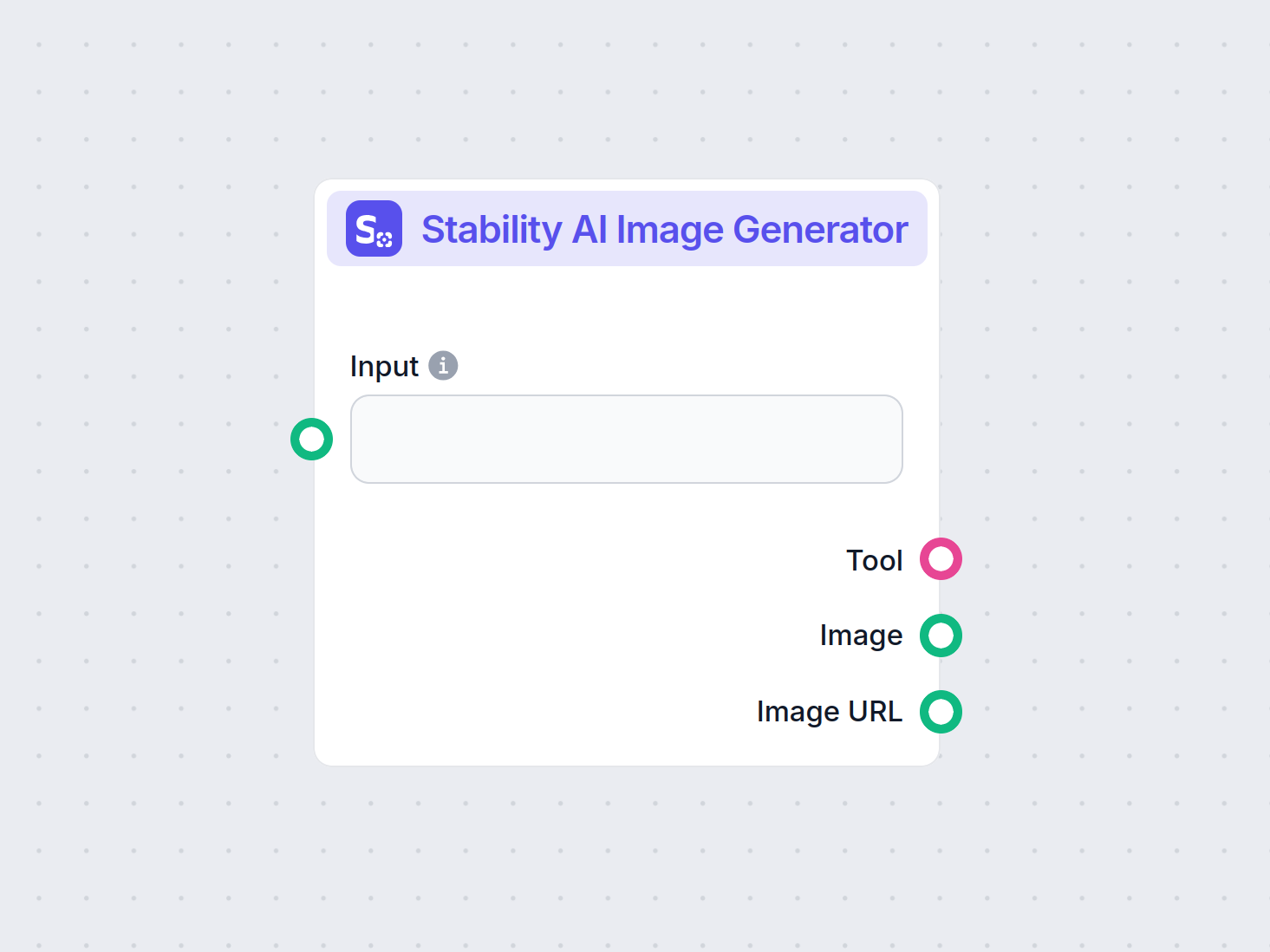

Genereer hoogwaardige afbeeldingen uit tekstprompts met de Stability AI Afbeelding Generator component. Aangedreven door Stable Diffusion-modellen biedt deze to...