LLM OpenAI

FlowHunt ondersteunt tientallen tekstgeneratiemodellen, waaronder modellen van OpenAI. Hier lees je hoe je ChatGPT gebruikt in je AI-tools en chatbots.

OpenAI Whisper is een open-source ASR-systeem dat spraak nauwkeurig omzet naar tekst in 99 talen, en ondersteunt transcriptie, vertaling en taalidentificatie voor robuuste AI-automatisering.

OpenAI Whisper kan zowel als een model als een systeem worden beschouwd, afhankelijk van de context.

De primaire functie van Whisper is het transcriberen van spraak naar tekstoutput. Het blinkt uit in:

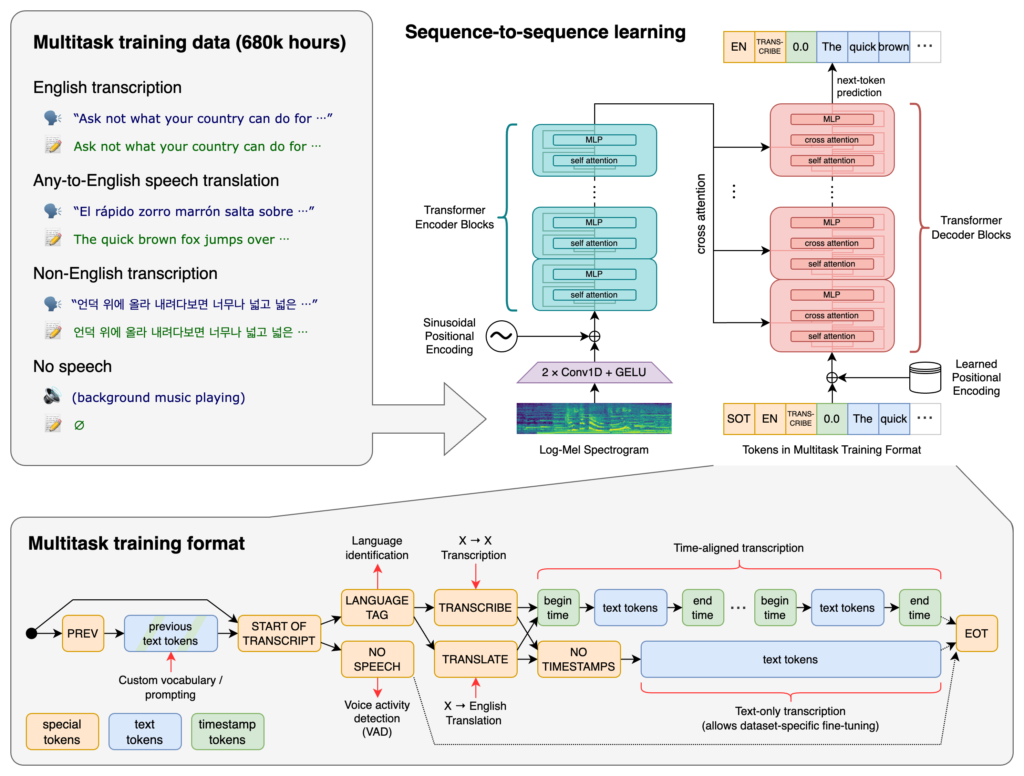

De kern van Whisper bestaat uit de Transformer-architectuur, specifiek een encoder-decoder model. Transformers zijn neurale netwerken die uitblinken in het verwerken van sequentiële data en het begrijpen van context over lange reeksen. Geïntroduceerd in het “Attention is All You Need”-artikel in 2017, zijn Transformers fundamenteel geworden in veel NLP-taken.

Het proces van Whisper omvat:

Whisper is getraind op een enorme dataset van 680.000 uur aan gelabelde data verzameld van het internet. Dit omvat:

Met dekking van 99 talen blinkt Whisper uit in het verwerken van uiteenlopende taalinvoer. Deze meertalige capaciteit maakt het geschikt voor wereldwijde toepassingen en diensten gericht op internationale doelgroepen.

Dankzij training op uitgebreide gelabelde data behaalt Whisper hoge nauwkeurigheidspercentages bij transcriptietaken. De robuustheid tegen verschillende accenten, dialecten en achtergrondgeluiden maakt het betrouwbaar in uiteenlopende praktijksituaties.

Naast transcriptie kan Whisper:

Whisper is uitgebracht als open-source software, waardoor ontwikkelaars kunnen:

Door Whisper te integreren in chatbots en AI-assistenten kunnen ontwikkelaars:

Whisper is geïmplementeerd als een Python-bibliotheek, waardoor naadloze integratie in Python-projecten mogelijk is. Gebruik van Whisper in Python vereist het instellen van de juiste omgeving, het installeren van de benodigde afhankelijkheden en het toepassen van de functies van de bibliotheek om audio te transcriberen of te vertalen.

Voordat je Whisper gebruikt, moet je je ontwikkelomgeving voorbereiden door Python, PyTorch, FFmpeg en de Whisper-bibliotheek zelf te installeren.

Als je Python nog niet hebt geïnstalleerd, download het dan van de officiële website. Om PyTorch te installeren, gebruik pip:

pip install torch

Of bezoek de PyTorch-website voor specifieke installatie-instructies voor jouw besturingssysteem en Python-versie.

Whisper heeft FFmpeg nodig om audiobestanden te verwerken. Installeer FFmpeg met de juiste pakketbeheerder voor jouw besturingssysteem.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (met Homebrew):

brew install ffmpeg

Windows (met Chocolatey):

choco install ffmpeg

Installeer het Whisper Python-pakket met pip:

pip install -U openai-whisper

Om de nieuwste versie direct vanaf de GitHub-repository te installeren:

pip install git+https://github.com/openai/whisper.git

Zorg dat de Ontwikkelaarsmodus is ingeschakeld:

Whisper biedt verschillende modellen die variëren in grootte en mogelijkheden. De modellen lopen van tiny tot large, elk met een eigen balans tussen snelheid en nauwkeurigheid.

| Grootte | Parameters | Alleen-Engels model | Meertalig model | Benodigde VRAM | Relatieve snelheid |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N.v.t. | large | ~10 GB | 1x |

.en): Geoptimaliseerd voor Engelse transcriptie, met betere prestaties voor Engelse audio.Na het instellen van je omgeving en het installeren van de benodigde componenten kun je Whisper gaan gebruiken in je Python-projecten.

Begin met het importeren van de Whisper-bibliotheek en het laden van een model:

import whisper

# Laad het gewenste model

model = whisper.load_model("base")

Vervang "base" door de modelnaam die het beste bij jouw toepassing past.

Whisper biedt een eenvoudige transcribe-functie om audiobestanden om te zetten naar tekst.

Voorbeeld: Engelse audio transcriberen

# Transcribeer het audiobestand

result = model.transcribe("path/to/english_audio.mp3")

# Print de transcriptie

print(result["text"])

model.transcribe(): Verwerkt het audiobestand en geeft een dictionary met de transcriptie en andere metadata.result["text"]: Toont de getranscribeerde tekst uit het resultaat.Whisper kan audio uit verschillende talen naar het Engels vertalen.

Voorbeeld: Spaanse audio vertalen naar Engels

# Transcribeer en vertaal Spaanse audio naar Engels

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# Print de vertaalde tekst

print(result["text"])

task="translate": Geeft het model de opdracht om de audio naar het Engels te vertalen in plaats van letterlijk te transcriberen.Hoewel Whisper de taal automatisch kan detecteren, kan het specificeren ervan de nauwkeurigheid en snelheid verbeteren.

Voorbeeld: Franse audio transcriberen

# Transcribeer Franse audio door de taal te specificeren

result = model.transcribe("path/to/french_audio.wav", language="fr")

# Print de transcriptie

print(result["text"])

Whisper kan de gesproken taal in een audiobestand identificeren met de detect_language-methode.

Voorbeeld: Taaldetectie

# Laad en verwerk de audio

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# Zet om naar log-Mel spectrogram

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Detecteer de taal

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): Laadt het audiobestand.whisper.pad_or_trim(): Past de audiolengte aan voor de inputvereisten van het model.whisper.log_mel_spectrogram(): Zet audio om naar het formaat dat het model verwacht.model.detect_language(): Geeft waarschijnlijkheden voor elke taal, zodat de meest waarschijnlijke taal wordt geïdentificeerd.Voor meer controle over het transcriptieproces kun je gebruik maken van laag-niveau functies en decoderingsopties aanpassen.

decode-functie gebruikenMet de decode-functie kun je opties specificeren zoals taal, taak en of tijdstempels moeten worden toegevoegd.

Voorbeeld: Aangepaste decodeeropties

# Stel decodeeropties in

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Decodeer de audio

result = whisper.decode(model, mel, options)

# Print de herkende tekst

print(result.text)

Je kunt Whisper integreren om live audio-invoer van een microfoon te transcriberen.

Voorbeeld: Live microfooningang transcriberen

import whisper

import sounddevice as sd

# Laad het model

model = whisper.load_model("base")

# Neem audio op van de microfoon

duration = 5 # seconden

fs = 16000 # Sampling rate

print("Recording...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper is een geavanceerd automatisch spraakherkenningssysteem (ASR) ontwikkeld door OpenAI, ontworpen om gesproken taal om te zetten in geschreven tekst met behulp van deep learning. Het ondersteunt 99 talen en blinkt uit in transcriptie, vertaling en taalidentificatie.

Whisper gebruikt een op transformer gebaseerde encoder-decoder architectuur, verwerkt audio tot log-Mel spectrogrammen en zet dit om naar tekst via een taalmodel. Het is getraind op 680.000 uur aan meertalige, multitask data voor hoge nauwkeurigheid en robuustheid.

Whisper ondersteunt meertalige spraakherkenning, spraakvertaling, automatische taalidentificatie, is robuust tegen accenten en ruis, en biedt open-source toegang voor maatwerk en integratie.

De hardwarevereisten zijn afhankelijk van de modelgrootte: kleinere modellen zoals 'tiny' vereisen ~1GB VRAM, terwijl de grootste ~10GB nodig heeft. Whisper draait sneller op GPU's maar kan ook op CPU's werken met langere verwerkingstijden.

Ja, Whisper is geïmplementeerd als een Python-bibliotheek en kan via pip worden geïnstalleerd. Het maakt eenvoudige integratie mogelijk in Python-projecten voor spraaktranscriptie, vertaling en real-time stemtoepassingen.

Veelvoorkomende toepassingen zijn geautomatiseerde transcriptie van vergaderingen, spraakgestuurde chatbots, live vertaling, toegankelijkheidstools (ondertiteling en ondersteunende technologie), callcenter-automatisering en spraakgestuurde automatiseringssystemen.

Ja, alternatieven zijn open-source engines zoals Mozilla DeepSpeech, Kaldi, Wav2vec, en commerciële API's zoals Google Cloud Speech-to-Text, Microsoft Azure AI Speech en AWS Transcribe.

Ja, OpenAI Whisper is open-source, waardoor ontwikkelaars het kunnen aanpassen, verfijnen en integreren in hun eigen producten en diensten zonder licentiebeperkingen.

Integreer geavanceerde spraak-naar-tekst mogelijkheden in je applicaties, automatiseer workflows en verbeter de gebruikerservaring met OpenAI Whisper en FlowHunt.

FlowHunt ondersteunt tientallen tekstgeneratiemodellen, waaronder modellen van OpenAI. Hier lees je hoe je ChatGPT gebruikt in je AI-tools en chatbots.

Een Groot Taalmodel (LLM) is een type AI dat is getraind op enorme hoeveelheden tekstuele data om menselijke taal te begrijpen, genereren en manipuleren. LLM's ...

Ontdek hoe de geavanceerde redeneercapaciteiten en reinforcement learning van OpenAI O1 zorgen voor betere RAG-nauwkeurigheid dan GPT4o, met benchmarks en koste...