Tekstgenerering

Tekstgenerering med store språkmodeller (LLMs) innebærer avansert bruk av maskinlæringsmodeller for å produsere menneskelignende tekst fra forespørsler. Utforsk...

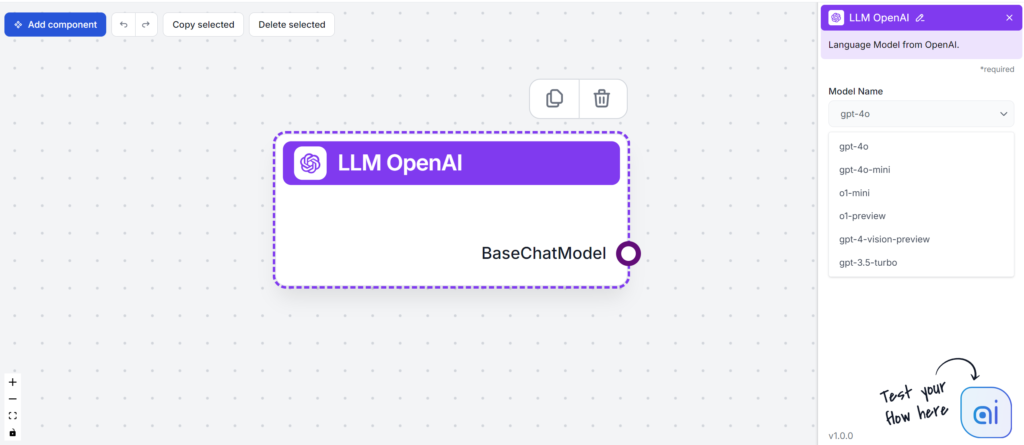

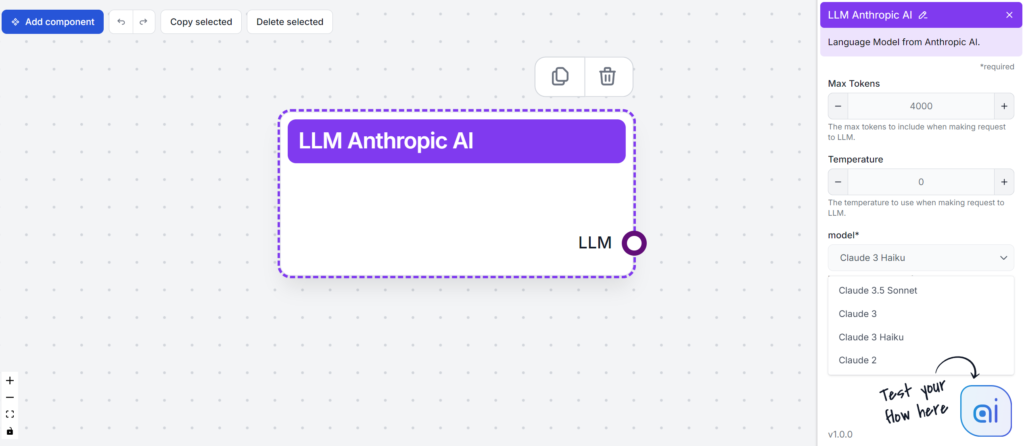

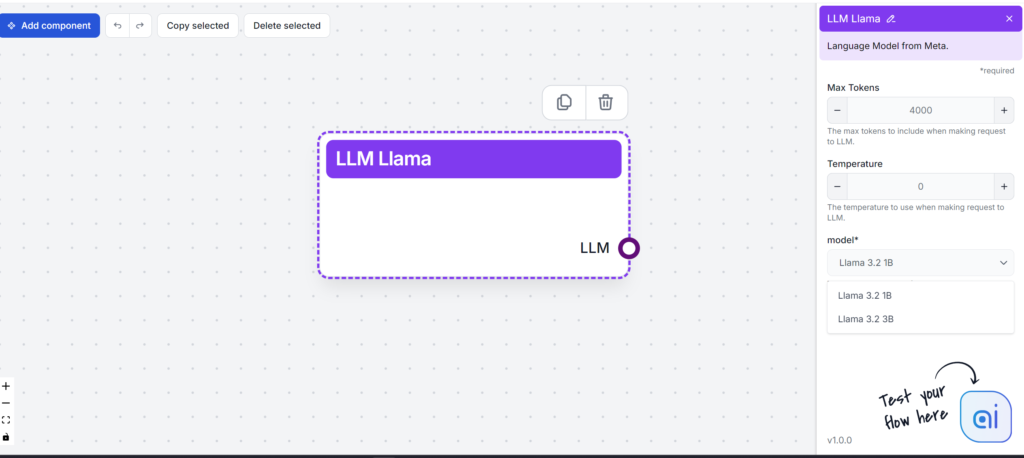

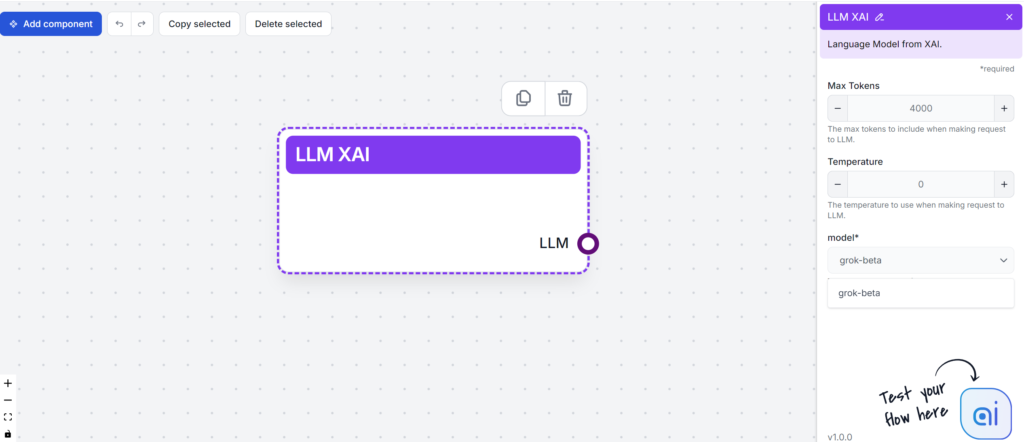

FlowHunt tester og rangerer ledende LLM-er — inkludert GPT-4, Claude 3, Llama 3 og Grok — for innholdsproduksjon, og vurderer lesbarhet, tone, originalitet og nøkkelordbruk for å hjelpe deg å velge den beste modellen for dine behov.

Store språkmodeller (LLMs) er banebrytende AI-verktøy som endrer hvordan vi lager og konsumerer innhold. Før vi går dypere inn i forskjellene mellom individuelle LLM-er, bør du forstå hva som gjør det mulig for disse modellene å lage menneskelignende tekst så enkelt.

LLM-er trenes på enorme datasett, noe som hjelper dem å forstå kontekst, semantikk og syntaks. Basert på mengden data kan de korrekt forutsi neste ord i en setning, og sette sammen ordene til forståelig tekst. En grunn til deres effektivitet er transformer-arkitekturen. Denne selvoppmerksomhetsmekanismen bruker nevrale nettverk til å prosessere tekstsyntaks og semantikk. Dette betyr at LLM-er kan håndtere et bredt spekter av komplekse oppgaver med letthet.

Store språkmodeller (LLMs) har forvandlet måten bedrifter tilnærmer seg innholdsproduksjon på. Med evnen til å produsere personlig og optimalisert tekst, genererer LLM-er innhold som e-poster, landingssider og innlegg på sosiale medier ved å bruke menneskelige språkforespørsler.

Her er hva LLM-er kan hjelpe innholdsforfattere med:

I tillegg ser fremtiden for LLM-er lovende ut. Teknologiske fremskritt vil sannsynligvis forbedre nøyaktigheten og de multimodale evnene. Denne utvidelsen av bruksområder vil få betydelig innvirkning på mange bransjer.

Her er en rask oversikt over de populære LLM-ene vi skal teste:

| Modell | Unike styrker |

|---|---|

| GPT-4 | Allsidig i ulike skrivestiler |

| Claude 3 | Utmerker seg i kreative og kontekstuelle oppgaver |

| Llama 3.2 | Kjent for effektiv tekstoppsummering |

| Grok | Kjent for fokus på en avslappet og humoristisk tone |

Når du velger en LLM, er det viktig å vurdere dine behov for innholdsskaping. Hver modell tilbyr noe unikt, fra å håndtere komplekse oppgaver til å generere AI-drevet kreativt innhold. Før vi tester dem, la oss kort oppsummere hver for å se hvordan de kan gagne din innholdsproduksjon.

Nøkkelfunksjoner:

Ytelsesmålinger:

Styrker:

Utfordringer:

Totalt sett er GPT-4 et kraftig verktøy for bedrifter som ønsker å styrke innholdsskaping og dataanalyse.

Nøkkelfunksjoner:

Styrker:

Utfordringer:

Nøkkelfunksjoner:

Styrker:

Utfordringer:

Llama 3 utmerker seg som en robust og allsidig åpen kildekode-LLM, og lover fremskritt i AI, men gir også brukere enkelte utfordringer.

Nøkkelfunksjoner:

Styrker:

Utfordringer:

Oppsummert tilbyr xAI Grok interessante funksjoner og har fordelen av medieoppmerksomhet, men møter betydelige utfordringer i popularitet og ytelse i konkurransen mellom språkmodeller.

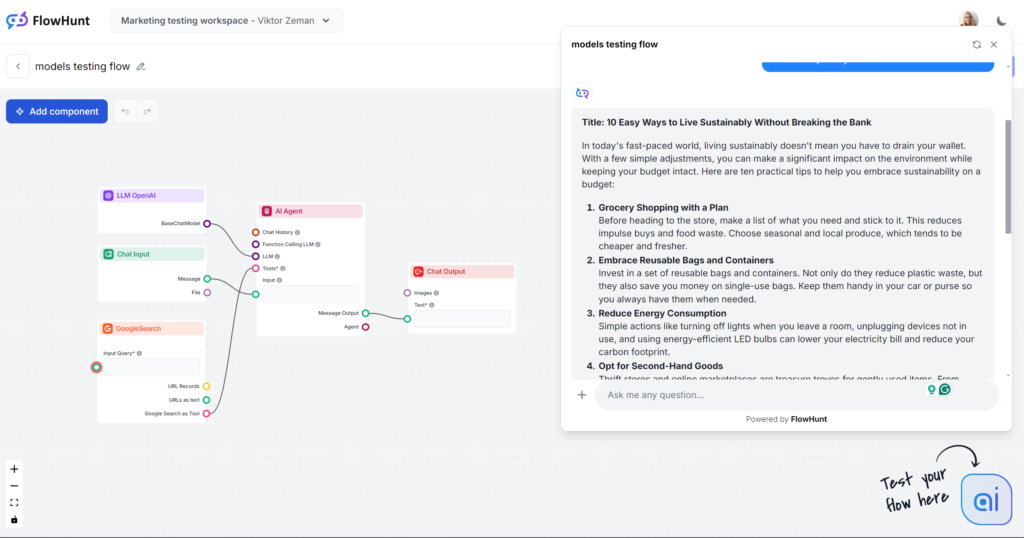

La oss gå rett på testing. Vi rangerer modellene ved å bruke en enkel bloggutgang. All testing ble utført i FlowHunt, kun LLM-modellen ble endret.

Viktige fokusområder:

Testprompt:

Skriv et blogginnlegg med tittelen “10 enkle måter å leve bærekraftig uten å sprenge budsjettet.” Tonen skal være praktisk og imøtekommende, med fokus på gjennomførbare tips som er realistiske for travle personer. Fremhev “bærekraft på budsjett” som hovednøkkelord. Inkluder eksempler fra hverdagslige situasjoner som dagligvarehandel, energibruk og personlige vaner. Avslutt med en oppmuntrende oppfordring om å starte med ett tips i dag.

Merk: Flow er begrenset til å lage utdata på omtrent 500 ord. Hvis du synes utgangene er forhastede eller ikke går i dybden, er dette med hensikt.

Hvis dette var en blindtest, ville åpningslinjen “I dagens hektiske verden…” avsløre modellen med en gang. Du er trolig godt kjent med denne modellens skrivemåte, da det ikke bare er det mest populære valget, men også kjernen i de fleste tredjeparts AI-skriveverktøy. GPT-4o er alltid et trygt valg for generelt innhold, men vær forberedt på vaghet og omstendelighet.

Tone og språk

Ser man bort fra den smertefullt overbrukte åpningssetningen, gjorde GPT-4o akkurat det vi forventet. Det er ikke lett å lure noen til å tro at en menneskelig forfatter har skrevet dette, men det er fortsatt en greit strukturert artikkel som følger prompten. Tonen er virkelig praktisk og imøtekommende, og fokuserer umiddelbart på konkrete tips i stedet for vage utlegninger.

Nøkkelordbruk

GPT-4o klarte seg bra i testen av nøkkelordbruk. Den brukte ikke bare det angitte hovednøkkelordet, men også lignende fraser og andre relevante nøkkelord.

Lesbarhet

På Flesch-Kincaid-skalaen rangerer denne utgangen som 10.–12. klasse (ganske vanskelig) med en score på 51,2. Ett poeng lavere, og den ville vært på høyskolenivå. Med en så kort utgang har til og med nøkkelordet “bærekraft” sannsynligvis merkbar effekt på lesbarheten. Det er likevel mye rom for forbedring.

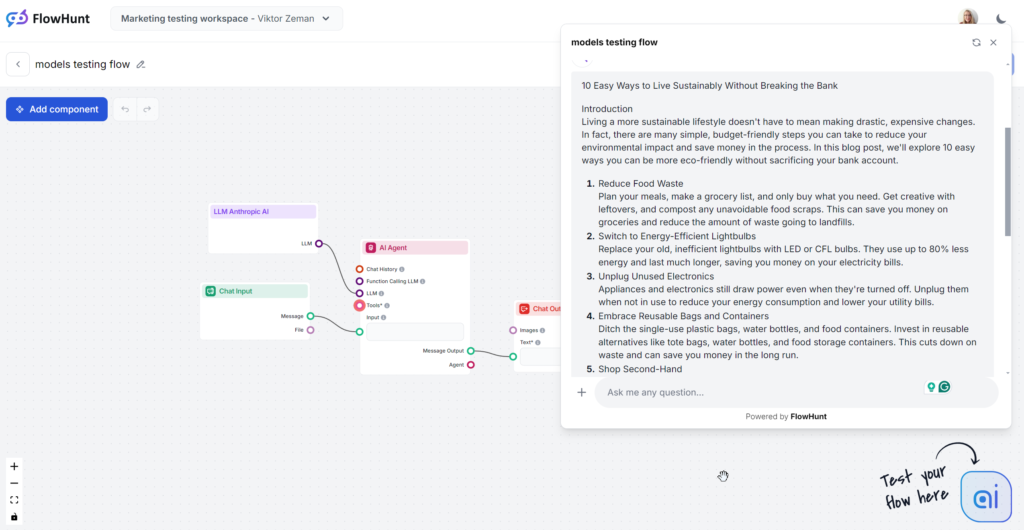

Den analyserte Claude-utgangen er mellomnivåmodellen Sonnet, som sies å være det beste valget for innhold. Innholdet leses godt og er merkbart mer menneskelig enn GPT-4o eller Llama. Claude er den perfekte løsningen for rent og enkelt innhold som gir informasjon effektivt uten å bli like omstendelig som GPT eller like prangende som Grok.

Tone og språk

Claude utmerker seg med en enkel, relaterbar og menneskelig skrivestil. Tonen er praktisk og imøtekommende, og fokuserer umiddelbart på konkrete tips.

Nøkkelordbruk

Claude var den eneste modellen som ignorerte nøkkelordet i prompten, og brukte det kun i 1 av 3 utganger. Når det ble brukt, var det i konklusjonen, og bruken føltes noe påtvunget.

Lesbarhet

Claude Sonnet scoret høyt på Flesch-Kincaid-skalaen, og rangerte på 8. og 9. klassetrinn (enkel engelsk), bare noen poeng bak Grok. Mens Grok endret hele tone og vokabular for å oppnå dette, brukte Claude lignende ordforråd som GPT-4o. Hva gjorde lesbarheten så god? Kortere setninger, hverdagsord og ingen vagt innhold.

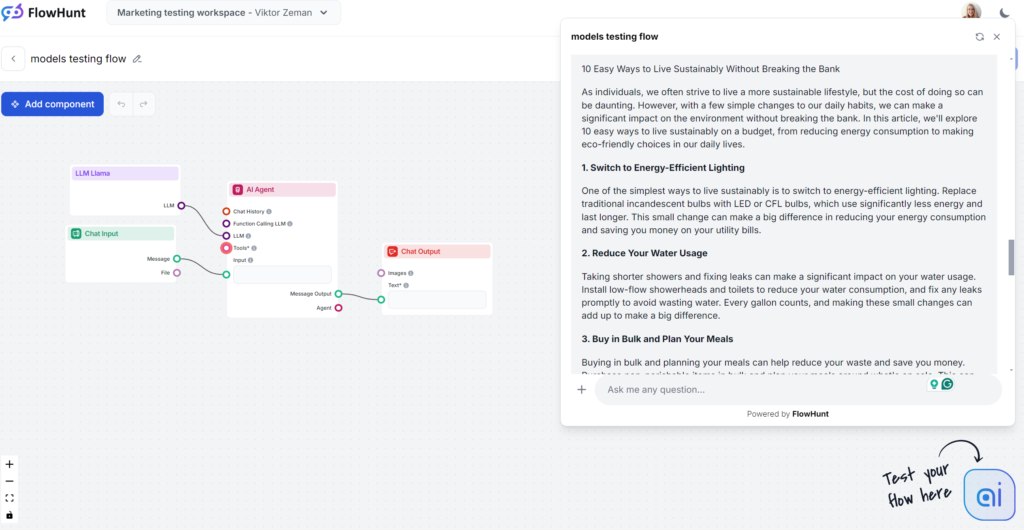

Llamas sterkeste punkt var nøkkelordbruk. På den andre siden var skrivestilen uinspirert og litt omstendelig, men fortsatt mindre kjedelig enn GPT-4o. Llama er som GPT-4os fetter – et sikkert innholdsvalg med en noe omstendelig og vag skrivestil. Det er et godt valg hvis du liker OpenAIs skrivestil, men vil unngå klassiske GPT-fraseer.

Tone og språk

Llama-genererte artikler ligner mye på de fra GPT-4o. Omstendelighet og vaghet er sammenlignbart, men tonen er praktisk og imøtekommende.

Nøkkelordbruk

Meta er vinneren i testen for nøkkelordbruk. Llama brukte nøkkelordet flere ganger, inkludert i innledningen, og inkluderte naturlig lignende fraser og andre relevante nøkkelord.

Lesbarhet

På Flesch-Kincaid-skalaen rangerer denne utgangen som 10.–12. klasse (ganske vanskelig), med 53,4 poeng, litt bedre enn GPT-4o (51,2). Med en så kort utgang har nøkkelordet “bærekraft” sannsynligvis merkbar effekt på lesbarheten. Det er fortsatt rom for forbedring.

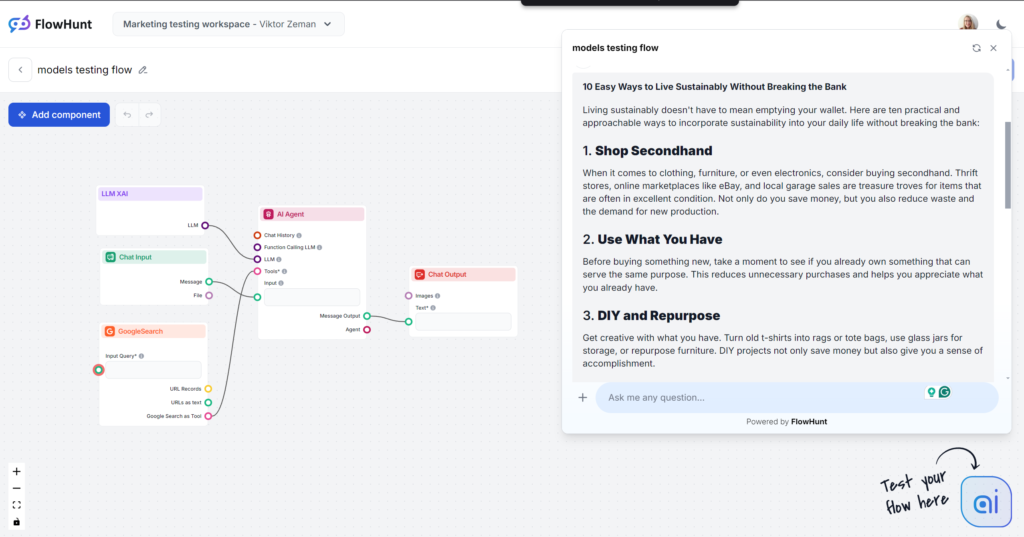

Grok var en stor overraskelse, spesielt når det gjelder tone og språk. Med en svært naturlig og avslappet tone føltes det som å få tips fra en nær venn. Hvis avslappet og kvikk er din skrivestil, er Grok definitivt valget for deg.

Tone og språk

Utgangen leses veldig godt. Språket er naturlig, setningene er korte, og Grok bruker idiomer godt. Modellen holder seg til sin primære tone og tøyer grensene for menneskelignende tekst. Merk: Groks avslappede tone er ikke alltid passende for B2B- og SEO-drevet innhold.

Nøkkelordbruk

Grok brukte nøkkelordet vi ba om, men kun i avslutningen. Andre modeller plasserte nøkkelordet bedre og la til flere relevante, mens Grok fokuserte mer på språklig flyt.

Lesbarhet

Med sitt lettfattelige språk bestod Grok Flesch-Kincaid-testen med glans. Den fikk 61,4 poeng, som tilsvarer 7.–8. klasse (enkel engelsk). Dette er optimalt for å gjøre emner tilgjengelige for folk flest. Dette store spranget i lesbarhet er nesten håndgripelig.

Kraften til LLM-er avhenger av kvaliteten på treningsdataene, som noen ganger kan være skjeve eller unøyaktige, og føre til spredning av feilinformasjon. Det er avgjørende å faktasjekke og kvalitetssikre AI-generert innhold for rettferdighet og inkludering. Når du tester ulike modeller, husk at hver har ulik tilnærming til personvern og begrensning av skadelig innhold.

For å veilede etisk bruk må organisasjoner etablere rammeverk for datavern, bias-redusering og innholdsmoderering. Dette inkluderer jevnlig dialog mellom AI-utviklere, skribenter og juridiske eksperter. Vurder denne listen over etiske hensyn:

Valg av LLM bør være i tråd med organisasjonens etiske innholdsretningslinjer. Både åpen kildekode- og proprietære modeller bør vurderes for potensiell misbruk.

Bias, unøyaktighet og hallusinasjoner er fortsatt store problemer for AI-generert innhold. På grunn av innebygde retningslinjer gir dette ofte vage, lite verdifulle LLM-utganger. Bedrifter trenger ofte ekstra opplæring og sikkerhetstiltak for å håndtere dette. For små bedrifter er tid og ressurser til tilpasset opplæring ofte urealistisk. Et alternativ er å legge til slike muligheter via generelle modeller gjennom tredjepartsverktøy som FlowHunt.

FlowHunt lar deg gi klassiske basismodeller spesifikk kunnskap, internett-tilgang og nye evner. Slik kan du velge riktig modell for oppgaven uten begrensninger fra basismodellen eller utallige abonnementer.

Et annet stort problem er kompleksiteten i disse modellene. Med milliarder av parametre kan de være vanskelige å styre, forstå og feilsøke. FlowHunt gir deg langt mer kontroll enn enkle chatforespørsler. Du kan legge til individuelle evner som blokker og justere dem for å lage ditt eget bibliotek av klare AI-verktøy.

Fremtiden for språkmodeller (LLM-er) i innholdsskriving er lovende og spennende. Etter hvert som disse modellene utvikles videre, lover de økt nøyaktighet og mindre bias i innholdsproduksjonen. Dette betyr at skribenter vil kunne produsere pålitelig, menneskelignende tekst med AI-generert innhold.

LLM-er vil ikke bare håndtere tekst, men også bli dyktige i multimodal innholdsskaping. Dette inkluderer håndtering av både tekst og bilder, og gir økt kreativitet for ulike bransjer. Med større og bedre filtrerte datasett vil LLM-er lage mer pålitelig innhold og forbedre skrivestiler.

Men foreløpig kan ikke LLM-er gjøre alt dette alene, og disse mulighetene er delt mellom ulike selskaper og modeller, som alle kjemper om din oppmerksomhet og penger. FlowHunt samler dem alle og lar

GPT-4 er den mest populære og allsidige for generelt innhold, men Metas Llama tilbyr en friskere skrivestil. Claude 3 er best for rent og enkelt innhold, mens Grok utmerker seg med en avslappet, menneskelig tone. Det beste valget avhenger av dine innholdsmål og stilpreferanser.

Vurder lesbarhet, tone, originalitet, nøkkelordbruk og hvordan hver modell samsvarer med dine innholdsbehov. Vei også styrker som kreativitet, sjangerbredde eller integreringspotensial, og vær oppmerksom på utfordringer som bias, omstendelighet eller ressurskrav.

FlowHunt lar deg teste og sammenligne flere ledende LLM-er i ett miljø, gir kontroll over utdata og gjør det mulig å finne den beste modellen for din spesifikke innholdsarbeidsflyt uten flere abonnementer.

Ja. LLM-er kan videreføre bias, generere feilinformasjon og reise bekymringer rundt datavern. Det er viktig å faktasjekke AI-utdata, vurdere modeller for etisk samsvar og etablere rammer for ansvarlig bruk.

Fremtidige LLM-er vil tilby bedre nøyaktighet, mindre bias og multimodal innholdsskaping (tekst, bilder, osv.), noe som gir skribenter mulighet til å lage mer pålitelig og kreativt innhold. Samlede plattformer som FlowHunt vil forenkle tilgangen til disse avanserte mulighetene.

Opplev topp LLM-er side om side og forbedre din arbeidsflyt for innholdsskriving med FlowHunts samlede plattform.

Tekstgenerering med store språkmodeller (LLMs) innebærer avansert bruk av maskinlæringsmodeller for å produsere menneskelignende tekst fra forespørsler. Utforsk...

En stor språkmodell (LLM) er en type KI trent på enorme mengder tekstdata for å forstå, generere og manipulere menneskespråk. LLM-er bruker dyp læring og transf...

Språkgjenkjenning i store språkmodeller (LLM-er) er prosessen der disse modellene identifiserer språket i innteksten, noe som muliggjør nøyaktig behandling for ...