Gemini Flash 2.0: KI med fart og presisjon

Gemini Flash 2.0 setter nye standarder innen KI med forbedret ytelse, hastighet og multimodale egenskaper. Utforsk potensialet i virkelige applikasjoner.

Utforsk hvordan Google I/O 2025 innleder Gemini-æraen med AI-drevne oppdateringer i hele Googles økosystem, og se hvordan FlowHunt bringer den nyeste Gemini 2.5 Flash-modellen til dine AI-prosjekter.

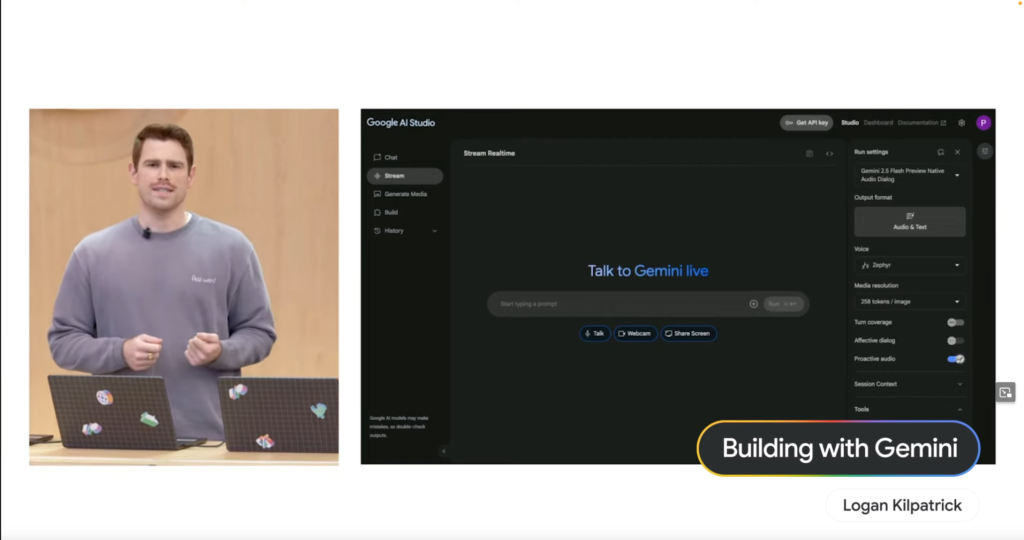

Logan Kilpatrick åpnet med å vise hvordan Project Astra har som mål å gjøre AI-interaksjon helt naturlig. Mange av disse funksjonene er nå tilgjengelige gjennom Live API, drevet av den nye Gemini 2.5 Flash native lydmodellen. Denne modellen er flinkere til å ignorere forstyrrende lyder og støtter natively 24 språk, noe som baner vei for mer intuitive og responsive AI-opplevelser.

Paige Bailey demonstrerte styrken ved å bygge med Gemini gjennom en “Keynote Companion”-demo. Ved å bruke Google AI Studio viste hun hvordan AI kunne forstå talekommandoer, samhandle med sanntidsdata (som å vise Shoreline Amphitheatre på et kart), og til og med utføre komplekse søk som å finne kaffebarer med Wi-Fi i nærheten, alt i en samtaleflyt. Dette fremhever Geminis imponerende multimodale egenskaper.

Adaptive by Design: Compose og Android XR

Diana Wong understreket Googles satsing på å gjøre adaptive brukergrensesnitt enklere å bygge. Nye funksjoner i Compose Adaptive Layouts-biblioteket, som Pane Expansion, er utviklet for å hjelpe utviklere med å lage apper som sømløst tilpasser seg ulike skjermstørrelser og formfaktorer. Denne adaptive filosofien strekker seg direkte til Android XR, plattformen for utvidet virkelighet utviklet i samarbeid med Samsung. Utviklere kan begynne å bygge for kommende headset som Project Moohan allerede nå, vel vitende om at deres adaptive apper er klare for denne nye immersive fremtiden.

Smartere koding: AI-agenter i Android Studio

Florina Muntenescu avduket en stor nyhet for Android-utviklere: en ny AI-agent som snart kommer til Android Studio. Denne agenten er utviklet for å hjelpe med kjedelige oppgaver som versjonsoppdateringer. I en overbevisende demo analyserte AI-agenten et gammelt prosjekt, identifiserte byggefeil, og brukte deretter Gemini for å finne ut hvordan problemene kunne løses, og itererte til bygget var vellykket. Dette lover å effektivisere utviklingsprosessen betydelig.

Strømlinjeformede webgrensesnitt: Nye muligheter for komplekse elementer

Una Kravets fremhevet nye webfunksjoner som forenkler opprettelsen av vanlige, men overraskende komplekse UI-elementer. Utviklere vil lettere kunne lage robuste og tilgjengelige komponenter som karuseller og hover-kort, og forbedre brukeropplevelsen på nettet.

Gemini Nano på nettet: Multimodale AI-API-er frigjøres

Addy Osmani kunngjorde at Gemini Nano åpner for nye multimodale muligheter direkte på nettet. Nye multimodale innebygde AI-API-er lar brukere samhandle med Gemini ved hjelp av både lyd- og bildeinput. En “Cinemal”-demo viste dette ved at en bruker tok et bilde av en billett med webkameraet, og den lokale AI-en fant umiddelbart seteseksjonen på et teaterkart – et kraftfullt eksempel på lokal prosessering.

David East demonstrerte hvordan Firebase integrerer AI for å akselerere apputvikling. Utviklere kan nå gjøre Figma-design levende i Firebase Studio med hjelp fra Builder.io. Det imponerende? Dette er ikke bare en monolitisk kodeeksport; Figma-eksporten genererer adskilte, individuelle React-komponenter. Ved å bruke Gemini i Firebase Studio viste David hvordan han enkelt kunne be AI-en legge til funksjoner som en “Legg til i handlekurv”-knapp på en produktside, som AI-en straks implementerte, og oppdaterte både kode og live forhåndsvisning.

Gemma 3n: Kraftig AI på bare 2GB RAM

Gus Martins kom med spennende nyheter for open source-miljøet med kunngjøringen av Gemma 3n. Denne utrolige effektive modellen kan kjøre på så lite som 2GB RAM, noe som gjør den mye raskere og slankere for mobil maskinvare sammenlignet med Gemma 3. Viktigst av alt inkluderer Gemma 3n nå lydforståelse, som gjør den virkelig multimodal.

SignGemma: Bygger bro over kommunikasjonsgap

Google utvider også tilgjengeligheten med SignGemma. Denne nye modellfamilien er trent til å oversette tegnspråk (med nåværende fokus på amerikansk tegnspråk – ASL) til talespråk-tekst, og åpner nye muligheter for kommunikasjon og inkludering.

Blir du inspirert av de utrolige AI-nyhetene fra Google I/O? Ønsker du å begynne å lage sofistikerte AI-agenter som kan forstå, resonnere og handle?

FlowHunt er plattformen som hjelper deg å lage kraftfulle AI-agenter sømløst, uten å være maskinlæringsekspert. Design komplekse arbeidsflyter, integrer ulike verktøy og distribuer intelligente agenter med letthet.

Og gode nyheter? Som fremhevet av kraften til de nye modellene i keynoten, støtter FlowHunt nå banebrytende Gemini 2.5 Flash! Det betyr at du umiddelbart kan begynne å utnytte hastigheten, effektiviteten og de forbedrede lydmulighetene for å bygge enda kraftigere og mer responsive AI-agenter.

Prøv de nye modellene implementert på under 24 timer i FlowHunt med én gang!

Google I/O 2025 fremhever selskapets overgang til en AI-native fremtid, med Gemini-modeller i kjernen av nye produkter og funksjoner på tvers av Android, nettet og utviklerverktøy.

Gemini 2.5 Flash er Googles nyeste native lyd-AI-modell, som tilbyr rask, effektiv og flerspråklig lydprosessering, nå tilgjengelig for utviklere og integrert i plattformer som FlowHunt.

Gemma 3n er en effektiv AI-modell som kjører på så lite som 2GB RAM med multimodale (lyd) egenskaper. SignGemma er en modellfamilie som oversetter tegnspråk, med fokus på ASL, til talespråk-tekst.

FlowHunt støtter nå Gemini 2.5 Flash, slik at brukere kan lage avanserte AI-agenter med forbedrede lyd- og multimodale egenskaper, uten å kreve maskinlæringskompetanse.

Android introduserte adaptive brukergrensesnitt, XR-støtte og AI-agenter i Android Studio for smartere koding. På nettet gjør Gemini Nano det mulig med multimodale AI-API-er for lyd- og bildeinput direkte i nettleseren.

Yasha er en dyktig programvareutvikler som spesialiserer seg på Python, Java og maskinlæring. Yasha skriver tekniske artikler om AI, prompt engineering og utvikling av chatboter.

Opplev kraften til den nye Gemini 2.5 Flash-modellen i FlowHunt og bygg neste generasjons AI-agenter med avanserte multimodale egenskaper.

Gemini Flash 2.0 setter nye standarder innen KI med forbedret ytelse, hastighet og multimodale egenskaper. Utforsk potensialet i virkelige applikasjoner.

Utforsk tankeprosessen, arkitekturen og beslutningstakingen til Gemini 1.5 Pro, en allsidig KI-agent, gjennom virkelige oppgaver og grundig analyse av dens reso...

Utforsk arkitekturen, tankeprosessen og den virkelige ytelsen til Gemini 1.5 Flash 8B—en avansert AI-agent som utmerker seg innen informasjonsbehandling, resonn...