Metaprompt

En metaprompt innen kunstig intelligens er en høynivå-instruksjon utformet for å generere eller forbedre andre prompt for store språkmodeller (LLMs), som forbed...

Bli ekspert på promptoptimalisering for AI ved å lage tydelige, kontekstfylte prompter som øker output-kvaliteten, reduserer kostnader og kutter behandlingstid. Utforsk teknikker for smartere AI-arbeidsflyter.

Promptoptimalisering betyr å forbedre inputen du gir til en AI-modell slik at den leverer de mest nøyaktige og effektive svarene mulig. Det handler ikke bare om tydelig kommunikasjon—optimaliserte prompter reduserer også beregningskostnader, som gir raskere behandlingstid og lavere utgifter. Enten du skriver spørsmål til kundestøtte-chatboter eller genererer komplekse rapporter, har det stor betydning hvordan du strukturerer og formulerer prompter.

Har du noen gang prøvd å be AI skrive en metabeskrivelse? Sjansen er stor for at ditt første forsøk lød omtrent slik:

Skriv en metabeskrivelse for temaet promptoptimalisering.

Denne prompten er feil av flere grunner. Hvis du ikke spesifiserer lengden på 140 tegn som Google krever, vil AI ofte gå langt over. Hvis den treffer riktig lengde, vil den ofte bruke en annen stil eller gjøre beskrivelsen for kjedelig til at noen vil klikke. Til slutt, uten å ha lest artikkelen din, kan den bare lage vage metabeskrivelser.

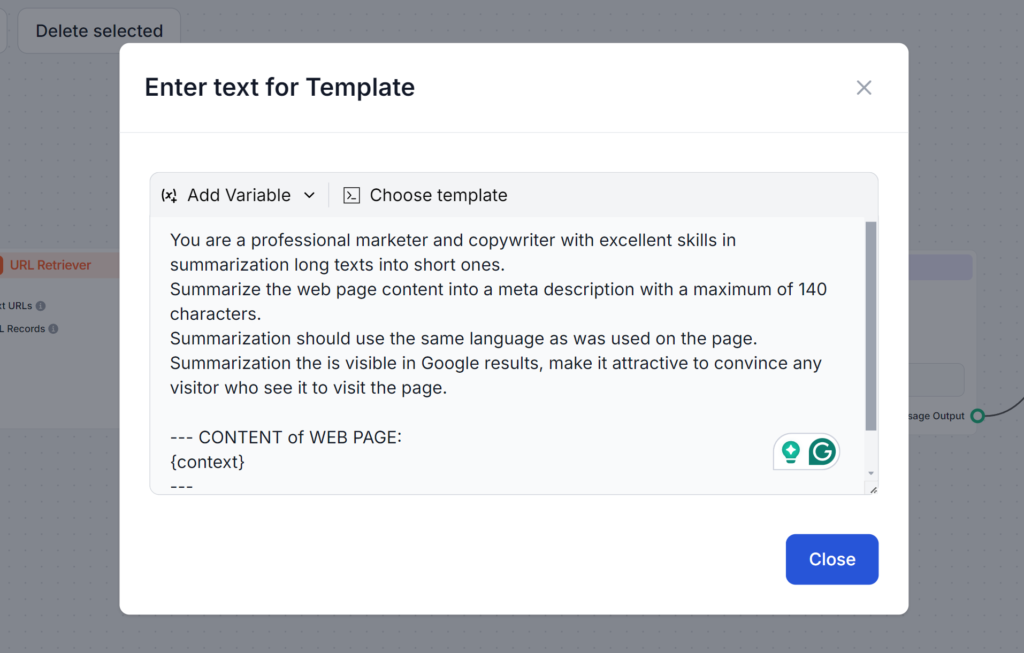

Se prompten nedenfor. Den er lengre og bruker flere teknikker vi skal lære om i dette blogginnlegget. Det denne prompten gjør bra, er at den tar for seg alle mulige problemer og sikrer at du får nøyaktig det resultatet du trenger på første forsøk:

Tokens er byggeklossene i teksten som AI-modeller prosesserer. Modellene deler opp teksten i disse tokenene. Ett token kan være ett ord, flere ord eller til og med en del av et ord. Flere tokens betyr som regel tregere svar og høyere datakostnader. Det å forstå hvordan tokens fungerer er derfor viktig for å lage bedre prompter og sørge for at de er kostnadseffektive og raske å kjøre.

Hvorfor tokens er viktige:

For eksempel:

I prompten med mange tokens blir AI bedt om å gå i detalj om alle mulige alternativer, mens prompten med få tokens ber om en enkel oversikt. Ved å få oversikten kan du utvide den etter behov og komme raskere og billigere til ønsket resultat.

Å lage effektive prompter krever en blanding av tydelighet, kontekst og kreativitet. Det anbefales å prøve ulike formater for å finne de mest effektive måtene å spørre AI på. Her er noen viktige teknikker:

Utydelige prompter kan forvirre modellen. En godt strukturert prompt sikrer at AI forstår hva du mener.

Eksempel:

Å legge til relevante detaljer hjelper AI å lage svar som er tilpasset dine behov.

Eksempel:

Ved å legge inn eksempler hjelper du AI å forstå formatet eller tonen du ønsker.

Eksempel:

Ved å bruke standardiserte maler for like oppgaver sikrer du konsistens og sparer tid.

Eksempelmåte for bloggskriving:

“Skriv et [antall ord] blogginnlegg om [tema], med fokus på [spesifikke detaljer]. Bruk en vennlig tone og inkluder [nøkkelord].”

Flere avanserte strategier kan løfte promptene dine til et nytt nivå. Disse teknikkene går utover grunnleggende tydelighet og struktur, og lar deg håndtere mer komplekse oppgaver, integrere dynamiske data og tilpasse AI-svar til bestemte domener eller behov. Her er en kort oversikt over hvordan hver teknikk fungerer, med praktiske eksempler.

Few-shot learning handler om å gi noen få eksempler i prompten for å hjelpe AI å forstå mønsteret eller formatet du ønsker. Dette lar modellen generalisere effektivt med minimalt med data, og er ideelt for nye eller ukjente oppgaver.

Bare legg inn noen eksempler i prompten for å vise modellen hva du forventer.

Eksempelpå prompt:

Oversett følgende fraser til fransk:

Prompt chaining er prosessen med å bryte ned komplekse oppgaver i mindre, håndterbare steg som bygger på hverandre. Denne metoden lar AI løse flerstegsproblemer systematisk, og sikrer klarhet og presisjon i resultatet.

Eksempelpå prompt:

Kontekstuell gjenfinning integrerer relevant, oppdatert informasjon i prompten ved å referere til eksterne kilder eller oppsummere viktige detaljer. Slik gir du AI tilgang til nøyaktige og ferske data for bedre svar.

Eksempel:

“Bruk data fra denne rapporten [sett inn lenke] og oppsummer hovedfunnene om fornybar energi [trender.”

Finjustering med embeddings tilpasser AI-modellen til spesifikke oppgaver eller domener ved å bruke spesialiserte datarepresentasjoner. Denne tilpasningen øker relevansen og nøyaktigheten på svar i nisje- eller bransjespesifikke applikasjoner.

God håndtering av tokens lar deg kontrollere hvor raskt og kostnadseffektivt AI behandler input og output. Ved å redusere antall tokens som behandles, kan du spare kostnader og få raskere responstid uten å gå på bekostning av kvalitet. Her er teknikker for effektiv tokenhåndtering:

Optimalisering slutter ikke med å skrive bedre prompter. Følg jevnlig med på ytelsen og gjør endringer basert på tilbakemeldinger. Denne kontinuerlige oppfølgingen gir deg mulighet til å forbedre resultatene over tid.

Fokuser på disse områdene:

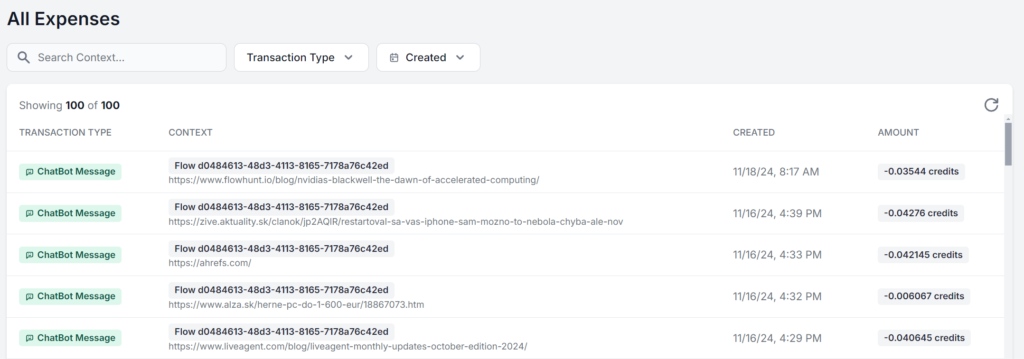

Den beste løsningen er å jobbe i et grensesnitt som lar deg se og analysere nøyaktig bruk for hver prompt. Her ser du samme FlowHunt AI-arbeidsflyt kjørt 5 ganger, kun med endret kildemateriale. Forskjellen i utgifter er bare noen øre, men etter hvert som nye utgifter hoper seg opp, blir forskjellen raskt merkbar:

Enten du bare vil få mest mulig ut av gratisgrensen på AI-modeller eller bygger en AI-strategi i stor skala, er promptoptimalisering avgjørende for alle som bruker AI. Disse teknikkene lar deg bruke AI effektivt, få nøyaktige resultater og redusere kostnader.

Etter hvert som AI-teknologien utvikler seg, vil betydningen av tydelig og optimalisert kommunikasjon med modellene bare øke. Begynn å eksperimentere med disse strategiene i dag, gratis. FlowHunt lar deg bygge med ulike AI-modeller og funksjoner i ett og samme dashbord, slik at du får optimaliserte og effektive AI-arbeidsflyter for alle oppgaver. Prøv 14 dagers gratis prøveperiode!

Promptoptimalisering innebærer å forbedre inputen du gir til en AI-modell slik at den leverer de mest nøyaktige og effektive svarene. Optimaliserte prompter reduserer beregningskostnader, som gir raskere behandlingstid og lavere utgifter.

Antall tokens påvirker både hastigheten og kostnaden på AI-resultater. Færre tokens gir raskere svar og lavere kostnader, mens konsise prompter hjelper modellene å fokusere på relevante detaljer.

Avanserte teknikker inkluderer few-shot learning, prompt chaining, kontekstuell gjenfinning og finjustering med embeddings. Disse metodene hjelper med å løse komplekse oppgaver, integrere dynamiske data og tilpasse svar til spesifikke behov.

Overvåk nøyaktigheten på svar, tokenbruk og behandlingstider. Jevnlig oppfølging og iterasjon basert på tilbakemeldinger hjelper med å forbedre prompter og opprettholde effektivitet.

FlowHunt tilbyr verktøy og et dashbord for å bygge, teste og optimalisere AI-prompter, slik at du kan eksperimentere med ulike modeller og strategier for effektive AI-arbeidsflyter.

Maria er tekstforfatter hos FlowHunt. En språknerd som er aktiv i litterære miljøer, hun er fullt klar over at KI forandrer måten vi skriver på. I stedet for å motsette seg utviklingen, ønsker hun å bidra til å finne den perfekte balansen mellom KI-arbeidsflyt og den uerstattelige verdien av menneskelig kreativitet.

Begynn å bygge optimaliserte AI-arbeidsflyter med FlowHunt. Eksperimenter med prompt engineering og øk produktiviteten din.

En metaprompt innen kunstig intelligens er en høynivå-instruksjon utformet for å generere eller forbedre andre prompt for store språkmodeller (LLMs), som forbed...

Prompt engineering er praksisen med å designe og forbedre inndata for generative AI-modeller for å produsere optimale resultater. Dette innebærer å lage presise...

Bli ekspert på promptskriving i Stable Diffusion-modeller for å lage AI-genererte bilder av høy kvalitet. Lær hvordan du lager effektive prompts med nøkkelxadel...