OpenAI O3 Mini vs DeepSeek for agentisk bruk

Sammenlign OpenAI O3 Mini og DeepSeek på resonnering, sjakkstrategioppgaver og agentisk verktøybruk. Se hvilken AI som utmerker seg i nøyaktighet, prisgunstighe...

OpenAI O1 utnytter forsterkningslæring og innebygd chain of thought-resonnering for å overgå GPT4o i komplekse RAG-oppgaver, men til en høyere kostnad.

OpenAI har nettopp lansert en ny modell kalt OpenAI O1 fra O1-serien av modeller. Den viktigste arkitektoniske endringen i disse modellene er evnen til å tenke før den svarer på en brukers spørsmål. I dette blogginnlegget går vi i dybden på de viktigste endringene i OpenAI O1, de nye paradigmer disse modellene bruker, og hvordan denne modellen kan øke RAG-nøyaktigheten betydelig. Vi sammenligner en enkel RAG-flow med OpenAI GPT4o og OpenAI O1-modellen.

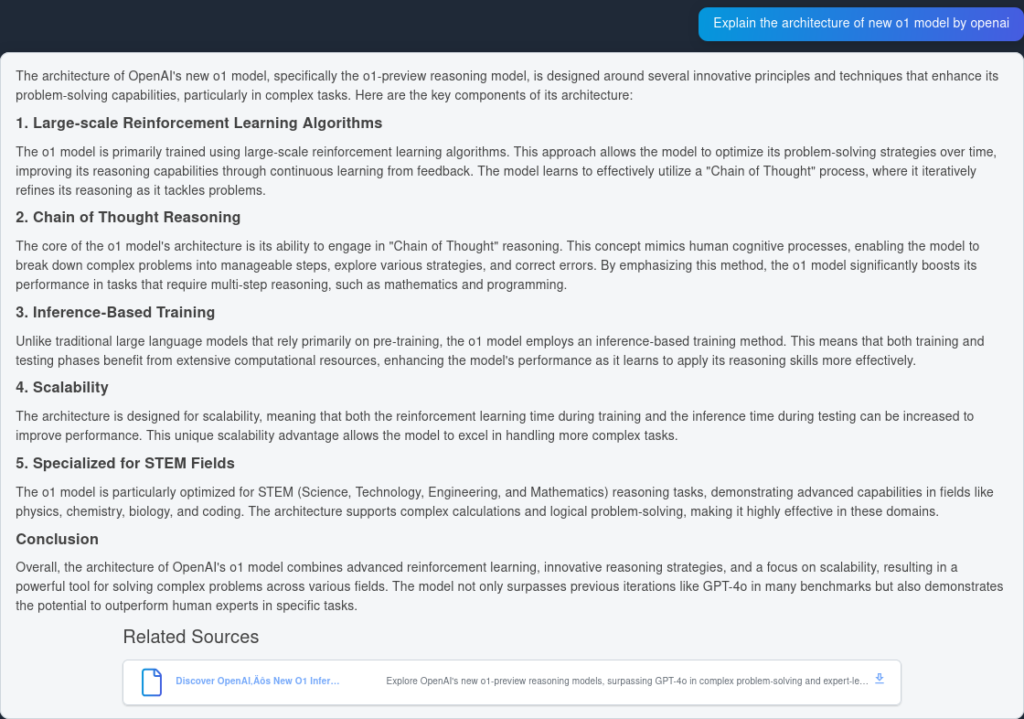

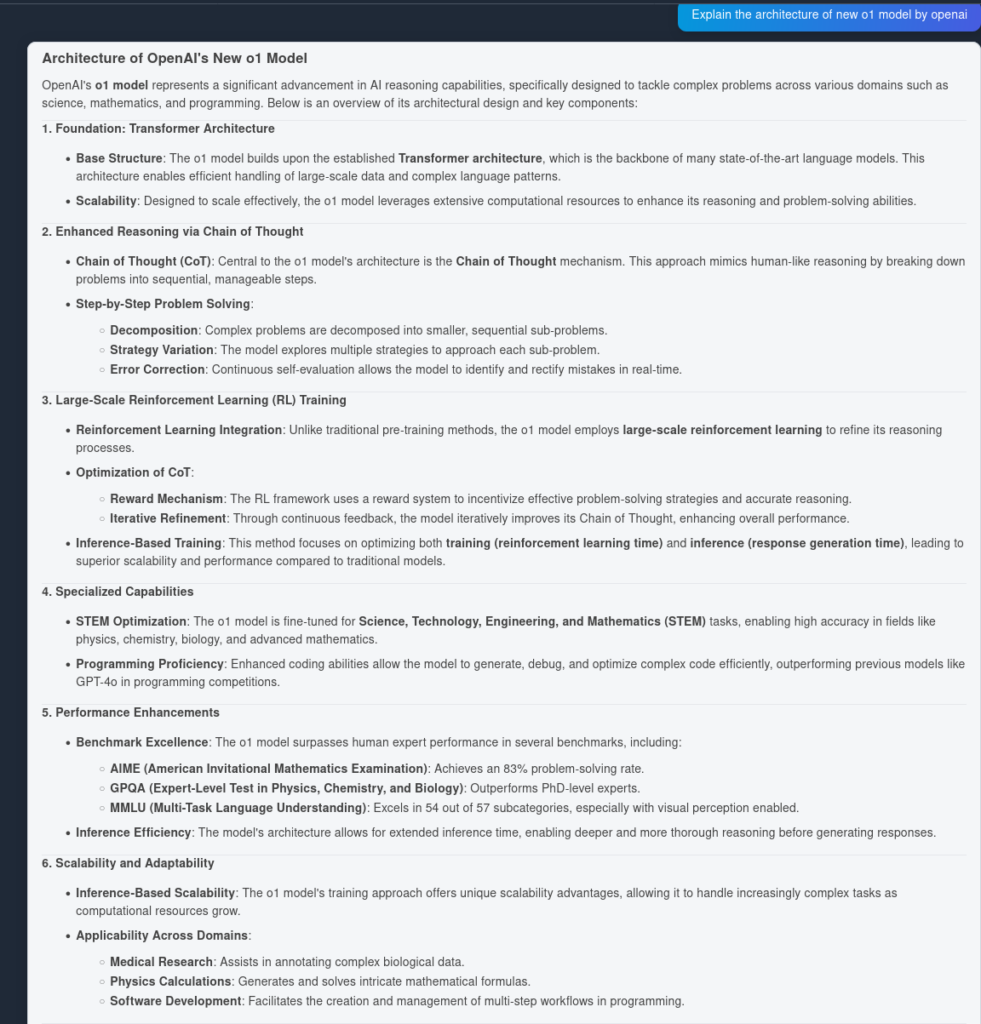

O1-modellen benytter storskala forsterkningslæringsalgoritmer under treningsprosessen. Dette gjør at modellen kan utvikle en robust “Chain of Thought”, som gjør det mulig å tenke dypere og mer strategisk rundt problemer. Ved kontinuerlig å optimalisere sine resonneringsveier gjennom forsterkningslæring, forbedrer O1-modellen evnen til å analysere og løse komplekse oppgaver effektivt.

Tidligere har chain of thought vist seg å være en nyttig prompt engineering-mekanisme for å få LLM-er til å “tenke” selv og svare på komplekse spørsmål med en trinnvis plan. Med O1-modeller kommer dette ut av boksen og er integrert direkte i modellen ved inferens, noe som gjør det nyttig for problemløsning innen matematikk og koding.

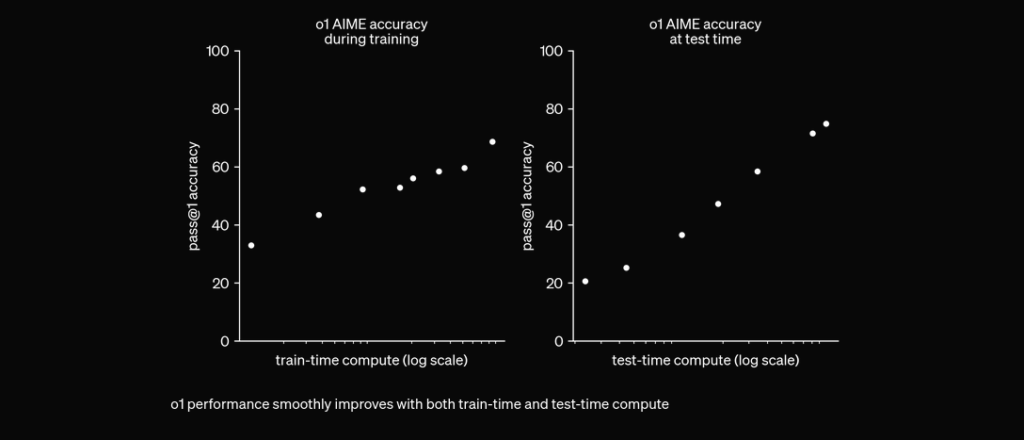

O1 er trent med RL for å “tenke” før den svarer via en privat chain of thought. Jo lenger den tenker, jo bedre gjør den det på resonneringsoppgaver. Dette åpner et nytt skaleringsnivå. Vi er ikke lenger begrenset av pretrening. Nå kan vi skalere inferensberegninger også. pic.twitter.com/niqRO9hhg1

— Noam Brown (@polynoamial) 12. september 2024

I omfattende evalueringer har O1-modellen vist bemerkelsesverdig ytelse på ulike benchmarks:

For å teste ytelsesnøyaktigheten til OpenAI O1 og GPT4o laget vi to identiske flows, men med to forskjellige LLM-er. Vi sammenligner modellenes spørsmålsbesvarende evner på to kilder indeksert ut fra den tekniske rapporten til OpenAI O1.

Først lager vi en enkel RAG-flow i FlowHunt. Den består av Chat Input, Document Retriever (henter relevante dokumenter), Prompt, Generator og Chat Output. LLM OpenAI-komponent er lagt til for å spesifisere modellen (ellers brukes GPT4o som standard).

Her er svaret fra GPT4o:

Og her er resultatet fra OpenAI O1:

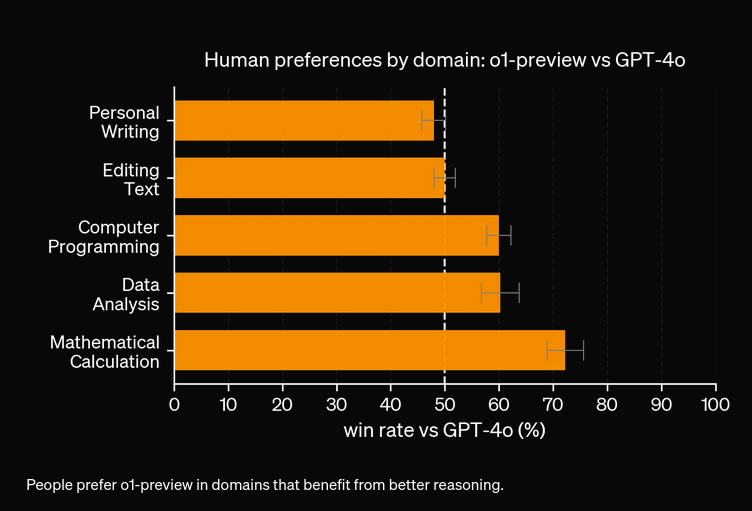

Som du ser, fanget OpenAI O1 opp flere arkitektoniske fordeler fra artikkelen selv—6 punkter mot 4. I tillegg trekker O1 logiske implikasjoner fra hvert punkt, og beriker dokumentet med flere innsikter om hvorfor den arkitektoniske endringen er nyttig.

Fra våre eksperimenter vil O1-modellen koste mer for økt nøyaktighet. Den nye modellen har 3 typer tokens: Prompt Token, Completion Token og Reason Token (en nylig lagt til type token), noe som potensielt gjør den dyrere. I de fleste tilfeller gir OpenAI O1 svar som virker mer nyttige dersom de er basert på sannhet. Likevel finnes det situasjoner der GPT4o overgår OpenAI O1—noen oppgaver trenger rett og slett ikke resonnering.

OpenAI O1 bruker storskala forsterkningslæring og integrerer chain of thought-resonnering under inferens, noe som muliggjør dypere og mer strategisk problemløsning enn GPT4o.

Ja, O1 oppnår høyere score i benchmark-tester som AIME (83 % mot GPT4os 13 %), GPQA (overgår eksperter på PhD-nivå) og MMLU, og utmerker seg i 54 av 57 kategorier.

Ikke alltid. Selv om O1 utmerker seg i oppgaver som krever mye resonnering, kan GPT4o være bedre i enklere brukstilfeller som ikke krever avansert resonnering.

O1 introduserer en ny 'Reason'-token i tillegg til Prompt- og Completion-tokens, som muliggjør mer sofistikert resonnering men potensielt øker driftskostnaden.

Du kan bruke plattformer som FlowHunt til å bygge RAG-flows og AI-agenter med OpenAI O1 for oppgaver som krever avansert resonnering og nøyaktig dokumenthenting.

Yasha er en dyktig programvareutvikler som spesialiserer seg på Python, Java og maskinlæring. Yasha skriver tekniske artikler om AI, prompt engineering og utvikling av chatboter.

Prøv FlowHunt for å utnytte de nyeste LLM-ene som OpenAI O1 og GPT4o for overlegen resonnering og retrieval-augmented generation.

Sammenlign OpenAI O3 Mini og DeepSeek på resonnering, sjakkstrategioppgaver og agentisk verktøybruk. Se hvilken AI som utmerker seg i nøyaktighet, prisgunstighe...

Spørsmål og svar med Retrieval-Augmented Generation (RAG) kombinerer informasjonsinnhenting og naturlig språk-generering for å forbedre store språkmodeller (LLM...

Er OpenAI O3 Mini det rette AI-verktøyet for deg? Vi satte den på prøve med innholdsgenerering, beregninger og mer. Se hvordan denne modellen balanserer ytelse ...