Enterprise-priser

FlowHunt Enterprise-priser – Lokal installasjon av AI Automatiseringsplattform i ditt eget datasenter eller private sky.

KPMG sin AI Risk and Controls Guide gir organisasjoner en strukturert og etisk tilnærming til å håndtere AI-risiko, og støtter ansvarlig implementering og etterlevelse av globale standarder.

Denne første statistikken kan være fra i fjor, men den kunne ikke vært mer relevant i dag. Ifølge KPMG’s 2024 U.S. CEO Outlook identifiserte hele 68 % av administrerende direktører AI som en topp prioritet for investeringer. De satser på at AI skal øke effektiviteten, heve kompetansen i arbeidsstyrken og drive innovasjon i hele organisasjonen.

Det er en stor tillitserklæring til AI — men det reiser også et viktig spørsmål: Når så mye står på spill, hvordan sikrer organisasjoner at de bruker AI på en ansvarlig og etisk måte?

Det er her KPMG sin AI Risk and Controls Guide kommer inn. Den gir et klart, praktisk rammeverk som hjelper virksomheter med å utnytte AI sitt potensial samtidig som de håndterer de reelle risikoene teknologien bringer med seg. I dagens landskap er det å bygge pålitelig AI ikke bare god praksis — det er en forretningsmessig nødvendighet.

Kunstig intelligens (AI) revolusjonerer bransjer og åpner for nye nivåer av effektivitet, innovasjon og konkurransekraft. Men med denne transformasjonen følger et eget sett med risikoer og etiske utfordringer som organisasjoner må håndtere nøye for å opprettholde tillit og sikre ansvarlig bruk. KPMG sin AI Risk and Controls Guide er utviklet for å støtte organisasjoner i å navigere i disse kompleksitetene, og gir en praktisk, strukturert og verdibasert tilnærming til AI-styring.

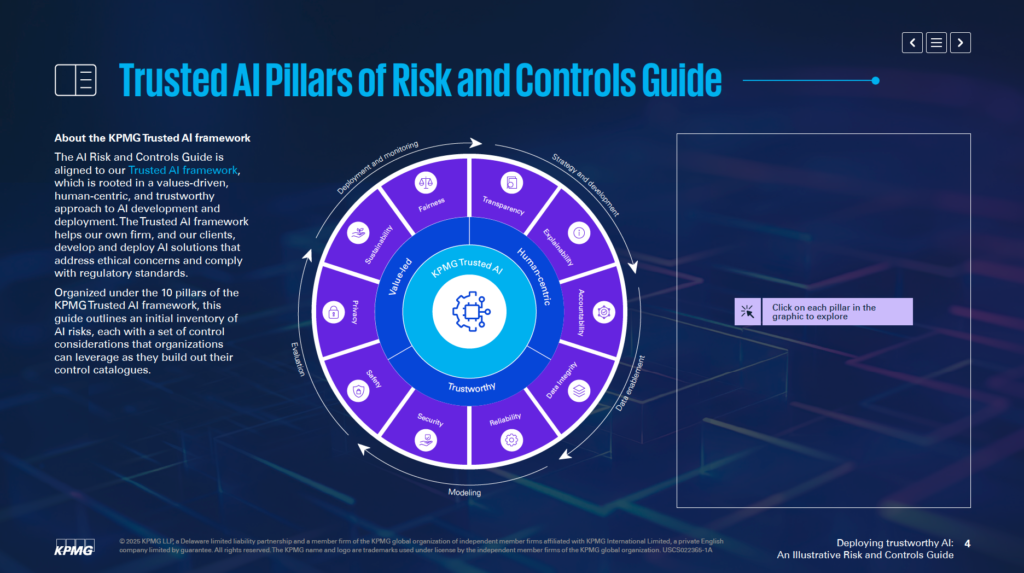

I tråd med KPMG sitt Trusted AI Framework hjelper denne veiledningen virksomheter med å utvikle og implementere AI-løsninger som er etiske, menneskesentrerte og i samsvar med globale regulatoriske standarder. Den er organisert rundt 10 grunnpilarer, som hver tar for seg et kritisk aspekt ved AI-risikostyring:

Ved å fokusere på disse pilarene kan organisasjoner integrere etiske prinsipper i alle faser av AI-livssyklusen—fra strategi og utvikling til iverksetting og overvåkning. Denne veiledningen styrker ikke bare risikoresiliens, men fremmer også innovasjon som er bærekraftig, pålitelig og i tråd med samfunnets forventninger.

Enten du er risikofaglig, leder, data scientist eller juridisk rådgiver, gir denne veiledningen viktige verktøy og innsikt som hjelper deg å utnytte AI på en ansvarlig måte.

KPMG sin AI Risk and Controls Guide fungerer som en spesialisert ressurs for å hjelpe organisasjoner med å håndtere de spesifikke risikoene forbundet med kunstig intelligens (AI). Den anerkjenner at AI gir store muligheter, men at kompleksiteten og de etiske problemstillingene krever en målrettet tilnærming til risikostyring. Veiledningen gir et strukturert rammeverk for å møte disse utfordringene på en ansvarlig og effektiv måte.

Veiledningen er ikke ment å erstatte dagens systemer, men er utviklet for å utfylle eksisterende prosesser for risikostyring. Hovedmålet er å inkludere AI-spesifikke hensyn i organisasjonens styringsstrukturer, slik at det blir sømløs tilpasning til nåværende operasjonelle praksis. Denne tilnærmingen gjør at organisasjoner kan styrke sin risikostyring uten å måtte redesigne hele rammeverket.

Veiledningen bygger på KPMG sitt Trusted AI-rammeverk, som fremmer en verdibasert og menneskesentrert tilnærming til AI. Den integrerer prinsipper fra anerkjente standarder, inkludert ISO 42001, NIST AI Risk Management Framework og EUs AI Act. Dette sikrer at veiledningen både er praktisk og i samsvar med globalt anerkjente beste praksiser og regulatoriske krav for AI-styring.

Veiledningen gir praktiske innsikter og eksempler som er tilpasset håndtering av AI-relaterte risikoer. Den oppfordrer organisasjoner til å tilpasse eksemplene til sine egne forhold, med hensyn til om AI-systemene utvikles internt eller av leverandører, samt hvilken type data og teknikker som brukes. Denne tilpasningsevnen gjør veiledningen relevant for ulike bransjer og AI-applikasjoner.

Veiledningen legger vekt på å gjøre det mulig for organisasjoner å ta i bruk AI-teknologi på en trygg, etisk og gjennomsiktig måte. Ved å adressere de tekniske, operasjonelle og etiske aspektene ved AI-risiko, hjelper den organisasjoner med å bygge tillit blant interessenter samtidig som de utnytter AI sin transformerende kraft.

Veiledningen fungerer som en ressurs for å sikre at AI-systemene er i tråd med forretningsmålene samtidig som potensielle risikoer reduseres. Den støtter innovasjon på en måte som prioriterer ansvarlighet og ansvar.

KPMG sin AI Governance Guide er utviklet for fagfolk som styrer AI-implementering og sørger for at den brukes trygt, etisk og effektivt. Den gjelder for team på tvers av flere områder i organisasjoner, inkludert:

Ledere på toppnivå, som CEO, CIO og CTO, vil finne denne veiledningen nyttig for å styre AI som et strategisk satsningsområde. Ifølge KPMG’s 2024 US CEO Outlook anser 68 % av administrerende direktører AI som et nøkkelområde for investeringer. Veiledningen gjør det mulig for ledelsen å tilpasse AI-strategier med organisasjonens mål, samtidig som de håndterer tilhørende risiko.

Programvareutviklere, data scientists og andre som har ansvar for å lage og implementere AI-løsninger, kan bruke veiledningen for å integrere etiske prinsipper og robuste kontroller direkte i systemene. Den fokuserer på å tilpasse risikostyringspraksis til den spesifikke arkitekturen og datatilstrømmene i AI-modellene.

Veiledningen kan tilpasses både bedrifter som utvikler AI-systemer internt, kjøper dem fra leverandører eller bruker proprietære datasett. Den er spesielt relevant for bransjer som finans, helse og teknologi, hvor avanserte AI-applikasjoner og sensitiv data er avgjørende for driften.

Å implementere AI uten et klart styringsrammeverk kan føre til økonomiske, regulatoriske og omdømmemessige risikoer. KPMG-veiledningen fungerer sammen med eksisterende prosesser og gir en strukturert, etisk tilnærming til AI-håndtering. Den fremmer ansvarlighet, åpenhet og etisk praksis, og hjelper organisasjoner å bruke AI ansvarlig mens de frigjør potensialet.

Organisasjoner bør starte med å knytte AI-spesifikke risikoer til sin nåværende risikotaksonomi. En risikotaksonomi er et strukturert rammeverk som brukes til å identifisere, organisere og håndtere potensielle sårbarheter. Fordi AI introduserer egne utfordringer, må tradisjonelle taksonomier utvides til å inkludere AI-spesifikke faktorer. Dette kan for eksempel være nøyaktigheten på datatilstrømningene, logikken bak algoritmer og påliteligheten til datakildene. Slik blir AI-risiko en del av organisasjonens overordnede risikostyring, i stedet for å behandles separat.

Veiledningen påpeker viktigheten av å vurdere hele livssyklusen til AI-systemer. Viktige områder å undersøke er hvor data kommer fra, hvordan de flyttes gjennom prosesser, og den grunnleggende logikken i AI-modellen. Dette brede perspektivet hjelper deg å identifisere hvor sårbarheter kan oppstå under utvikling og bruk av AI.

AI-systemer varierer ut fra hensikt, utviklingsmetode og typen data de bruker. Om en modell er bygget internt eller kjøpt eksternt påvirker risikoen betydelig. Likeledes krever datatypen—enten den er proprietær, offentlig eller sensitiv—og teknikkene som brukes for å bygge AI, tilpassede risikostyringsstrategier.

Veiledningen foreslår å tilpasse kontrolltiltak til de spesifikke behovene for dine AI-systemer. For eksempel, hvis du baserer deg på proprietære data, kan det være nødvendig med strengere tilgangskontroller. Om du bruker et AI-system fra en leverandør, bør du gjennomføre grundige tredjepartsrisikovurderinger. Ved å tilpasse kontrollene kan du møte de spesifikke utfordringene for dine AI-systemer mer effektivt.

Veiledningen anbefaler å implementere risikostyringspraksiser i alle stadier av AI-livssyklusen. Dette innebærer å planlegge for risiko allerede i designfasen, sette opp solide overvåkningssystemer under implementering, og jevnlig oppdatere risikovurderinger etter hvert som AI-systemet utvikler seg. Ved å håndtere risiko i hvert trinn kan du redusere sårbarheter og sikre at AI-systemene dine er både etiske og pålitelige.

Å ta det første steget med å tilpasse AI-risiko til virksomhetens eksisterende risikotaksonomi, og tilpasse kontroller til egne behov, gir et solid fundament for tillitsskapende AI. Disse tiltakene gjør det mulig for organisasjoner å systematisk identifisere, vurdere og håndtere risiko, og bygge et sterkt rammeverk for AI-styring.

KPMG sitt Trusted AI Framework bygger på ti sentrale pilarer som adresserer de etiske, tekniske og operasjonelle utfordringene ved kunstig intelligens. Disse pilarene veileder organisasjoner i å designe, utvikle og ta i bruk AI-systemer på en ansvarlig måte, og sikrer tillit og ansvarlighet gjennom hele AI-livssyklusen.

Menneskelig tilsyn og ansvar bør være til stede i alle stadier av AI-livssyklusen. Dette betyr å definere hvem som har ansvar for å håndtere AI-risiko, sikre etterlevelse av lover og regler, samt opprettholde muligheten til å gripe inn, overstyre eller reversere AI-beslutninger ved behov.

AI-systemer bør redusere eller eliminere skjevhet som kan påvirke enkeltpersoner, lokalsamfunn eller grupper negativt. Dette innebærer å nøye gjennomgå data for å sikre at de representerer ulike befolkningsgrupper, bruke rettferdighetstiltak under utviklingen og kontinuerlig overvåke resultater for å fremme likebehandling.

Åpenhet krever åpent å dele hvordan AI-systemer fungerer og hvorfor de treffer bestemte beslutninger. Dette inkluderer dokumentasjon av systembegrensninger, ytelsesresultater og testmetoder. Brukere skal informeres når deres data samles inn, AI-generert innhold skal være tydelig merket, og sensitive applikasjoner som biometrisk kategorisering må gi klare varsler til brukeren.

AI-systemer må kunne gi forståelige grunner til sine beslutninger. For å oppnå dette bør organisasjoner dokumentere datasett, algoritmer og ytelsesmålinger i detalj, slik at interessenter effektivt kan analysere og reprodusere resultater.

Kvaliteten og påliteligheten til data gjennom hele livssyklusen—innsamling, merking, lagring og analyse—er avgjørende. Kontroller bør være på plass for å håndtere risiko som datakorrupsjon eller skjevhet. Jevnlig sjekk av datakvalitet og regresjonstesting under systemoppdateringer bidrar til å opprettholde nøyaktighet og pålitelighet for AI-systemene.

AI-løsninger må følge personvern- og datavernregler. Organisasjoner må håndtere forespørsler fra registrerte riktig, gjennomføre personvernkonsekvensvurderinger og bruke avanserte metoder som differensielt personvern for å balansere databruk med beskyttelse av enkeltpersoners privatliv.

AI-systemer bør fungere konsekvent i henhold til sitt formål og den nødvendige nøyaktigheten. Dette krever grundig testing, mekanismer for å oppdage avvik og kontinuerlige tilbakemeldingssløyfer for å validere systemutganger.

Trygghetstiltak beskytter AI-systemer mot å forårsake skade på personer, virksomheter eller eiendom. Tiltakene inkluderer å designe feilsikringer, overvåke for problemer som datakorrupsjon eller prompt-injeksjonsangrep, og sikre at systemene er i tråd med etiske og operasjonelle standarder.

Sterke sikkerhetsrutiner er nødvendige for å beskytte AI-systemer mot trusler og ondsinnede aktiviteter. Organisasjoner bør gjennomføre regelmessige revisjoner, utføre sårbarhetsvurderinger og bruke kryptering for å beskytte sensitiv data.

AI-systemer bør utformes for å minimere energibruk og støtte miljømål. Bærekraftshensyn bør inkluderes fra starten av designprosessen, med løpende overvåkning av energiforbruk, effektivitet og utslipp gjennom hele AI-livssyklusen.

Ved å følge disse ti pilarene kan organisasjoner skape AI-systemer som er etiske, pålitelige og i samsvar med samfunnets forventninger. Dette rammeverket gir en klar struktur for å håndtere AI-utfordringer samtidig som det fremmer ansvarlig innovasjon.

Dataintegritet er avgjørende for at AI-systemer skal forbli nøyaktige, rettferdige og pålitelige. Dårlig datastyring kan føre til risiko som skjevhet, unøyaktighet og upålitelige resultater. Disse problemene kan svekke tilliten til AI-resultater og føre til store operasjonelle og omdømmemessige utfordringer. KPMG sitt Trusted AI-rammeverk fremhever behovet for å opprettholde høy datakvalitet gjennom hele livssyklusen for å sikre at AI-systemer fungerer effektivt og møter etiske standarder.

Uten sterk datastyring kan AI-systemer gi feilaktige resultater. Problemer som ufullstendige, unøyaktige eller irrelevante data kan føre til skjeve eller upålitelige utganger, noe som øker risikoen for ulike AI-applikasjoner.

Data flyttes ofte mellom systemer for aktiviteter som trening, testing eller drift. Dersom disse overføringene ikke håndteres riktig, kan data bli ødelagt, tapt eller forringet. Dette kan påvirke hvordan AI-systemer fungerer.

For å forbedre datastyring kan organisasjoner:

For å minimere risiko under dataoverføringer bør organisasjoner:

Bruk av kontinuerlige overvåkningssystemer bidrar til å opprettholde dataintegritet gjennom hele AI-livssyklusen. Disse systemene kan oppdage problemer som uventede endringer i datakvalitet eller inkonsistens i datahåndteringen. Dette gir mulighet for raske korrigerende tiltak når problemer oppstår.

Å opprettholde dataintegritet er avgjørende for å implementere pålitelige AI-systemer. Organisasjoner kan redusere risiko ved å etablere sterke styringsrammer, beskytte datainteraksjoner og opprettholde kontinuerlige valideringsprosesser. Disse tiltakene forbedrer påliteligheten til AI-resultater og sikrer at etiske og operasjonelle standarder overholdes, noe som bidrar til å bygge tillit til AI-teknologi.

Håndtering av forespørsler knyttet til innsynsrett for registrerte er en sentral personvernutfordring i AI. Organisasjoner må sikre at enkeltpersoner kan utøve sine rettigheter til å få tilgang til, korrigere eller slette personopplysninger under lover som GDPR og CCPA. Dersom slike forespørsler ikke håndteres riktig, kan det føre til brudd på regelverk, tap av forbrukertillit og skade på organisasjonens omdømme.

For å redusere denne risikoen bør bedrifter lage programmer for å informere enkeltpersoner om deres datarrettigheter når de samhandler med AI. Systemene må være satt opp for å behandle slike forespørsler raskt og gjennomsiktig. Organisasjoner bør også føre detaljerte logger over hvordan de håndterer disse forespørslene for å dokumentere etterlevelse under revisjoner.

AI-systemer håndterer ofte sensitive personopplysninger, noe som gjør dem attraktive mål for cyberangrep. Hvis et brudd oppstår, kan det føre til betydelige regulatoriske bøter, skade på selskapets omdømme og tap av kundetillit.

For å møte dette anbefaler KPMG sitt Trusted AI-rammeverk å gjennomføre etiske vurderinger for AI-systemer som bruker personopplysninger, for å sikre at de møter personvernregler. Regelmessige revisjoner av databeskyttelse og personvernkonsekvensvurderinger (DPIA) er også nødvendige, spesielt når sensitiv data brukes til å trene AI-modeller. I tillegg kan metoder som differensielt personvern, som tilfører statistisk støy til data, bidra til å anonymisere informasjon samtidig som analyse er mulig.

AI-systemer som ikke inkluderer personvernmekanismer fra starten, kan skape alvorlige problemer. Uten å implementere personvern-ved-design-prinsipper risikerer organisasjoner å utsette sensitiv data eller å ikke oppfylle lovkrav.

Bedrifter bør inkludere personverntiltak i utviklingsfasen av AI-systemer. Dette innebærer å følge personvernlovgivning og datavernregler gjennom sterke datastyringsrutiner. Tydelig dokumentasjon av hvordan data samles inn, brukes og lagres er avgjørende. Organisasjoner må også innhente eksplisitt samtykke fra brukere til innsamling og behandling av data, spesielt i sensitive områder som biometriske data.

Når AI-systemer ikke tydelig forklarer hvordan brukerdata håndteres, kan det føre til mistillit og juridisk granskning. Brukere bør vite når deres data samles inn og hvordan de blir brukt

KPMG sin AI Risk and Controls Guide er et praktisk rammeverk utformet for å hjelpe organisasjoner med å håndtere de unike risikoene ved AI, og sikre ansvarlig, etisk og lovlig implementering av AI på tvers av bransjer.

Veiledningen er bygget på ti sentrale pilarer: Ansvarlighet, Rettferdighet, Åpenhet, Forklarbarhet, Dataintegritet, Pålitelighet, Sikkerhet, Trygghet, Personvern og Bærekraft—hver av disse adresserer kritiske aspekter ved AI-risikostyring.

Veiledningen er ment for risikofagfolk, compliance-team, cybersikkerhetsspesialister, juridiske rådgivere, ledere, AI-utviklere, ingeniører og organisasjoner i alle størrelser som ønsker å håndtere AI på en ansvarlig måte.

Den samsvarer med globale standarder som ISO 42001, NIST AI Risk Management Framework og EUs AI Act, og hjelper organisasjoner med å integrere AI-spesifikke kontroller i eksisterende styringsprosesser og oppfylle regulatoriske krav.

Den foreslår tiltak som sterk datastyring, personvern-ved-design, kontinuerlig overvåkning, åpenhet i AI-beslutninger, avviksdeteksjon, tilbakemeldingssløyfer og bærekraftsmål for å redusere AI-relaterte risikoer.

Oppdag hvordan KPMG sin AI Risk and Controls Guide kan hjelpe din organisasjon med å ta i bruk AI-innovasjon samtidig som dere sikrer etisk, sikker og lovlig implementering.

FlowHunt Enterprise-priser – Lokal installasjon av AI Automatiseringsplattform i ditt eget datasenter eller private sky.

Utforsk hvorfor AI-ledelse er avgjørende for organisasjoners suksess, hvordan sterke ledere driver AI-transformasjon, og hvordan FlowHunt sitt AI Leadership Wor...

AI-adopsjonsrater indikerer prosentandelen av organisasjoner som har innført kunstig intelligens i sine operasjoner. Disse ratene varierer på tvers av bransjer,...