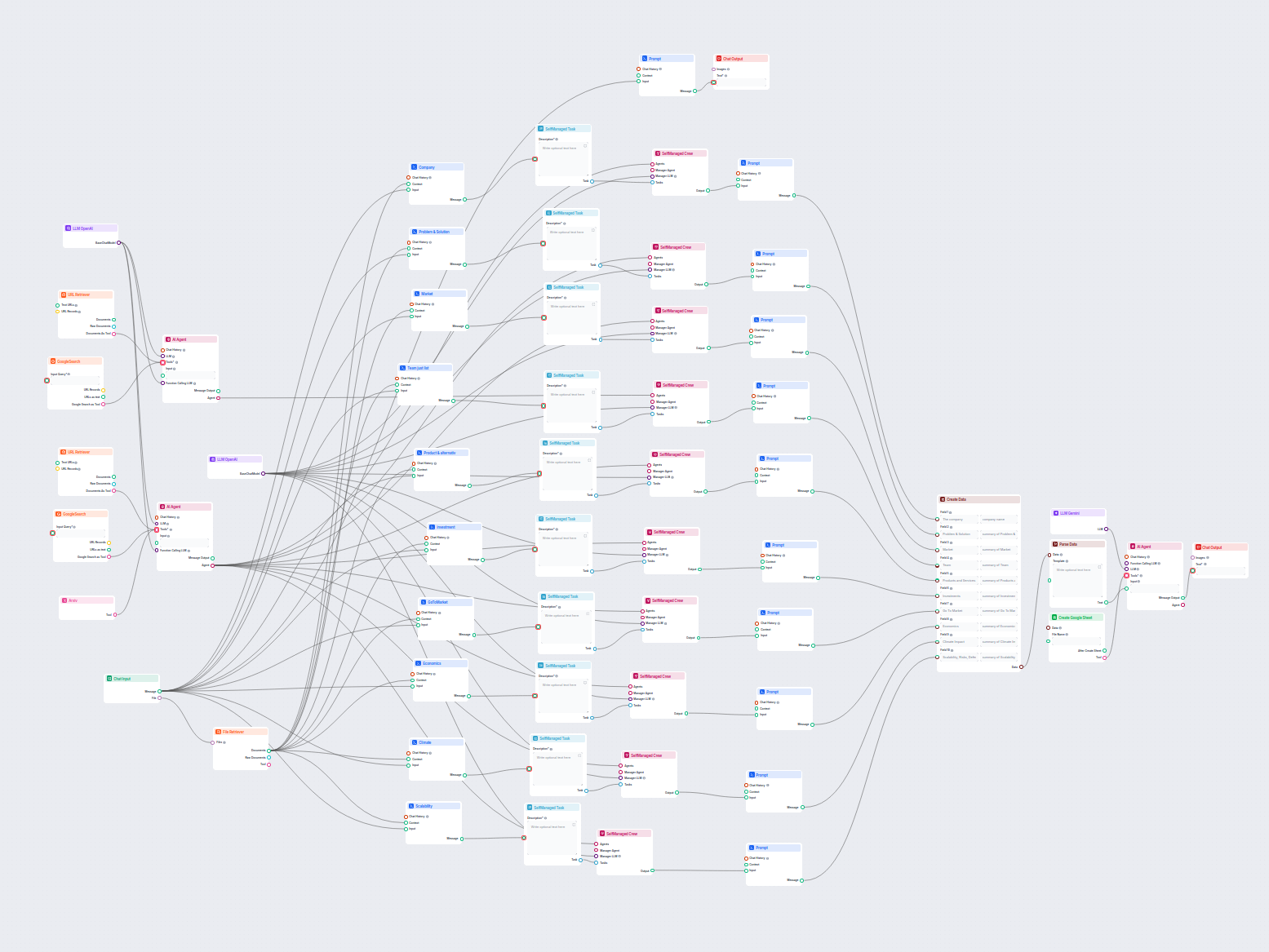

AI-drevet selskapsanalyse og Google Sheets-eksport

Denne AI-arbeidsflyten analyserer ethvert selskap i dybden ved å undersøke offentlige data og dokumenter, og dekker marked, team, produkter, investeringer og me...

Lås opp kraften i Googles Gemini-modeller i FlowHunt—bytt AI-modeller, kontroller innstillinger og bygg smartere AI-chatboter med letthet.

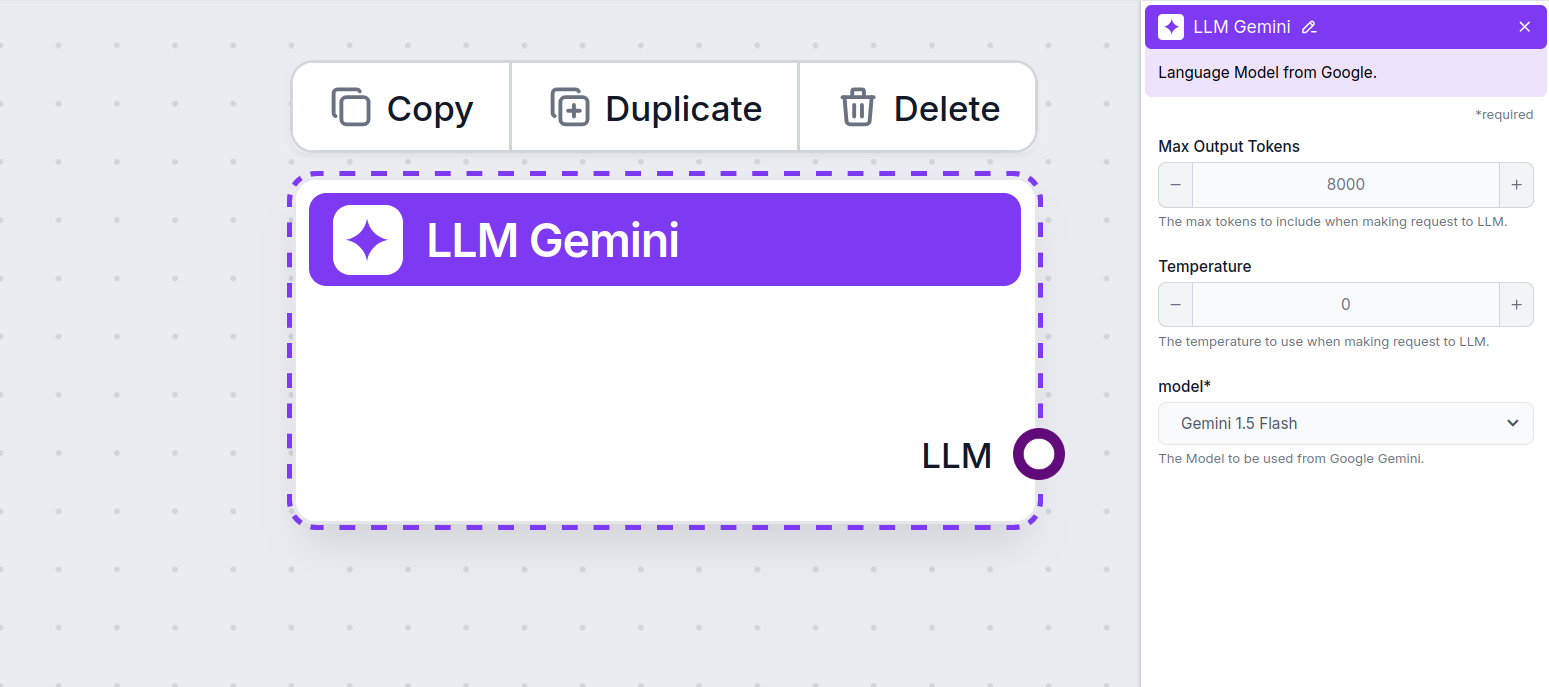

Komponentbeskrivelse

LLM Gemini-komponenten kobler Gemini-modellene fra Google til flowen din. Mens Generatorer og Agenter er der selve magien skjer, lar LLM-komponenter deg kontrollere hvilken modell som brukes. Alle komponenter leveres med ChatGPT-4 som standard. Du kan koble til denne komponenten hvis du ønsker å endre modellen eller få mer kontroll over den.

Husk at det er valgfritt å koble til en LLM-komponent. Alle komponenter som bruker en LLM, leveres med ChatGPT-4o som standard. LLM-komponentene lar deg endre modell og kontrollere modellinnstillinger.

Tokens representerer de individuelle enhetene av tekst som modellen prosesserer og genererer. Token-bruken varierer mellom modeller, og en enkelt token kan være alt fra ord eller delord til ett enkelt tegn. Modellene prises vanligvis i millioner av tokens.

Max tokens-innstillingen begrenser det totale antallet tokens som kan behandles i en enkelt interaksjon eller forespørsel, og sikrer at svarene genereres innenfor rimelige rammer. Standardgrensen er 4 000 tokens, som er den optimale størrelsen for å oppsummere dokumenter og flere kilder for å generere et svar.

Temperature styrer variasjonen i svarene, og varierer fra 0 til 1.

En temperatur på 0,1 gjør svarene svært presise, men potensielt repeterende og mangelfulle.

En høy temperatur på 1 gir maksimal kreativitet i svarene, men øker risikoen for irrelevante eller til og med hallusinatoriske svar.

For eksempel anbefales en temperatur for en kundeservicebot på mellom 0,2 og 0,5. Dette nivået holder svarene relevante og tilpasset manus, samtidig som det gir mulighet for naturlig variasjon.

Dette er modellvelgeren. Her finner du alle støttede Gemini-modeller fra Google. Vi støtter alle de nyeste Gemini-modellene:

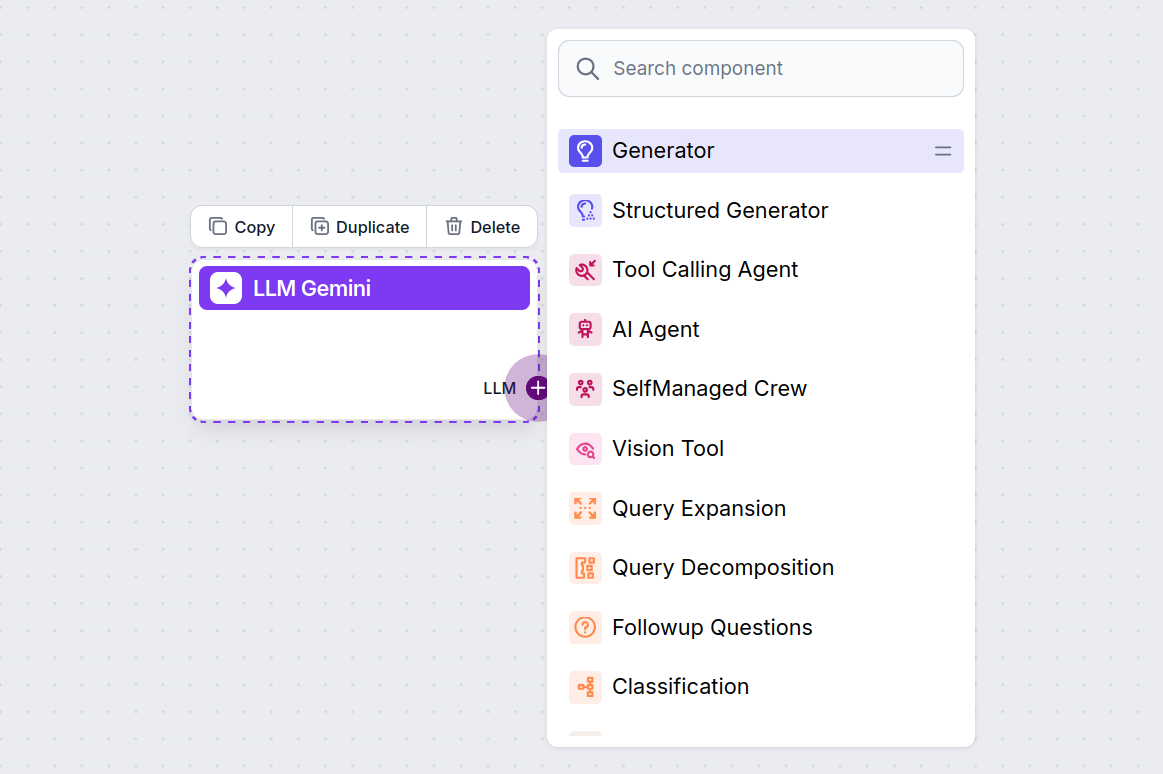

Du vil merke at alle LLM-komponenter bare har et utgangshåndtak. Inndata går ikke gjennom komponenten, da den kun representerer modellen, mens selve genereringen skjer i AI-agenter og generatorer.

LLM-håndtaket er alltid lilla. LLM-inngangshåndtaket finnes på enhver komponent som bruker AI for å generere tekst eller behandle data. Du kan se alternativene ved å klikke på håndtaket:

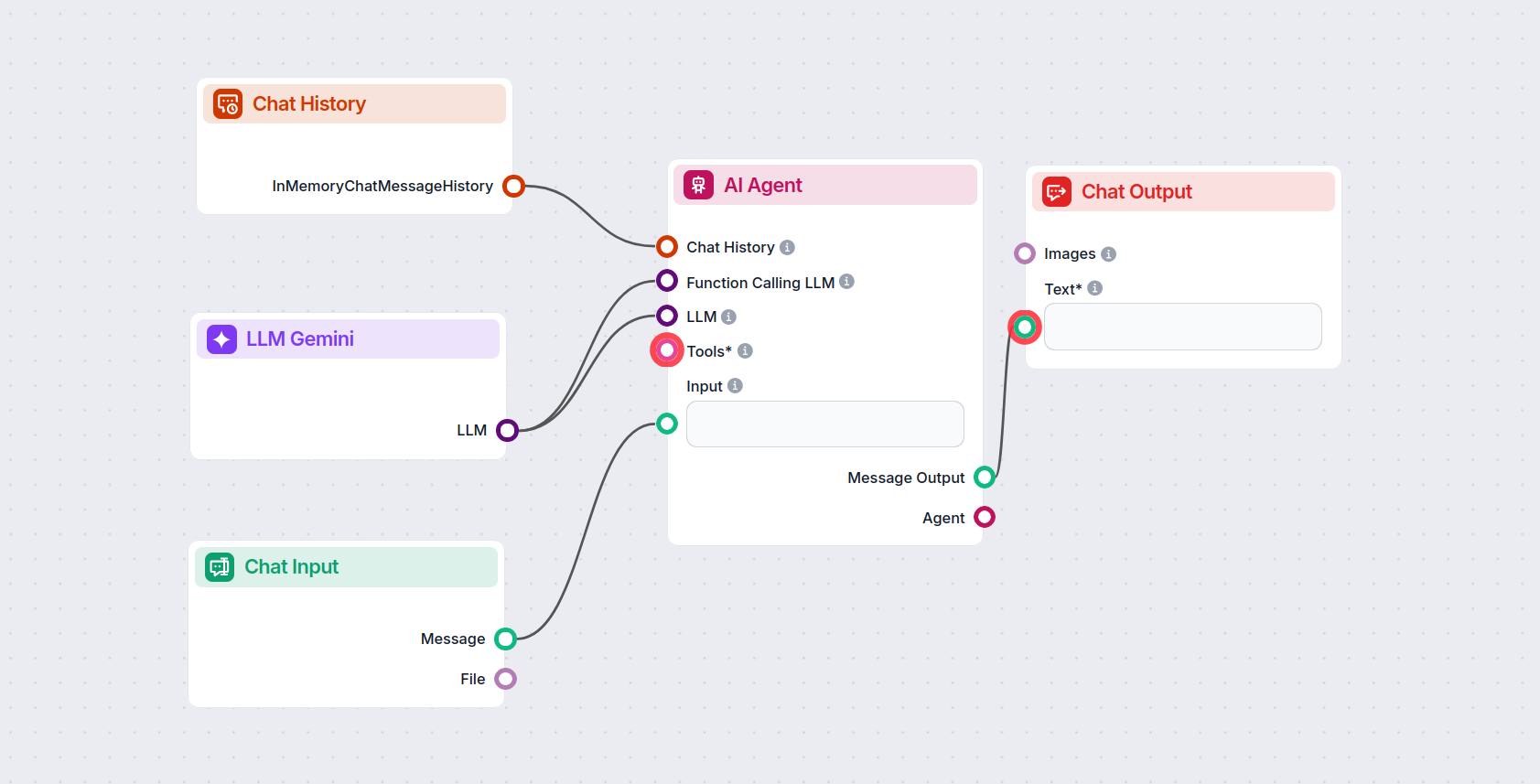

Dette lar deg lage alle slags verktøy. La oss se komponenten i aksjon. Her er en enkel AI Agent chatbot-flow som bruker Gemini 2.0 Flash Experimental for å generere svar. Du kan tenke på det som en grunnleggende Gemini-chatbot.

Denne enkle Chatbot-flowen inkluderer:

For å hjelpe deg med å komme raskt i gang, har vi forberedt flere eksempel-flow-maler som demonstrerer hvordan du bruker LLM Gemini-komponenten effektivt. Disse malene viser forskjellige brukstilfeller og beste praksis, noe som gjør det lettere for deg å forstå og implementere komponenten i dine egne prosjekter.

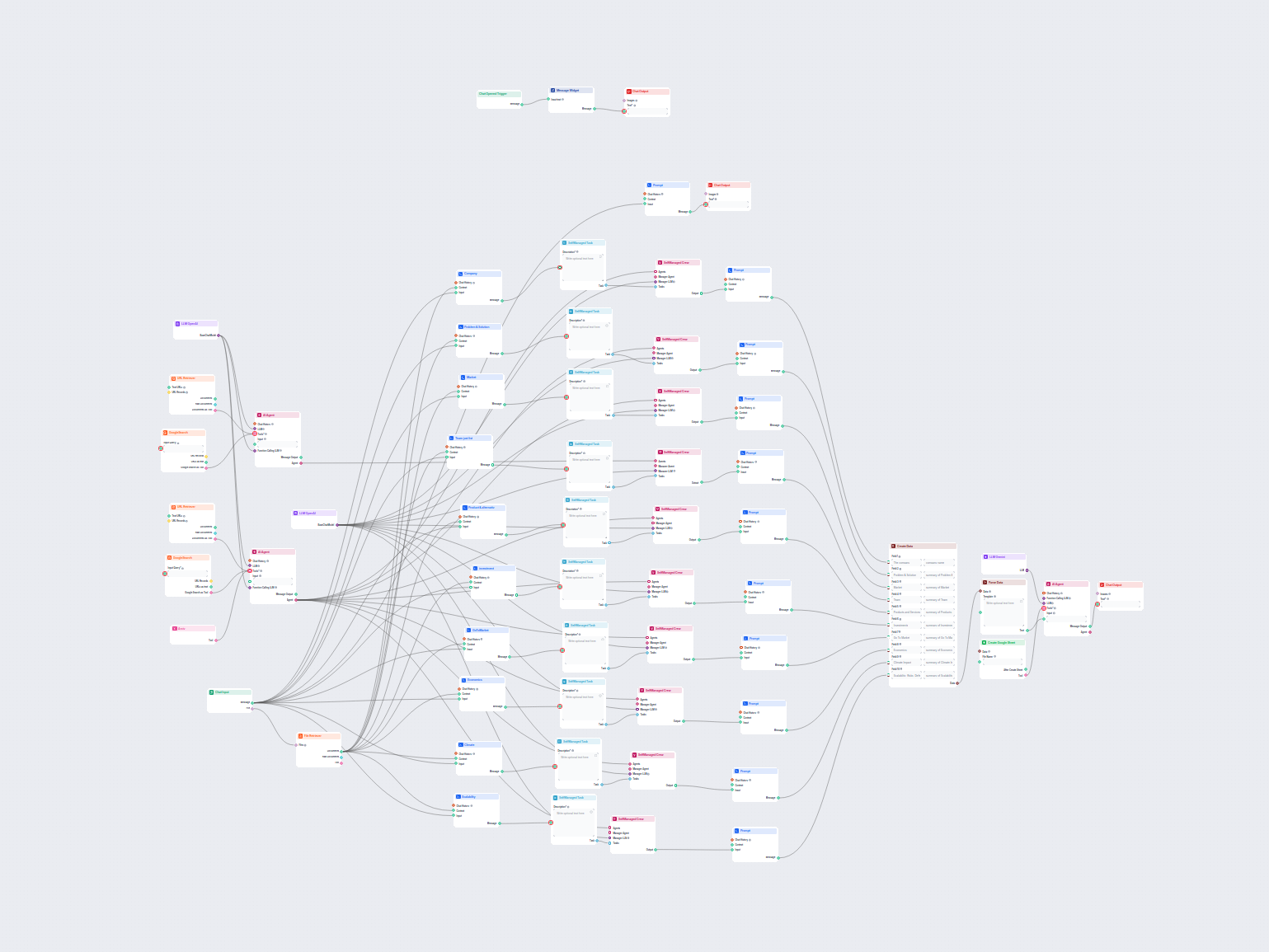

Denne AI-arbeidsflyten analyserer ethvert selskap i dybden ved å undersøke offentlige data og dokumenter, og dekker marked, team, produkter, investeringer og me...

Denne AI-drevne arbeidsflyten gir en omfattende, datadrevet selskapsanalyse. Den samler informasjon om selskapsbakgrunn, marked, team, produkter, investeringer ...

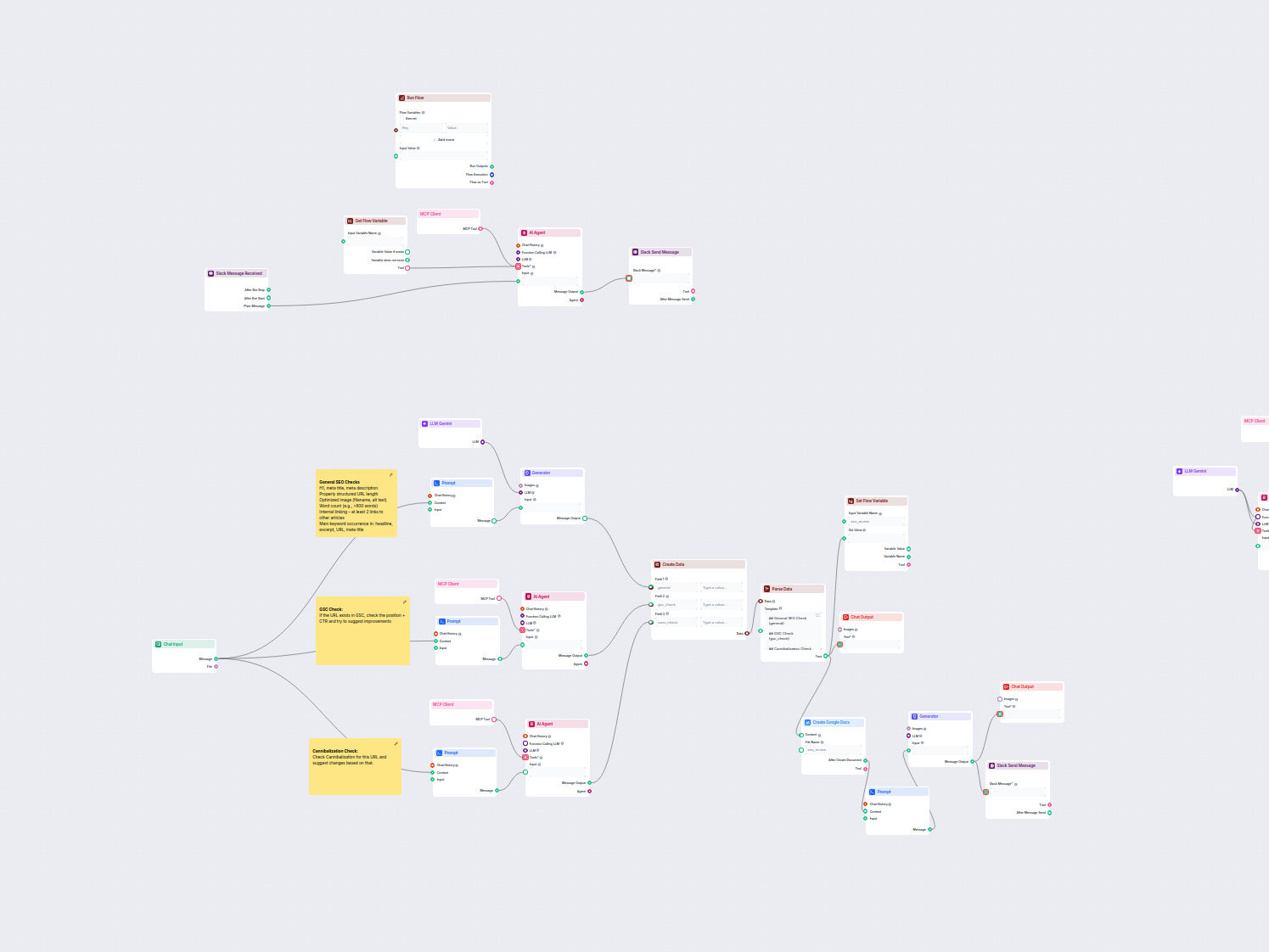

Denne arbeidsflyten automatiserer SEO-gjennomgang og revisjonsprosessen for nettsider. Den analyserer sideinnholdet for SEO-best practices, utfører kontroller i...

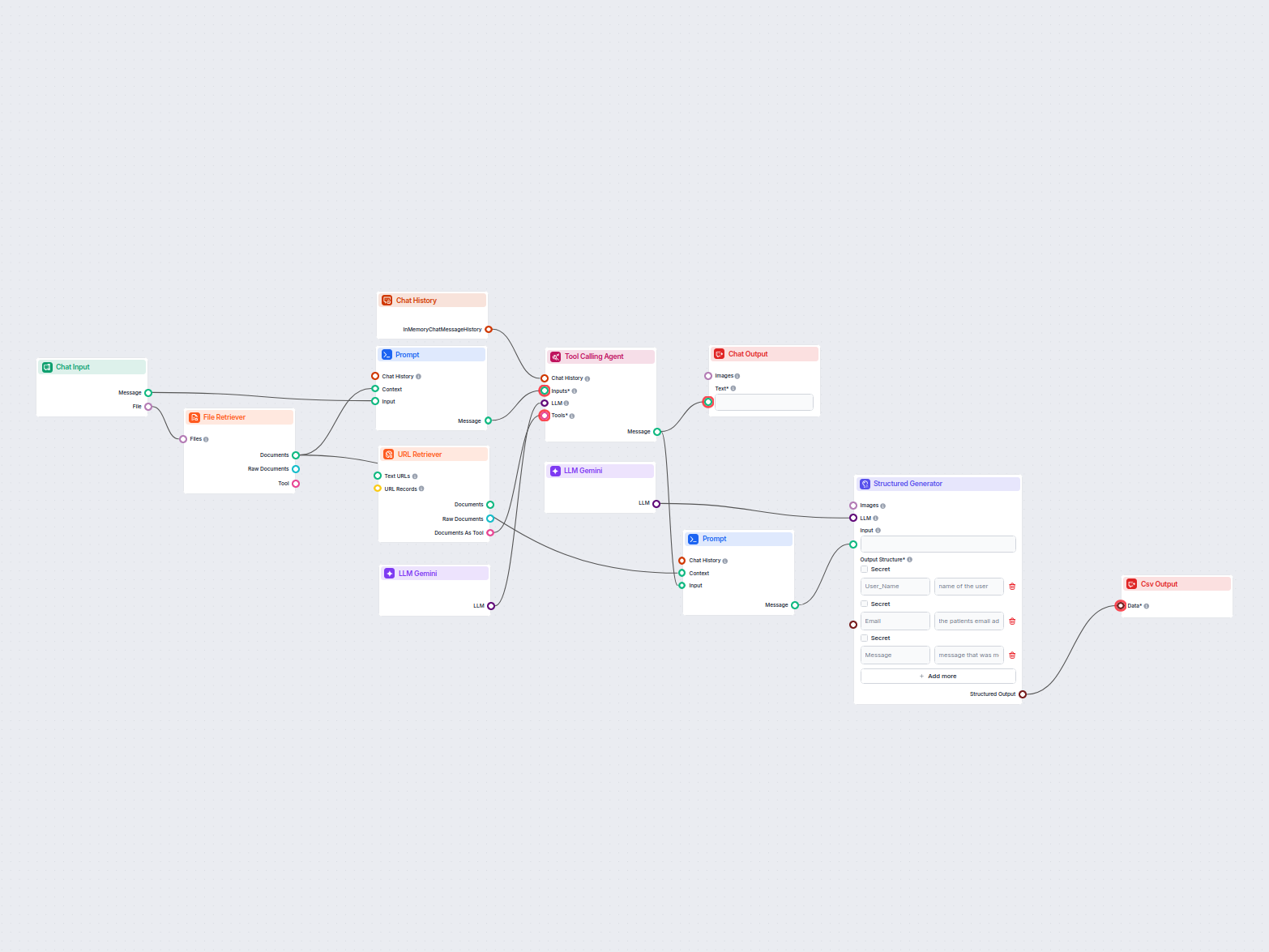

Dette arbeidsflyten trekker ut og organiserer nøkkelinformasjon fra e-poster og vedlagte filer, bruker KI for å prosessere og strukturere dataene, og gir result...

LLM Gemini kobler Googles Gemini-modeller til dine FlowHunt AI-flows, slik at du kan velge blant de nyeste Gemini-variantene for tekstgenerering og tilpasse oppførselen deres.

FlowHunt støtter Gemini 2.0 Flash Experimental, Gemini 1.5 Flash, Gemini 1.5 Flash-8B og Gemini 1.5 Pro—hver tilbyr unike muligheter for tekst-, bilde-, lyd- og videoinndata.

Max Tokens begrenser lengden på svaret, mens Temperature kontrollerer kreativiteten—lavere verdier gir fokuserte svar, høyere verdier gir mer variasjon. Begge kan settes per modell i FlowHunt.

Nei, bruk av LLM-komponenter er valgfritt. Alle AI-flows leveres med ChatGPT-4o som standard, men ved å legge til LLM Gemini kan du bytte til Google-modeller og finjustere innstillingene deres.

Begynn å bygge avanserte AI-chatboter og verktøy med Gemini og andre toppmodeller—alt i ett dashbord. Bytt modeller, tilpass innstillinger og effektiviser arbeidsflyten din.

FlowHunt støtter dusinvis av AI-modeller, inkludert de revolusjonerende DeepSeek-modellene. Her er hvordan du bruker DeepSeek i dine AI-verktøy og chatboter.

FlowHunt støtter dusinvis av AI-tekstmodeller, inkludert modeller fra Mistral. Slik bruker du Mistral i dine AI-verktøy og chatboter.

FlowHunt støtter dusinvis av tekstgenereringsmodeller, inkludert modeller fra xAI. Her er hvordan du bruker xAI-modellene i AI-verktøyene og chatbotene dine.