LLM Meta AI

FlowHunt støtter dusinvis av tekstgenereringsmodeller, inkludert Metas Llama-modeller. Lær hvordan du integrerer Llama i dine AI-verktøy og chatboter, tilpasser...

LLM Mistral på FlowHunt muliggjør fleksibel integrasjon av avanserte Mistral AI-modeller for sømløs tekstgenerering i chatboter og AI-verktøy.

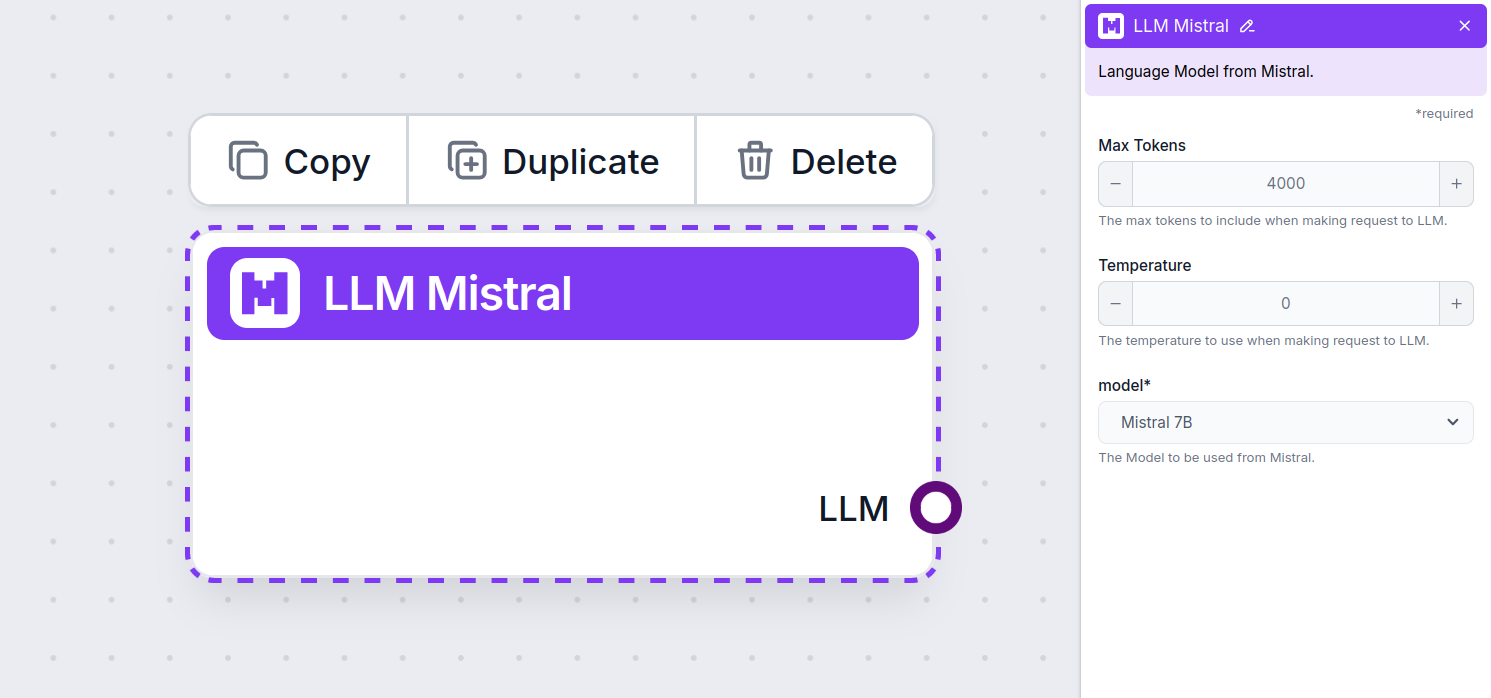

Komponentbeskrivelse

LLM Mistral-komponenten kobler Mistral-modellene til din flow. Mens Generatorer og Agenter er der den faktiske magien skjer, lar LLM-komponenter deg kontrollere hvilken modell som brukes. Alle komponenter kommer med ChatGPT-4 som standard. Du kan koble til denne komponenten hvis du ønsker å endre modellen eller få mer kontroll over den.

Husk at tilkobling av en LLM-komponent er valgfritt. Alle komponenter som bruker en LLM kommer med ChatGPT-4o som standard. LLM-komponentene lar deg bytte modell og kontrollere modellinnstillinger.

Tokens representerer de individuelle enhetene av tekst som modellen prosesserer og genererer. Token-bruk varierer mellom modellene, og en enkelt token kan være alt fra ord eller delord til et enkelt tegn. Modeller prises vanligvis i millioner av tokens.

Innstillingen for maks tokens begrenser det totale antallet tokens som kan behandles i én enkelt interaksjon eller forespørsel, og sikrer at svarene genereres innenfor rimelige rammer. Standardgrensen er 4 000 tokens, som er optimal størrelse for å oppsummere dokumenter og flere kilder til å generere et svar.

Temperatur kontrollerer variasjonen i svarene, og går fra 0 til 1.

En temperatur på 0,1 gjør svarene svært presise, men potensielt repeterende og mangelfulle.

En høy temperatur på 1 tillater maksimal kreativitet i svarene, men øker risikoen for irrelevante eller til og med hallusinerte svar.

For eksempel er anbefalt temperatur for en kundeservicebot mellom 0,2 og 0,5. Dette nivået bør holde svarene relevante og til punktet, samtidig som det gir naturlig variasjon i responsene.

Dette er modellvelgeren. Her finner du alle støttede modeller fra Mistral. Vi støtter for øyeblikket følgende modeller:

Hvordan legge til LLM Mistral i din flow

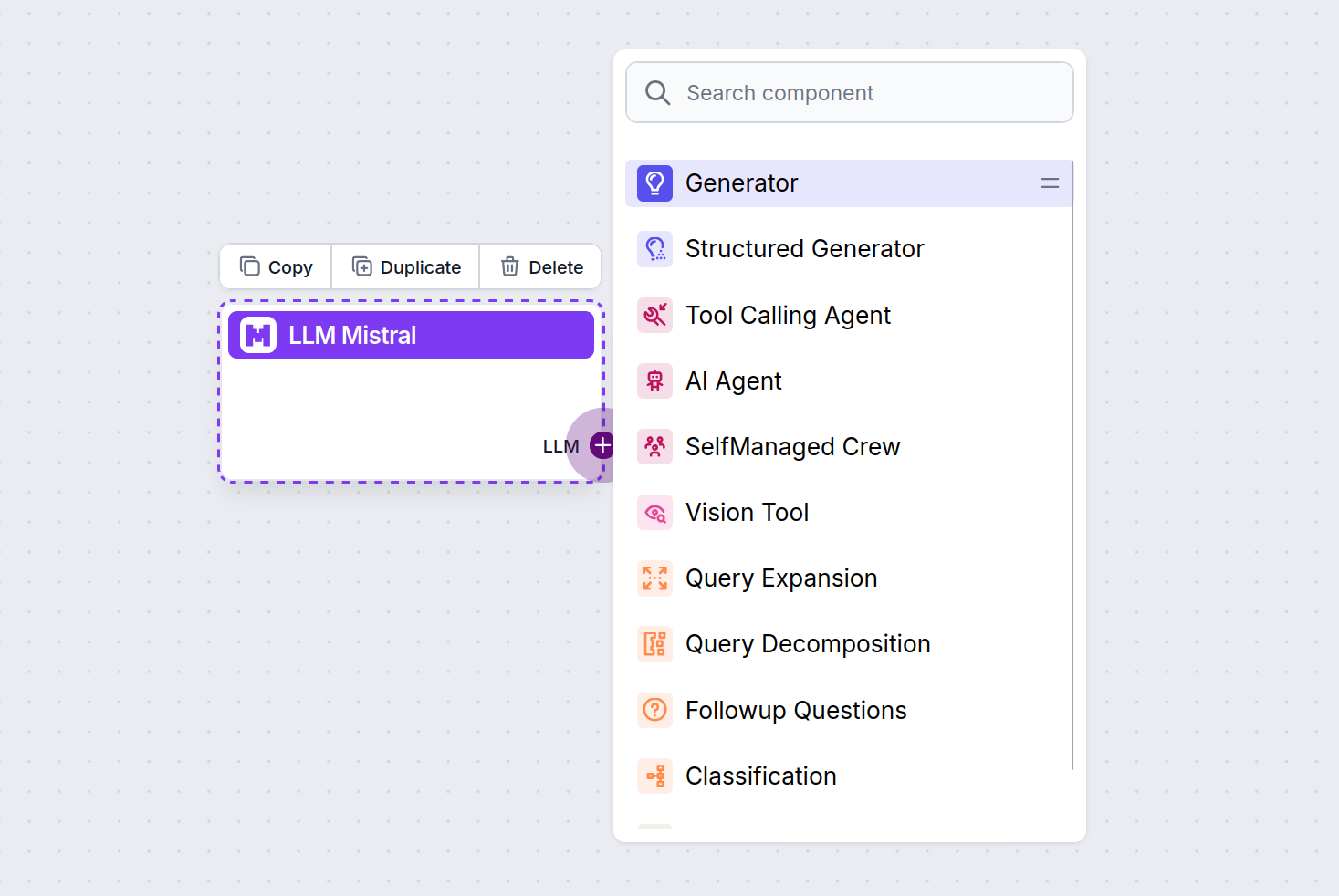

Du vil merke at alle LLM-komponenter kun har et output-håndtak. Input går ikke gjennom komponenten, da den kun representerer modellen, mens selve genereringen skjer i AI-agenter og Generatorer.

LLM-håndtaket er alltid lilla. LLM input-håndtaket finnes på enhver komponent som bruker AI til å generere tekst eller prosessere data. Du kan se alternativene ved å klikke på håndtaket:

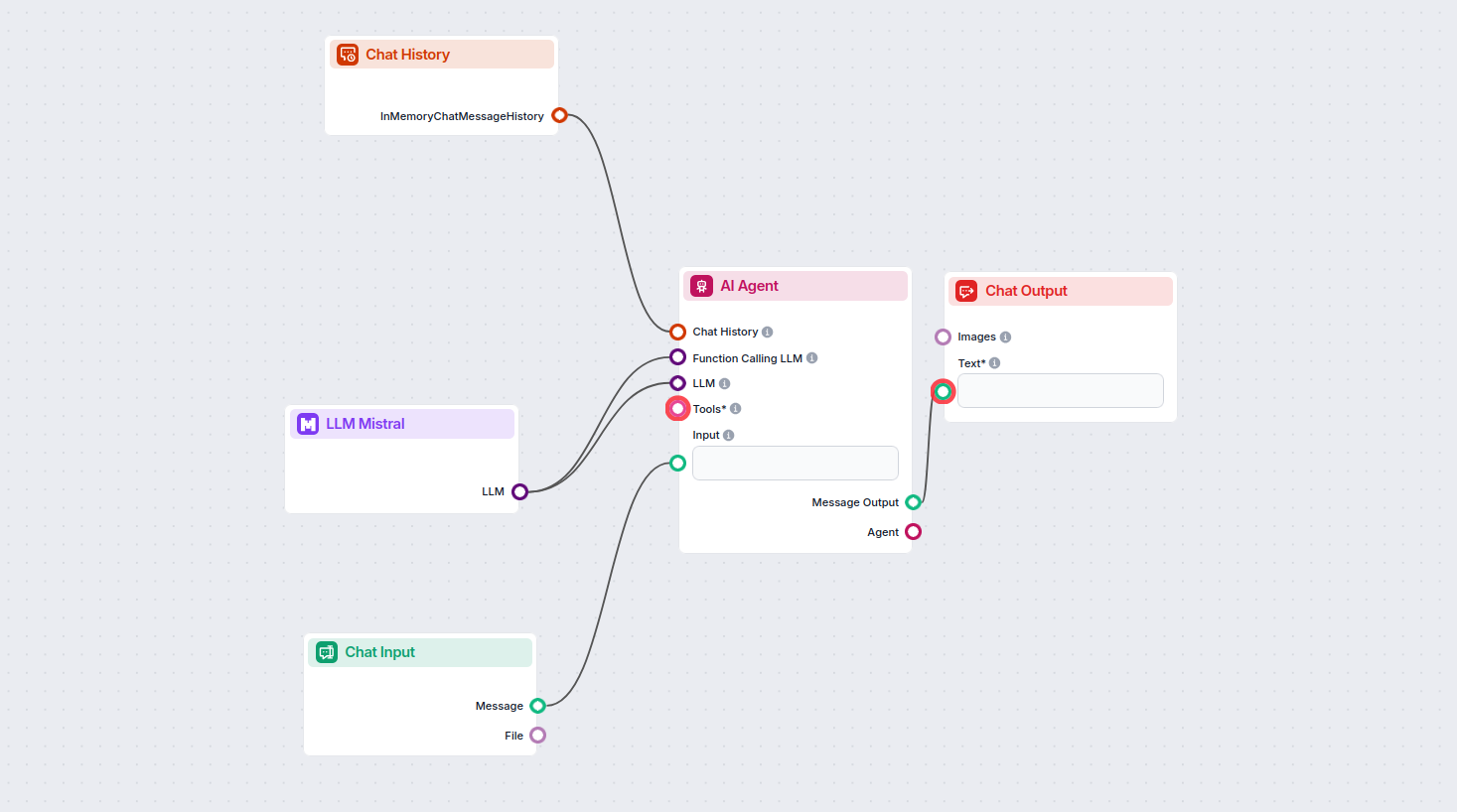

Dette gir deg mulighet til å lage alle slags verktøy. La oss se komponenten i aksjon. Her er en enkel AI Agent Chatbot Flow som bruker Mistral 7B-modellen til å generere svar. Du kan tenke på det som en grunnleggende Mistral-chatbot.

Denne enkle Chatbot Flow inkluderer:

LLM Mistral-komponenten lar deg koble Mistral AI-modeller til dine FlowHunt-prosjekter, og muliggjør avansert tekstgenerering for dine chatboter og AI-agenter. Den lar deg bytte modeller, kontrollere innstillinger og integrere modeller som Mistral 7B, Mixtral (8x7B) og Mistral Large.

FlowHunt støtter Mistral 7B, Mixtral (8x7B) og Mistral Large, som alle tilbyr ulike ytelses- og parameternivåer for forskjellige behov innen tekstgenerering.

Du kan justere innstillinger som maks tokens og temperatur, og velge mellom støttede Mistral-modeller for å kontrollere svarlengde, kreativitet og modellens oppførsel i dine flows.

Nei, tilkobling av en LLM-komponent er valgfritt. Som standard bruker FlowHunt-komponentene ChatGPT-4o. Bruk LLM Mistral-komponenten når du ønsker mer kontroll eller vil bruke en spesifikk Mistral-modell.

Begynn å bygge smartere AI-chatboter og verktøy ved å integrere Mistral’s kraftige språkmodeller med FlowHunt’s plattform uten koding.

FlowHunt støtter dusinvis av tekstgenereringsmodeller, inkludert Metas Llama-modeller. Lær hvordan du integrerer Llama i dine AI-verktøy og chatboter, tilpasser...

FlowHunt støtter dusinvis av tekstgenereringsmodeller, inkludert modeller fra xAI. Her er hvordan du bruker xAI-modellene i AI-verktøyene og chatbotene dine.

FlowHunt støtter dusinvis av AI-modeller, inkludert de revolusjonerende DeepSeek-modellene. Her er hvordan du bruker DeepSeek i dine AI-verktøy og chatboter.