Neurale nettverk

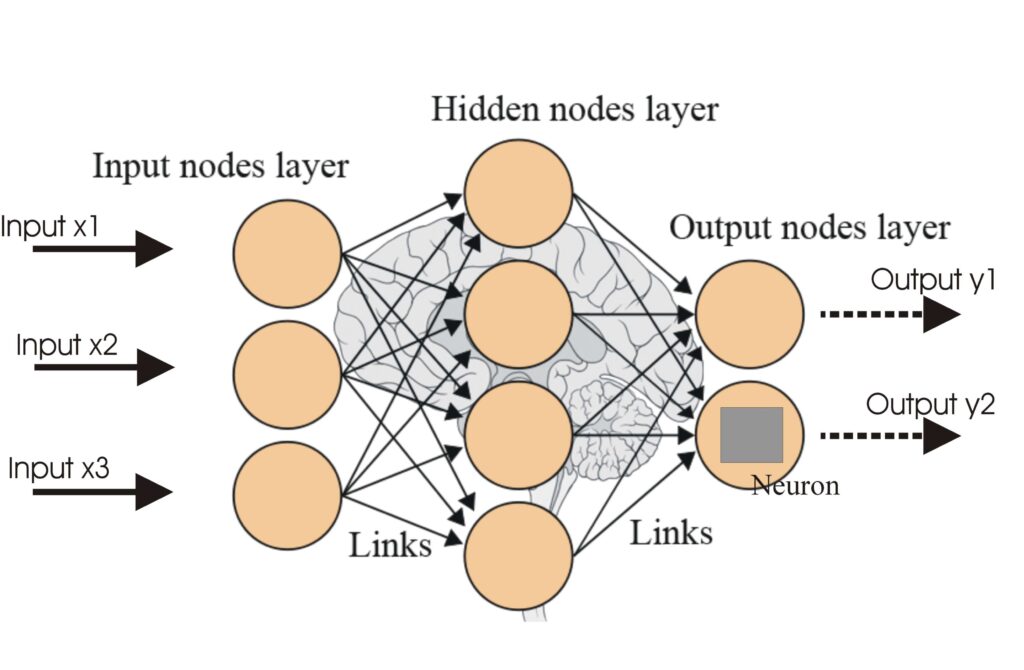

Et neuralt nettverk, eller kunstig neuralt nettverk (ANN), er en datamodell inspirert av menneskehjernen, essensiell i KI og maskinlæring for oppgaver som mønst...

Aktiveringsfunksjoner introduserer ikke-linearitet i nevrale nettverk, noe som gjør dem i stand til å lære komplekse mønstre som er essensielle for AI- og dyp læringsapplikasjoner.

Aktiveringsfunksjoner er grunnleggende for arkitekturen til kunstige nevrale nettverk (ANN), og har stor innvirkning på nettverkets evne til å lære og utføre kompliserte oppgaver. Denne ordlisteartikkelen utforsker kompleksiteten rundt aktiveringsfunksjoner, og ser på deres formål, typer og bruksområder, spesielt innen AI, dyp læring og nevrale nettverk.

En aktiveringsfunksjon i et nevralt nettverk er en matematisk operasjon som brukes på utdataene fra et nevron. Den avgjør om et nevron skal aktiveres eller ikke, og introduserer ikke-linearitet i modellen, noe som gjør det mulig for nettverket å lære komplekse mønstre. Uten disse funksjonene ville et nevralt nettverk i praksis fungere som en lineær regresjonsmodell, uansett hvor dypt eller hvor mange lag det hadde.

Sigmoid-funksjon

Tanh-funksjon

ReLU (Rectified Linear Unit)

Leaky ReLU

Softmax-funksjon

Swish-funksjon

Aktiveringsfunksjoner er sentrale i ulike AI-applikasjoner, inkludert:

En aktiveringsfunksjon er en matematisk operasjon som brukes på utdataene fra et nevron, og som introduserer ikke-linearitet og gjør det mulig for nevrale nettverk å lære komplekse mønstre utover enkle lineære forhold.

Aktiveringsfunksjoner gjør det mulig for nevrale nettverk å løse komplekse, ikke-lineære problemer ved å muliggjøre læring av intrikate mønstre, noe som gjør dem avgjørende for oppgaver som bildeklassifisering, språkbehandling og automatisering.

Vanlige typer inkluderer Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax og Swish, hver med unike egenskaper og bruksområder i ulike lag av nevrale nettverk.

Vanlige utfordringer inkluderer problemet med forsvinnende gradient (spesielt med Sigmoid og Tanh), døende ReLU og beregningskostnader for funksjoner som Softmax i sanntidsapplikasjoner.

Smarte chatboter og AI-verktøy samlet på ett sted. Koble sammen intuitive blokker for å gjøre ideene dine om til automatiserte Flows.

Et neuralt nettverk, eller kunstig neuralt nettverk (ANN), er en datamodell inspirert av menneskehjernen, essensiell i KI og maskinlæring for oppgaver som mønst...

Kunstige nevrale nettverk (ANNs) er en undergruppe av maskinlæringsalgoritmer modellert etter den menneskelige hjernen. Disse beregningsmodellene består av samm...

Utforsk hvordan funksjonsutvikling og -ekstraksjon forbedrer ytelsen til AI-modeller ved å forvandle rådata til verdifulle innsikter. Oppdag nøkkelteknikker som...