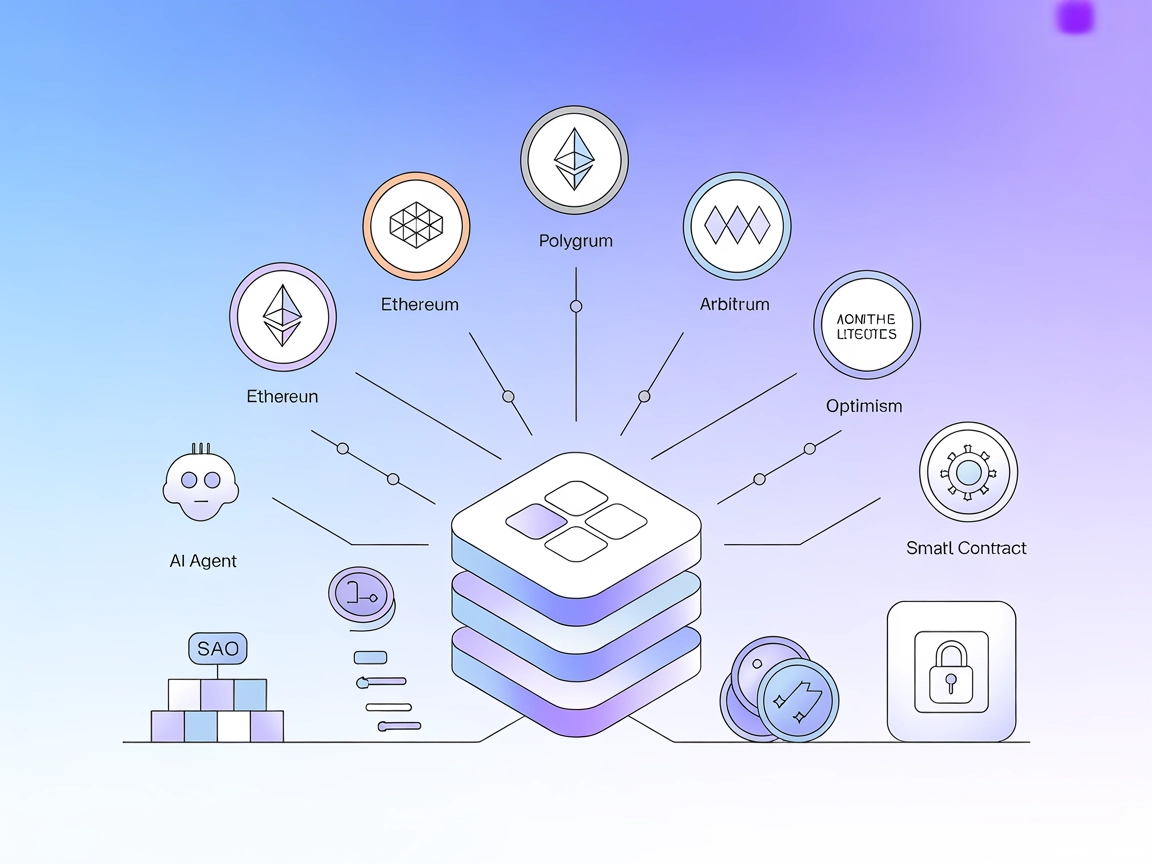

EVM MCP Server-integrasjon

Integrer FlowHunt med EVM MCP Server for å gi AI-agenter sikker, samlet tilgang til over 30 EVM-kompatible blokkjeder. Automatiser sømløst smartkontrakt-interak...

Blokkering av AI-boter bruker robots.txt for å forhindre AI-drevne roboter fra å få tilgang til nettstedets data, og beskytter innhold og personvern.

Blokkering av AI-boter refererer til praksisen med å forhindre AI-drevne roboter fra å få tilgang til og hente ut data fra et nettsted. Dette oppnås vanligvis ved å bruke robots.txt-filen, som gir direktiver til nettroboter om hvilke deler av et nettsted de har tillatelse til å få tilgang til.

Å blokkere AI-boter er avgjørende for å beskytte sensitiv nettsidedata, opprettholde innholdets originalitet og forhindre uautorisert bruk av innhold til AI-treningsformål. Det hjelper med å bevare integriteten til nettstedets innhold og kan beskytte mot potensielle personvernhensyn og misbruk av data.

Hva er robots.txt?

Robots.txt er en tekstfil som brukes av nettsteder for å kommunisere med nettroboter og roboter. Den instruerer disse automatiserte agentene om hvilke områder av nettstedet de har tillatelse til å gjennomsøke og indeksere.

Funksjonalitet:

Implementering:

Nettsteder bør plassere robots.txt-filen i rotmappen for å sikre at den er tilgjengelig via URL-en:https://example.com/robots.txt

Filsyntaksen inkluderer spesifisering av user-agent etterfulgt av “Disallow” for å blokkere tilgang eller “Allow” for å tillate tilgang.

AI-assistenter

AI-dataskrapere

AI-søkecrawlere

| Botnavn | Beskrivelse | Blokkeringsmetode (robots.txt) |

|---|---|---|

| GPTBot | OpenAI’s bot for datainnsamling | User-agent: GPTBot Disallow: / |

| Bytespider | ByteDance’s dataskraper | User-agent: Bytespider Disallow: / |

| OAI-SearchBot | OpenAI’s søkeindekseringsbot | User-agent: OAI-SearchBot Disallow: / |

| Google-Extended | Googles AI-treningsdatabot | User-agent: Google-Extended Disallow: / |

Innholdsbeskyttelse:

Blokkering av roboter bidrar til å beskytte nettstedets originale innhold mot å bli brukt uten samtykke i AI-treningsdatasett, og dermed bevare immaterielle rettigheter.

Personvernhensyn:

Ved å kontrollere robottilgang kan nettsteder redusere risiko knyttet til personvern og uautorisert datainnsamling.

SEO-hensyn:

Selv om blokkering av roboter kan beskytte innhold, kan det også påvirke nettstedets synlighet i AI-drevne søkemotorer, noe som potensielt kan redusere trafikk og oppdagbarhet.

Juridiske og etiske aspekter:

Praksisen reiser spørsmål om dataeierskap og rimelig bruk av nettinnhold fra AI-selskaper. Nettsteder må balansere beskyttelse av sitt innhold med de potensielle fordelene ved AI-drevne søketeknologier.

Blokkering av AI-boter refererer til å forhindre AI-drevne roboter fra å få tilgang til og hente ut data fra et nettsted, vanligvis gjennom direktiver i robots.txt-filen.

Å blokkere AI-boter bidrar til å beskytte sensitiv data, opprettholde innholdets originalitet, forhindre uautorisert bruk til AI-trening, og ivareta personvern og immaterielle rettigheter.

Ved å plassere en robots.txt-fil i nettstedets rotmappe med spesifikke user-agent og disallow-direktiver, begrenser man roboters tilgang til bestemte sider eller hele nettstedet.

Populære AI-boter som GPTBot, Bytespider, OAI-SearchBot og Google-Extended kan blokkeres ved å bruke robots.txt-direktiver som retter seg mot deres user-agent-navn.

Blokkering av AI-boter kan redusere risikoen for brudd på personvernet, men kan også påvirke nettstedets synlighet i AI-drevne søkemotorer, noe som kan redusere trafikk og oppdagbarhet.

Lær hvordan du blokkerer AI-boter og sikrer innholdet ditt mot uautorisert tilgang og dataskraping. Begynn å bygge sikre AI-løsninger med FlowHunt.

Integrer FlowHunt med EVM MCP Server for å gi AI-agenter sikker, samlet tilgang til over 30 EVM-kompatible blokkjeder. Automatiser sømløst smartkontrakt-interak...

Integrer FlowHunt med Nodit MCP Server for å gi AI-agenter og applikasjoner sanntids, strukturert blokkjede-data på tvers av EVM- og ikke-EVM-nettverk. Automati...

Integrer FlowHunt med Algorand MCP Server for sømløse blokkjedeinteraksjoner, lommebokadministrasjon, transaksjonsbehandling og sanntidsforespørsler om tilstand...