Finne den beste LLM-en for innholdsproduksjon: Testet og rangert

Vi har testet og rangert skriveevnene til 5 populære modeller tilgjengelig i FlowHunt for å finne den beste LLM-en for innholdsproduksjon.

Instruksjonstuning finjusterer LLM-er på instruksjon-respons-data, og forbedrer deres evne til å følge menneskelige instrukser i oppgaver som oversettelse, oppsummering og spørsmål og svar.

Instruksjonstuning er en teknikk brukt innen kunstig intelligens (KI) for å forbedre evnene til store språkmodeller (LLM-er). Den innebærer å finjustere forhåndstrente språkmodeller på et datasett bestående av instruksjon-respons-par. Målet er å trene modellen til bedre å forstå og følge menneskelige instruksjoner, og slik bygge bro over gapet mellom modellens evne til å forutsi tekst og dens evne til å utføre spesifikke oppgaver etter brukerens anvisning.

I sin kjerne tilpasser instruksjonstuning en språkmodell til ikke bare å generere sammenhengende tekst basert på mønstre lært under forhåndstrening, men til å produsere utdata som er tilpasset gitte instruksjoner. Dette gjør modellen mer interaktiv, responsiv og nyttig for virkelige applikasjoner der nøyaktig etterfølgelse av brukerinstruksjoner er avgjørende.

Instruksjonstuning brukes etter at en språkmodell har gjennomgått initial forhåndstrening, som vanligvis innebærer å lære fra store mengder umerkede tekstdata for å forutsi neste ord i en sekvens. Selv om denne forhåndstreningen gir en sterk forståelse av språkstruktur og generell kunnskap, gir den ikke modellen evnen til å følge spesifikke instruksjoner eller utføre definerte oppgaver effektivt.

For å løse dette finjusterer instruksjonstuning modellen ved hjelp av et kuratert datasett med instruksjon- og utgangspar. Disse datasettene er designet for å representere et bredt spekter av oppgaver og instruksjoner brukere kan gi. Ved å trene på disse eksemplene lærer modellen å tolke instruksjoner og generere passende svar.

Datasettopprettelse:

Sett sammen et datasett som inneholder varierte instruksjon-respons-par. Instruksjonene kan omfatte ulike oppgaver som oversettelse, oppsummering, spørsmål og svar, tekstgenerering og mer.

Finjusteringsprosess:

Bruk veiledet læring for å trene den forhåndstrente modellen på dette datasettet. Modellen justerer sine parametre for å minimere forskjellen mellom sine genererte utdata og de ønskede responsene i datasettet.

Evaluering og iterasjon:

Vurder modellens ytelse på valideringsoppgaver som ikke er inkludert i treningsdataene, for å sikre at den generaliserer godt til nye instruksjoner. Gjenta datasettet og treningsprosessen ved behov for å forbedre ytelsen.

Språköversettelse:

Trene en modell til å oversette tekst fra ett språk til et annet basert på instruksjoner som “Oversett følgende setning til fransk.”

Oppsummering:

Finjustere en modell til å oppsummere lange artikler når det blir instruert, f.eks. “Oppsummer hovedpunktene i denne artikkelen om klimaendringer.”

Spørsmål og svar:

Gjøre det mulig for en modell å svare på spørsmål ved å gi instruksjoner som “Svar på følgende spørsmål basert på gitt kontekst.”

Tekstgenerering med stilretningslinjer:

Tilpasse en modell til å skrive i en spesifikk stil eller tone, for eksempel “Skriv om følgende avsnitt i en formell akademisk stil.”

Instruksjonstuning har blitt en sentral teknikk for å forbedre flerspråklige og store språkmodeller (LLM-er) slik at de får større nytteverdi på tvers av ulike språklige kontekster. Nyere studier undersøker ulike aspekter ved denne tilnærmingen og gir innsikt i potensial og utfordringer.

1. Investigating Multilingual Instruction-Tuning: Do Polyglot Models Demand for Multilingual Instructions?

Av Alexander Arno Weber mfl. (2024)

Denne studien utforsker tilpasningen av flerspråklige forhåndstrente LLM-er for å fungere som effektive assistenter på ulike språk. Den undersøker systematisk flerspråklige modeller som er instruksjonstunet på ulike språkdatasett, med fokus på indoeuropeiske språk. Resultatene viser at instruksjonstuning på parallelle flerspråklige korpora forbedrer evnen til å følge instruksjoner på tvers av språk med opptil 9,9 %, og utfordrer hypotesen om overflatisk tilpasning. Videre fremheves behovet for store instruksjonstuning-datasett for flerspråklige modeller. Forfatterne gjennomførte også en menneskelig annoteringsstudie for å tilpasse menneskelige og GPT-4-baserte evalueringer i flerspråklige chat-scenarier.

Les mer

2. OpinionGPT: Modelling Explicit Biases in Instruction-Tuned LLMs

Av Patrick Haller mfl. (2023)

Denne studien undersøker skjevheter som finnes i instruksjonstunede LLM-er. Den anerkjenner bekymringer om skjevheter som gjenspeiles i modeller trent på data med spesifikke demografiske påvirkninger, som politiske eller geografiske skjevheter. I stedet for å undertrykke disse skjevhetene, foreslår forfatterne å gjøre dem eksplisitte og transparente gjennom OpinionGPT, en nettapplikasjon som lar brukere utforske og sammenligne svar basert på ulike skjevheter. Denne tilnærmingen innebar å opprette et instruksjonstuning-korpus som reflekterer ulike skjevheter, og gir en mer nyansert forståelse av skjevhet i LLM-er.

Les mer

Instruksjonstuning er prosessen med å finjustere store språkmodeller ved hjelp av datasett med instruksjon-respons-par, slik at de bedre kan forstå og følge menneskelige instruksjoner for ulike oppgaver.

Det hjelper modellene med å generere utdata som er mer i tråd med brukerens instruksjoner, noe som gjør dem mer interaktive, responsive og effektive til å følge spesifikke retningslinjer.

Oppgaver som språköversettelse, oppsummering, spørsmål og svar, og generering av tekst i bestemte stiler drar nytte av instruksjonstuning.

Hovedstegene inkluderer å lage et variert datasett med instruksjon-respons-par, finjustere modellen ved hjelp av veiledet læring, og iterativt evaluere og forbedre modellens ytelse.

Utfordringer inkluderer behovet for store, varierte datasett—spesielt for flerspråklige modeller—og å håndtere iboende skjevheter i treningsdataene.

Koble intuitive blokker med FlowHunt for å lage chatboter og KI-verktøy. Begynn å automatisere ideene dine i dag.

Vi har testet og rangert skriveevnene til 5 populære modeller tilgjengelig i FlowHunt for å finne den beste LLM-en for innholdsproduksjon.

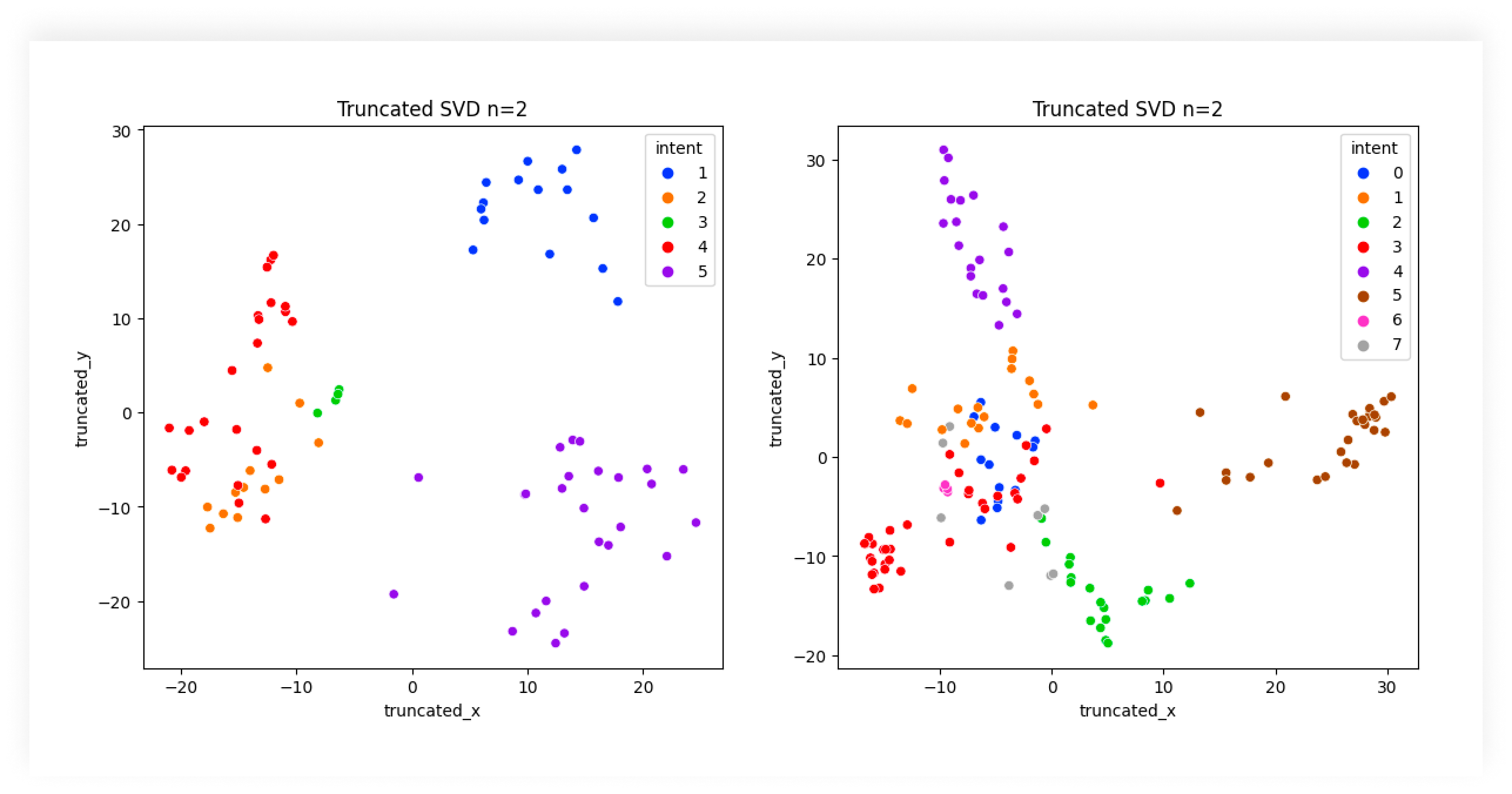

Oppdag den essensielle rollen AI Intentklassifisering har for å forbedre brukerinteraksjoner med teknologi, styrke kundestøtte og effektivisere forretningsdrift...

Overføringslæring er en avansert maskinlæringsteknikk som gjør det mulig å gjenbruke modeller trent på én oppgave til en beslektet oppgave, noe som forbedrer ef...