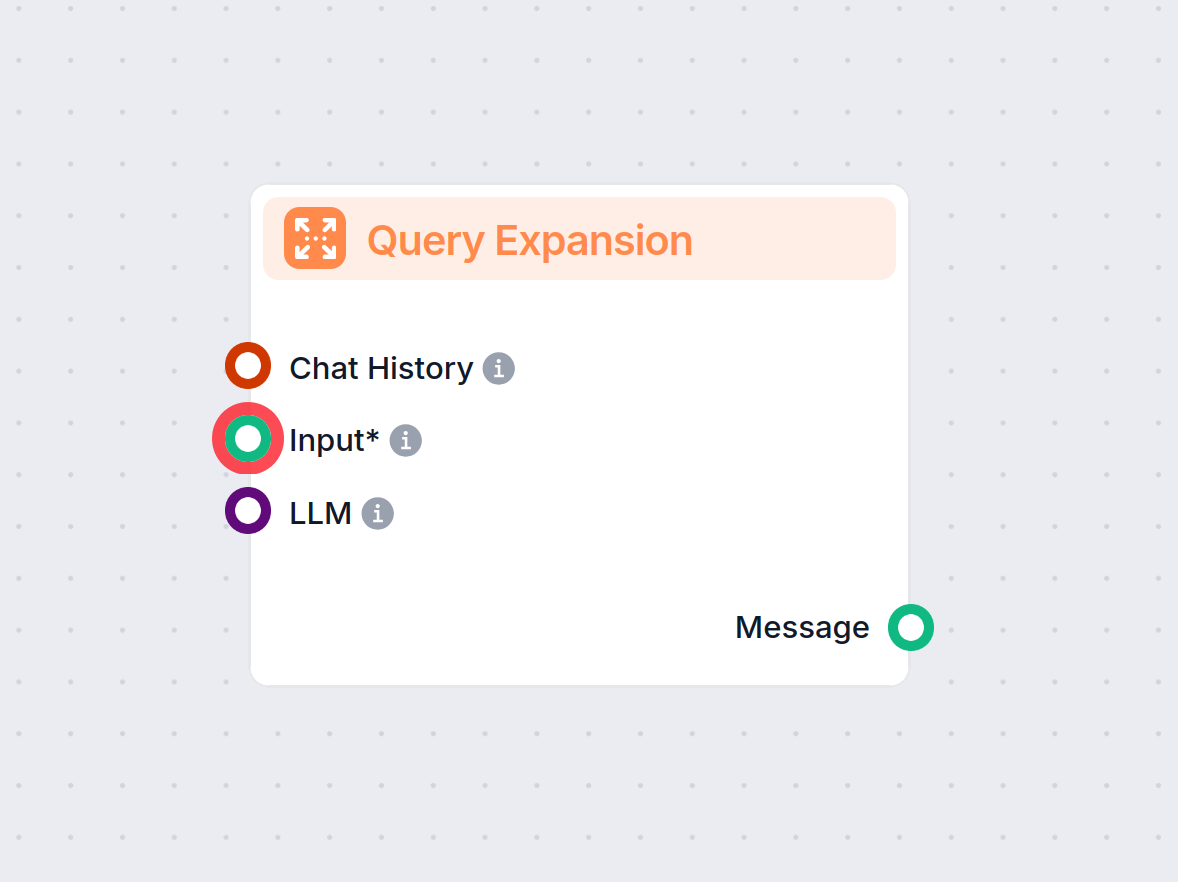

Forespørselsekspansjon

Forespørselsekspansjon i FlowHunt forbedrer chatbotens forståelse ved å finne synonymer, rette stavefeil og sikre konsistente, nøyaktige svar på brukerhenvendel...

Forespørselsekspansjon beriker brukerforespørsler med ekstra kontekst eller termer, og øker nøyaktigheten på gjenfinning og svar i AI-systemer som RAG og chatboter.

Forespørselsekspansjon forbedrer brukerforespørsler ved å legge til termer eller kontekst, noe som gir bedre dokumentgjenfinning for nøyaktige svar. I RAG-systemer øker det tilbakekall og relevans, og hjelper chatboter og AI med å gi presise svar ved effektiv håndtering av vage eller synonymbaserte forespørsler.

Forespørselsekspansjon refererer til prosessen med å forbedre en brukers opprinnelige forespørsel ved å legge til ekstra termer eller kontekst før den sendes til gjenfinningsmekanismen. Denne utvidelsen hjelper til med å hente mer relevante dokumenter eller informasjonsbiter, som deretter brukes til å generere et mer nøyaktig og kontekstuelt passende svar. Hvis dokumenter søkes opp med alternative forespørsler og så rangeres på nytt, gir RAG-prosessen langt mer presise dokumentresultater i kontekstvinduet til prompten.

Retrieval-Augmented Generation (RAG) er en AI-arkitektur som kombinerer gjenfinningsmekanismer med generative modeller for å produsere mer nøyaktige og kontekstuelt relevante svar. I RAG-systemer henter en gjenfinningskomponent relevante dokumenter eller datastykker fra en kunnskapsbase basert på en brukerforespørsel. Deretter bruker en generativ modell (ofte en stor språkmodell eller LLM) denne informasjonen til å generere et sammenhengende og informativt svar.

I RAG-systemer avhenger kvaliteten på det genererte svaret i stor grad av relevansen til de hentede dokumentene. Hvis gjenfinningskomponenten ikke klarer å hente den mest relevante informasjonen, kan den generative modellen produsere suboptimale eller irrelevante svar. Forespørselsekspansjon adresserer denne utfordringen ved å forbedre den opprinnelige forespørselen og øke sjansen for å hente alle relevante dokumenter.

Ved å utvide den opprinnelige forespørselen med relaterte termer, synonymer eller omformuleringer, utvider forespørselsekspansjon søkeområdet. Dette øker tilbakekallingen til gjenfinningssystemet, noe som betyr at det fanger opp en større andel relevante dokumenter fra kunnskapsbasen. Høyere tilbakekall gir et mer omfattende kontekstuelt grunnlag for den generative modellen, noe som forbedrer den totale kvaliteten på RAG-systemets svar.

LLM-er som GPT-4 kan generere semantisk like forespørsler eller omformuleringer av den opprinnelige forespørselen. Ved å forstå kontekst og nyanser i språket, kan LLM-er produsere høykvalitets ekspansjoner som fanger opp ulike måter det samme spørsmålet kan stilles på.

Eksempel:

I denne tilnærmingen genererer systemet et hypotetisk svar på brukerens forespørsel ved hjelp av en LLM. Det hypotetiske svaret legges deretter til den opprinnelige forespørselen for å gi mer kontekst under gjenfinningen.

Prosess:

Eksempel:

Denne metoden innebærer å generere flere alternative forespørsler som fanger opp ulike formuleringer eller aspekter av den opprinnelige forespørselen. Hver forespørsel brukes uavhengig til å hente dokumenter.

Prosess:

Eksempel:

Scenario:

Et AI-system er designet for å svare på spørsmål basert på en bedrifts årsrapport. En bruker spør: “Var det betydelig utskiftning i ledergruppen?”

Implementering:

Fordel:

Ved å gi mer kontekst gjennom det hypotetiske svaret, henter systemet relevant informasjon som ellers kunne blitt oversett med kun den opprinnelige forespørselen.

Scenario:

En kundeservice-chatbot hjelper brukere med feilsøking. En bruker skriver: “Internettet mitt er tregt.”

Implementering:

Fordel:

Chatboten fanger opp et bredere spekter av mulige problemer og løsninger, og øker sannsynligheten for å løse brukerens problem effektivt.

Scenario:

En student bruker en AI-assistent for å finne ressurser om emnet: “Effekter av søvnmangel på kognitiv funksjon.”

Implementering:

Fordel:

Studenten får omfattende informasjon som dekker ulike sider av emnet og får hjelp til grundigere forskning.

For mange utvidede forespørsler kan føre til irrelevante dokumenter, noe som reduserer presisjonen på gjenfinningen.

Tiltak:

Ord med flere betydninger kan føre til irrelevante ekspansjoner.

Tiltak:

Generering og behandling av flere utvidede forespørsler kan være ressurskrevende.

Tiltak:

Sikre at de utvidede forespørslene fungerer effektivt med eksisterende gjenfinningsalgoritmer.

Tiltak:

Tildeling av vekter til termer i de utvidede forespørslene for å reflektere deres betydning.

Etter gjenfinning, om-ranger dokumentene for å prioritere relevans.

Eksempel:

Bruke en Cross-Encoder etter gjenfinning for å poengsette og om-rangere dokumenter ut fra deres relevans til den opprinnelige forespørselen.

Inkluder brukerinteraksjoner for å forbedre forespørselsekspansjonen.

Bruk av AI og LLM-er for forespørselsekspansjon utnytter avansert språkforståelse for å forbedre gjenfinning. Dette gjør det mulig for AI-systemer, inkludert chatboter og virtuelle assistenter, å levere mer nøyaktige og kontekstuelle svar.

Automatisering av forespørselsekspansjonsprosessen reduserer behovet for at brukeren må formulere presise forespørsler. AI-automatisering håndterer kompleksiteten i bakgrunnen og øker effektiviteten til informasjonsgjenfinningssystemer.

Chatboter drar nytte av forespørselsekspansjon ved å bedre forstå brukerintensjoner, særlig når brukere bruker dagligtale eller ufullstendige fraser. Dette gir mer tilfredsstillende interaksjoner og effektiv problemløsning.

Eksempel:

En chatbot som bistår med teknisk støtte kan tolke en vag forespørsel som “Appen min virker ikke” ved å utvide til “applikasjonen krasjer”, “programvaren svarer ikke” og “feilmeldinger i appen”, noe som gir raskere løsning.

Forskning på forespørselsekspansjon for RAG

Improving Retrieval for RAG based Question Answering in question answering, enhancing accuracy with real-time data. Discover more!") Models on Financial Documents

Denne artikkelen undersøker effektiviteten til store språkmodeller (LLM) forbedret med Retrieval-Augmented Generation (RAG), spesielt i finansdokumenter. Den identifiserer at unøyaktigheter i LLM-svar ofte skyldes suboptimal tekstgjenfinning snarere enn selve LLM-en. Studien foreslår forbedringer i RAG-prosesser, inkludert avanserte chunking-teknikker og forespørselsekspansjon, sammen med metadata-annotasjoner og om-rangeringsalgoritmer. Disse metodene har som mål å forbedre tekstgjenfinning og dermed LLM-ytelsen i å generere nøyaktige svar. Les mer

Enhancing Retrieval and Managing Retrieval: A Four-Module Synergy for Improved Quality and Efficiency in RAG Systems

Artikkelen introduserer en modulær tilnærming for å forbedre RAG-systemer, med fokus på Query Rewriter-modulen, som lager søkevennlige forespørsler for å forbedre kunnskapsgjenfinning. Den adresserer problemer med informasjonsplatåer og tvetydighet i forespørsler ved å generere flere forespørsler. I tillegg foreslås Knowledge Filter og Memory Knowledge Reservoir for å håndtere irrelevant kunnskap og optimalisere gjenfinningsressurser. Disse forbedringene har som mål å øke svarenes kvalitet og effektivitet i RAG-systemer, validert gjennom eksperimenter på QA-datasett. Få tilgang til kode og mer informasjon.

MultiHop-RAG: Benchmarking Retrieval-Augmented Generation for Multi-Hop Queries

Denne forskningen belyser utfordringer i eksisterende RAG-systemer når det gjelder multi-hop-forespørsler, som krever resonnement over flere informasjonsbiter. Det introduseres et nytt datasett spesielt designet for å benchmarke RAG-systemer på multi-hop-forespørsler, med mål om å utvide grensene for dagens RAG-kapasitet. Artikkelen diskuterer nødvendige fremskritt for at RAG-metoder skal kunne håndtere komplekse forespørselsstrukturer og forbedre LLM-adopsjon for praktiske applikasjoner.

Forespørselsekspansjon er prosessen med å utvide en brukers opprinnelige forespørsel ved å legge til relaterte termer, synonymer eller kontekst. Dette hjelper gjenfinningssystemer å hente mer relevante dokumenter og generere nøyaktige svar, spesielt i AI-drevne applikasjoner.

I RAG-systemer (Retrieval-Augmented Generation) øker forespørselsekspansjon tilbakekallingen til gjenfinningskomponenten ved å utvide søkeområdet. Dette sikrer at flere relevante dokumenter vurderes for å generere presise svar.

Teknikker inkluderer bruk av store språkmodeller til å generere omformulerte forespørsler, hypotetisk svar-generering, multi-forespørselsmetoder, termvektlegging og bruk av tilbakemeldinger fra brukere for kontinuerlig forbedring.

Forespørselsekspansjon forbedrer tilbakekalling, håndterer vage eller tvetydige forespørsler, gjenkjenner synonymer og forbedrer brukeropplevelsen ved å levere mer nøyaktige og informative svar uten manuell tilpasning av forespørslene.

Ja, utfordringer inkluderer over-ekspansjon (innføring av irrelevante dokumenter), tvetydighet i termer, høyt krav til datakraft og å sikre kompatibilitet med gjenfinningsalgoritmer. Dette kan motvirkes med kontrollert generering, relevansfiltrering og effektive modeller.

Se hvordan forespørselsekspansjon kan forbedre nøyaktigheten til din AI-chatbot og øke informasjonsgjenfinningen. Oppdag FlowHunt sine løsninger for effektiv og automatisert håndtering av forespørsler.

Forespørselsekspansjon i FlowHunt forbedrer chatbotens forståelse ved å finne synonymer, rette stavefeil og sikre konsistente, nøyaktige svar på brukerhenvendel...

Dokument-omrangering er prosessen med å omorganisere hentede dokumenter basert på hvor relevante de er for en brukers søk, slik at søkeresultater forbedres ved ...

Spørsmål og svar med Retrieval-Augmented Generation (RAG) kombinerer informasjonsinnhenting og naturlig språk-generering for å forbedre store språkmodeller (LLM...