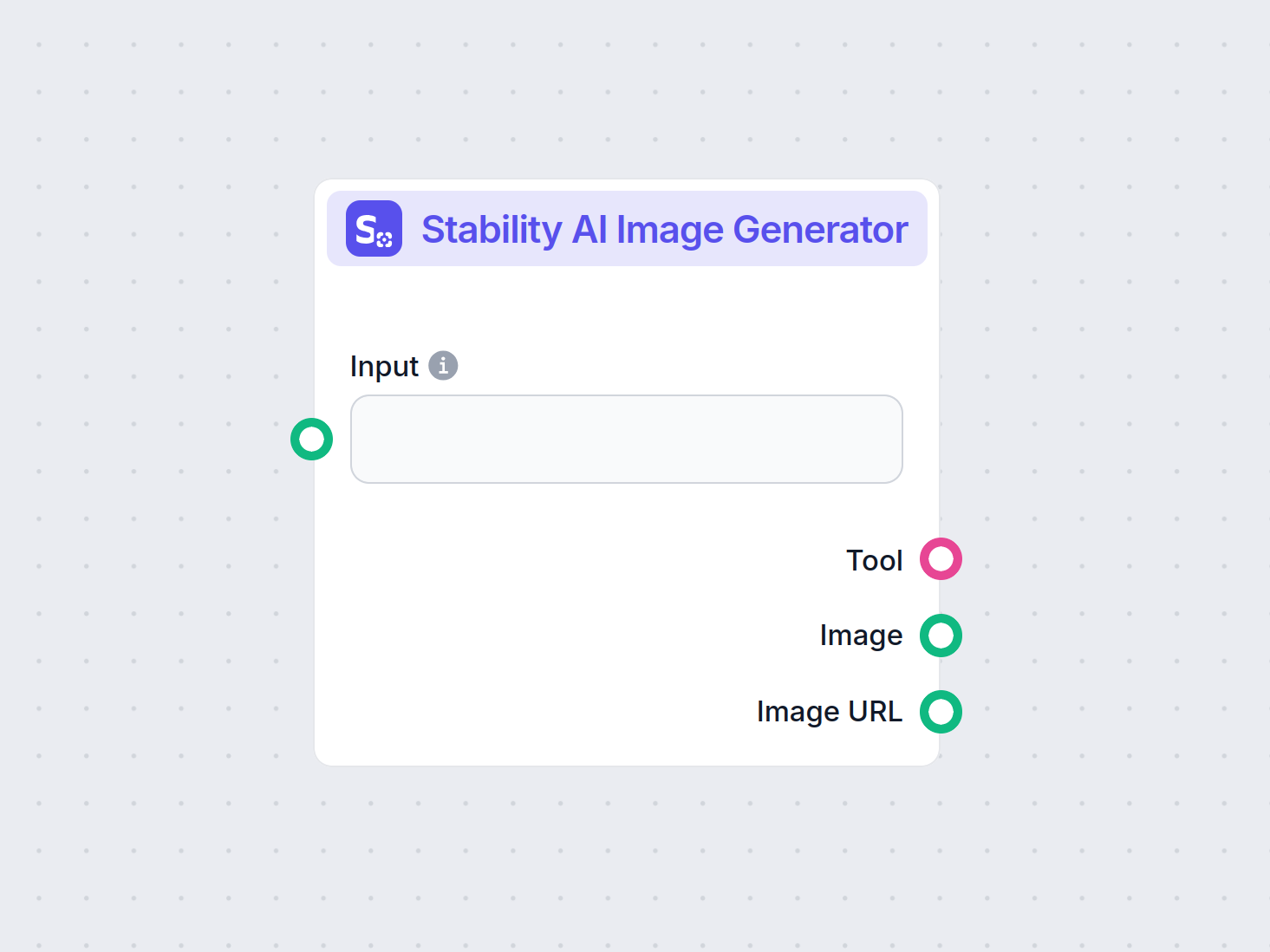

Stability AI Bildgenerator

Generer bilder av høy kvalitet fra tekstinstruksjoner med Stability AI Bildgenerator-komponenten. Drevet av Stable Diffusion-modeller tilbyr dette verktøyet til...

Stable Diffusion er en ledende tekst-til-bilde AI-modell som gjør det mulig for brukere å generere fotorealistiske bilder fra oppfordringer ved hjelp av avanserte latent diffusjons- og dyp læringsteknikker.

Stable Diffusion er en tekst-til-bilde AI-modell som lager bilder av høy kvalitet fra beskrivelser ved hjelp av dyp læring. Den benytter teknikker som negative oppfordringer og referansebilder for bedre resultater, spesielt med komplekse elementer som hender.

Stable Diffusion er en avansert modell for tekst-til-bilde-generering som benytter dyp læring for å produsere høykvalitets, fotorealistiske bilder basert på tekstlige beskrivelser. Utviklet som en latent diffusjonsmodell, representerer den et betydelig gjennombrudd innen generativ kunstig intelligens ved å kombinere prinsippene fra diffusjonsmodeller og maskinlæring for å skape bilder som tett samsvarer med gitte tekstoppfordringer.

Stable Diffusion bruker dyp læring og diffusjonsmodeller til å generere bilder ved å raffinere tilfeldig støy til sammenhengende visuelle uttrykk. Til tross for omfattende trening på millioner av bilder, sliter den med komplekse elementer som hender. Over tid, etter hvert som modellene trenes på stadig større datasett, minimeres disse problemene og bildekvaliteten blir stadig mer realistisk.

En effektiv metode for å håndtere utfordringen med hender er å bruke negative oppfordringer. Ved å legge til fraser som (-dårlig anatomi) eller (-dårlige hender -unaturlige hender) i oppfordringene dine, kan du instruere AI-en til å unngå forvrengte trekk. Vær forsiktig med å ikke overbruke negative oppfordringer, da de kan begrense modellens kreative output.

En annen teknikk innebærer bruk av referansebilder for å veilede AI-en. Ved å inkludere en {image}-tag med lenke til et referansebilde i oppfordringen, gir du AI-en en visuell mal for presis gjengivelse av hender. Dette er spesielt nyttig for å opprettholde korrekte håndproporsjoner og positurer.

For best mulig resultat, kombiner både negative oppfordringer og referansebilder. Denne todelte tilnærmingen sikrer at AI-en unngår vanlige feil samtidig som den holder seg til høykvalitets eksempler.

(-bøyde fingre) eller (realistiske perspektiver) for å ytterligere forbedre håndkvaliteten.Ved å mestre disse teknikkene kan du forbedre gjengivelsen av hender betydelig i dine Stable Diffusion-kreasjoner og oppnå kunstverk med en erfaren kunstners finesse. Samle referansebildene dine, lag presise oppfordringer, og se AI-kunsten din utvikle seg!

I sin kjerne opererer Stable Diffusion ved å transformere tekstoppfordringer til visuelle representasjoner gjennom en serie databehandlingsprosesser. Forståelse av funksjonaliteten innebærer å se nærmere på diffusjonsmodeller, latente rom og nevrale nettverk.

Diffusjonsmodeller er en klasse av generative modeller innen maskinlæring som lærer å skape data ved å reversere en diffusjonsprosess. Diffusjonsprosessen innebærer gradvis å legge til støy til data – som bilder – til de blir ugjenkjennelige fra tilfeldig støy. Modellen lærer så å reversere denne prosessen, og fjerne støy steg for steg for å gjenvinne de opprinnelige dataene. Denne omvendte diffusjonsprosessen er nøkkelen til å generere nye, sammenhengende data fra tilfeldig støy.

Stable Diffusion bruker spesifikt en latent diffusjonsmodell. I motsetning til tradisjonelle diffusjonsmodeller som opererer direkte i bildenes høy-dimensjonale pikselrom, arbeider latente diffusjonsmodeller i et komprimert latent rom. Dette latente rommet er en lavere-dimensjonal representasjon av dataene, som fanger opp essensielle trekk og samtidig reduserer beregningskompleksiteten. Ved å operere i det latente rommet kan Stable Diffusion generere bilder med høy oppløsning mer effektivt.

Kjernemekanismen i Stable Diffusion involverer den omvendte diffusjonsprosessen i det latente rommet. Startende med en tilfeldig støy latent vektor, raffinerer modellen denne latente representasjonen iterativt ved å predikere og fjerne støy for hvert steg. Denne raffineringen styres av tekstbeskrivelsen brukeren gir. Prosessen fortsetter til den latente vektoren konvergerer til en tilstand som, når den dekodes, produserer et bilde i samsvar med tekstoppfordringen.

Stable Diffusions arkitektur integrerer flere viktige komponenter som samarbeider for å transformere tekstoppfordringer til bilder.

VAE fungerer som et koder-dekoder-system som komprimerer bilder til det latente rommet og rekonstruerer dem tilbake til bilder. Koderen omformer et bilde til dets latente representasjon og fanger de grunnleggende trekkene i en redusert form. Dekoderen tar denne latente representasjonen og gjenskaper den til et detaljert bilde.

Denne prosessen er avgjørende fordi den lar modellen arbeide med lavere-dimensjonale data, noe som reduserer ressursbruken betydelig sammenlignet med å operere i hele pikselrommet.

U-Net er en spesialisert arkitektur for nevrale nettverk brukt i Stable Diffusion for bildebehandling. Den består av en kodingsbane og en dekodingsbane med hoppkoblinger mellom speilvendte lag. I Stable Diffusion fungerer U-Net som støyforutsier under den omvendte diffusjonsprosessen.

Ved hvert tidssteg i diffusjonsprosessen predikerer U-Net mengden støy i den latente representasjonen. Denne forutsigelsen brukes deretter til å raffinere den latente vektoren ved å trekke fra estimert støy, og gradvis avstøye det latente rommet mot et bilde som samsvarer med tekstoppfordringen.

For å innlemme tekstinformasjon bruker Stable Diffusion en tekstkoder basert på CLIP (Contrastive Language-Image Pretraining)-modellen. CLIP er utviklet for å forstå og relatere tekstlig og visuell informasjon ved å kartlegge dem inn i et felles latent rom.

Når en bruker gir en tekstoppfordring, konverterer tekstkoderen denne oppfordringen til en rekke innbeddinger—numeriske representasjoner av tekstdataene. Disse innbeddingene betinger U-Net under den omvendte diffusjonsprosessen og veileder bildegenereringen for å reflektere innholdet i tekstoppfordringen.

Stable Diffusion tilbyr allsidighet i bildegenerering og kan brukes på ulike måter avhengig av brukerens behov.

Hovedbruken av Stable Diffusion er å generere bilder fra tekstoppfordringer. Brukere skriver inn beskrivende tekst, og modellen genererer et bilde som representerer beskrivelsen. For eksempel kan en bruker skrive inn “En fredelig strand ved solnedgang med palmetrær” og motta et bilde som viser denne scenen.

Denne funksjonen er særlig verdifull i kreative bransjer, innholdsproduksjon og design, hvor rask visualisering av konsepter er viktig.

I tillegg til å generere bilder fra bunnen av, kan Stable Diffusion også endre eksisterende bilder basert på tekstlige instruksjoner. Ved å gi et startbilde og en tekstoppfordring, kan modellen produsere et nytt bilde som inkorporerer endringene beskrevet i teksten.

For eksempel kan en bruker legge inn et bilde av et bylandskap på dagtid sammen med oppfordringen “endre til natt med neonlys”, som resulterer i et bilde som reflekterer disse endringene.

Inpainting innebærer å fylle inn manglende eller ødelagte deler av et bilde. Stable Diffusion utmerker seg på dette området ved å bruke tekstoppfordringer til å styre gjenoppbyggingen av spesifikke bildeområder. Brukere kan maskere deler av et bilde og oppgi tekstlige beskrivelser av hva som skal fylle området.

Denne funksjonen er nyttig i fotorestaurering, fjerning av uønskede objekter eller endring av spesifikke elementer i et bilde samtidig som den overordnede sammenhengen opprettholdes.

Ved å generere sekvenser av bilder med små variasjoner, kan Stable Diffusion utvides til å lage animasjoner eller videoinnhold. Verktøy som Deforum forbedrer Stable Diffusions muligheter til å lage dynamisk visuelt innhold styrt av tekstoppfordringer over tid.

Dette åpner for muligheter innen animasjon, visuelle effekter og dynamisk innholdsgenerering uten behov for tradisjonelle bilde-for-bilde-animasjonsteknikker.

Stable Diffusions evne til å generere bilder fra tekstbeskrivelser gjør det til et kraftig verktøy i AI-automatisering og chatbotutvikling.

Ved å integrere Stable Diffusion i chatboter kan man generere visuelt innhold som respons på brukerforespørsler. For eksempel kan en kundeservicechatbot tilby visuelle guider eller illustrasjoner generert i sanntid for å hjelpe brukere.

Tekstoppfordringer konverteres til innbeddinger ved hjelp av CLIP-tekstkoderen. Disse innbeddingene er avgjørende for å betinge bildegenereringsprosessen og sikre at det genererte bildet samsvarer med brukerens tekstbeskrivelse.

Den omvendte diffusjonsprosessen innebærer iterativt å raffinere den latente representasjonen ved å fjerne predikert støy. Ved hvert tidssteg vurderer modellen tekstinnbeddingene og den nåværende tilstanden til den latente vektoren for nøyaktig å predikere støykomponenten.

Modellens dyktighet til å håndtere støyete bilder kommer fra trening på store datasett der den lærer å skille og avstøye bilder effektivt. Denne treningen gjør det mulig å generere klare bilder selv når man starter fra tilfeldig støy.

Arbeid i det latente rommet gir beregningseffektivitet. Siden det latente rommet har færre dimensjoner enn pikselrommet, krever operasjoner mindre ressurser. Denne effektiviteten gjør det mulig for Stable Diffusion å generere bilder med høy oppløsning uten overdrevne krav til maskinvare.

Kunstnere og designere kan bruke Stable Diffusion til raskt å prototype visuelle uttrykk basert på konseptuelle beskrivelser, noe som gir en mer effektiv kreativ prosess og kortere tid fra idé til visualisering.

Markedsføringsteam kan lage tilpassede bilder for kampanjer, sosiale medier og annonser uten å måtte investere mye i grafisk design.

Spillutviklere kan lage ressurser, miljøer og konseptkunst ved å gi beskrivende oppfordringer, og dermed effektivisere ressursutviklingsprosessen.

Forhandlere kan generere bilder av produkter i ulike omgivelser eller konfigurasjoner, og dermed forbedre produktvisualisering og kundeopplevelse.

Lærere og innholdsprodusenter kan lage illustrasjoner og diagrammer for å forklare komplekse konsepter, noe som gjør læremateriell mer engasjerende.

Forskere innen kunstig intelligens og datavisjon kan bruke Stable Diffusion til å utforske diffusjonsmodeller og latente rom videre.

For å bruke Stable Diffusion effektivt, bør visse tekniske hensyn tas.

For å begynne å bruke Stable Diffusion, følg disse stegene:

For utviklere som bygger AI-automatisering-systemer og chatboter, kan Stable Diffusion integreres for å forbedre funksjonaliteten.

Når du bruker Stable Diffusion, er det viktig å være oppmerksom på etiske implikasjoner.

Stable Diffusion er et viktig tema innen generative modeller, spesielt for dataforstørring og bildesyntese. Nylige studier har utforsket ulike aspekter av stable diffusion og fremhevet bruksområder og effektivitet.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments av Fuxi Wen (2013):

Introduserer en diffusjon least mean p-power (LMP)-algoritme utviklet for distribuert estimering i miljøer preget av alpha-stabil støy. Studien sammenligner diffusjon LMP-metoden med diffusjon least mean squares (LMS)-algoritmen og viser forbedret ytelse under alpha-stabil støy. Denne forskningen er viktig for å utvikle robuste estimeringsteknikker i støyende miljøer. Les mer

Stable Diffusion for Data Augmentation in COCO and Weed Datasets av Boyang Deng (2024):

Undersøker bruk av stabile diffusjonsmodeller for å generere syntetiske bilder i høy oppløsning for å forbedre små datasett. Ved å benytte teknikker som bilde-til-bilde-oversettelse, Dreambooth og ControlNet vurderer forskningen effektiviteten til stable diffusion innen klassifiserings- og deteksjonsoppgaver. Funnene antyder lovende bruksområder for stable diffusion i ulike fagfelt. Les mer

Diffusion and Relaxation Controlled by Tempered α-stable Processes av Aleksander Stanislavsky, Karina Weron og Aleksander Weron (2011):

Utleder egenskaper ved anomale diffusjons- og ikke-eksponensielle relaksasjonsprosesser ved bruk av tempererte α-stabile prosesser. Den tar opp problemet med uendelig moment relatert til α-stabil tilfeldig operasjonell tid og gir en modell som inkluderer subdiffusjon som et spesialtilfelle. Les mer

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion av Andreas Stöckl (2022):

Evaluerer syntetiske bilder generert av Stable Diffusion-modellen ved bruk av Wordnet-taksonomi. Den vurderer modellens evne til å produsere korrekte bilder for ulike konsepter, og illustrerer forskjeller i representasjonsnøyaktighet. Disse evalueringene er viktige for å forstå stable diffusions rolle i dataforstørring. Les mer

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion av Sanchayan Vivekananthan (2024):

Utforsker tre generative rammeverk: VAE-er, GAN-er og Stable Diffusion-modeller. Forskningen fremhever styrker og begrensninger ved hver modell, og bemerker at selv om VAE-er og GAN-er har sine fordeler, utmerker stable diffusion seg i visse synteseoppgaver. Les mer

La oss se på hvordan man implementerer en Stable Diffusion-modell i Python ved bruk av Hugging Face Diffusers-biblioteket.

Installer nødvendige biblioteker:

pip install torch transformers diffusers accelerate

pip install xformers # Valgfritt

Diffusers-biblioteket gir en enkel måte å laste inn forhåndstrente modeller på:

from diffusers import StableDiffusionPipeline

import torch

# Last inn Stable Diffusion-modellen

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Flytt modellen til GPU for raskere inferens

For å generere bilder, gi bare en tekstoppfordring:

prompt = "Et fredelig landskap med fjell og en innsjø, fotorealistisk, 8K oppløsning"

image = pipe(prompt).images[0]

# Lagre eller vis bildet

image.save("generated_image.png")

model_id.torch.float16 reduserer minnebruken.Du kan tilpasse ulike parametere:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Antall avstøyingssteg

guidance

Stable Diffusion er en avansert AI-modell utviklet for å generere bilder av høy kvalitet og fotorealistiske bilder fra tekstoppfordringer. Den bruker latent diffusjon og dyp læring for å omforme tekstbeskrivelser til visuelle bilder.

Stable Diffusion fungerer ved å konvertere tekstoppfordringer til bildeinnbeddinger ved hjelp av en CLIP-tekstkoder, og deretter iterativt avstøyende en latent representasjon veiledet av oppfordringen, noe som resulterer i et sammenhengende bilde.

Stable Diffusion brukes til kreativ innholdsgenerering, markedsføringsmateriell, spillressursoppretting, produktvisualisering for netthandel, pedagogiske illustrasjoner og AI-drevne chatboter.

Ja, Stable Diffusion støtter bilde-til-bilde-oversettelse og inpainting, slik at brukere kan endre eksisterende bilder eller fylle inn manglende deler basert på tekstoppfordringer.

En datamaskin med et moderne GPU anbefales for effektiv bildegenerering med Stable Diffusion. Modellen krever også Python og biblioteker som PyTorch og Diffusers.

Ja, Stable Diffusion er utgitt under en permissiv åpen kildekode-lisens, som oppmuntrer til bidrag fra samfunnet, tilpasning og bred tilgjengelighet.

Slipp løs kreativiteten din med Stable Diffusion og se hvordan AI kan forvandle ideene dine til fantastiske bilder.

Generer bilder av høy kvalitet fra tekstinstruksjoner med Stability AI Bildgenerator-komponenten. Drevet av Stable Diffusion-modeller tilbyr dette verktøyet til...

Utforsk vår grundige gjennomgang av Stability AI SD3 Large. Analyser styrker, svakheter og kreativt utfall på tvers av ulike tekst-til-bilde-forespørsler, og op...

Flux AI-modellen fra Black Forest Labs er et avansert tekst-til-bilde-genereringssystem som omdanner naturlige språkbeskrivelser til svært detaljerte, fotoreali...